1804.03235-Large scale distributed neural network training through online distillation.md

现有分布式模型训练的模式

- 分布式SGD

- 并行SGD: 大规模训练中,一次的最长时间取决于最慢的机器

- 异步SGD: 不同步的数据,有可能导致权重更新向着未知方向

- 并行多模型 :多个集群训练不同的模型,再组合最终模型,但是会消耗inference运行时

- 蒸馏:流程复杂

- student训练数据集的选择

- unlabeled的数据

- 原始数据

- 留出来的数据

- student训练数据集的选择

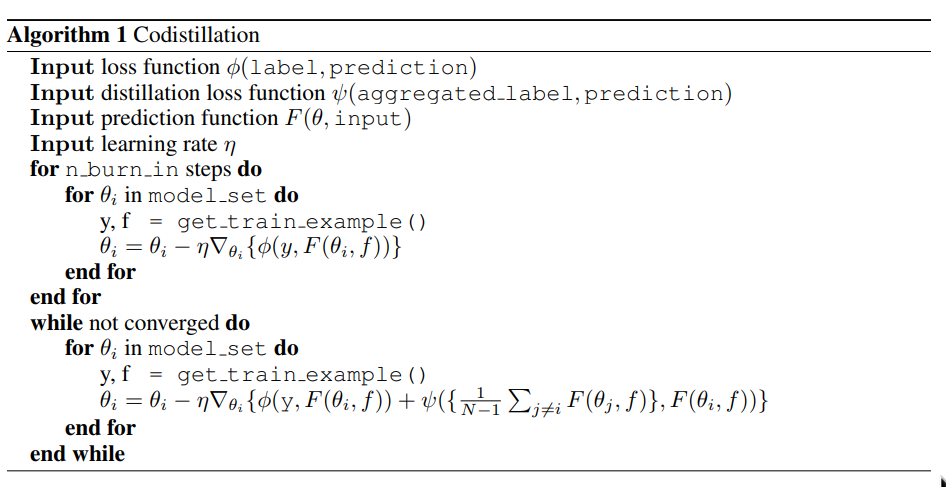

协同蒸馏

- using the same architecture for all the models;

- using the same dataset to train all the models; and

- using the distillation loss during training before any model has fully converged.

特点

- 就算thacher和student是完全相同的模型设置,只要其内容足够不同,也是能够获得有效的提升的

- 即是模型未收敛,收益也是有的

- 丢掉teacher和student的区分,互相训练,也是有好处的

- 不是同步的模型也是可以的。

算法简单易懂,而且步骤看上去不是很复杂。

使用out of state模型权重的解释:

- every change in weights leads to a change in gradients, but as training progresses towards convergence, weight updates should substantially change only the predictions on a small subset of the training data;

- weights (and gradients) are not statistically identifiable as different copies of the weights might have arbitrary scaling differences, permuted hidden units, or otherwise rotated or transformed hidden layer feature space so that averaging gradients does not make sense unless models are extremely similar;

- sufficiently out-of-sync copies of the weights will have completely arbitrary differences that change the meaning of individual directions in feature space that are not distinguishable by measuring the loss on the training set;

- in contrast, output units have a clear and consistent meaning enforced by the loss function and the training data.

所以这里似乎是说,随机性的好处?

一种指导性的实用框架设计:

- Each worker trains an independent version of the model on a locally available subset of the training data.

- Occasionally, workers checkpoint their parameters.

- Once this happens, other workers can load the freshest available checkpoints into memory and perform codistillation.

再加上,可以在小一些的集群上使用分布式SGD。

另外论文中提到,这种方式,比起每次直接发送梯度和权重,只需要偶尔载入checkpoint,而且各个模型集群在运算上是完全相互独立的。这个倒是确实能减少一些问题。

但是,如果某个模型垮掉了,完全没收敛呢?

另外,没看出来这种框架哪里简单了,管理模型和checkpoint不是一个简单的事情。

实验结论

20TB的数据,有钱任性

论文中提到,并不是机器越多,最终模型效果越好,似乎32-128是比较合适的,更多了,模型收敛速度和性能不会更好,有时反而会有下降。

论文中的实验结果2a,最好的还是双模型并行,其次是协同蒸馏,最差的是unigram的smooth0.9,label smooth 0.99跟直接训练表现差不多,毕竟只是一个随机噪声。

另外,通过对比相同数据的协同蒸馏2b,和随机数据的协同整理,实验发现,随机数据实际上让模型有更好的表现

3在imagenet上的实验,出现了跟2a差不多的结果。

4中虽然不用非得用最新的模型,但是,协同蒸馏,使用太久远的checkpoint还是会显著降低训练效率的。

欠拟合的模型是有用的,但是过拟合的模型在蒸馏中可能不太有价值。

协同蒸馏比双步蒸馏能更快的收敛,而且更有效率。

3.5中介绍的,也是很多时候面临的问题,因为初始化,训练过程的参数不一样等问题,可能导致两次训练出来的模型的输出有很大区别。例如分类模型,可能上次训练的在某些分类上准确,而这次训练的,在这些分类上就不准确了。模型平均或者蒸馏法能有效避免这个问题。

总结

balabalabala

实验只尝试了两个模型,多个模型的多种拓扑结构也值得尝试。

很值得一读的一个论文。

1804.03235-Large scale distributed neural network training through online distillation.md的更多相关文章

- 论文笔记之:Large Scale Distributed Semi-Supervised Learning Using Streaming Approximation

Large Scale Distributed Semi-Supervised Learning Using Streaming Approximation Google 2016.10.06 官方 ...

- 1 - ImageNet Classification with Deep Convolutional Neural Network (阅读翻译)

ImageNet Classification with Deep Convolutional Neural Network 利用深度卷积神经网络进行ImageNet分类 Abstract We tr ...

- 【转】Principles of training multi-layer neural network using backpropagation

Principles of training multi-layer neural network using backpropagation http://galaxy.agh.edu.pl/~vl ...

- 用matlab训练数字分类的深度神经网络Training a Deep Neural Network for Digit Classification

This example shows how to use Neural Network Toolbox™ to train a deep neural network to classify ima ...

- CheeseZH: Stanford University: Machine Learning Ex4:Training Neural Network(Backpropagation Algorithm)

1. Feedforward and cost function; 2.Regularized cost function: 3.Sigmoid gradient The gradient for t ...

- 【论文考古】Training a 3-Node Neural Network is NP-Complete

今天看到一篇1988年的老文章谈到了训练一个简单网络是NPC问题[1].也就是下面的网络结构,在线性激活函数下,如果要找到参数使得输入数据的标签估计准确,这个问题是一个NPC问题.这个文章的意义在于宣 ...

- 大规模视觉识别挑战赛ILSVRC2015各团队结果和方法 Large Scale Visual Recognition Challenge 2015

Large Scale Visual Recognition Challenge 2015 (ILSVRC2015) Legend: Yellow background = winner in thi ...

- 通过Visualizing Representations来理解Deep Learning、Neural network、以及输入样本自身的高维空间结构

catalogue . 引言 . Neural Networks Transform Space - 神经网络内部的空间结构 . Understand the data itself by visua ...

- (zhuan) Recurrent Neural Network

Recurrent Neural Network 2016年07月01日 Deep learning Deep learning 字数:24235 this blog from: http:/ ...

随机推荐

- tab页的使用方法

css代码: #main{ margin:0px; width:100%; height:540px; background:url(m.jpg) no-repeat; background-size ...

- MySQL事务锁问题-Lock wait timeout exceeded

转载:https://cloud.tencent.com/developer/article/1356959 问题现象: 接口响应时间超长,耗时几十秒才返回错误提示,后台日志中出现Lock wai ...

- GRE配置教程——华为设备

GRE隧道是通过隧道两端的Tunnel接口建立的,所以需要在隧道两端的设备上分别配置Tunnel接口.对于GRE的Tunnel接口,需要指定其协议类型为GRE.源地址或源接口.目的地址和Tunnel接 ...

- Python开发工程师技术手记

Python基础篇 PythonPEP8规范 Python历史与安装 Python注释 Python变量以及类型 Python标识符和关键字 Python输出 Python输入 Python运算符 P ...

- C# .net mvc web api 返回 json 内容,过滤值为null的属性

在WebApiConfig.Register 中增加一段 #region 过滤值为null的属性 //json 序列化设置 GlobalConfiguration.Configuration.Form ...

- nginx的location root alias指令以及区别

原文:http://blog.csdn.net/bjash/article/details/8596538 location /img/ { alias /var/www/image/; } #若按照 ...

- Oracle数据库容量使用情况调查

-- 剩余容量 select sum(bytes) FREE from DBA_FREE_SPACE where tablespace_name ='xxx'; -- 总容量 select sum(b ...

- ARC085E MUL

https://atcoder.jp/contests/arc085/tasks/arc085_c 题目大意 略 解法 最小割即可. 直接建图有负边,但是因为我们知道最后在割上的边数一定为 \(N\) ...

- UC登录功能:商户需要创建的表

1:类似PHP的hash_hmac DELIMITER ;; CREATE DEFINER=`root`@`%` FUNCTION `uc_session_hmacsha1`( `_secretkey ...

- 填坑:Java 中的日期转换

我们之前讨论过时间,在Java 中有一些方法会出现横线?比如Date 过期方法. 参考文章:知识点:java一些方法会有横线?以Date 过期方法为例 Java中的日期和时间处理方法 Date类(官方 ...