spark复习笔记(3)

在windows上实现wordcount单词统计

一、编写scala程序,引入spark类库,完成wordcount

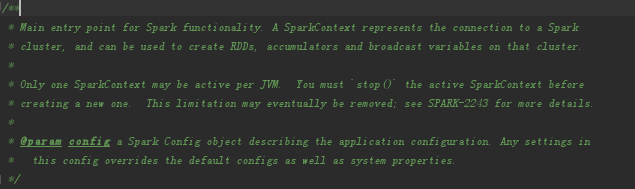

1.sparkcontextAPI

sparkcontext是spark功能的主要入口点,代表着到spark集群的连接,可用于在这些集群上创建RDD(弹性分布式数据集),累加器和广播变量。在每一个JVM上面只允许一个活跃的sparkcontext。在创建一个新的RDD之前,你应该停止这个活跃的SparkContext

2.sparkconf配置对象

sparkconf是对spark应用的配置,用来设置键值对的各种spark参数。大多数的时候,你需要通过new sparkconf的方式来创建一个对象,会从任何的spark系统属性中记性加载,从这个方面来讲,你在sparkconf上设置的参数会直接影响你在整个系统属性中的优先级

3.scala版单词统计:wordCount

import org.apache.spark.SparkContext

import org.apache.spark.SparkConf

object WordCount {

def main(args: Array[String]): Unit = {

//创建spark配置对象

val conf = new SparkConf();

//设置app名字

conf.setAppName("WordConf")

//创建master

conf.setMaster("local");

//创建spark上下文对象

val sc = new SparkContext(conf);

//加载文本文件

val rdd1 = sc.textFile("E:\\studyFile\\data\\test.txt")

//对rdd1中的对象压扁

val rdd2 = rdd1.flatMap(line=>line.split(" "))

//映射w=>(w,1)

val rdd3 = rdd2.map((_,))

val rdd4 = rdd3.reduceByKey(_ + _)

val r= rdd4.collect()

//遍历打印

r.foreach(println)

}

}

3.java版单词统计:wordCount

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.FlatMapFunction;

import org.apache.spark.api.java.function.Function2;

import org.apache.spark.api.java.function.PairFunction;

import scala.Tuple2; import java.util.ArrayList;

import java.util.Iterator;

import java.util.List; public class WordCountJava2 {

//创建conf对象

public static void main(String[] args){

SparkConf conf = new SparkConf();

conf.setAppName("WordCountJava2");

conf.setMaster("local");

//创建java版的sparkContext上下文对象

JavaSparkContext sc = new JavaSparkContext(conf);

JavaRDD<String> rdd1=sc.textFile("E:/studyFile/data/test.txt");

//先将单词压扁

JavaRDD<String> rdd2 = rdd1.flatMap(new FlatMapFunction<String, String>() {

//迭代的方法

public Iterator<String> call(String s) throws Exception {

List<String> list = new ArrayList<String>();

String[] arr = s.split(" ");

for(String ss:arr){

list.add(ss);

}

return list.iterator();

}

});

//映射,将单词映射为:word===>(word,1)

JavaPairRDD<String,Integer> rdd3=rdd2.mapToPair(new PairFunction<String, String, Integer>() { public Tuple2<String, Integer> call(String s) throws Exception {

return new Tuple2<String, Integer>(s,);

}

});

JavaPairRDD<String,Integer> rdd4 = rdd3.reduceByKey(new Function2<Integer, Integer, Integer>() {

public Integer call(Integer v1, Integer v2) throws Exception {

//函数捏合的过程

return v1+v2;

}

});

List<Tuple2<String,Integer>> list=rdd4.collect();

for(Tuple2<String,Integer> t :list){

System.out.println(t._1+":"+t._2);

}

}

}

4.提交作业到完全分布式spark集群上来运行

1)到处jar包

2)spark-submit --master local --name WordCount --class com.jd.spark.scala.WordCountDemoScala spark-daemon1-1.0-SNAPSHOT.jar /home/centos/test.txt

5.提交作业到完全分布式spark集群上来运行(只需要hdfs)

1)需要启动hadoop集群

$>start-dfs.sh

2)put文件到hdfs

hdfs dfs -put test.txt /user/centos/hadoop/

2)spark-submit提交命令运行job

$>spark-submit --master spark://s11:7070 --name WordCount --class com.jd.spark.scala.WordCountDemoScala spark-daemon1-1.0-SNAPSHOT.jar hdfs://s11:8020/user/centos/hadoop/test.txt

spark复习笔记(3)的更多相关文章

- spark复习笔记(1)

使用spark实现work count ---------------------------------------------------- (1)用sc.textFile(" &quo ...

- spark复习笔记(7):sparkstreaming

一.介绍 1.sparkStreaming是核心模块Spark API的扩展,具有可伸缩,高吞吐量以及容错的实时数据流处理等.数据可以从许多来源(如Kafka,Flume,Kinesis或TCP套接字 ...

- spark复习笔记(7):sparkSQL

一.saprkSQL模块,使用类sql的方式访问Hadoop,实现mr计算,底层使用的是rdd 1.hive //hadoop mr sql 2.phenoix //hbase上构建sql的交互过 ...

- spark复习笔记(6):RDD持久化

在spark中最重要的功能之一是跨操作在内存中持久化数据集.当你持久化一个RDD的时候,每个节点都存放了一个它在内存中计算的一个分区,并在该数据集的其他操作中进行重用,持久化一个RDD的时候,节点上的 ...

- spark复习笔记(6):数据倾斜

一.数据倾斜 spark数据倾斜,map阶段对key进行重新划分.大量的数据在经过hash计算之后,进入到相同的分区中,zao

- spark复习笔记(4):RDD变换

一.RDD变换 1.返回执行新的rdd的指针,在rdd之间创建依赖关系.每个rdd都有一个计算函数和指向父rdd的指针 Spark是惰性的,因此除非调用某个转换或动作,否则不会执行任何操作,否则将触发 ...

- spark复习笔记(5):API分析

0.spark是基于hadoop的mr模型,扩展了MR,高效实用MR模型,内存型集群计算,提高了app处理速度. 1.特点:(1)在内存中存储中间结果 (2)支持多种语言:java scala pyt ...

- spark复习笔记(4):spark脚本分析

1.[start-all.sh] #!/usr/bin/env bash # # Licensed to the Apache Software Foundation (ASF) under one ...

- spark复习笔记(3):使用spark实现单词统计

wordcount是spark入门级的demo,不难但是很有趣.接下来我用命令行.scala.Java和python这三种语言来实现单词统计. 一.使用命令行实现单词的统计 1.首先touch一个a. ...

随机推荐

- LeetCode--079--单词搜索(python)

给定一个二维网格和一个单词,找出该单词是否存在于网格中. 单词必须按照字母顺序,通过相邻的单元格内的字母构成,其中“相邻”单元格是那些水平相邻或垂直相邻的单元格.同一个单元格内的字母不允许被重复使用. ...

- extjs定时器TaskRunner

Extjs封装了一个定时器类叫TaskRunner,该类在Ext.util下,先看看其公共方法: TaskRunner( Number interval ) interval : Number ( ...

- 微信小程序-tabBar-注意事项

tabBar.list[0].selectedIconPath 文件格式错误,仅支持 .png..jpg..jpeg 格式

- 动态淀粉质(划掉)题单&简要题解

简介 动态点分治的思想:还不太清楚诶怎么办. 大概是通过降低树高来降低每次修改和询问的复杂度吧,还可以把树上一个连通块的信息统计到一个点(重心)上.具体实现方式和普通的静态点分治没有太大的区别,只是把 ...

- php简单随机实现发红包程序

前言: 使用PHP发红包,当我们输入红包数量和总金额后,PHP会根据这两个值进行随机分配每个金额,保证每个人都能领取到一个红包,每个红包金额不等,就是要求红包金额要有差异,所有红包金额总额应该等于总金 ...

- matlab 中 ordfilt2() 函数

简介: ordfilt2 是一个二维数据过滤器,首先对根据滤窗口中的非零元素对目标矩阵中的元素进行排序,然后用其中第K(通过参数指定)大的元素代替原数据值,并以此过程遍历目标矩阵中的每一个元素. 一. ...

- Fabric基础架构原理(一)

Linux基金会于2015年12月启动了名为“超级账本”(Hyperledger)的开源项目,旨在推动各方协作,共同打造基于区块链的企业级分布式账本底层技术,用于构建支撑业务的行业应用和平台. 超级账 ...

- Window7 系统下重新建立一个新分区

为了方便使用,准备在原来分区上再分割出一个分区,步骤如下 首先右击计算机,选择管理打开计算机管理窗口,选择磁盘管理,当前窗口右侧会出现当前计算机所有已存在的分区列表. 选择要进行分区的磁盘,右击选择压 ...

- Linux下查看分区内目录及文件占用空间容量

转载linux下使用 du查看某个文件或目录占用磁盘空间的大小 du -ah --max-depth=1 这个是我想要的结果 a显示目录占用的磁盘空间大小,还要显示其下目录和文件占用磁盘 ...

- 线性回归 r python 比较

w http://blog.sina.cn/dpool/blog/s/blog_70f632090101bp8u.html