论文解读(CDCL)《Cross-domain Contrastive Learning for Unsupervised Domain Adaptation》

论文信息

论文标题:Cross-domain Contrastive Learning for Unsupervised Domain Adaptation

论文作者:Rui Wang, Zuxuan Wu, Zejia Weng, Jingjing Chen, Guo-Jun Qi, Yu-Gang Jiang

论文来源:aRxiv 2022

论文地址:download

论文代码:download

1 Introduction

无监督域自适应(UDA)的目的是将从一个完全标记的源域学习到的知识转移到一个不同的未标记的目标域。 大多数现有的 UDA 方法通过最小化域间的特征距离来学习域不变的特征表示。

UDA 研究方向:

- discrepancy-based methods:最小化不同域之间的差异;

- adversarial-based methods:为域鉴别器设计一个对抗性优化目标,并通过对抗性学习获得域不变表示;

- domain-adaptive dictionary learning;

- multi-modality representation learning;

- feature disentanglement;

我们的目标是通过对比自监督学习来调整源域和目标域之间的特征分布。

2 方法

NT-Xent loss

B. Cross-domain Contrastive Learning

考虑目标域样本$\boldsymbol{x}_{t}^{i}$ 的 $\ell_{2}\text{-normalized}$ 特征 $\boldsymbol{z}_{t}^{i}$ 作为锚,它的正样本为同一类的源域样本,其特征表示为 $\boldsymbol{z}_{s}^{p}$,那么跨域对比损失:

$\mathcal{L}_{C D C}^{t, i}=-\frac{1}{\left|P_{s}\left(\hat{y}_{t}^{i}\right)\right|} \sum\limits _{p \in P_{s}\left(\hat{y}_{t}^{i}\right)} \log \frac{\exp \left(\boldsymbol{z}_{t}^{i^{\top}} \boldsymbol{z}_{s}^{p} / \tau\right)}{\sum\limits_{j \in I_{s}} \exp \left(\boldsymbol{z}_{t}^{i^{\top}} \boldsymbol{z}_{s}^{j} / \tau\right)} \quad\quad\quad(2)$

其中,$I_{S}$ 代表一个 mini-batch 中的源域样本集合,$P_{s}\left(\hat{y}_{t}^{i}\right)=\left\{k \mid y_{s}^{k}=\hat{y}_{t}^{i}\right\}$ 代表源域和目标域样本 $x_{t}^{i}$ 有相同标签;

$\mathcal{L}_{C D C}=\sum\limits _{i=1}^{N_{s}} \mathcal{L}_{C D C}^{s, i}+\sum\limits_{i=1}^{N_{t}} \mathcal{L}_{C D C}^{t, i} \quad\quad\quad(3)$

$\underset{\boldsymbol{\theta}}{\operatorname{minimize}} \quad \mathcal{L}_{C E}\left(\boldsymbol{\theta} ; D_{s}\right)+\lambda \mathcal{L}_{C D C}\left(\boldsymbol{\theta} ; D_{s}, D_{t}\right) \quad\quad\quad(4)$

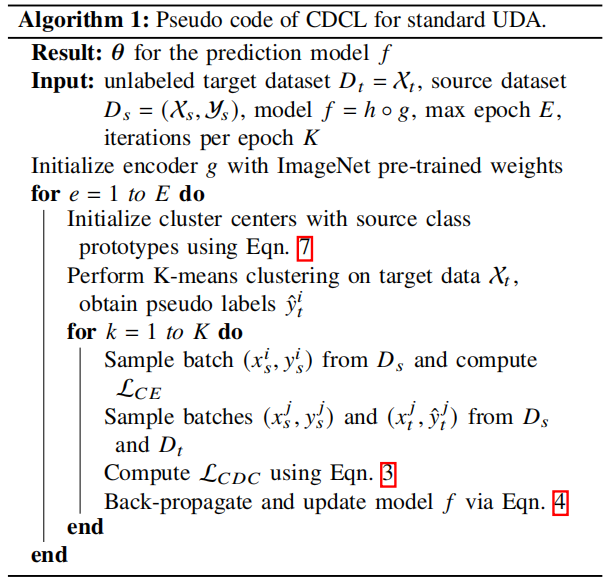

C. Pseudo Labels for the Target Domain

在训练过程中,没有来自目标域的真实标签,因此利用 k-means 聚类产生伪标签。由于 K-means 对初始化很敏感,因此使用随机生成的集群不能保证与预定义类别相关的相关语义。为缓解这个问题,将簇的数量设置为类 $M$ 的数量,并使用来自源域的类原型作为初始簇。

$O_{t}^{m} \leftarrow O_{s}^{m}=\mathbb{E}_{i \sim D_{s}\;, \; y_{s}^{i}=m} z_{s}^{i} \quad\quad\quad(5)$

D. Source Data-free UDA

Note:预训练模型 $f_{s}$ 是上文提到的通过交叉熵优化得到的。

许多标准的 UDA 设置,假设在源域和目标域上共享相同的特征编码器,然而由于特征编码器不能同时在源域和目标域上训练,所以 Source Data-free UDA 无法实现。本文的 CDCL 在缺少源域数据的情况下面临的挑战是 :(1) form positive and negative pairs and (2) to compute source class prototypes。

本文通过用训练模型 $_$ 的分类器权值替换源样本来解决这个问题。直觉是,预先训练模型的分类器层的权向量可以看作是在源域上学习到的每个类的原型特征。特别地,我们首先消除了全连通层的 bias ,并对分类器进行了归一化处理。假设 $\boldsymbol{w}_{s}^{m}\in \boldsymbol{W}_{s}=\left[\boldsymbol{w}_{s}^{1}, \ldots, \boldsymbol{w}_{s}^{M}\right]$ 代表从源域学到的 $M$ 分类器的权重向量,由于权值是规范化的,所以我们将它们用作类原型。当适应目标域时,冻结分类器层的参数,以保持源原型,并且只训练特征编码器。通过用源原型替换源样本,在源数据自由设置下的跨域对比损失可以写为:

$\mathcal{L}_{S D F-C D C}^{t, i}=-\sum\limits_{m=1}^{M} \mathbf{1}_{\hat{y}_{t}^{i}=m} \log \frac{\exp \left(\boldsymbol{z}_{t}^{i^{\top}} \boldsymbol{w}_{s}^{m} / \tau\right)}{\sum\limits _{j=1}^{M} \exp \left(\boldsymbol{z}_{t}^{i^{\top}} \boldsymbol{w}_{S}^{j} / \tau\right)} \quad\quad\quad(6)$

source data-free UDA 的最终目标是:

$\operatorname{minimize} \sum\limits _{i=1}^{N_{t}} \mathcal{L}_{S D F-C D C}^{t, i} \quad\quad\quad(8)$

论文解读(CDCL)《Cross-domain Contrastive Learning for Unsupervised Domain Adaptation》的更多相关文章

- 论文解读(PCL)《Prototypical Contrastive Learning of Unsupervised Representations》

论文标题:Prototypical Contrastive Learning of Unsupervised Representations 论文方向:图像领域,提出原型对比学习,效果远超MoCo和S ...

- 论文解读(LG2AR)《Learning Graph Augmentations to Learn Graph Representations》

论文信息 论文标题:Learning Graph Augmentations to Learn Graph Representations论文作者:Kaveh Hassani, Amir Hosein ...

- 论文解读(MVGRL)Contrastive Multi-View Representation Learning on Graphs

Paper Information 论文标题:Contrastive Multi-View Representation Learning on Graphs论文作者:Kaveh Hassani .A ...

- 论文解读(ARVGA)《Learning Graph Embedding with Adversarial Training Methods》

论文信息 论文标题:Learning Graph Embedding with Adversarial Training Methods论文作者:Shirui Pan, Ruiqi Hu, Sai-f ...

- 论文解读(gCooL)《Graph Communal Contrastive Learning》

论文信息 论文标题:Graph Communal Contrastive Learning论文作者:Bolian Li, Baoyu Jing, Hanghang Tong论文来源:2022, WWW ...

- 论文解读(SimGRACE)《SimGRACE: A Simple Framework for Graph Contrastive Learning without Data Augmentation》

论文信息 论文标题:SimGRACE: A Simple Framework for Graph Contrastive Learning without Data Augmentation论文作者: ...

- 论文解读(SimCLR)《A Simple Framework for Contrastive Learning of Visual Representations》

1 题目 <A Simple Framework for Contrastive Learning of Visual Representations> 作者: Ting Chen, Si ...

- 论文解读(GRACE)《Deep Graph Contrastive Representation Learning》

Paper Information 论文标题:Deep Graph Contrastive Representation Learning论文作者:Yanqiao Zhu, Yichen Xu, Fe ...

- 论文解读(S^3-CL)《Structural and Semantic Contrastive Learning for Self-supervised Node Representation Learning》

论文信息 论文标题:Structural and Semantic Contrastive Learning for Self-supervised Node Representation Learn ...

- 论文解读(MLGCL)《Multi-Level Graph Contrastive Learning》

论文信息 论文标题:Structural and Semantic Contrastive Learning for Self-supervised Node Representation Learn ...

随机推荐

- VMware Component Manager服务无法启动

近日,给一台Windows 2016上的vCenter打补丁,系统重启后,发现vmware的很多服务无法启动了.这是一台老版本的vcenter,虽然已经2021年了,但是它还管理着一些很老的ESX,比 ...

- Java安全之freemaker模版注入

Java安全之freemaker模版注入 freemaker简介 FreeMarker 是一款模板引擎: 即一种基于模板和要改变的数据, 并用来生成输出文本(HTML网页,电子邮件,配置文件,源代码等 ...

- 微信公众号商城、小程序商城、H5商城 实例 前后端源码

CRMEB客户管理+电商营销系统 https://gitee.com/ZhongBangKeJi/CRMEB 演示站后台: http://demo.crmeb.net/admin 账号:demo 密 ...

- Elasticsearch基础但非常有用的功能之一:别名

文章转载自: https://mp.weixin.qq.com/s?__biz=MzI2NDY1MTA3OQ==&mid=2247484454&idx=1&sn=43e95a2 ...

- CentOS yum如何安装php7.4

centos系统下使用yum安装php7.4正式版,当前基于WLNMP提供的一键安装包来安装 1.添加epel源 yum install epel-release 2.添加WLNMP一键安装包源 rp ...

- css padding和overflow

padding:10px 5px 15px 20px; 上右下左 padding:10px 5px 15px; 上 左右 下 padding:10px 5px; 上下 左右 padding:10px; ...

- C# 内存泄漏之 Internal 关键词代表什么?

一:背景 1. 背景 前段时间有位朋友咨询说他的程序出现了非托管内存泄漏,说里面有很多的 HEAP_BLOCK 都被标记成了 Internal 状态,而且 size 都很大, 让我帮忙看下怎么回事? ...

- 大数据常用的Linux命令

Linux文件系统基础知识 要想熟练使用命令,就先要熟练掌握Linux文件系统基础知识: 三个路径 当前路径:也叫当前工作目录,就是当前状态下用户所处的位置 相对路径:相对于当前工作目录开始的路径,会 ...

- 220726 T3 最优化问题 (树状数组)

题目描述 在同学们的努力下, 高匀感受到了 alb 的快乐. 高勺意犹未尽,找来了一个长度为 nn 的序列 a_1,a_2,-.,a_na1,a2,-.,an . 她想要删除这个序列中的 kk ...

- 如何实现通过Leaflet加载dwg格式的CAD图

前言 在前面介绍了通过openlayers加载dwg格式的CAD图并与互联网地图叠加,openlayers功能很全面,但同时也很庞大,入门比较难,适合于大中型项目中.而在中小型项目中,一般用开源的 ...