BP神经网络及手工搭建神经网络

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt def sigmoid(x): # 定义网络激活函数

return 1/(1+np.exp(-x)) data_tr = pd.read_csv('C:/Users/CHEN/Documents/WeChat Files/wxid_t1xqjm4fkg2v22/FileStorage/File/2022-03/3.3 data_tr.txt') # 训练集样本

data_te = pd.read_csv('C:/Users/CHEN/Documents/WeChat Files/wxid_t1xqjm4fkg2v22/FileStorage/File/2022-03/3.3 data_te.txt') # 测试集样本

n = len(data_tr)

yita = 0.85 # 自己设置学习速率 out_in = np.array([0.0, 0, 0, 0, -1]) # 输出层的输入,即隐层的输出

w_mid = np.zeros([3,4]) # 隐层神经元的权值&阈值

w_out = np.zeros([5]) # 输出层神经元的权值&阈值 delta_w_out = np.zeros([5]) # 输出层权值&阈值的修正量

delta_w_mid = np.zeros([3,4]) # 中间层权值&阈值的修正量

Err = []

'''

模型训练

'''

for j in range(1000):

error = []

for it in range(n):

net_in = np.array([data_tr.iloc[it, 0], data_tr.iloc[it, 1], -1]) # 网络输入

real = data_tr.iloc[it, 2]

for i in range(4):

out_in[i] = sigmoid(sum(net_in * w_mid[:, i])) # 从输入到隐层的传输过程

res = sigmoid(sum(out_in * w_out)) # 模型预测值

error.append(abs(real-res))#误差 print(it, '个样本的模型输出:', res, 'real:', real)

delta_w_out = yita*res*(1-res)*(real-res)*out_in # 输出层权值的修正量

delta_w_out[4] = -yita*res*(1-res)*(real-res) # 输出层阈值的修正量

w_out = w_out + delta_w_out # 更新,加上修正量 for i in range(4):

delta_w_mid[:, i] = yita*out_in[i]*(1-out_in[i])*w_out[i]*res*(1-res)*(real-res)*net_in # 中间层神经元的权值修正量

delta_w_mid[2, i] = -yita*out_in[i]*(1-out_in[i])*w_out[i]*res*(1-res)*(real-res) # 中间层神经元的阈值修正量,第2行是阈值

w_mid = w_mid + delta_w_mid # 更新,加上修正量

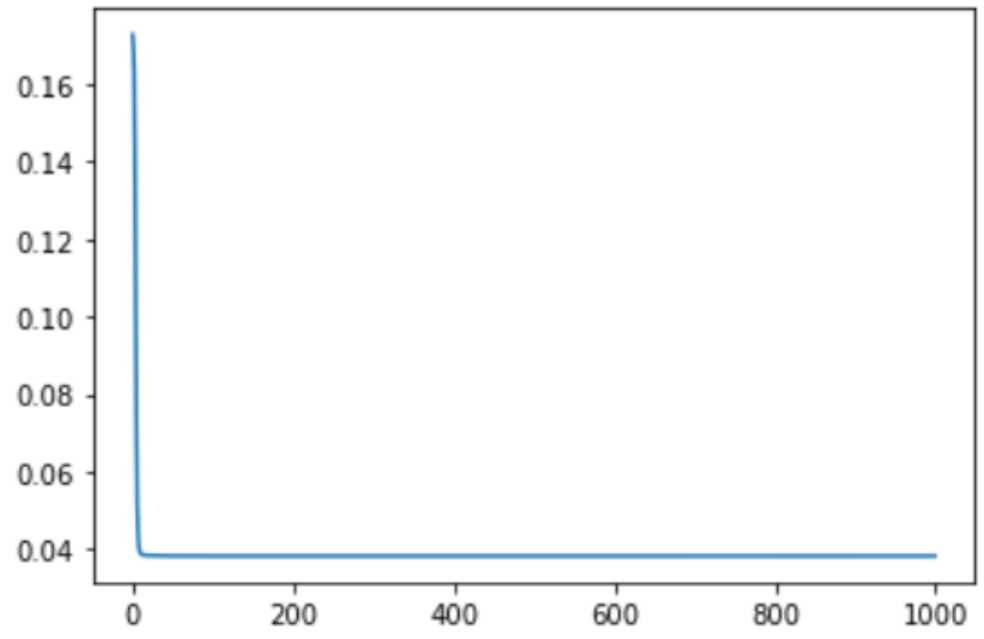

Err.append(np.mean(error))

print(w_mid,w_out)

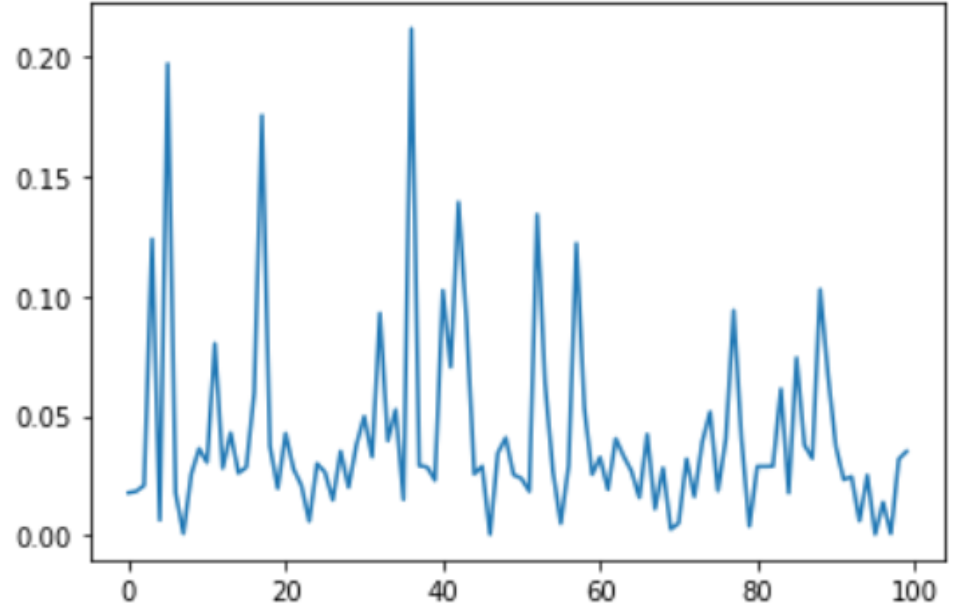

plt.plot(Err)#训练集上每一轮的平均误差

plt.show()

plt.close() '''

将测试集样本放入训练好的网络中去

'''

error_te = []

for it in range(len(data_te)):

net_in = np.array([data_te.iloc[it, 0], data_te.iloc[it, 1], -1]) # 网络输入

real = data_te.iloc[it, 2]

for i in range(4):

out_in[i] = sigmoid(sum(net_in * w_mid[:, i])) # 从输入到隐层的传输过程

res = sigmoid(sum(out_in * w_out)) # 模型预测值

error_te.append(abs(real-res))

plt.plot(error_te)#测试集上每一轮的误差

plt.show()

np.mean(error_te)

import numpy as np

import scipy.special

import pylab

import matplotlib.pyplot as plt

#%%

class NeuralNetwork():

# 初始化神经网络

def __init__(self, inputnodes, hiddennodes, outputnodes, learningrate):

# 设置输入层节点,隐藏层节点和输出层节点的数量和学习率

self.inodes = inputnodes

self.hnodes = hiddennodes

self.onodes = outputnodes

self.lr = learningrate #设置神经网络中的学习率

# 使用正态分布,进行权重矩阵的初始化

self.wih = np.random.normal(0.0, pow(self.hnodes, -0.5), (self.hnodes, self.inodes)) #(mu,sigma,矩阵)

self.who = np.random.normal(0.0, pow(self.onodes, -0.5), (self.onodes, self.hnodes))

self.activation_function = lambda x: scipy.special.expit(x) #激活函数设为Sigmod()函数

pass

# 定义训练神经网络

print("************Train start******************")

def train(self,input_list,target_list):

# 将输入、输出列表转换为二维数组

inputs = np.array(input_list, ndmin=2).T #T:转置

targets = np.array(target_list,ndmin= 2).T

hidden_inputs = np.dot(self.wih, inputs) #计算到隐藏层的信号,dot()返回的是两个数组的点积

hidden_outputs = self.activation_function(hidden_inputs) #计算隐藏层输出的信号

final_inputs = np.dot(self.who, hidden_outputs) #计算到输出层的信号

final_outputs = self.activation_function(final_inputs) output_errors = targets - final_outputs #计算输出值与标签值的差值 hidden_errors = np.dot(self.who.T,output_errors) #隐藏层和输出层权重更新

self.who += self.lr * np.dot((output_errors*final_outputs*(1.0-final_outputs)),

np.transpose(hidden_outputs))#transpose()转置

#输入层和隐藏层权重更新

self.wih += self.lr * np.dot((hidden_errors*hidden_outputs*(1.0-hidden_outputs)),

np.transpose(inputs))#转置

pass #查询神经网络

def query(self, input_list): # 转换输入列表到二维数

inputs = np.array(input_list, ndmin=2).T #计算到隐藏层的信号

hidden_inputs = np.dot(self.wih, inputs) #计算隐藏层输出的信号

hidden_outputs = self.activation_function(hidden_inputs) #计算到输出层的信号

final_inputs = np.dot(self.who, hidden_outputs)

final_outputs = self.activation_function(final_inputs)

return final_outputs

#%%

input_nodes = 784 #输入层神经元个数

hidden_nodes = 100 #隐藏层神经元个数

output_nodes = 10 #输出层神经元个数

learning_rate = 0.3 #学习率为0.3

# 创建神经网络

n = NeuralNetwork(input_nodes, hidden_nodes, output_nodes, learning_rate)

#%%

#读取训练数据集 转化为列表

training_data_file = open(r"C:\Users\CHEN\Documents\WeChat Files\wxid_t1xqjm4fkg2v22\FileStorage\File\2022-03\mnist_train.csv",'r')

training_data_list = training_data_file.readlines() #方法用于读取所有行,并返回列表

#print("training_data_list:",training_data_list)

training_data_file.close()

#%%

#训练次数

i = 2

for e in range(i):

#训练神经网络

for record in training_data_list:

all_values = record.split(',') #根据逗号,将文本数据进行拆分

#将文本字符串转化为实数,并创建这些数字的数组。

inputs = (np.asfarray(all_values[1:])/255.0 * 0.99) + 0.01

#创建用零填充的数组,数组的长度为output_nodes,加0.01解决了0输入造成的问题

targets = np.zeros(output_nodes) + 0.01 #10个元素都为0.01的数组

#使用目标标签,将正确元素设置为0.99

targets[int(all_values[0])] = 0.99#all_values[0]=='8'

n.train(inputs,targets)

pass

pass

#%%

test_data_file = open(r"C:\Users\CHEN\Documents\WeChat Files\wxid_t1xqjm4fkg2v22\FileStorage\File\2022-03\mnist_test.csv",'r')

test_data_list = test_data_file.readlines()

test_data_file.close() all_values = test_data_list[2].split(',') #第3条数据,首元素为1

# print(all_values)

# print(len(all_values))

# print(all_values[0]) #输出目标值

#%%

score = []

print("***************Test start!**********************")

for record in test_data_list:

#用逗号分割将数据进行拆分

all_values = record.split(',')

#正确的答案是第一个值

correct_values = int(all_values[0])

# print(correct_values,"是正确的期望值")

#做输入

inputs = (np.asfarray(all_values[1:])/255.0 * 0.99) + 0.01

#测试网络 作输入

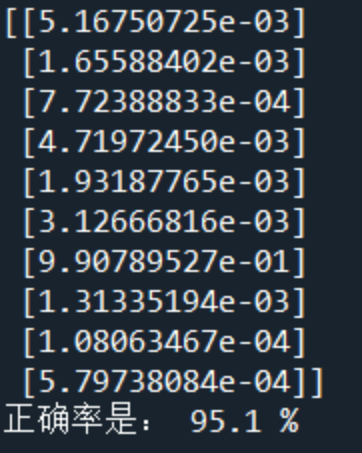

outputs= n.query(inputs)#10行一列的矩阵

#找出输出的最大值的索引

label = np.argmax(outputs)

# print(label,"是网络的输出值\n")

#如果期望值和网络的输出值正确 则往score 数组里面加1 否则添加0

if(label == correct_values):

score.append(1)

else:

score.append(0)

pass

pass

print(outputs)

#%%

# print(score)

score_array = np.asfarray(score)

#%%

print("正确率是:",(score_array.sum()/score_array.size)*100,'%')

BP神经网络及手工搭建神经网络的更多相关文章

- TensorFlow笔记-05-反向传播,搭建神经网络的八股

TensorFlow笔记-05-反向传播,搭建神经网络的八股 反向传播 反向传播: 训练模型参数,在所有参数上用梯度下降,使用神经网络模型在训练数据上的损失函数最小 损失函数:(loss) 计算得到的 ...

- (转)一文学会用 Tensorflow 搭建神经网络

一文学会用 Tensorflow 搭建神经网络 本文转自:http://www.jianshu.com/p/e112012a4b2d 字数2259 阅读3168 评论8 喜欢11 cs224d-Day ...

- 用Tensorflow搭建神经网络的一般步骤

用Tensorflow搭建神经网络的一般步骤如下: ① 导入模块 ② 创建模型变量和占位符 ③ 建立模型 ④ 定义loss函数 ⑤ 定义优化器(optimizer), 使 loss 达到最小 ⑥ 引入 ...

- Tensorflow 搭建神经网络及tensorboard可视化

1. session对话控制 matrix1 = tf.constant([[3,3]]) matrix2 = tf.constant([[2],[2]]) product = tf.matmul(m ...

- 一文学会用 Tensorflow 搭建神经网络

http://www.jianshu.com/p/e112012a4b2d 本文是学习这个视频课程系列的笔记,课程链接是 youtube 上的,讲的很好,浅显易懂,入门首选, 而且在github有代码 ...

- 用Keras搭建神经网络 简单模版(二)——Classifier分类(手写数字识别)

# -*- coding: utf-8 -*- import numpy as np np.random.seed(1337) #for reproducibility再现性 from keras.d ...

- Tensorflow学习:(二)搭建神经网络

一.神经网络的实现过程 1.准备数据集,提取特征,作为输入喂给神经网络 2.搭建神经网络结构,从输入到输出 3.大量特征数据喂给 NN,迭代优化 NN 参数 4.使 ...

- 用Keras搭建神经网络 简单模版(六)——Autoencoder 自编码

import numpy as np np.random.seed(1337) from keras.datasets import mnist from keras.models import Mo ...

- 【pytorch】学习笔记(四)-搭建神经网络进行关系拟合

[pytorch学习笔记]-搭建神经网络进行关系拟合 学习自莫烦python 目标 1.创建一些围绕y=x^2+噪声这个函数的散点 2.用神经网络模型来建立一个可以代表他们关系的线条 建立数据集 im ...

- keras搭建神经网络快速入门笔记

之前学习了tensorflow2.0的小伙伴可能会遇到一些问题,就是在读论文中的代码和一些实战项目往往使用keras+tensorflow1.0搭建, 所以本次和大家一起分享keras如何搭建神经网络 ...

随机推荐

- Prometheus&Alertmanager告警推送

前言 尽管可以通过可视化数据监控系统运行状态,但我们无法时刻关注系统运行,因此需要一些实时运行的工具能够辅助监控系统运行,当系统出现运行问题时,能够通知我们,以此确保系统稳定性,告警便是作为度量指标监 ...

- .Net依赖注入、控制反转

依赖项是指另一个对象所依赖的对象. 使用其他类所依赖的 WriteMessage 方法检查以下 MyDependency 类: public class MyDependency { public ...

- Apache HttpClient使用和源码分析

在上文中分析了 HttpURLConnection的用法,功能还是比较简单的,没有什么封装 接下来看看Apache HttpClient是如何封装httpClient的 目录 组成 请求代码 代码分析 ...

- 信息学奥赛介绍-CSP

什么是信息学奥赛 信息学奥赛,全称为信息学奥林匹克竞赛,是教育部和中国科协委托中国计算机 学会举办的一项全国青少年计算机程序设计竞赛.主要分为NOIP(全国联赛),夏令营 NOI比赛的扩展赛,也称全国 ...

- vue模板三目运算判断报错

问题: 关于vue三目运算符提示报错 1.三目运算符等于判断 {{ a==b ? '是' : '否'}} 2.其他三目运算符 <代表小于号(<) >代表大于符号(>) ≤表示小 ...

- ImportError: cannot import name 'six' from 'django.utils'的解决办法

解决办法 对于3.x版本的django,安装django-utils-six2.0 pip install django-utils-six

- ASP.NET Core MVC中调用Json()时默认使用Newtonsoft.Json返回数据

1.需要安装两个包 Newtonsoft.Json Microsoft.AspNetCore.Mvc.NewtonsoftJson 2. Startup 类中的 ConfigureServices 方 ...

- redisTemplate实现分布式锁(释放锁用lua脚本)

package com.xxx.platform.util; import org.springframework.beans.factory.annotation.Autowired; import ...

- linux 下 配置 nginx

服务器:centOS7 安装nginx之前操作: yum install -y pcre pcre-devel // pcre是一个perl库,包括perl兼容的正则表达式库,nginx的http ...

- HCIP-进阶实验05-Eth-Trunk配置部署

HCIP-进阶实验06-Eth-Trunk配置部署 1 实验需求 1.1 实验拓扑 1.2 实验环境说明 无 1.3 实验需求 本实验共采用3台三层交换机.1台路由器.认真分析实验需求,明确每步考查的 ...