潭州课堂25班:Ph201805201 爬虫高级 第五课 sclapy 框架 日志和 settings 配置 模拟登录(课堂笔记)

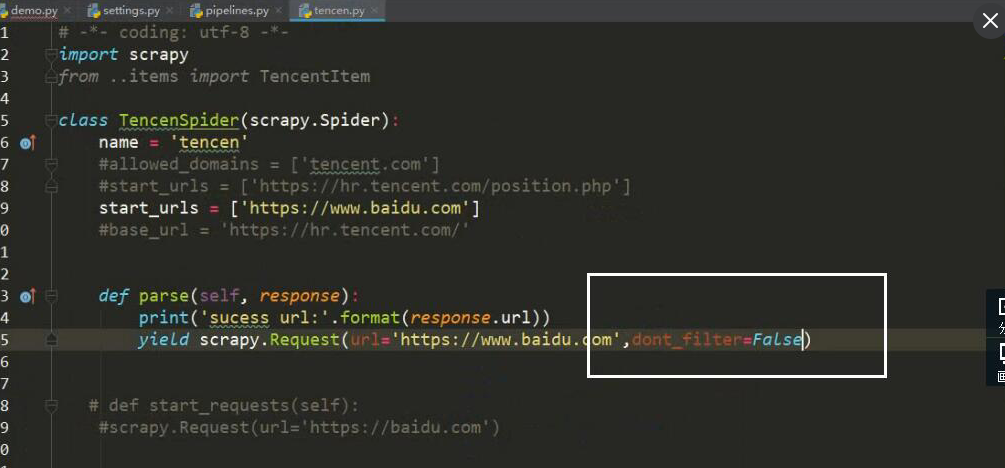

当要对一个页面进行多次请求时,

设 dont_filter = True 忽略去重

在 scrapy 框架中模拟登录

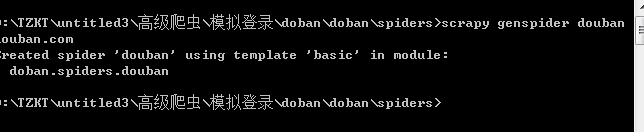

创建项目

创建运行文件

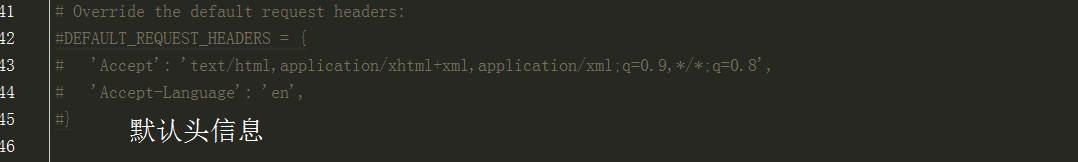

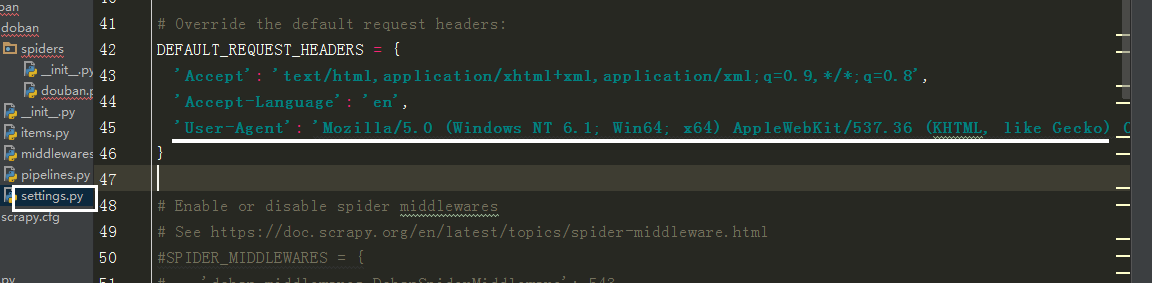

设请求头

# -*- coding: utf-8 -*-

import scrapy

import requests class DoubanSpider(scrapy.Spider):

name = 'douban'

# allowed_domains = ['douban.com']

# 登录页面

start_urls = ['https://accounts.douban.com/login']

log_url = 'https://accounts.douban.com/login'

c_g_url = 'https://www.douban.com/'

def parse(self, response):

# 如果出现验证码

# 验证码

captcha_url = response.xpath('//img[@id="captcha_image"]/@src').extract_first()

# 如果没有验证码

if not captcha_url:

print('没有验证码')

data = {

'source': 'index_nav',

'redir':'https://www.douban.com/people/184159212/',

'form_email': '13605938437',

'form_password': '17906808lmlmlm',

'login':'登录'

}

else:

print('出现验证码')

captcha_id = response.xpath('//input[@name="captcha-id"]/@value').extract_first()

# 下载图片验证码

with open('1.jpg','wb')as f:

f.write(requests.get(captcha_url).content)

captcha_solution = input('>>>>>')

data = {

'source': 'None',

'redir':'https://www.douban.com/',

'captcha-solution':captcha_solution,

'captcha-id':captcha_id,

'form_email': '账号',

'form_password': '密码',

'login':'登录'

} # 返回url , 参数 , 回调函数

yield scrapy.FormRequest(url=self.log_url,formdata=data,callback=self.login_after) def login_after(self,response):

# 判断是否登录成功

text ={

'ck': '7nL_',

'comment':' 哈哈....哈哈....哈哈....'

}

name = response.xpath('//*[@id="db-global-nav"]/div/div[1]/ul/li[2]/a/span[1]//text()').extract()

if name:

print('登录成功,当前用户是%s'%name)

yield scrapy.FormRequest(url=self.c_g_url,formdata=text)

else:print('登录失败')

潭州课堂25班:Ph201805201 爬虫高级 第五课 sclapy 框架 日志和 settings 配置 模拟登录(课堂笔记)的更多相关文章

- 潭州课堂25班:Ph201805201 爬虫高级 第七课 sclapy 框架 爬前程网 (课堂笔)

定时对该网页数据采集,所以每次只爬第一个页面就可以, 创建工程 scrapy startproject qianchen 创建运行文件 cd qianchenscrapy genspider qian ...

- 潭州课堂25班:Ph201805201 爬虫高级 第六课 sclapy 框架 中间建 与selenium对接 (课堂笔记)

因为每次请求得到的响应不一定是正常的, 也可以在中间建中与个类的方法,自动更换头自信,代理Ip, 在设置文件中添加头信息列表, 在中间建中导入刚刚的列表,和随机函数 class UserAgent ...

- 潭州课堂25班:Ph201805201 爬虫高级 第四课 sclapy 框架 crawispider类 (课堂笔记)

以上内容以 spider 类 获取 start_urls 里面的网页 在这里平时只写一个,是个入口,之后 通过 xpath 生成 url,继续请求, crawispider 中 多了个 rules ...

- 潭州课堂25班:Ph201805201 爬虫高级 第三课 sclapy 框架 腾讯 招聘案例 (课堂笔记)

到指定目录下,创建个项目 进到 spiders 目录 创建执行文件,并命名 运行调试 执行代码,: # -*- coding: utf-8 -*- import scrapy from ..items ...

- 潭州课堂25班:Ph201805201 爬虫高级 第十三 课 代理池爬虫检测部分 (课堂笔记)

1,通过爬虫获取代理 ip ,要从多个网站获取,每个网站的前几页2,获取到代理后,开进程,一个继续解析,一个检测代理是否有用 ,引入队列数据共享3,Queue 中存放的是所有的代理,我们要分离出可用的 ...

- 潭州课堂25班:Ph201805201 爬虫高级 第十一课 Scrapy-redis分布 项目实战 (课堂笔

- 潭州课堂25班:Ph201805201 爬虫高级 第十课 Scrapy-redis分布 (课堂笔记)

利用 redis 数据库,做 request 队列,去重,多台数据共享, scrapy 调度 基于文件每户,默认只能在单机运行, scrapy-redis 默认把数据放到 redis 中,实现数据共享 ...

- 潭州课堂25班:Ph201805201 爬虫高级 第八课 AP抓包 SCRAPY 的图片处理 (课堂笔记)

装好模拟器设置代理到 Fiddler 中, 代理 IP 是本机 IP, 端口是 8888, 抓包 APP斗鱼 用 format 设置翻页

- 潭州课堂25班:Ph201805201 爬虫基础 第五课 (案例) 豆瓣分析 (课堂笔记)

动态讲求 , 翻页参数: # -*- coding: utf-8 -*- # 斌彬电脑 # @Time : 2018/9/1 0001 3:44 import requests,json class ...

随机推荐

- java中网络设置代理

三种方式: 1.JVM启动时加参数设置代理 在系统启动时,使用-D项来设置代理. 例如: java -Dhttp.ProxyHost="proxyUrl" -Dhttp.Proxy ...

- 蓝牙HID协议笔记【转】

蓝牙HID协议笔记 转自:http://blog.sina.com.cn/s/blog_69b5d2a50101emll.html 1.概述 The Human Interface Devic ...

- c或c++的网络库

Asio C++ Library: Asio is a cross-platform C++ library for network and low-level I/O programming tha ...

- oracle ip 改为 机器名

1 hosts文件 添加 ip 机器名 这一行 2 修改listner.ora 和tnsora.ora ip改为机器名 3 重启服务

- 故障 -> nginx启动失败

描述:在用saltstack给 minion 安装 nginx 服务 时 提示 nginx 服务下载成功,但是启动失败. ---------- ID: nginx-systemctl Function ...

- zabbix3.0.4使用shell脚本和zabbix自带模板两种方法添加对指定进程和端口的监控

zabbix3.0.4添加对进程的监控: 方法一:通过自定义命令进行监控 主要思路: 通过 ps -ef|grep sdk-push-1.0.0.jar |grep -v grep|wc -l 这个命 ...

- centos系统中perl进程病毒占用大量网络流量导致网络瘫痪的问题分析及解决方案

故障现象: 1.系统在早上9点的时候非常慢,单台服务器占用流量很大,使交换机流量被占满,而连累挂在同一交换机上的其他应用也无法提供服务,或者速度非常慢 2.通过查看进程发现大量的perl程序占 ...

- 玩树莓派(raspberry pi) 2/3 raspbian的遇到的一些问题

raspberry pi买回来玩了一段时间,现在就记录一下入门遇到的一些问题吧. 首先是烧写镜像,和安装电脑系统是一样的道理. 先要有一个制作一个U启动盘.先将SD卡格式化,再用Win32DiskIm ...

- linux java报错汇总

一:♦linux 下javac 编译报 需要class, interface 或enum错误 ♦解析时已到达文件结尾 原因:大括号补匹配 //注意看报警提示

- notepad++颜色修改

设置-->>语言格式设置-->> https://blog.csdn.net/onceing/article/details/51554399(别人博客园的内容) 另外下面是N ...