elasticsearch index 之 Mapping

Lucene索引的一个特点就filed,索引以field组合。这一特点为索引和搜索提供了很大的灵活性。elasticsearch则在Lucene的基础上更近一步,它可以是 no scheme。实现这一功能的秘密就Mapping。Mapping是对索引各个字段的一种预设,包括索引与分词方式,是否存储等,数据根据字段名在Mapping中找到对应的配置,建立索引。这里将对Mapping的实现结构简单分析,Mapping的放置、更新、应用会在后面的索引fenx中进行说明。

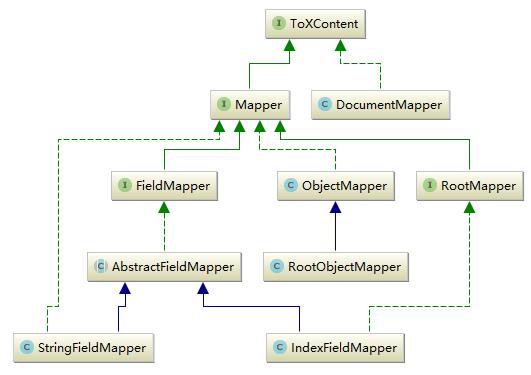

首先看一下Mapping的实现关系结构,如下图所示:

这只是Mapping中的一部分内容。Mapping扩展了lucene的filed,定义了更多的field类型既有Lucene所拥有的string,number等字段又有date,IP,byte及geo的相关字段,这也是es的强大之处。如上图所示,可以分为两类,mapper与documentmapper,前者是所有mapper的父接口。而DocumentMapper则是Mapper的集合,它代表了一个索引的mapper定义。

Mapper的有三类,第一类就是核心field结构FileMapper—>AbstractFieldMapper—>StringField这种核心数据类型,它代表了一类数据类型,如字符串类型,int类型这种;第二类是Mapper—>ObjectMapper—>RootObjectMapper,object类型的Mapper,这也是elasticsearch对lucene的一大改进,不想lucene之支持基本数据类型;最后一类是Mapper—>RootMapper—>IndexFieldMapper这种类型,只存在于根Mapper中的一种Mapper,如IdFieldMapper及图上的IndexFieldMapper,它们类似于index的元数据,只可能存在于某个index内部。

Mapper中一个比较重要的方法就是parse(ParseContext context),Mapper的子类对这个方法都有各自的实现。它的主要功能是通过解析ParseContext获取到对应的field,这个方法主要用于建立索引时。索引数据被继续成parsecontext,每个field解析parseContext构建对应的lucene Field。它在AbstractFieldMapper中的实现如下所示:

public void parse(ParseContext context) throws IOException {

final List<Field> fields = new ArrayList<>(2);

try {

parseCreateField(context, fields);//实际Filed解析方法

for (Field field : fields) {

if (!customBoost()) {//设置boost

field.setBoost(boost);

}

if (context.listener().beforeFieldAdded(this, field, context)) {

context.doc().add(field);//将解析完成的Field加入到context中

}

}

} catch (Exception e) {

throw new MapperParsingException("failed to parse [" + names.fullName() + "]", e);

}

multiFields.parse(this, context);//进行mutiFields解析,MultiFields作用是对同一个field做不同的定义,如可以进行不同分词方式的索引这样便于通过各种方式查询

if (copyTo != null) {

copyTo.parse(context);

}

}

这里的parseCreateField是一个抽象方法,每种数据类型都有自己的实现,如string的实现方式如下所示:

protected void parseCreateField(ParseContext context, List<Field> fields) throws IOException {

ValueAndBoost valueAndBoost = parseCreateFieldForString(context, nullValue, boost);//解析成值和boost

if (valueAndBoost.value() == null) {

return;

}

if (ignoreAbove > 0 && valueAndBoost.value().length() > ignoreAbove) {

return;

}

if (context.includeInAll(includeInAll, this)) {

context.allEntries().addText(names.fullName(), valueAndBoost.value(), valueAndBoost.boost());

}

if (fieldType.indexed() || fieldType.stored()) {//构建LuceneField

Field field = new Field(names.indexName(), valueAndBoost.value(), fieldType);

field.setBoost(valueAndBoost.boost());

fields.add(field);

}

if (hasDocValues()) {

fields.add(new SortedSetDocValuesField(names.indexName(), new BytesRef(valueAndBoost.value())));

}

if (fields.isEmpty()) {

context.ignoredValue(names.indexName(), valueAndBoost.value());

}

}

//解析出字段的值和boost

public static ValueAndBoost parseCreateFieldForString(ParseContext context, String nullValue, float defaultBoost) throws IOException {

if (context.externalValueSet()) {

return new ValueAndBoost((String) context.externalValue(), defaultBoost);

}

XContentParser parser = context.parser();

if (parser.currentToken() == XContentParser.Token.VALUE_NULL) {

return new ValueAndBoost(nullValue, defaultBoost);

}

if (parser.currentToken() == XContentParser.Token.START_OBJECT) {

XContentParser.Token token;

String currentFieldName = null;

String value = nullValue;

float boost = defaultBoost;

while ((token = parser.nextToken()) != XContentParser.Token.END_OBJECT) {

if (token == XContentParser.Token.FIELD_NAME) {

currentFieldName = parser.currentName();

} else {

if ("value".equals(currentFieldName) || "_value".equals(currentFieldName)) {

value = parser.textOrNull();

} else if ("boost".equals(currentFieldName) || "_boost".equals(currentFieldName)) {

boost = parser.floatValue();

} else {

throw new ElasticsearchIllegalArgumentException("unknown property [" + currentFieldName + "]");

}

}

}

return new ValueAndBoost(value, boost);

}

return new ValueAndBoost(parser.textOrNull(), defaultBoost);

}

以上就是Mapper如何将一个值解析成对应的Field的过程,这里只是简单介绍,后面会有详细分析。

DocumentMapper是一个索引所有Mapper的集合,它表述了一个索引所有field的定义,可以说是lucene的Document的定义,同时它还包含以下index的默认值,如index和search时默认分词器。它的部分Field如下所示:

private final DocumentMapperParser docMapperParser;

private volatile ImmutableMap<String, Object> meta;

private volatile CompressedString mappingSource;

private final RootObjectMapper rootObjectMapper;

private final ImmutableMap<Class<? extends RootMapper>, RootMapper> rootMappers;

private final RootMapper[] rootMappersOrdered;

private final RootMapper[] rootMappersNotIncludedInObject;

private final NamedAnalyzer indexAnalyzer;

private final NamedAnalyzer searchAnalyzer;

private final NamedAnalyzer searchQuoteAnalyzer;

DocumentMapper的功能也体现在parse方法上,它的作用是解析整条数据。之前在Mapper中看到了Field是如何解析出来的,那其实是在DocumentMapper解析之后。index请求发过来的整条数据在这里被解析出Field,查找Mapping中对应的Field设置,交给它去解析。如果没有且运行动态添加,es则会根据值自动创建一个Field同时更新Mapping。方法代码如下所示:

public ParsedDocument parse(SourceToParse source, @Nullable ParseListener listener) throws MapperParsingException {

ParseContext.InternalParseContext context = cache.get();

if (source.type() != null && !source.type().equals(this.type)) {

throw new MapperParsingException("Type mismatch, provide type [" + source.type() + "] but mapper is of type [" + this.type + "]");

}

source.type(this.type);

XContentParser parser = source.parser();

try {

if (parser == null) {

parser = XContentHelper.createParser(source.source());

}

if (sourceTransforms != null) {

parser = transform(parser);

}

context.reset(parser, new ParseContext.Document(), source, listener);

// will result in START_OBJECT

int countDownTokens = 0;

XContentParser.Token token = parser.nextToken();

if (token != XContentParser.Token.START_OBJECT) {

throw new MapperParsingException("Malformed content, must start with an object");

}

boolean emptyDoc = false;

token = parser.nextToken();

if (token == XContentParser.Token.END_OBJECT) {

// empty doc, we can handle it...

emptyDoc = true;

} else if (token != XContentParser.Token.FIELD_NAME) {

throw new MapperParsingException("Malformed content, after first object, either the type field or the actual properties should exist");

}

// first field is the same as the type, this might be because the

// type is provided, and the object exists within it or because

// there is a valid field that by chance is named as the type.

// Because of this, by default wrapping a document in a type is

// disabled, but can be enabled by setting

// index.mapping.allow_type_wrapper to true

if (type.equals(parser.currentName()) && indexSettings.getAsBoolean(ALLOW_TYPE_WRAPPER, false)) {

parser.nextToken();

countDownTokens++;

}

for (RootMapper rootMapper : rootMappersOrdered) {

rootMapper.preParse(context);

}

if (!emptyDoc) {

rootObjectMapper.parse(context);

}

for (int i = 0; i < countDownTokens; i++) {

parser.nextToken();

}

for (RootMapper rootMapper : rootMappersOrdered) {

rootMapper.postParse(context);

}

} catch (Throwable e) {

// if its already a mapper parsing exception, no need to wrap it...

if (e instanceof MapperParsingException) {

throw (MapperParsingException) e;

}

// Throw a more meaningful message if the document is empty.

if (source.source() != null && source.source().length() == 0) {

throw new MapperParsingException("failed to parse, document is empty");

}

throw new MapperParsingException("failed to parse", e);

} finally {

// only close the parser when its not provided externally

if (source.parser() == null && parser != null) {

parser.close();

}

}

// reverse the order of docs for nested docs support, parent should be last

if (context.docs().size() > 1) {

Collections.reverse(context.docs());

}

// apply doc boost

if (context.docBoost() != 1.0f) {

Set<String> encounteredFields = Sets.newHashSet();

for (ParseContext.Document doc : context.docs()) {

encounteredFields.clear();

for (IndexableField field : doc) {

if (field.fieldType().indexed() && !field.fieldType().omitNorms()) {

if (!encounteredFields.contains(field.name())) {

((Field) field).setBoost(context.docBoost() * field.boost());

encounteredFields.add(field.name());

}

}

}

}

}

ParsedDocument doc = new ParsedDocument(context.uid(), context.version(), context.id(), context.type(), source.routing(), source.timestamp(), source.ttl(), context.docs(), context.analyzer(),

context.source(), context.mappingsModified()).parent(source.parent());

// reset the context to free up memory

context.reset(null, null, null, null);

return doc;

}

将整条数据解析成ParsedDocument,解析后的数据才能进行后面的Field解析建立索引。

总结:以上就是Mapping的结构和相关功能概括,Mapper赋予了elasticsearch索引的更强大功能,使得索引和搜索可以支持更多数据类型,灵活性更高。

elasticsearch index 之 Mapping的更多相关文章

- ElasticSearch Index API && Mapping

ElasticSearch NEST Client 操作Index var indexName="twitter"; var deleteIndexResponse = clie ...

- elasticsearch index 之 put mapping

elasticsearch index 之 put mapping mapping机制使得elasticsearch索引数据变的更加灵活,近乎于no schema.mapping可以在建立索引时设 ...

- elasticsearch中的mapping映射配置与查询典型案例

elasticsearch中的mapping映射配置与查询典型案例 elasticsearch中的mapping映射配置示例比如要搭建个中文新闻信息的搜索引擎,新闻有"标题".&q ...

- ES 11 - 配置Elasticsearch的映射 (mapping)

目录 1 映射的相关概念 1.1 什么是映射 1.2 映射的组成 1.3 元字段 1.4 字段的类型 2 如何配置mapping 2.1 创建mapping 2.2 更新mapping 2.3 查看m ...

- 第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理 1.映射(mapping)介绍 映射:创建索引的时候,可以预先定义字 ...

- Elasticsearch:Dynamic mapping

Elasticsearch最重要的功能之一是它试图摆脱你的方式,让你尽快开始探索你的数据. 要索引文档,您不必首先创建索引,定义映射类型和定义字段 - 您只需索引文档,那么index,type和fie ...

- ElasticSearch Index操作源码分析

ElasticSearch Index操作源码分析 本文记录ElasticSearch创建索引执行源码流程.从执行流程角度看一下创建索引会涉及到哪些服务(比如AllocationService.Mas ...

- elasticsearch篇之mapping

2018年05月17日 18:01:37 lyzkks 阅读数:444更多 个人分类: Elastic stack 版权声明:文章内容来自于网络和博主自身学习体会,转载请注明出处,欢迎留言大家一起 ...

- 【ElasticSearch】:Mapping相关

Mapping 类似数据库中的表结构定义,主要作用如下: 定义Index下的字段名(Field Name). 定义字段类型,例如数值型.字符串型.布尔型等. 定义倒排索引相关配置,比如是否索引.记录p ...

随机推荐

- Kali linux 2016.2(Rolling)里Metasploit的OpenVAS

不多说,直接上干货! 关于OpenAVS的概念,我这里不多赘述. 前提得,大家要先安装好OpenVAS!!! 我们都知道,BT5中已经预先安装好了OpenVAS网络漏洞扫描工具,我们只需进行一些配置即 ...

- linux中的挂载是什么意思?通俗点讲

mount /dev/sda1 /mnt解释:mount 就是挂载命令,/dev/sda1是要挂载的磁盘分区,/mnt是要绑定的目录挂载后就能到目录/mnt去访问磁盘分区/dev/sda1里面的资料了 ...

- CSS之基于不同场景的垂直居中解决方案

元素的水平居中,如果是一个行内元素,就对它的父元素应用 “text-align:center”: 如果是一个块级元素,就对它自身应用“margin:auto”. 垂直居中的几种场景以及实现方法: 一. ...

- 《剑指offer》数值的整数次方

一.题目描述 给定一个double类型的浮点数base和int类型的整数exponent.求base的exponent次方. 二.输入 double base, int exponent 三.输出 b ...

- ELK到底是什么?那么多公司用!__转载

Sina.饿了么.携程.华为.美团.freewheel.畅捷通 .新浪微博.大讲台.魅族.IBM...... 这些公司都在使用ELK!ELK!ELK! ELK竟然重复了三遍,是个什么? 一.ELK ...

- Ubuntu14.04下tensorflow安装

自己电脑没装双系统,于是决定在虚拟机里装个tensorflow,以下是安装过程: 1.安装anaconda2 for Linux 官网下的话很慢,去清华的镜像网站下吧,我上一篇文章有网址 安装:bas ...

- Open With Atom添加到右键菜单/从右键菜单移除

1.进入Settings 快捷键ctrl+shift+p,输入settings后回车 2.切换到System选项卡 3.通过勾选/取消勾选以下选项实现添加/移除右键菜单 √ Show in file ...

- vscode 调试vue.js程序

npm install -g vue-cli //安装vue-clivue init webpack projectName //创建项目 1.Ctrl+~ 打开命令行 ...

- 洛谷1414 又是毕业季II

问题描述 彩排了一次,老师不太满意.当然啦,取每位同学的号数来找最大公约数显然不太合理.于是老师给每位同学评了一个能力值.于是现在问题变为,从n个学生中挑出k个人使得他们的默契程度(即能力值的最大公约 ...

- 阿里云上如何找到虚拟主机和用户名登录FileZilla软件?

0.少玩游戏 1.登录阿里云官网 :https://www.aliyun.com/ 2.点击自己的旁边的名称进入进入自己的页面 3.购买的域名和主机会在这里显示,点击域名与网站(万网)>云虚拟主 ...