scrapy框架爬取开源中国项目大厅所有的发布项目。

本文爬取的字段,项目名称,发布时间,项目周期,应用领域,最低报价,最高报价,技术类型

1,items中定义爬取字段。

import scrapy class KaiyuanzhongguoItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

name = scrapy.Field()

publishTime = scrapy.Field()

cycle = scrapy.Field()

application = scrapy.Field()

budgetMinByYuan = scrapy.Field()

budgetMaxByYuan = scrapy.Field()

ski = scrapy.Field()

2, 爬虫主程序

# -*- coding: utf-8 -*-

import scrapy

import json

from kaiyuanzhongguo.items import KaiyuanzhongguoItem

class KyzgSpider(scrapy.Spider):

name = 'kyzg'

# allowed_domains = ['www.xxx.com']

base_url = 'https://zb.oschina.net/project/contractor-browse-project-and-reward?pageSize=10¤tPage='

start_urls = ['https://zb.oschina.net/project/contractor-browse-project-and-reward?pageSize=10¤tPage=1']

def parse(self, response):

result = json.loads(response.text)

totalpage = result['data']['totalPage']

for res in result['data']['data']:

item = KaiyuanzhongguoItem()

item['name'] = res['name']

item['publishTime'] = res['publishTime']

item['cycle'] = res['cycle']

item['application'] = res['application']

item['budgetMinByYuan'] = res['budgetMinByYuan']

item['budgetMaxByYuan'] = res['budgetMaxByYuan']

skillList = res['skillList']

skill = []

item['ski'] = ''

if skillList:

for sk in skillList:

skill.append(sk['value'])

item['ski'] = ','.join(skill)

yield item

for i in range(2,totalpage+1):

url_info = self.base_url+str(i)

yield scrapy.Request(url=url_info,callback=self.parse)

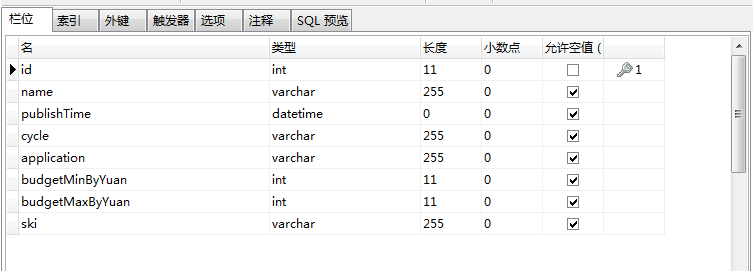

3,数据库设计

4,pipelines.py文件中写入mysql数据库

# 写入mysql数据库

import pymysql

class KaiyuanzhongguoPipeline(object):

conn = None

mycursor = None def open_spider(self, spider):

self.conn = pymysql.connect(host='172.16.25.4', user='root', password='root', db='scrapy')

self.mycursor = self.conn.cursor() def process_item(self, item, spider):

print(':正在写数据库...')

sql = 'insert into kyzg VALUES (null,"%s","%s","%s","%s","%s","%s","%s")' % (

item['name'], item['publishTime'], item['cycle'], item['application'], item['budgetMinByYuan'], item['budgetMaxByYuan'], item['ski'])

bool = self.mycursor.execute(sql)

self.conn.commit()

return item def close_spider(self, spider):

print('写入数据库完成...')

self.mycursor.close()

self.conn.close()

5,settings.py文件中设置请求头和打开下载管道

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.71 Safari/537.36'

ITEM_PIPELINES = {

'kaiyuanzhongguo.pipelines.KaiyuanzhongguoPipeline': 300,

}

6,运行爬虫

scrapy crawl kyzg --nolog

7,查看数据库是否写入成功

done。

scrapy框架爬取开源中国项目大厅所有的发布项目。的更多相关文章

- 使用scrapy框架爬取自己的博文(2)

之前写了一篇用scrapy框架爬取自己博文的博客,后来发现对于中文的处理一直有问题- - 显示的时候 [u'python\u4e0b\u722c\u67d0\u4e2a\u7f51\u9875\u76 ...

- scrapy框架爬取笔趣阁

笔趣阁是很好爬的网站了,这里简单爬取了全部小说链接和每本的全部章节链接,还想爬取章节内容在biquge.py里在加一个爬取循环,在pipelines.py添加保存函数即可 1 创建一个scrapy项目 ...

- scrapy框架爬取笔趣阁完整版

继续上一篇,这一次的爬取了小说内容 pipelines.py import csv class ScrapytestPipeline(object): # 爬虫文件中提取数据的方法每yield一次it ...

- Python使用Scrapy框架爬取数据存入CSV文件(Python爬虫实战4)

1. Scrapy框架 Scrapy是python下实现爬虫功能的框架,能够将数据解析.数据处理.数据存储合为一体功能的爬虫框架. 2. Scrapy安装 1. 安装依赖包 yum install g ...

- 爬虫入门(四)——Scrapy框架入门:使用Scrapy框架爬取全书网小说数据

为了入门scrapy框架,昨天写了一个爬取静态小说网站的小程序 下面我们尝试爬取全书网中网游动漫类小说的书籍信息. 一.准备阶段 明确一下爬虫页面分析的思路: 对于书籍列表页:我们需要知道打开单本书籍 ...

- 基于python的scrapy框架爬取豆瓣电影及其可视化

1.Scrapy框架介绍 主要介绍,spiders,engine,scheduler,downloader,Item pipeline scrapy常见命令如下: 对应在scrapy文件中有,自己增加 ...

- scrapy框架爬取糗妹妹网站妹子图分类的所有图片

爬取所有图片,一个页面的图片建一个文件夹.难点,图片中有不少.gif图片,需要重写下载规则, 创建scrapy项目 scrapy startproject qiumeimei 创建爬虫应用 cd qi ...

- scrapy框架爬取妹子图片

首先,建立一个项目#可在github账户下载完整代码:https://github.com/connordb/scrapy-jiandan2 scrapy startproject jiandan2 ...

- 使用scrapy框架爬取自己的博文(3)

既然如此,何不再抓一抓网页的文字内容呢? 谷歌浏览器有个审查元素的功能,就是按树的结构查看html的组织形式,如图: 这样已经比较明显了,博客的正文内容主要在div 的class = cnblogs_ ...

随机推荐

- django orm 改动数据库中已存在的表(添加、删除、修改表字段)

python3 manage.py makemigrations --empty api # 因为我的models.py文件并直接在项目根目录,而是根目录下的api目录中 python3 manage ...

- XT交易所Websocket API

WebSocketAPI xt为用户提供了一个简单的而又强大的API,旨在帮助用户快速高效的将xt交易功能整合到自己应用当中. WebSocket服务地址 xt WebSocket服务连接地址:wss ...

- 【NPDP笔记】第二章 组合管理

2.1 什么是产品组合 Product Portfolio 什么是组合管理,讲述的是完成正确的项目, 五大目标 财务稳健,财务目标 管道平衡,资源需求与可用资源之间的平衡 战略协同,与经营战略 组织战 ...

- 转 java 8 lamba stream

一直在写中间件相关的代码,提供SDK给业务方使用,但很多业务方还一直停留在1.7版本,迟迟不升级,为了兼容性,不敢在代码中使用Java8的一些新特性,比如Stream之类的,虽然不能用,但还是要学一下 ...

- solr的创建分片的方式

在Solr4.4之后,Solr提供了SolrCloud分布式集群的模式,它带来的主要好处是: (1)大数据量下更高的性能 (2)更好扩展性 (3)更高的可靠性 (4)更简单易用 什么时候应该使用Sol ...

- turtle1

#画风车 from turtle import * pensize(2) for i in range(4): seth(360-i*90) fd(150) rt(90) circle(-150,45 ...

- [转帖]linux下安装7z命令及7z命令的使用

linux下安装7z命令及7z命令的使用 https://www.cnblogs.com/yiwd/p/3649094.html yum install p7zip 执行命令为 7za x 或者是 7 ...

- identity server4

dotnet new -i identityserver4.templates 添加模板

- Java的含义

Java是一种广泛使用的计算机编程语言,拥有跨平台.面向对象.泛型编程的特性,广泛应用于企业级Web应用开发和移动应用开发. Java语言它不是软件,这里给各位初学者们详细解释一下.简单来说计算机语言 ...

- B站动态转发抽奖脚本+教程

运行python脚本需要的条件: 1.连通的网络 2.已安装Python2并配置环境变量 3.Python脚本源码 环境搭建: 网络就不用我说了("'▽'") 那么下面我们来安装 ...