阿狸V任务页面爬取数据解析

需求:

爬取:https://v.taobao.com/v/content/video 所有主播详情页信息

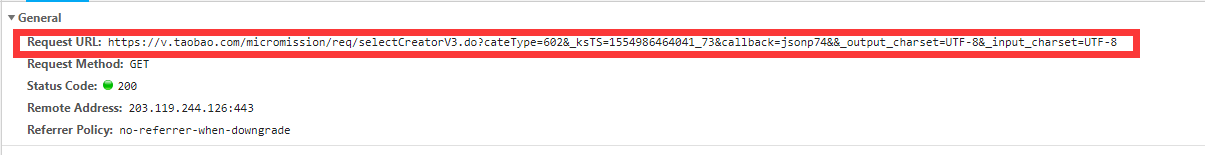

首页分析

分析可以得知数据是通过ajax请求获取的.

分析请求头

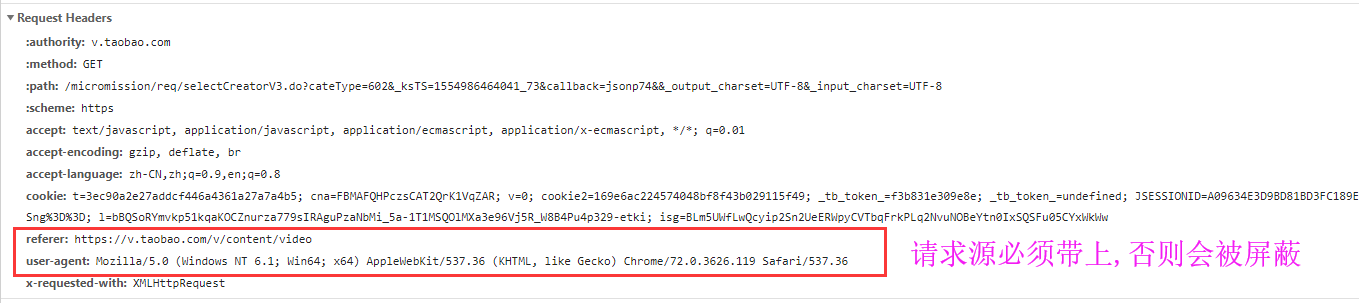

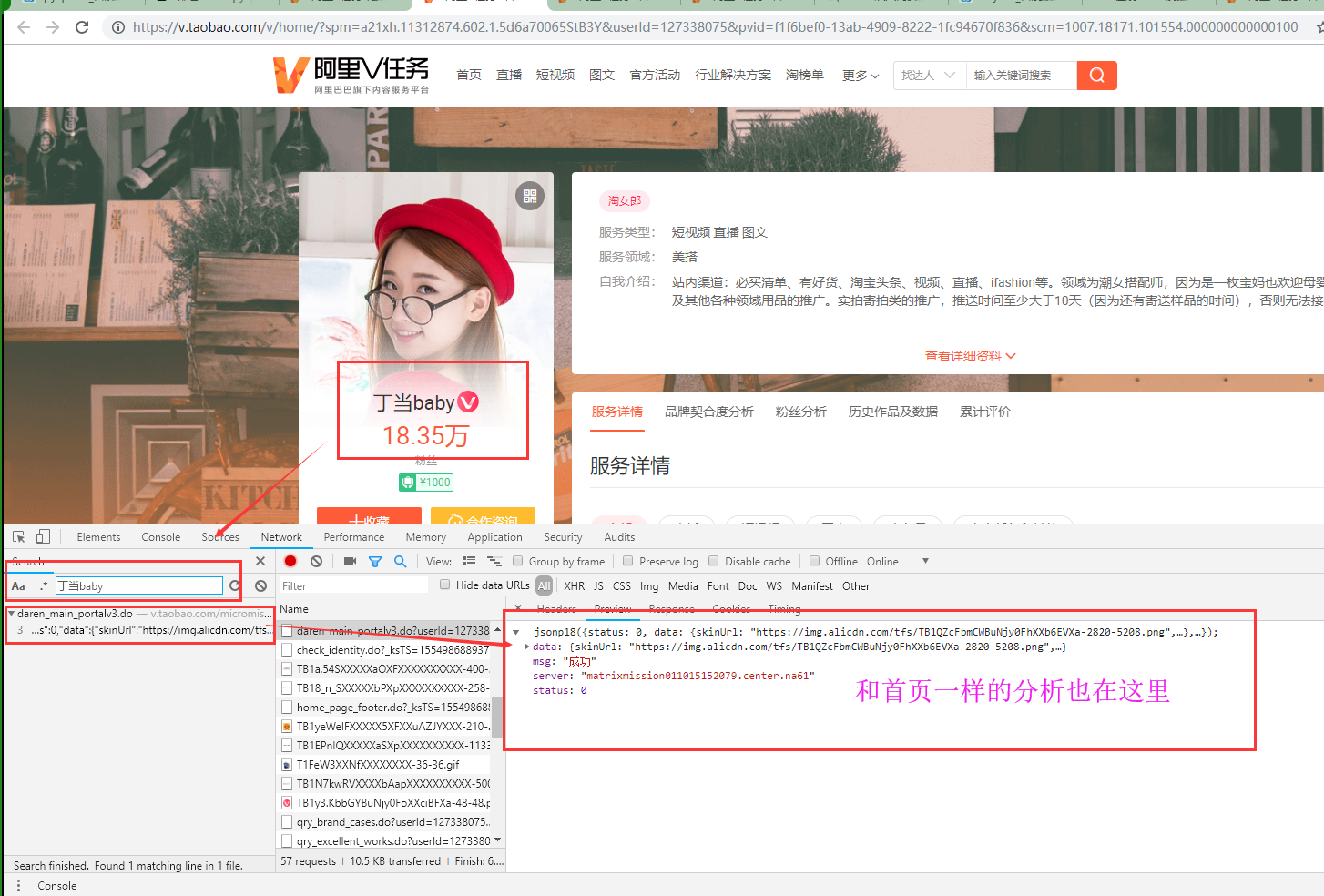

详情页分析

详情页和详情页数据url对比分析

经过测试,发现我们只需要更改'''userid'''的值就可以获取到不同的数据.

分析完毕开始编写代码

完整代码如下

import re

import requests

import json

import jsonpath

import pymongo

class VtaoSpider:

headers={

'referer': 'https://v.taobao.com/v/content/video',

'user-agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36',

} db=None

def open(self):

'连接数据库'

client=pymongo.MongoClient(host='106.12.108.236',port=27017)

self.db=client['trip'] def get_first_page(self):

'获取首页所有的数据'

url_lst=[]

for i in range(1,26): #25页数据

'处理页面'

params={

'cateType': 602,

'currentPage': i,

'_ksTS': '1554971959356_87',

'':'',

'_output_charset': 'UTF-8',

'_input_charset': 'UTF-8',

}

start_url='https://v.taobao.com/micromission/req/selectCreatorV3.do' first_data=requests.get(url=start_url,headers=self.headers,params=params)

url_lst.append(first_data)

# print(first_data.text)

return url_lst def get_detail_url(self):

'获取详情页的url'

response_list=self.get_first_page()

all_detail_url=[]

for response in response_list:

dd = response.text

d_dict = json.loads(dd)

detail_url = jsonpath.jsonpath(d_dict, '$..homeUrl')

#detail_url是一个列表

all_detail_url.extend(detail_url)

# print(all_detail_url)

return all_detail_url def get_detail_data(self):

url_list=self.get_detail_url()

# print(url_list)

for url in url_list:

try:

ex='userId=(.*?)&'

user_id=re.findall(ex,url)[0]

detail_data_url=f'https://v.taobao.com/micromission/daren/daren_main_portalv3.do?userId={user_id}&_ksTS=1554976401436_17'

# print(detail_data_url) #获取响应数据

data = requests.get(url=detail_data_url, headers=self.headers).text

data_json=json.loads(data)

darenNick=jsonpath.jsonpath(data_json,'$..darenNick')[0]

darenScore=jsonpath.jsonpath(data_json,'$..darenScore')[0]

nick=jsonpath.jsonpath(data_json,'$..nick')[0]

creatorType=jsonpath.jsonpath(data_json,'$..creatorType')[0]

rank=jsonpath.jsonpath(data_json,'$..rank')

res_data={

'darenNick':darenNick,

'darenScore':darenScore,

'nick':nick,

'creatorType':creatorType,

'rank':rank, }

#存入数据库

if self.db['vtaobao'].insert(res_data):

print('save to mongo is successful!') except Exception as e:

print(e) if __name__ == '__main__':

vspider=VtaoSpider()

#数据库启动只需要执行一次

vspider.open()

vspider.get_detail_data()

一共爬取了450条数据,就是450个主播的相关信息!!!

此代码为使用多进程,多线程,爬取时间不能如你们所愿,感兴趣的朋友可以把代码重构一下,使用多进程,多线程,再分享一波,让大家学习一番,谢谢!!!

阿狸V任务页面爬取数据解析的更多相关文章

- Python实训day07pm【Selenium操作网页、爬取数据-下载歌曲】

练习1-爬取歌曲列表 任务:通过两个案例,练习使用Selenium操作网页.爬取数据.使用无头模式,爬取网易云的内容. ''' 任务:通过两个案例,练习使用Selenium操作网页.爬取数据. 使用无 ...

- 【图文详解】scrapy爬虫与动态页面——爬取拉勾网职位信息(2)

上次挖了一个坑,今天终于填上了,还记得之前我们做的拉勾爬虫吗?那时我们实现了一页的爬取,今天让我们再接再厉,实现多页爬取,顺便实现职位和公司的关键词搜索功能. 之前的内容就不再介绍了,不熟悉的请一定要 ...

- Python使用Scrapy框架爬取数据存入CSV文件(Python爬虫实战4)

1. Scrapy框架 Scrapy是python下实现爬虫功能的框架,能够将数据解析.数据处理.数据存储合为一体功能的爬虫框架. 2. Scrapy安装 1. 安装依赖包 yum install g ...

- 借助Chrome和插件爬取数据

工具 Chrome浏览器 TamperMonkey ReRes Chrome浏览器 chrome浏览器是目前最受欢迎的浏览器,没有之一,它兼容大部分的w3c标准和ecma标准,对于前端工程师在开发过程 ...

- python3编写网络爬虫14-动态渲染页面爬取

一.动态渲染页面爬取 上节课我们了解了Ajax分析和抓取方式,这其实也是JavaScript动态渲染页面的一种情形,通过直接分析Ajax,借助requests和urllib实现数据爬取 但是javaS ...

- web scraper——简单的爬取数据【二】

web scraper——安装[一] 在上文中我们已经安装好了web scraper现在我们来进行简单的爬取,就来爬取百度的实时热点吧. http://top.baidu.com/buzz?b=1&a ...

- 关于js渲染网页时爬取数据的思路和全过程(附源码)

于js渲染网页时爬取数据的思路 首先可以先去用requests库访问url来测试一下能不能拿到数据,如果能拿到那么就是一个普通的网页,如果出现403类的错误代码可以在requests.get()方法里 ...

- node.js爬取数据并定时发送HTML邮件

node.js是前端程序员不可不学的一个框架,我们可以通过它来爬取数据.发送邮件.存取数据等等.下面我们通过koa2框架简单的只有一个小爬虫并使用定时任务来发送小邮件! 首先我们先来看一下效果图 差不 ...

- 爬虫系列5:scrapy动态页面爬取的另一种思路

前面有篇文章给出了爬取动态页面的一种思路,即应用Selenium+Firefox(参考<scrapy动态页面爬取>).但是selenium需要运行本地浏览器,比较耗时,不太适合大规模网页抓 ...

随机推荐

- SpringBoot2.0之五 优雅整合SpringBoot2.0+MyBatis+druid+PageHelper

上篇文章我们介绍了SpringBoot和MyBatis的整合,可以说非常简单快捷的就搭建了一个web项目,但是在一个真正的企业级项目中,可能我们还需要更多的更加完善的框架才能开始真正的开发,比如连接池 ...

- 使用正则替换script及其内容

因做微信公众号文章保存,发现他的js大多数也用不着,所以就想着用正则替换掉源代码中的js片段 正则代码: <script(?:[^<]++|<(?!/script>))*+&l ...

- k8s实战之从私有仓库拉取镜像 - kubernetes

1.实战目的 从私有docker仓库拉取镜像,部署pod.上一篇中,我们搭建了私有的镜像仓库,这一篇我们将与k8s结合实战使用私有仓库. 2.登录docker 为了完成本次实战,需要登录docker, ...

- 一文让你明白Redis主从同步

今天想和大家分享有关 Redis 主从同步(也称「复制」)的内容. 我们知道,当有多台 Redis 服务器时,肯定就有一台主服务器和多台从服务器.一般来说,主服务器进行写操作,从服务器进行读操作. 那 ...

- 第5章 简单的C程序设计——循环结构程序设计

5.1 为什么需要循环控制 前面介绍了程序中常用到的顺序结构和选择结构,但是只有这两种结构是不够的,还需要用到循环结构(或称重复结构).因为在程序所处理的问题中常常遇到需要重复处理的问题. 循环结构和 ...

- 网络协议 16 - DNS 协议:网络世界的地址簿

[前五篇]系列文章传送门: 网络协议 11 - Socket 编程(下):眼见为实耳听为虚 网络协议 12 - HTTP 协议:常用而不简单 网络协议 13 - HTTPS 协议:加密路上无尽头 网络 ...

- 微信小程序初体验,入门练手项目--通讯录,后台是阿里云服务器(一)

内容: 一.前言 二.相关概念 三.开始工作 四.启动项目起来 五.项目结构 六.设计理念 七.路由 八.部署线上后端服务 同步交流学习社区: https://www.mwcxs.top/page/4 ...

- Capacitor 新一代混合应用“神器” 会代替Cordova吗??

1.介绍or畅想 Capacitor是由ionic团队最新开发维护的一个跨平台的应用程序容器,可以轻松构建在iOS,Android,Electron 和 Web 上本机运行的Web应用程序.我们称这些 ...

- async/await使用深入详解

async和await作为异步模型代码编写的语法糖已经提供了一段时间不过一直没怎么用,由于最近需要在BeetleX webapi中集成对Task方法的支持,所以对async和await有了深入的了解和 ...

- 数据库~dotnetcore连接Mysql插入中文失败

到目录 在dotnetcore里,连接mysql数据,插入中文时出现无法识别,并提示插入失败的情况,分析后得知它是编码问题,即数据库编码问题,你的中文在数据表里无法被识别! 解决方法(一) 进行mys ...