Pipeline和FeatureUnion

注:本文是人工智能研究网的学习笔记

Pipeline:chaining(链接)estimators

Pipeline可以用于把多个estimators级联合成一个estimator。这么做的原因是考虑了数据处理过程的一系列前后相继的固定流程,比如:feature selection --> normalization --> classification。

在这里,Pipeline提供了两种服务:

- Convenience: 你只需要一次fit和predict就可以在数据集上训练一组estimators。

- Join parameter selection: 可以把grid search用在pipeline中所有的estimators的参数组合上面。

注意: pineline中除了最后一个之外的所有的estimators都必须是变换器(transformers)(也就是说必须要有一个transform方法)。最后一个estimator可以是任意的类型(transformer, classifier, regresser, etc)。

调用pipeline estimator的fit方法,就等于是轮流调用每一个estimator的fit函数一样,不断地变换输入,然后把结果传递到下一个阶段(step)的estimator。Pipeine对象实例拥有最后一个estimator的所有的方法。也就是说,如果最后一个estimator是一个分类器,则整个pipeline就可以作为一个分类器使用,如果最后一个eatimator是一个聚类器,则整个pipeline就可以作为一个聚类器使用。

Pipeline用法:

Pipeline对象使用(key, value)列表来构建,其中key是一个标识步骤的名称字符串,值是一个estimator对象:

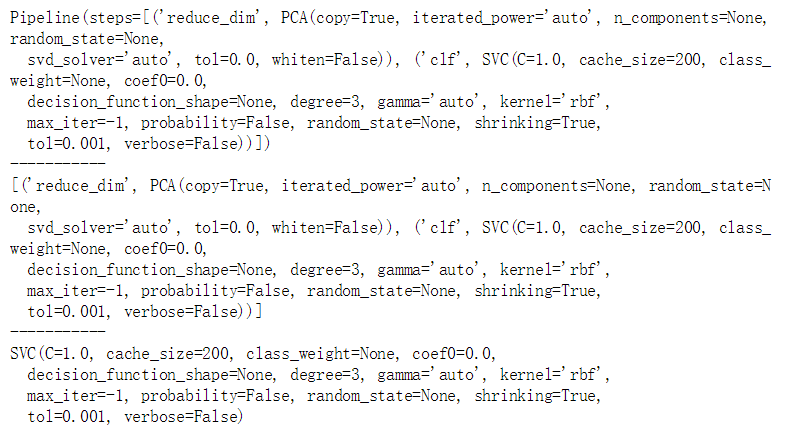

from sklearn.pipeline import Pipeline

from sklearn.svm import SVC

from sklearn.decomposition import PCA # 主成分分析

estimators = [('reduce_dim', PCA()), ('clf', SVC()) ]

pipe = Pipeline(estimators)

print(pipe)

print('-----------')

print(pipe.steps)

print('-----------')

print(pipe.named_steps['clf'])

Pipeline中estimators的参数通过__语法来获取

pipe.set_params(clf__C=10)

上面的方式在网格搜索中尤其好用

from sklearn.model_selection import GridSearchCV

params = dict(reduce_dim__n_components=[2, 5, 10],

clf__C=[0.1, 10, 100])

grid_search = GridSearchCV(pipe, param_grid=params)

单个的阶段(Step)可以使用参数替换,而且非最后阶段(non-final steps)还可以将其设置为None来忽略。

from sklearn.linear_model import LogisticRegression

params = dict(reduce_dim=[None, PCA(5), PCV(10)],

clf=[SVC(), LogisticRegression()],

clf__C=[0.1, 10, 100])

grid_search = GridSearchCV(pipe, param_grid=params)

函数make_pipeline是一个构造pipeline的简短的工具,它可以接受可变数量的estimators并且返回一个pipeline,每个estimator的名称是自动填充的,他不需要指定name。

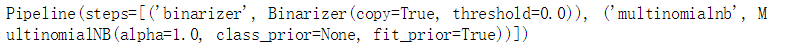

from sklearn.pipeline import make_pipeline

from sklearn.naive_bayes import MultinomialNB

from sklearn.preprocessing import Binarizer

make_pipeline(Binarizer(), MultinomialNB())

FeatureUnion: composite(组合)feature spaces

FeatureUnion把若干个transformer object组合成一个新的estimators。这个新的transformer组合了他们的输出,一个FeatureUnion对象接受一个transformer对象列表。

在训练阶段,每一个transformer都在数据集上独立的训练。在数据变换阶段,多有的训练好的Trandformer可以并行的执行。他们输出的样本特征向量被以end-to-end的方式拼接成为一个更大的特征向量。

在这里,FeatureUnion提供了两种服务:

- Convenience: 你只需要调用一次fit和transform就可以在数据集上训练一组estimators。

- Joint parameter selection: 可以把grid search用在FeatureUnion中所有的estimators的参数这上面。

FeatureUnion和Pipeline可以组合使用来创建更加复杂的模型。

注意:FeatureUnion无法检查两个transformers是否产生了相同的特征输出,它仅仅产生了一个原来互相分离的特征向量的集合。确保其产生不一样的特征输出是调用者的事情。

用法:

FeatureUnion对象实例使用(key, value)构成的list来构造,key是你自己起的transformation的名称,value是一个estimator对象。

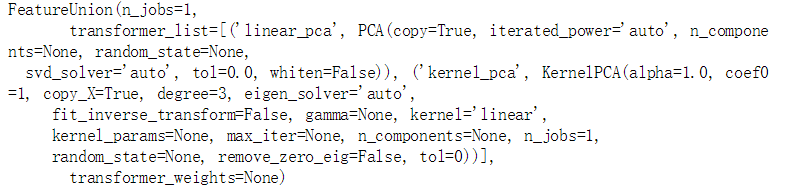

from sklearn.pipeline import FeatureUnion

from sklearn.decomposition import PCA

from sklearn.decomposition import KernelPCA

estimators = [('linear_pca', PCA()), ('kernel_pca', KernelPCA())]

combined = FeatureUnion(estimators)

combined

与pipeline类似,feature unions也有一个比较简单地构造方法make_union,不需要显式的给出name。

Pipeline和FeatureUnion的更多相关文章

- sklearn 中的 Pipeline 机制 和FeatureUnion

一.pipeline的用法 pipeline可以用于把多个estimators级联成一个estimator,这么 做的原因是考虑了数据处理过程中一系列前后相继的固定流程,比如feature selec ...

- sklearn中pipeline的用法和FeatureUnion

一.pipeline的用法 pipeline可以用于把多个estimators级联成一个estimator,这么 做的原因是考虑了数据处理过程中一系列前后相继的固定流程,比如feature selec ...

- [Machine Learning with Python] My First Data Preprocessing Pipeline with Titanic Dataset

The Dataset was acquired from https://www.kaggle.com/c/titanic For data preprocessing, I firstly def ...

- [Feature] Final pipeline: custom transformers

有视频:https://www.youtube.com/watch?v=BFaadIqWlAg 有代码:https://github.com/jem1031/pandas-pipelines-cust ...

- [Feature] Build pipeline

准备数据集 一.数据集 Ref: 6. Dataset loading utilities[各种数据集选项] 第一部分,加载原始iris数据集的数据: 第二部分,先增加一行,再增加一列: #%% pa ...

- pipeline和baseline是什么?

昨天和刚来项目的机器学习小白解释了一边什么baseline 和pipeline,今天在这里总结一下什么是baseline和pipeline. 1.pipeline 1.1 从管道符到pipeline ...

- [占位-未完成]scikit-learn一般实例之十一:异构数据源的特征联合

[占位-未完成]scikit-learn一般实例之十一:异构数据源的特征联合 Datasets can often contain components of that require differe ...

- 使用sklearn优雅地进行数据挖掘【转】

目录 1 使用sklearn进行数据挖掘 1.1 数据挖掘的步骤 1.2 数据初貌 1.3 关键技术2 并行处理 2.1 整体并行处理 2.2 部分并行处理3 流水线处理4 自动化调参5 持久化6 回 ...

- 使用sklearn优雅地进行数据挖掘

目录 1 使用sklearn进行数据挖掘 1.1 数据挖掘的步骤 1.2 数据初貌 1.3 关键技术2 并行处理 2.1 整体并行处理 2.2 部分并行处理3 流水线处理4 自动化调参5 持久化6 回 ...

随机推荐

- python3学习笔记.5.打包发布

为了给别人使用将 .py 文件打包成 .exe 文件 安装 PyInstaller ,完成 打开 Cmd 调用 path:\pyinstaller.exe -F path:\name.py 发布文件 ...

- MyBatis 总结记录

1.1MyBatis简介 MyBatis 是一个可以自定义SQL.存储过程和高级映射的持久层框架.MyBatis 摒除了大部分的JDBC代码.手工设置参数和结果集重获.MyBatis 只使用简单的XM ...

- Ubuntu下安装arm-linux-gnueabi-xxx编译器【转】

转自:http://blog.csdn.net/real_myth/article/details/51481639 from: http://www.linuxdiyf.com/linux/1948 ...

- 数据库-mysql视图

视图是一个虚拟表(非真实存在),其本质是[根据SQL语句获取动态的数据集,并为其命名],用户使用时只需使用[名称]即可获取结果集,并可以将其当作表来使用 一:创建视图 create view view ...

- 洛谷P1455搭配购买

传送门啦 这是强连通分量与背包的例题 需要注意的就是价值和价格两个数组不要打反了.. 另外 这是双向图!!! #include <iostream> #include <cstdio ...

- delphi TComponent类 2

来自:http://blog.csdn.net/lailai186/article/details/7442385 ------------------------------------------ ...

- SQL SERVER 断开所有连接(转)

通过sql server management studio对数据进行管理,比如数据库改名等,经常遇到有正在运行的连接,以致无法操作,这时候断掉所有的连接很有必要.代码如下:(会断掉某个库的所有连接, ...

- 【考古向翻译】Pwn2Own 2010 Windows 7 Internet Explorer 8 exploit

正好在Google搜到了这篇文章,就打算自己翻译一下,也不清楚国内是否有人已经翻译过了.作者是Pwn2Own 2010的获奖者来自荷兰的皮特·维莱格登希尔(Peter Vreugdenhil). 20 ...

- IE6 验证码刷新失败显示空白解决办法

原因:点击a标签看不清?换图片 结果验证码显示的空白! 解决办法:在对应的点击事件最后加上return false 即可解决问题. 下面是HTML源码: <p class="regis ...

- POJ - 1743 后缀自动机

POJ - 1743 顺着原字符串找到所有叶子节点,然后自下而上更新,每个节点right的最左和最右,然后求出答案. #include<cstdio> #include<cstrin ...