073 HBASE的读写以及client API

一:读写思想

1.系统表

hbase:namespace

存储hbase中所有的namespace的信息

hbase:meta

rowkey:hbase中所有表的region的名称

column:regioninfo:region的名称,region的范围

server:该region在哪台regionserver上

2.读写流程

tbname,rowkey -> region -> regionserver -> store -> storefile

但是这些都是加载过meta表之后,然后meta表如何寻找?

3.读的流程

-》根据表名和rowkey找到对应的region

-》zookeeper中存储了meta表的region信息

-》从meta表中获取相应的region的信息

-》找到对应的regionserver

-》查找对应的region

-》读memstore

-》storefile

4.写的流程

-》根据表名和rowkey找到对应的region

-》zookeeper中存储了meta表的region信息

-》从meta表中获取相应的region的信息

-》找到对应的regionserver

-》正常情况

-》WAL(write ahead log预写日志),一个regionserver维护一个hlog

-》memstore (达到一定大小,flush到磁盘)

-》当多个storefile达到一定大小以后,会进行compact,合并成一个storefile

-》当单个storefile达到一定大小以后,会进行split操作,等分割region

5.注意点

关于版本的合并和删除是在compact阶段完成的。hbase只负责数据的增加存储

hmaster短暂的不参与实际的读写

二:HBase Client API 的书写

1.添加依赖

2.添加配置文件

core-site.xml

hdfs-site.xml

hbase-site.xml

log4j.properties

regionservers

3.get的书写

4.put的书写

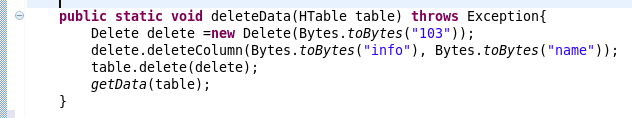

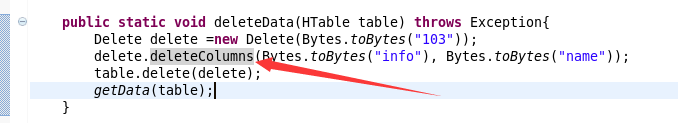

5.delete的书写

注意全部删除:

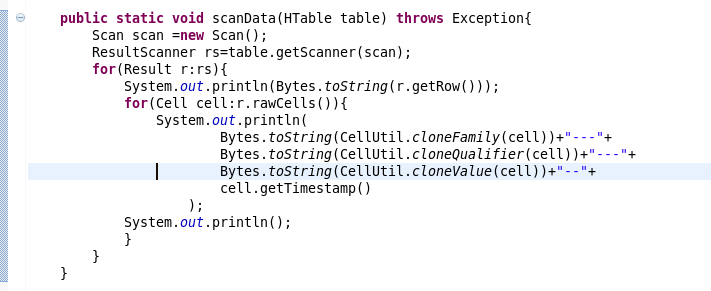

6.scan的书写

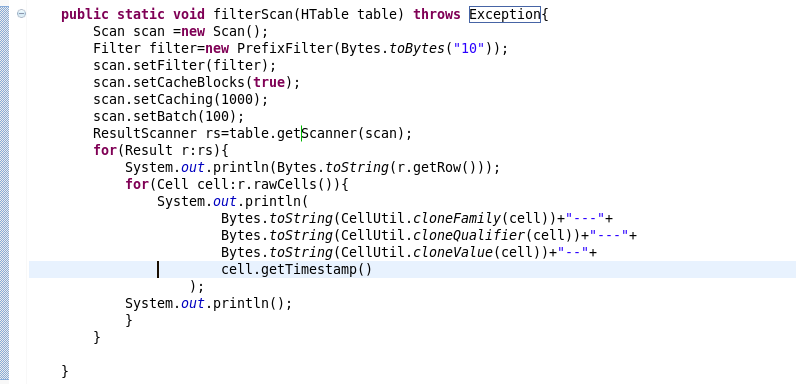

7.过滤条件的scan的书写

三:复制源代码

package com.beifeng.bigdat; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.Cell;

import org.apache.hadoop.hbase.CellUtil;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.client.Delete;

import org.apache.hadoop.hbase.client.Get;

import org.apache.hadoop.hbase.client.HTable;

import org.apache.hadoop.hbase.client.Put;

import org.apache.hadoop.hbase.client.Result;

import org.apache.hadoop.hbase.client.ResultScanner;

import org.apache.hadoop.hbase.client.Scan;

import org.apache.hadoop.hbase.filter.Filter;

import org.apache.hadoop.hbase.filter.PrefixFilter;

import org.apache.hadoop.hbase.util.Bytes; public class HbaseClientTest {

public static HTable getTable(String name) throws Exception{

Configuration conf=HBaseConfiguration.create();

HTable table=new HTable(conf,name);

return table; }

public static void getData(HTable table) throws Exception{

Get get=new Get(Bytes.toBytes("103"));

get.addFamily(Bytes.toBytes("info"));

Result rs=table.get(get);

for(Cell cell:rs.rawCells()){

System.out.println(

Bytes.toString(CellUtil.cloneFamily(cell))+"--"+

Bytes.toString(CellUtil.cloneQualifier(cell))+"---"+

Bytes.toString(CellUtil.cloneValue(cell))+"----"+

cell.getTimestamp()

);

System.out.println("----------------------------------------------");

}

} public static void putData(HTable table) throws Exception{

Put put=new Put(Bytes.toBytes("103"));

put.add(Bytes.toBytes("info"),

Bytes.toBytes("name"),

Bytes.toBytes("zhaoliu"));

table.put(put);

getData(table);

} public static void deleteData(HTable table) throws Exception{

Delete delete =new Delete(Bytes.toBytes("103"));

delete.deleteColumns(Bytes.toBytes("info"), Bytes.toBytes("name"));

table.delete(delete);

getData(table);

} public static void scanData(HTable table) throws Exception{

Scan scan =new Scan();

ResultScanner rs=table.getScanner(scan);

for(Result r:rs){

System.out.println(Bytes.toString(r.getRow()));

for(Cell cell:r.rawCells()){

System.out.println(

Bytes.toString(CellUtil.cloneFamily(cell))+"---"+

Bytes.toString(CellUtil.cloneQualifier(cell))+"---"+

Bytes.toString(CellUtil.cloneValue(cell))+"--"+

cell.getTimestamp()

);

System.out.println();

}

}

} public static void filterScan(HTable table) throws Exception{

Scan scan =new Scan();

Filter filter=new PrefixFilter(Bytes.toBytes("10"));

scan.setFilter(filter);

scan.setCacheBlocks(true);

scan.setCaching(1000);

scan.setBatch(100);

ResultScanner rs=table.getScanner(scan);

for(Result r:rs){

System.out.println(Bytes.toString(r.getRow()));

for(Cell cell:r.rawCells()){

System.out.println(

Bytes.toString(CellUtil.cloneFamily(cell))+"---"+

Bytes.toString(CellUtil.cloneQualifier(cell))+"---"+

Bytes.toString(CellUtil.cloneValue(cell))+"--"+

cell.getTimestamp()

);

System.out.println();

}

} } public static void main(String[] args) throws Exception {

HTable table=getTable("nstest1:tb1");

//getData(table);

//putData(table);

//deleteData(table);

//scanData(table);

filterScan(table);

} }

073 HBASE的读写以及client API的更多相关文章

- HBASE的读写以及client API

一:读写思想 1.系统表 hbase:namespace 存储hbase中所有的namespace的信息 hbase:meta rowkey:hbase中所有表的region的名称 column:re ...

- HBase 二次开发 java api和demo

1. 试用thrift python/java以及hbase client api.结论例如以下: 1.1 thrift的安装和公布繁琐.可能会遇到未知的错误,且hbase.thrift的版本 ...

- hbase的读写过程

hbase的读写过程: hbase的架构: Hbase真实数据hbase真实数据存储在hdfs上,通过配置文件的hbase.rootdir属性可知,文件在/user/hbase/下hdfs dfs - ...

- Hbase的读写流程

HBase读写流程 1.HBase读数据流程 HRegionServer保存着meta表以及表数据,要访问表数据,首先Client先去访问zookeeper,从zookeeper里面获取meta表所在 ...

- HBase 数据读写流程

HBase 数据读写流程 2016-10-18 杜亦舒 读数据 HBase的表是按行拆分为一个个 region 块儿,这些块儿被放置在各个 regionserver 中 假设现在想在用户表中获取 ro ...

- ecshop /api/client/api.php、/api/client/includes/lib_api.php SQL Injection Vul

catalog . 漏洞描述 . 漏洞触发条件 . 漏洞影响范围 . 漏洞代码分析 . 防御方法 . 攻防思考 1. 漏洞描述 ECShop存在一个盲注漏洞,问题存在于/api/client/api. ...

- Memcached Java Client API详解

针对Memcached官方网站提供的java_memcached-release_2.0.1版本进行阅读分析,Memcached Java客户端lib库主要提供的调用类是SockIOPool和MemC ...

- Jersey(1.19.1) - Client API, Uniform Interface Constraint

The Jersey client API is a high-level Java based API for interoperating with RESTful Web services. I ...

- Jersey(1.19.1) - Client API, Ease of use and reusing JAX-RS artifacts

Since a resource is represented as a Java type it makes it easy to configure, pass around and inject ...

随机推荐

- DTP协议攻击

DTP协议 动态中继协议DTP(Dynamic Trunking Protocol)是一种Cisco私有协议.DTP用于两台交换机的直连二层端口探测对端的配置,自动协商出二层端口的链路类型和以太网封装 ...

- DNS缓存欺骗攻击

1.受影响的无线网络设备 一些D-link.TP-Link.Belkin.Linksys及IPTime等品牌无线路由器存在安全隐患. 2.漏洞描述 攻击者向DNS服务器注入非法网络域名地址,如果服务器 ...

- C# 面向对象的new关键字的使用

using System; using System.Collections.Generic; using System.Linq; using System.Text; namespace Cons ...

- Nginx proxy开启cache缓存

proxy_temp_path /tmp/proxy_temp_dir; // 设置缓存位置 proxy_cache_path /tmp/proxy_cache_dir levels = : keys ...

- [USACO]地震 (二分答案+最优比率生成树详解)

题面:[USACO 2001 OPEN]地震 题目描述: 一场地震把约翰家的牧场摧毁了, 坚强的约翰决心重建家园. 约翰已经重建了N个牧场,现在他希望能修建一些道路把它们连接起来.研究地形之后,约翰发 ...

- nginx反向代理实现前后端分离&跨域问题

1.代理和跨域 1.1 正向代理 1)用户希望代理服务器帮助其和要访问服务器之间实现通信,需要: a.用户IP报文的目的IP=代理服务器IP: b.用户报文端口号=代理服务器监听端口号: c.HTTP ...

- DBSCAN密度聚类

1. 密度聚类概念 DBSCAN(Density-Based Spatial Clustering of Applications with Noise,具有噪声的基于密度的聚类方法)是一种很典型的密 ...

- NandFlash和iNand

nand 1.nand的单元组织:block与page(大页Nand与小页Nand)(1)Nand的页和以前讲过的块设备(尤其是硬盘)的扇区是类似的.扇区最早在磁盘中是512字节,后来也有些高级硬盘扇 ...

- 经典]Linux内核中ioremap映射的透彻理解【转】

转自:http://blog.csdn.net/lanyang123456/article/details/7403514 几乎每一种外设都是通过读写设备上的寄存器来进行的,通常包括控制寄存器.状态寄 ...

- MISC混杂设备 struct miscdevice /misc_register()/misc_deregister()【转】

本文转自:http://blog.csdn.net/angle_birds/article/details/8330407 在Linux系统中,存在一类字符设备,他们共享一个主设备号(10),但此设备 ...