scrapy 中crawlspider 爬虫

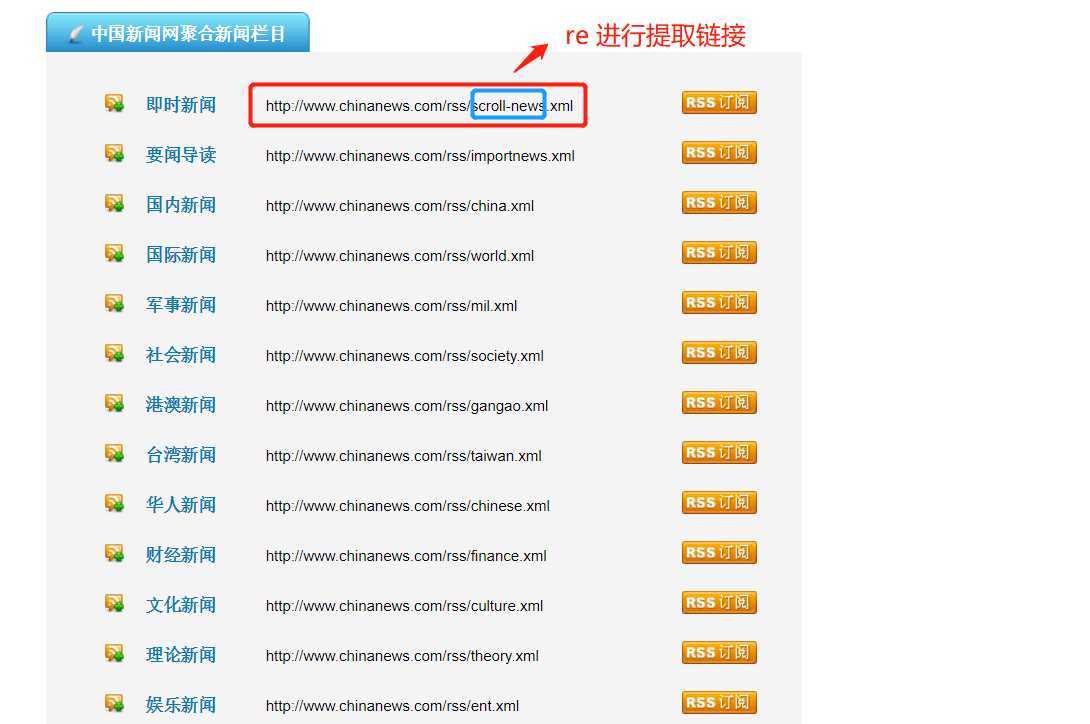

爬取目标网站:

http://www.chinanews.com/rss/rss_2.html

获取url后进入另一个页面进行数据提取

检查网页:

爬虫该页数据的逻辑:

Crawlspider爬虫类:

# -*- coding: utf-8 -*-

import scrapy

import re

#from scrapy import Selector

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule class NwSpider(CrawlSpider):

name = 'nw'

# allowed_domains = ['www.new.com']

start_urls = ['http://www.chinanews.com/rss/rss_2.html'] rules = (

Rule(LinkExtractor(allow='http://www.chinanews.com/rss/.*?\.xml'), callback='parse_item'),

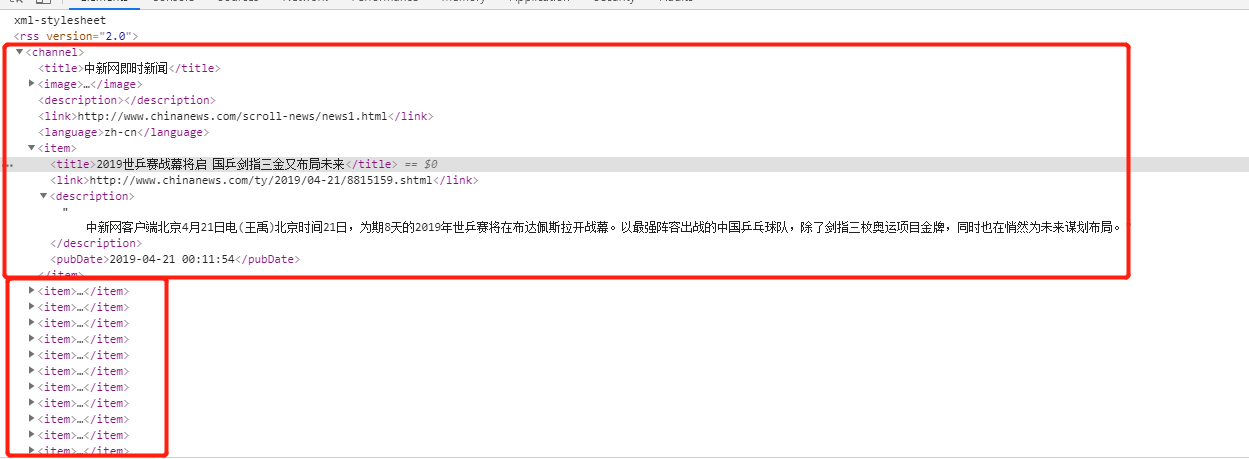

) def parse_item(self, response):

selector = Selector(response)

items =response.xpath('//item').extract()

for node in items:

# print(type(node))

#

item = {}

item['title'] = re.findall(r'<title>(.*?)</title>',node,re.S)[0]

item['link'] = re.findall(r'<link>(.*?)</link>',node,re.S)[0]

item['desc'] = re.findall(r'<description>(.*?)</description>',node,re.S)[0]

item['pub_date'] =re.findall(r'<pubDate>(.*?)</pubDate>',node,re.S)[0]

print(item)

#item['domain_id'] = response.xpath('//input[@id="sid"]/@value').get() #item['name'] = response.xpath('//div[@id="name"]').get()

#item['description'] = response.xpath('//div[@id="description"]').get()

# yield item

scrapy 中crawlspider 爬虫的更多相关文章

- python框架Scrapy中crawlSpider的使用——爬取内容写进MySQL

一.先在MySQL中创建test数据库,和相应的site数据表 二.创建Scrapy工程 #scrapy startproject 工程名 scrapy startproject demo4 三.进入 ...

- python框架Scrapy中crawlSpider的使用

一.创建Scrapy工程 #scrapy startproject 工程名 scrapy startproject demo3 二.进入工程目录,根据爬虫模板生成爬虫文件 #scrapy genspi ...

- scrapy中运行爬虫时出现twisted critical unhandled error错误

1. 试试这条命令: twisted critical unhandled error on scrapy tutorial python python27\scripts\pywin32_posti ...

- 爬虫07 /scrapy图片爬取、中间件、selenium在scrapy中的应用、CrawlSpider、分布式、增量式

爬虫07 /scrapy图片爬取.中间件.selenium在scrapy中的应用.CrawlSpider.分布式.增量式 目录 爬虫07 /scrapy图片爬取.中间件.selenium在scrapy ...

- scrapy进阶(CrawlSpider爬虫__爬取整站小说)

# -*- coding: utf-8 -*- import scrapy,re from scrapy.linkextractors import LinkExtractor from scrapy ...

- Scrapy - CrawlSpider爬虫

crawlSpider 爬虫 思路: 从response中提取满足某个条件的url地址,发送给引擎,同时能够指定callback函数. 1. 创建项目 scrapy startproject mysp ...

- python爬虫之Scrapy框架(CrawlSpider)

提问:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬去进行实现的(Request模块回调) 方法二:基于CrawlSpi ...

- 第三百五十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—将selenium操作谷歌浏览器集成到scrapy中

第三百五十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—将selenium操作谷歌浏览器集成到scrapy中 1.爬虫文件 dispatcher.connect()信号分发器,第一个参数信 ...

- 爬虫开发12.selenium在scrapy中的应用

selenium在scrapy中的应用阅读量: 370 1 引入 在通过scrapy框架进行某些网站数据爬取的时候,往往会碰到页面动态数据加载的情况发生,如果直接使用scrapy对其url发请求,是绝 ...

随机推荐

- vue评论显示隐藏,JavaScript显示关闭

<template> <div id="vue_det"> <h1>{{details()}}</h1> <div>{{ ...

- C# 链表反转

链表反转分这么两种情况, 一种是链表头节点始终前置,那这时候需要传一个头节点特有的标记:(简称:头不转) HEAD->Test1->Test2->Test3->Test4 反转 ...

- jpa报错:Table 'dev-test.hibernate_sequence' doesn't exist

Hibernate 能够出色地自动生成主键.Hibernate/EBJ 3 注释也可以为主键的自动生成提供丰富的支持,允许实现各种策略.其生成规则由@GeneratedValue设定的.这里的@id和 ...

- 【论文速读】Shangbang Long_ECCV2018_TextSnake_A Flexible Representation for Detecting Text of Arbitrary Shapes

Shangbang Long_ECCV2018_TextSnake_A Flexible Representation for Detecting Text of Arbitrary Shapes 作 ...

- SDK?JDK?JDK 下载、安装、配置图文教程

什么是软件开发工具包(SDK) 开发一个软件,需要经过编辑.编译.调试.运行几个过程. 编辑:使用编程语言编写程序代码的过程. 编译:如上一节所讲,就是将编写的程序进行翻译. 调试:程序不可能一次 ...

- 什么是DevOps

历史回顾 为了能够更好的理解什么是DevOps,我们很有必要对当时还只有程序员(此前还没有派生出开发者,前台工程师,后台工程师之类)这个称号存在的历史进行一下回顾. 如编程之道中所言: 老一辈的程序员 ...

- vue路由详解

自己看vue文档,难免有些地方不懂,自己整理一下,主要是vue-router具体实现的操作步骤. 安装 直接下载/CDN https://unpkg.com/vue-router/dist/vue-r ...

- PL/SQL变量的作用域和可见性

变量的作用域和可见性设计变量在块中的位置,不同的位置使得变量具有不同的有效性与可访问性. 变量的作用域是指可以使用变量的程序单元部分,可以是包和子程序包等. 当一个变量在它的作用域中可以用一个不限定的 ...

- UI自动化(十三)appium操作

定位: # id resource-id可能出现重复 如果appium-desktop提示了id 定位方式 说明id唯一driver.find_element_by_id('com.tencent.m ...

- 用PIL库进行图像处理

一.如果系统里没有安装PIL库的,请先到命令提示符输入“pip install pillow”进行安装 二.之后就可以参考以下的代码 from PIL import Image from pylab ...