【python实现卷积神经网络】批量归一化层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch

卷积神经网络中卷积层Conv2D(带stride、padding)的具体实现:https://www.cnblogs.com/xiximayou/p/12706576.html

激活函数的实现(sigmoid、softmax、tanh、relu、leakyrelu、elu、selu、softplus):https://www.cnblogs.com/xiximayou/p/12713081.html

损失函数定义(均方误差、交叉熵损失):https://www.cnblogs.com/xiximayou/p/12713198.html

优化器的实现(SGD、Nesterov、Adagrad、Adadelta、RMSprop、Adam):https://www.cnblogs.com/xiximayou/p/12713594.html

卷积层反向传播过程:https://www.cnblogs.com/xiximayou/p/12713930.html

全连接层实现:https://www.cnblogs.com/xiximayou/p/12720017.html

class BatchNormalization(Layer):

"""Batch normalization.

"""

def __init__(self, momentum=0.99):

self.momentum = momentum

self.trainable = True

self.eps = 0.01

self.running_mean = None

self.running_var = None def initialize(self, optimizer):

# Initialize the parameters

self.gamma = np.ones(self.input_shape)

self.beta = np.zeros(self.input_shape)

# parameter optimizers

self.gamma_opt = copy.copy(optimizer)

self.beta_opt = copy.copy(optimizer) def parameters(self):

return np.prod(self.gamma.shape) + np.prod(self.beta.shape) def forward_pass(self, X, training=True): # Initialize running mean and variance if first run

if self.running_mean is None:

self.running_mean = np.mean(X, axis=0)

self.running_var = np.var(X, axis=0) if training and self.trainable:

mean = np.mean(X, axis=0)

var = np.var(X, axis=0)

self.running_mean = self.momentum * self.running_mean + (1 - self.momentum) * mean

self.running_var = self.momentum * self.running_var + (1 - self.momentum) * var

else:

mean = self.running_mean

var = self.running_var # Statistics saved for backward pass

self.X_centered = X - mean

self.stddev_inv = 1 / np.sqrt(var + self.eps) X_norm = self.X_centered * self.stddev_inv

output = self.gamma * X_norm + self.beta return output def backward_pass(self, accum_grad): # Save parameters used during the forward pass

gamma = self.gamma # If the layer is trainable the parameters are updated

if self.trainable:

X_norm = self.X_centered * self.stddev_inv

grad_gamma = np.sum(accum_grad * X_norm, axis=0)

grad_beta = np.sum(accum_grad, axis=0) self.gamma = self.gamma_opt.update(self.gamma, grad_gamma)

self.beta = self.beta_opt.update(self.beta, grad_beta) batch_size = accum_grad.shape[0] # The gradient of the loss with respect to the layer inputs (use weights and statistics from forward pass)

accum_grad = (1 / batch_size) * gamma * self.stddev_inv * (

batch_size * accum_grad

- np.sum(accum_grad, axis=0)

- self.X_centered * self.stddev_inv**2 * np.sum(accum_grad * self.X_centered, axis=0)

) return accum_grad def output_shape(self):

return self.input_shape

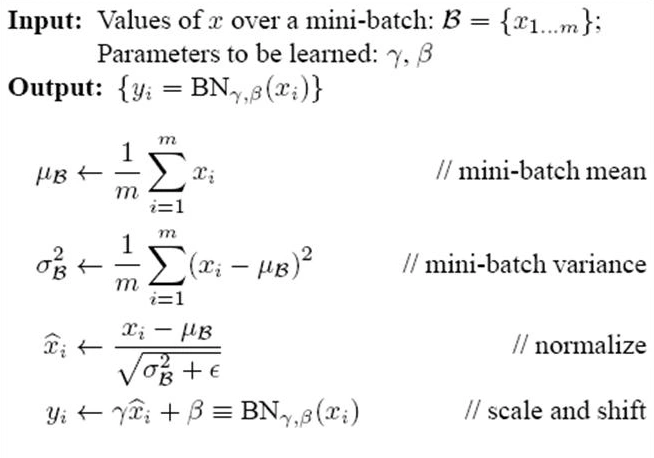

批量归一化的过程:

前向传播的时候按照公式进行就可以了。需要关注的是BN层反向传播的过程。

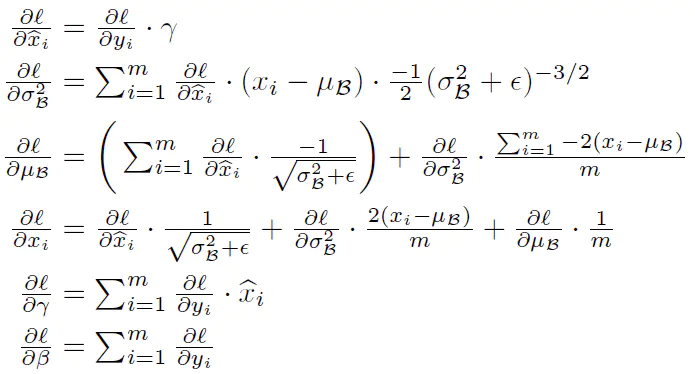

accm_grad是上一层传到本层的梯度。反向传播过程:

【python实现卷积神经网络】批量归一化层实现的更多相关文章

- 【python实现卷积神经网络】padding2D层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】Flatten层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】Dropout层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】激活层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】池化层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】上采样层upSampling2D实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】卷积层Conv2D实现(带stride、padding)

关于卷积操作是如何进行的就不必多说了,结合代码一步一步来看卷积层是怎么实现的. 代码来源:https://github.com/eriklindernoren/ML-From-Scratch 先看一下 ...

- 【python实现卷积神经网络】开始训练

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 【python实现卷积神经网络】定义训练和测试过程

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- 基于Python的卷积神经网络和特征提取

基于Python的卷积神经网络和特征提取 用户1737318发表于人工智能头条订阅 224 在这篇文章中: Lasagne 和 nolearn 加载MNIST数据集 ConvNet体系结构与训练 预测 ...

随机推荐

- Python3学习之路~10.1 多进程、进程间通信、进程池

一 多进程multiprocessing multiprocessing is a package that supports spawning processes using an API simi ...

- Go语言之Go语言变量

GO 语言变量 Go语言是静态类型语言,因此变量(variable)是有明确类型的,编译器也会检查变量类型的正确性. 标识符 在编程语言中标识符就是程序员定义的具有特殊意义的词,比如变量名.常量名.函 ...

- 【洛谷】P2444 [POI2000]病毒——AC自动机

题目链接 题目描述 二进制病毒审查委员会最近发现了如下的规律:某些确定的二进制串是病毒的代码.如果某段代码中不存在任何一段病毒代码,那么我们就称这段代码是安全的.现在委员会已经找出了所有的病毒代码段, ...

- Java集合工具类使用的一些坑,Arrays.asList()、Collection.toArray()、foreach

Arrays.asList() 使用指南 最近使用Arrays.asList()遇到了一些坑,然后在网上看到这篇文章:Java Array to List Examples 感觉挺不错的,但是还不是特 ...

- Building Applications with Force.com and VisualForce(Dev401)(十一):Designing Applications for Multiple Users: Proseving Data Quality

Dev401-012:Proseving Data Quality Universal Containers Scenario1.Universal Containers(UC) wants to e ...

- spring源码阅读笔记06:bean加载之准备创建bean

上文中我们学习了bean加载的整个过程,我们知道从spring容器中获取单例bean时会先从缓存尝试获取,如果缓存中不存在已经加载的单例bean就需要从头开始bean的创建,而bean的创建过程是非常 ...

- WeChat-SmallProgram:如何定义一个组件

创建组件所需的文件: 1.在根目录创建 Componet 文件夹 2.再创建一个select文件夹 3.然后:右键这个文件夹,新建下面的这个 Component.然后输入需要创建的名称,我这里为了方便 ...

- [noip2016]组合数问题<dp+杨辉三角>

题目链接:https://vijos.org/p/2006 当时在考场上只想到了暴力的做法,现在自己看了以后还是没思路,最后看大佬说的杨辉三角才懂这题... 我自己总结了一下,我不能反应出杨辉三角的递 ...

- Pytest系列(1) - 快速入门和基础讲解

如果你还想从头学起Pytest,可以看看这个系列的文章哦! https://www.cnblogs.com/poloyy/category/1690628.html 前言 目前有两种纯测试的测试框架, ...

- Spring Boot 完整讲解

SpringBoot学习笔记 文章写得比较详细,所以很长(105336 字数),可以参考目录 文章目录 SpringBoot学习笔记 @[toc] 一. Spring Boot 入门 预:必须掌握的技 ...