keyvalue对RDD s

scala> val input =sc.textFile("/home/simon/SparkWorkspace/test.txt")

input: org.apache.spark.rdd.RDD[String] = /home/simon/SparkWorkspace/test.txt MapPartitionsRDD[32] at textFile at <console>:24

scala> input.foreach(println)

hello simon!

hello world!

hello gg

scala> val rdds=input.map(line=>(line.split(" ")(0),line))

rdds: org.apache.spark.rdd.RDD[(String, String)] = MapPartitionsRDD[33] at map at <console>:25

scala> rdds.foreach(println)

(hello,hello simon!)

(hello,hello world!)

(hello,hello gg)

scala>

scala> val rdd=sc.parallelize(Array((1,2),(2,3),(3,4),(3,5),(4,6),(2,4)))

rdd: org.apache.spark.rdd.RDD[(Int, Int)] = ParallelCollectionRDD[34] at parallelize at <console>:24

scala> rdd.foreach(println)

(3,5)

(2,3)

(3,4)

(1,2)

(4,6)

(2,4)

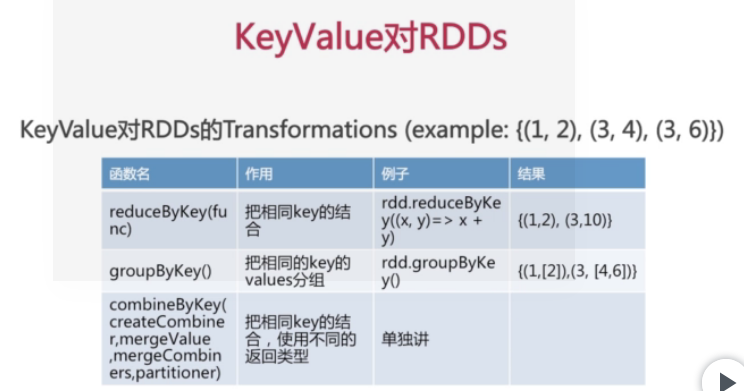

scala> val rdd1=rdd.reduceByKey((x,y)=>x+y)

rdd1: org.apache.spark.rdd.RDD[(Int, Int)] = ShuffledRDD[35] at reduceByKey at <console>:25

scala> rdd1.foreach(println)

(1,2)

(4,6)

(2,7)

(3,9)

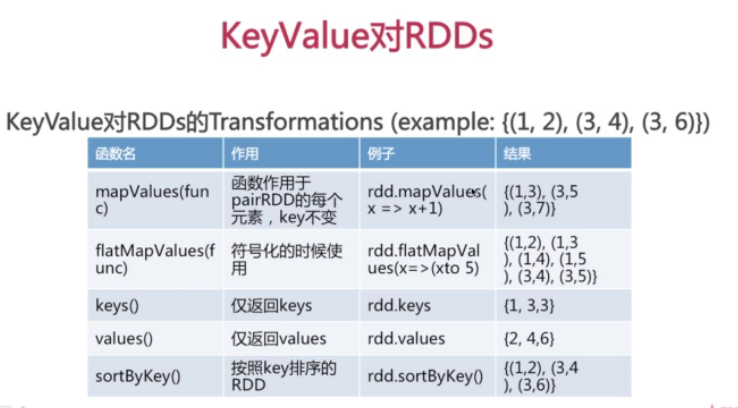

scala> val rdd2=rdd.keys

rdd2: org.apache.spark.rdd.RDD[Int] = MapPartitionsRDD[36] at keys at <console>:25

scala> rdd2.foreach(println)

1

4

2

3

2

3

scala> val rdd3=rdd.values

rdd3: org.apache.spark.rdd.RDD[Int] = MapPartitionsRDD[37] at values at <console>:25

scala> rdd3.foreach(println)

2

6

4

5

3

4

scala> val rdd4=rdd.groupByKey()

rdd4: org.apache.spark.rdd.RDD[(Int, Iterable[Int])] = ShuffledRDD[38] at groupByKey at <console>:25

scala> rdd4.foreach(println)

(3,CompactBuffer(4, 5))

(4,CompactBuffer(6))

(1,CompactBuffer(2))

(2,CompactBuffer(3, 4))

scala> val rdd5=rdd.sortByKey()

rdd5: org.apache.spark.rdd.RDD[(Int, Int)] = ShuffledRDD[41] at sortByKey at <console>:25

scala> rdd5.foreach(println)

(3,4)

(3,5)

(4,6)

(1,2)

(2,3)

(2,4)

scala> val rdd6=rdd4.sortByKey()

rdd6: org.apache.spark.rdd.RDD[(Int, Iterable[Int])] = ShuffledRDD[44] at sortByKey at <console>:25

scala> rdd6.foreach(println)

(1,CompactBuffer(2))

(4,CompactBuffer(6))

(3,CompactBuffer(4, 5))

(2,CompactBuffer(3, 4))

scala>

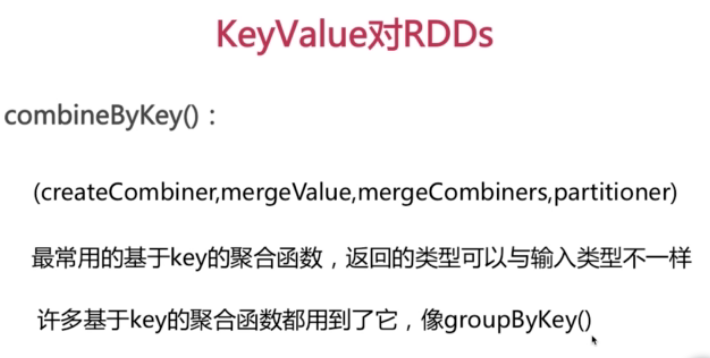

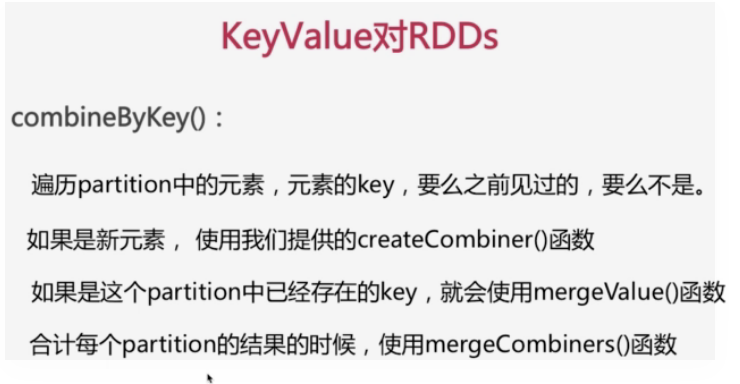

val scores=sc.parallelize(Array(("jack",89),("jack",90),("jack",99),("Tom",89),("Tom",95),("Tom",99)))

scores.foreach(println)

val scores2=scores.combineByKey(score=>(1,score),(c1:(Int,Double),newScore)=>(c1._1+1,c1._2+newScore),(c1:(Int,Double),c2:(Int,Double)=>(c1._1+c2._1,c1._2+c2._2))

scores2.foreach(println)

val average =scores2.map{case(name,(num,score))=>(name,score/num)}

average.foreach(println)

keyvalue对RDD s的更多相关文章

- RDD之五:Key-Value型Transformation算子

Transformation处理的数据为Key-Value形式的算子大致可以分为:输入分区与输出分区一对一.聚集.连接操作. 输入分区与输出分区一对一 mapValues mapValues:针对(K ...

- Spark RDD 核心总结

摘要: 1.RDD的五大属性 1.1 partitions(分区) 1.2 partitioner(分区方法) 1.3 dependencies(依赖关系) 1.4 compute(获取分区迭代列表) ...

- Spark核心概念之RDD

RDD: Resilient Distributed Dataset RDD的特点: 1.A list of partitions 一系列的分片:比如说64M一片:类似于Hadoop中的s ...

- Spark RDD概念学习系列之RDD的5大特点(五)

RDD的5大特点 1)有一个分片列表,就是能被切分,和Hadoop一样,能够切分的数据才能并行计算. 一组分片(partition),即数据集的基本组成单位,对于RDD来说,每个分片都会被一个计 ...

- Spark RDD/Core 编程 API入门系列 之rdd案例(map、filter、flatMap、groupByKey、reduceByKey、join、cogroupy等)(四)

声明: 大数据中,最重要的算子操作是:join !!! 典型的transformation和action val nums = sc.parallelize(1 to 10) //根据集合创建RDD ...

- Spark计算模型-RDD介绍

在Spark集群背后,有一个非常重要的分布式数据架构,即弹性分布式数据集(Resilient Distributed DataSet,RDD),它是逻辑集中的实体,在集群中的多台集群上进行数据分区.通 ...

- Spark里边:到底是什么RDD

RDD它是Spark基,它是最根本的数据抽象.http://www.cs.berkeley.edu/~matei/papers/2012/nsdi_spark.pdf 它开着RDD文件.假设英语阅读太 ...

- Spark核心类:弹性分布式数据集RDD及其转换和操作pyspark.RDD

http://blog.csdn.net/pipisorry/article/details/53257188 弹性分布式数据集RDD(Resilient Distributed Dataset) 术 ...

- Spark技术内幕:究竟什么是RDD

RDD是Spark最基本,也是最根本的数据抽象.http://www.cs.berkeley.edu/~matei/papers/2012/nsdi_spark.pdf 是关于RDD的论文.如果觉得英 ...

随机推荐

- 创建线程时如果既传入了runnable对象,又继承thread重写了run方法,会执行的哪里的代码

1 使用线程的方式,继承thread类,重写run方法 new Thread() { @Override public void run() { System.out.println("我是 ...

- 【转】宽带路由器应用(三)—ARP欺骗防护功能的使用

在局域网中,通信前必须通过ARP协议来完成IP地址转换为第二层物理地址(即MAC地址).ARP协议对网络安全具有重要的意义.通过伪造IP地址和MAC地址实现ARP欺骗,对网络的正常传输和安全都是一个很 ...

- 【vue】vue +element 实现批量删除

相关资料:http://blog.csdn.net/eagle_88/article/details/70238836 作者:smile.轉角 QQ:493177502

- 【转载】理解本真的REST架构风格

本文将带您领略REST架构的起源.与Web的关系.REST架构的本质及特性,以及REST架构与其他架构风格之间的比较. 引子 在移动互联网.云计算迅猛发展的今天,作为一名Web开发者,如果您还没听说过 ...

- face recognition[翻译][深度学习理解人脸]

本文译自<Deep learning for understanding faces: Machines may be just as good, or better, than humans& ...

- 错误 103 未能加载文件或程序集“Telerik.Web.UI”或它的某一个依赖项。磁盘空间不足。 (异常来自 HRESULT:0x80070070)

运行vs2010时出现错误: 错误 103 未能加载文件或程序集“Telerik.Web.UI”或它的某一个依赖项.磁盘空间不足. (异常来自 HRESULT:0x80070070) 处理方式:清理C ...

- C# System.Guid.NewGuid() 格式化

概念 GUID: 即Globally Unique Identifier(全球唯一标识符) 也称作 UUID(Universally Unique IDentifier) . GUID是一个通过特定算 ...

- jenkins+svn安装

参考资料: http://blog.csdn.net/wuxuehong0306/article/details/50016547 https://www.ibm.com/developerworks ...

- springboot 集成 jpa/hibernate

pom.xml <dependency> <groupId>org.springframework.boot</groupId> <artifactId> ...

- 深入理解消息中间件技术之RabbitMQ服务

什么叫消息队列? 消息(Message)是指在应用间传送的数据.消息可以非常简单,比如只包含文本字符串,也可以更复杂,可能包含嵌入对象. 消息队列(Message Queue)是一种应用间的通信方式, ...