莫烦PyTorch学习笔记(三)——激励函数

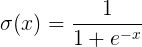

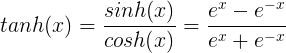

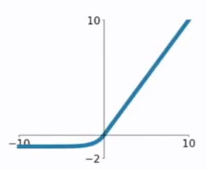

tanh是双曲正切函数,tanh函数和sigmod函数的曲线是比较相近的,咱们来比较一下看看。首先相同的是,这两个函数在输入很大或是很小的时候,输出都几乎平滑,梯度很小,不利于权重更新;不同的是输出区间,tanh的输出区间是在(-1,1)之间,而且整个函数是以0为中心的,这个特点比sigmod的好。

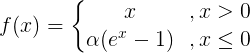

ELU函数是针对ReLU函数的一个改进型,相比于ReLU函数,在输入为负数的情况下,是有一定的输出的,而且这部分输出还具有一定的抗干扰能力。这样可以消除ReLU死掉的问题,不过还是有梯度饱和和指数运算的问题。

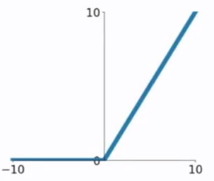

PReLU也是针对ReLU的一个改进型,在负数区域内,PReLU有一个很小的斜率,这样也可以避免ReLU死掉的问题。相比于ELU,PReLU在负数区域内是线性运算,斜率虽然小,但是不会趋于0,这算是一定的优势吧。

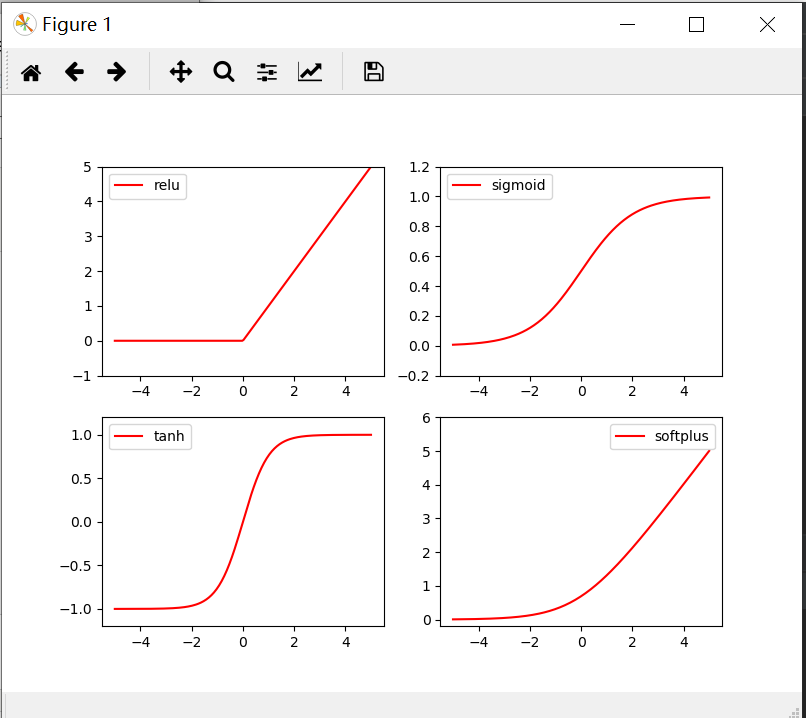

import torch

from torch.autograd import Variable

import matplotlib.pyplot as plt

import torch.nn.functional as F

x= torch.linspace(-,,)

x= Variable(x)

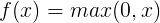

x_np=x.data.numpy() y_relu = torch.relu(x).data.numpy()

y_sigmoid =torch.sigmoid(x).data.numpy()

y_tanh = torch.tanh(x).data.numpy()

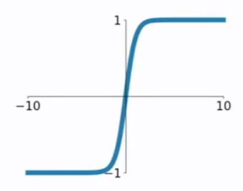

y_softplus = F.softplus(x).data.numpy() plt.figure(,figsize=(,))

plt.subplot()

plt.plot(x_np,y_relu,c='red',label='relu')

plt.ylim(-,)

plt.legend(loc='best') plt.subplot()

plt.plot(x_np,y_sigmoid,c='red',label='sigmoid')

plt.ylim(-0.2,1.2)

plt.legend(loc='best') plt.subplot()

plt.plot(x_np,y_tanh,c='red',label='tanh')

plt.ylim(-1.2,1.2)

plt.legend(loc='best') plt.subplot()

plt.plot(x_np,y_softplus,c='red',label='softplus')

plt.ylim(-0.2,)

plt.legend(loc='best')

plt.show()

莫烦PyTorch学习笔记(三)——激励函数的更多相关文章

- 莫烦pytorch学习笔记(八)——卷积神经网络(手写数字识别实现)

莫烦视频网址 这个代码实现了预测和可视化 import os # third-party library import torch import torch.nn as nn import torch ...

- 莫烦pytorch学习笔记(七)——Optimizer优化器

各种优化器的比较 莫烦的对各种优化通俗理解的视频 import torch import torch.utils.data as Data import torch.nn.functional as ...

- 莫烦PyTorch学习笔记(五)——模型的存取

import torch from torch.autograd import Variable import matplotlib.pyplot as plt torch.manual_seed() ...

- 莫烦PyTorch学习笔记(六)——批处理

1.要点 Torch 中提供了一种帮你整理你的数据结构的好东西, 叫做 DataLoader, 我们能用它来包装自己的数据, 进行批训练. 而且批训练可以有很多种途径. 2.DataLoader Da ...

- 莫烦pytorch学习笔记(二)——variable

.简介 torch.autograd.Variable是Autograd的核心类,它封装了Tensor,并整合了反向传播的相关实现 Variable和tensor的区别和联系 Variable是篮子, ...

- 莫烦 - Pytorch学习笔记 [ 二 ] CNN ( 1 )

CNN原理和结构 观点提出 关于照片的三种观点引出了CNN的作用. 局部性:某一特征只出现在一张image的局部位置中. 相同性: 同一特征重复出现.例如鸟的羽毛. 不变性:subsampling下图 ...

- 莫烦 - Pytorch学习笔记 [ 一 ]

1. Numpy VS Torch #相互转换 np_data = torch_data.numpy() torch_data = torch.from_numpy(np_data) #abs dat ...

- 莫烦PyTorch学习笔记(五)——分类

import torch from torch.autograd import Variable import torch.nn.functional as F import matplotlib.p ...

- 莫烦PyTorch学习笔记(四)——回归

下面的代码说明个整个神经网络模拟回归的过程,代码含有详细注释,直接贴下来了 import torch from torch.autograd import Variable import torch. ...

随机推荐

- 编译Solr4.72 源码没有成功

最近需要用到solr,查询Hbase里面的数据,编译Solr的时候遇到了点问题: 下了solr的源码后需要用ant自己编译: 源码下载地址:https://svn.apache.org/repos/a ...

- 好消息:Dubbo & Spring Boot要来了

Duboo和Spring Boot都是非常优秀的框架,现在它们要结合了.为了简化Dubbo开发集成,阿里Dubbo团队将发布基于Spring Boot的版本,可快速上手Dubbo的分布式开发,并提供了 ...

- 2019 HDU 多校赛第二场 HDU 6598 Harmonious Army 构造最小割模型

题意: 有n个士兵,你可以选择让它成为战士还是法师. 有m对关系,u和v 如果同时为战士那么你可以获得a的权值 如果同时为法师,你可以获得c的权值, 如果一个为战士一个是法师,你可以获得b的权值 问你 ...

- 科普帖:深度学习中GPU和显存分析

知乎的一篇文章: https://zhuanlan.zhihu.com/p/31558973 关于如何使用nvidia-smi查看显存与GPU使用情况,参考如下链接: https://blog.csd ...

- Linux下mysql实现远程连接

首先明白一点并不是mysql禁止远程连接,而是MYSQL的账号禁止远程连接.可能觉得我有点咬文嚼字了,不过我感觉分清这点还是很重要的.默认情况下,所有账号都是禁止远程连接的.在安装MYSQL的时候,在 ...

- Vue——组件上使用v-model

一.最近在工作过程中要实现一个搜索模糊匹配功能,考虑到组件的复用,就单独把搜索框抽出来作为一个子组件.在以往的开发中,我一般会在input框中的值变化时向父组件emit一个事件,并带上一些父组件中需要 ...

- maven javaProject打包发布成服务

1,现在pom.xml中添加打包所需要的jar包. <plugins> <plugin> <groupId>org.apache.maven.plugins< ...

- 在线文库解决方案Jacob+SwfTools+FlexPaper

课程作业,准备做一个类似于豆丁之类的在线文库,解决方案也就是将文档(doc ppt xls)等转换成pdf,然后转成swf展示在页面中,今天下午经过研究,参考其他人的博客,实现了这个主要功能,这里也做 ...

- extern const 不能一起用

转载至:https://www.cnblogs.com/herenzhiming/articles/5442893.html 常变量在定义的时候必须初始化,所以当你在a.cpp中定义extern co ...

- linux 服务器安装php5.6

查看原有的php版本:php -v 如果已经装了低版本的php,为了避免冲突,查看: yum list installed | grep php 删除:自行百度吧.可能不能一次性全部删除,只能一个一个 ...