python爬虫——爬取小说 | 探索白子画和花千骨的爱恨情仇(转载)

转载出处:药少敏 ,感谢原作者清晰的讲解思路!

下述代码是我通过自己互联网搜索和拜读完此篇文章之后写出的具有同样效果的爬虫代码:

from bs4 import BeautifulSoup

import requests if __name__ == '__main__':

html = requests.get('http://www.136book.com/huaqiangu/')

soup = BeautifulSoup(html.content, 'lxml')

#获取所有div

soup_texts = soup.find_all('div', id = 'book_detail', class_= 'box1') f=open('F:/huaqiangu.txt', 'w') #第二个div有用

for x in soup_texts[1].find_all('a'):

#控制台输出网址,章节标题

print(x.get('href'),x.get_text()) down_html = requests.get(x.get('href'))

down_soup = BeautifulSoup(down_html.content, 'lxml')

#获取正文

down_texts = down_soup.select('p') f.write('\n\n')

#写入章节标题

f.write(x.get_text() + '\n')

#写入章节内容

for s in down_texts:

f.write(s.text) f.close()

知识就像碎布,记得“缝一缝”,你才能华丽丽地亮相。

1.Beautiful Soup

1.Beautifulsoup 简介

此次实战从网上爬取小说,需要使用到Beautiful Soup。

Beautiful Soup为python的第三方库,可以帮助我们从网页抓取数据。

它主要有如下特点:

- 1.Beautiful Soup可以从一个HTML或者XML提取数据,它包含了简单的处理、遍历、搜索文档树、修改网页元素等功能。可以通过很简短地代码完成我们地爬虫程序。

- 2.Beautiful Soup几乎不用考虑编码问题。一般情况下,它可以将输入文档转换为unicode编码,并且以utf-8编码方式输出,

2.Beautiful Soup安装

win命令行下:

pip install beautifusoup4

3.Beautiful Soup基础

大家可以参考文档来学习(中文版的哦):

http://beautifulsoup.readthedocs.io/zh_CN/latest/#id8

对于本次爬虫任务,只要了解以下几点基础内容就可以完成:

1.Beautiful Soup的对象种类:

- Tag

- Navigablestring

- BeautifulSoup

- Comment

2.遍历文档树:find、find_all、find_next和children

3.一点点HTML和CSS知识(没有也将就,现学就可以)

2.爬取小说花千骨

1.爬虫思路分析

本次爬取小说的网站为136书屋。

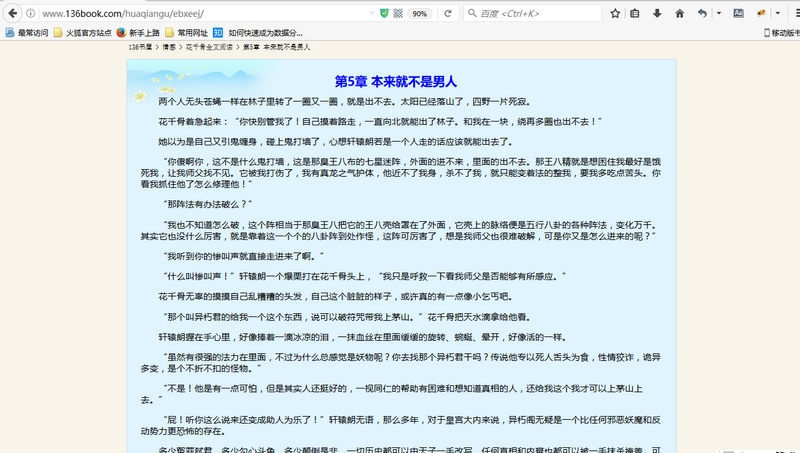

先打开花千骨小说的目录页,是这样的。

我们的目的是找到每个目录对应的url,并且爬取其中地正文内容,然后放在本地文件中。

2.网页结构分析

首先,目录页左上角有几个可以提高你此次爬虫成功后成就感的字眼:暂不提供花千骨txt全集下载。

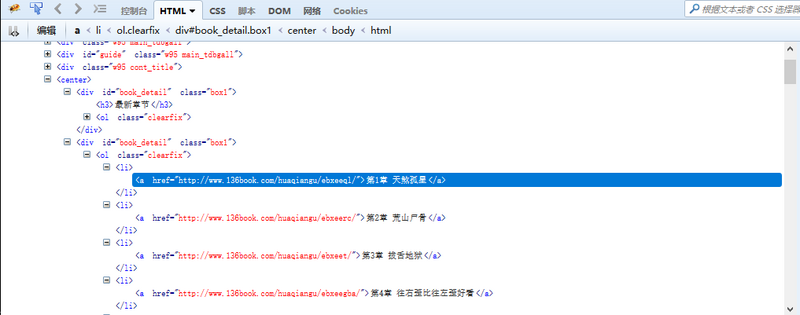

继续往下看,发现是最新章节板块,然后便是全书的所有目录。我们分析的对象便是全书所有目录。点开其中一个目录,我们便可以都看到正文内容。

按F12打开审查元素菜单。可以看到网页前端的内容都包含在这里。

我们的目的是要找到所有目录的对应链接地址,爬取每个地址中的文本内容。

有耐心的朋友可以在里面找到对应的章节目录内容。有一个简便方法是点击审查元素中左上角箭头标志的按钮,然后选中相应元素,对应的位置就会加深显示。

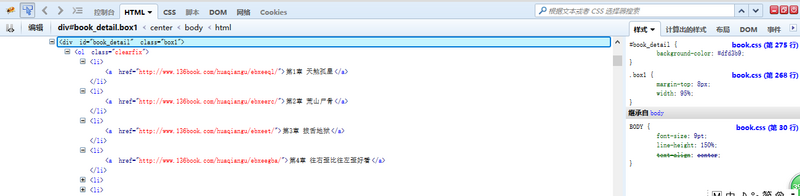

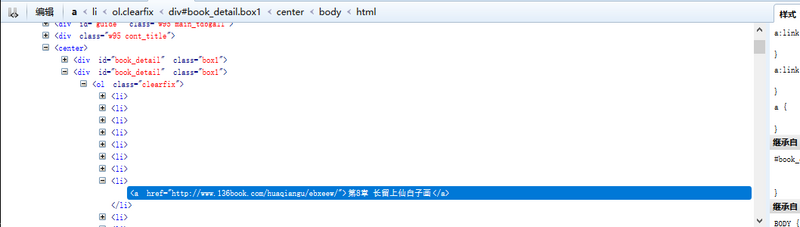

这样我们可以看到,每一章的链接地址都是有规则地存放在<li>中。而这些<li>又放在<div id=”book_detail” class=”box1″>中。

我不停地强调“我们的目的”是要告诉大家,思路很重要。爬虫不是约pao,蒙头就上不可取。

3.单章节爬虫

刚才已经分析过网页结构。我们可以直接在浏览器中打开对应章节的链接地址,然后将文本内容提取出来。

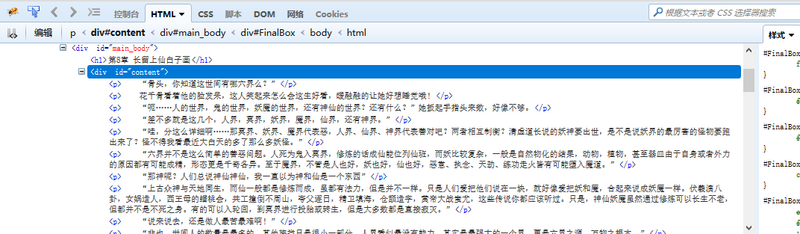

我们要爬取的内容全都包含在这个<div>里面。

代码整理如下:

from urllib import request

from bs4 import BeautifulSoup if __name__ == '__main__':

# 第8章的网址

url = 'http://www.136book.com/huaqiangu/ebxeew/'

head = {}

# 使用代理

head['User-Agent'] = 'Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19'

req = request.Request(url, headers = head)

response = request.urlopen(req)

html = response.read()

# 创建request对象

soup = BeautifulSoup(html, 'lxml')

# 找出div中的内容

soup_text = soup.find('div', id = 'content')

# 输出其中的文本

print(soup_text.text)

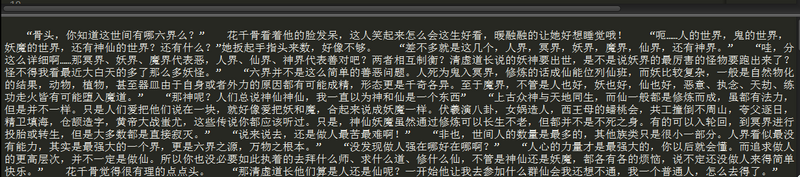

运行结果如下:

这样,单章节内容爬取就大功告成了。

4.小说全集爬虫

单章节爬虫我们可以直接打开对应的章节地址解析其中的文本,全集爬虫我们不可能让爬虫程序在每章节网页内中跑一遍,如此还不如复制、粘贴来的快。

我们的思路是先在目录页中爬取所有章节的链接地址,然后再爬取每个链接对应的网页中的文本内容。说来,就是比单章节爬虫多一次解析过程,需要用到Beautiful Soup遍历文档树的内容。

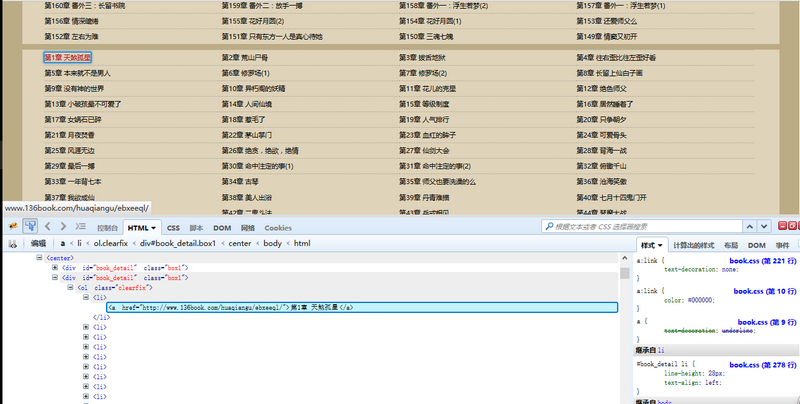

1.解析目录页

在思路分析中,我们已经了解了目录页的结构。所有的内容都放在一个所有的内容都放在一个<div id=”book_detail” class=”box1″>中。

这儿有两个一模一样的<div id=”book_detail” class=”box1″>。

第一个<div>包含着最近更新的章节,第二个<div>包含着全集内容。

请注意,我们要爬取的是第二个<div>中的内容。

代码整理如下:

from urllib import request

from bs4 import BeautifulSoup if __name__ == '__main__':

# 目录页

url = 'http://www.136book.com/huaqiangu/'

head = {}

head['User-Agent'] = 'Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19'

req = request.Request(url, headers = head)

response = request.urlopen(req)

html = response.read()

# 解析目录页

soup = BeautifulSoup(html, 'lxml')

# find_next找到第二个<div>

soup_texts = soup.find('div', id = 'book_detail', class_= 'box1').find_next('div')

# 遍历ol的子节点,打印出章节标题和对应的链接地址

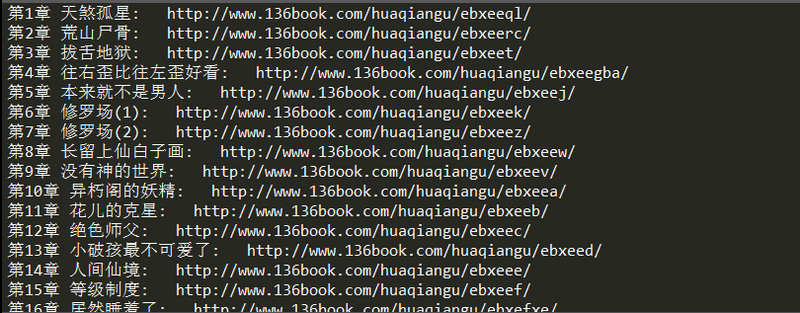

for link in soup_texts.ol.children:

if link != '\n':

print(link.text + ': ', link.a.get('href'))

执行结果如图:

2.爬取全集内容

将每个解析出来的链接循环代入到url中解析出来,并将其中的文本爬取出来,并且写到本地F:/huaqiangu.txt中。

代码整理如下:

from urllib import request

from bs4 import BeautifulSoup if __name__ == '__main__':

url = 'http://www.136book.com/huaqiangu/'

head = {}

head['User-Agent'] = 'Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19'

req = request.Request(url, headers = head)

response = request.urlopen(req)

html = response.read()

soup = BeautifulSoup(html, 'lxml')

soup_texts = soup.find('div', id = 'book_detail', class_= 'box1').find_next('div')

# 打开文件

f = open('F:/huaqiangu.txt','w')

# 循环解析链接地址

for link in soup_texts.ol.children:

if link != '\n':

download_url = link.a.get('href')

download_req = request.Request(download_url, headers = head)

download_response = request.urlopen(download_req)

download_html = download_response.read()

download_soup = BeautifulSoup(download_html, 'lxml')

download_soup_texts = download_soup.find('div', id = 'content')

# 抓取其中文本

download_soup_texts = download_soup_texts.text

# 写入章节标题

f.write(link.text + '\n\n')

# 写入章节内容

f.write(download_soup_texts)

f.write('\n\n')

f.close()

执行结果显示 [Finished in 32.3s] 。

打开F盘查看花千骨文件。

爬虫成功。备好纸巾,快快去感受尊上和小骨的虐恋吧。

5.总结

代码还有很多改进的地方。例如文本中包含广告的js代码可以去除,还可以加上爬虫进度显示等等。实现这些功能需要包含正则表达式和os模块知识,就不多说了,大家可以继续完善。

码字辛苦,码代码费神,文字和代码同码更是艰辛无比。如果您觉得文章有那么一丢丢价值,请不要吝啬您的赞赏。

python爬虫——爬取小说 | 探索白子画和花千骨的爱恨情仇(转载)的更多相关文章

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- Python爬虫|爬取喜马拉雅音频

"GOOD Python爬虫|爬取喜马拉雅音频 喜马拉雅是知名的专业的音频分享平台,用户规模突破4.8亿,汇集了有声小说,有声读物,儿童睡前故事,相声小品等数亿条音频,成为国内发展最快.规模 ...

- Python爬虫 - 爬取百度html代码前200行

Python爬虫 - 爬取百度html代码前200行 - 改进版, 增加了对字符串的.strip()处理 源代码如下: # 改进版, 增加了 .strip()方法的使用 # coding=utf-8 ...

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- 使用Python爬虫爬取网络美女图片

代码地址如下:http://www.demodashi.com/demo/13500.html 准备工作 安装python3.6 略 安装requests库(用于请求静态页面) pip install ...

- python爬虫爬取内容中,-xa0,-u3000的含义

python爬虫爬取内容中,-xa0,-u3000的含义 - CSDN博客 https://blog.csdn.net/aiwuzhi12/article/details/54866310

- python爬虫—爬取英文名以及正则表达式的介绍

python爬虫—爬取英文名以及正则表达式的介绍 爬取英文名: 一. 爬虫模块详细设计 (1)整体思路 对于本次爬取英文名数据的爬虫实现,我的思路是先将A-Z所有英文名的连接爬取出来,保存在一个cs ...

- 一个简单的python爬虫,爬取知乎

一个简单的python爬虫,爬取知乎 主要实现 爬取一个收藏夹 里 所有问题答案下的 图片 文字信息暂未收录,可自行实现,比图片更简单 具体代码里有详细注释,请自行阅读 项目源码: # -*- cod ...

- python爬虫-爬取百度图片

python爬虫-爬取百度图片(转) #!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:16# 文件 :spider ...

随机推荐

- alpha-咸鱼冲刺day7

一,合照 emmmmm.自然还是没有的. 二,项目燃尽图 三,项目进展 正在写登陆+注册ing 注册搞出来了!!!!!!!!QAQ(喜极而泣!!!!.jpg) 四,问题困难 数据流程大概是搞定了.不过 ...

- 201621123050 《Java程序设计》第11周学习总结

1. 本周学习总结 1.1 以你喜欢的方式(思维导图或其他)归纳总结多线程相关内容. 2. 书面作业 本次PTA作业题集多线程 1. 源代码阅读:多线程程序BounceThread 1.1 BallR ...

- Linux下ftp和ssh详解

学习了几天Linux下ftp和ssh的搭建和使用,故记录一下.学习ftp和ssh的主要目的是为了连接远程主机,并且进行文件传输.废话不多说,直接开讲! ftp服务器 1. 环境搭建 本人的系统是Arc ...

- 2017-2018-1 我爱学Java 第一周 作业

构建之法 成员及分工 内容简介 作者简介 分章学习及问题 第一章 概论 第二章 个人技术和流程 第三章 软件工程师的成长 第四章 两人合作 第五章 团队和流程 第六章 敏捷流程 第七章 实战中的软件工 ...

- 【iOS】swift-ObjectC 在iOS 8中使用UIAlertController

iOS 8的新特性之一就是让接口更有适应性.更灵活,因此许多视图控制器的实现方式发生了巨大的变化.全新的UIPresentationController在实现视图控制器间的过渡动画效果和自适应设备尺寸 ...

- DML数据操作语言之查询(二)

当我们查询出了N条记录之后 ,我们知道一共是几条记录,或者这些记录某一字段(列值)的最大值,最小值,平均值等,就可以使用聚合函数. 1.聚合函数 聚合函数会将null 排除在外.但是count(*)例 ...

- Docker_部署jenkins(dockerfile实现)

docker+jenkins开始合体! 我用的是ubuntu14.04的基础镜像,具体的这里不做赘述. 我在/tmp/目录下建了一个Dockerfile文件: touch Dockerfile vi ...

- JAVA_SE基础——35.static修饰成员函数

在Java中适用static关键字修饰的方法称为静态方法. 声明静态方法的语法格式如下: 权限修饰符 static 数据类型 方法名(){ 方法体 } 静态方法 可以使用类名直接调用 类名.方 ...

- New UWP Community Toolkit - RotatorTile

概述 UWP Community Toolkit 中有一个为图片或磁贴提供轮播效果的控件 - RotatorTile,本篇我们结合代码详细讲解 RotatorTile 的实现. RotatorTi ...

- ( 转 ) WebApiTestClient 的使用

注意点:需要修改api路由规则,加上action: "api/{controller}/{action}/{id}" 1.如何引入组件 首先,我们需要定义一个API项目 然后通过N ...