简单python爬虫案例(爬取慕课网全部实战课程信息)

技术选型

下载器是Requests

解析使用的是正则表达式

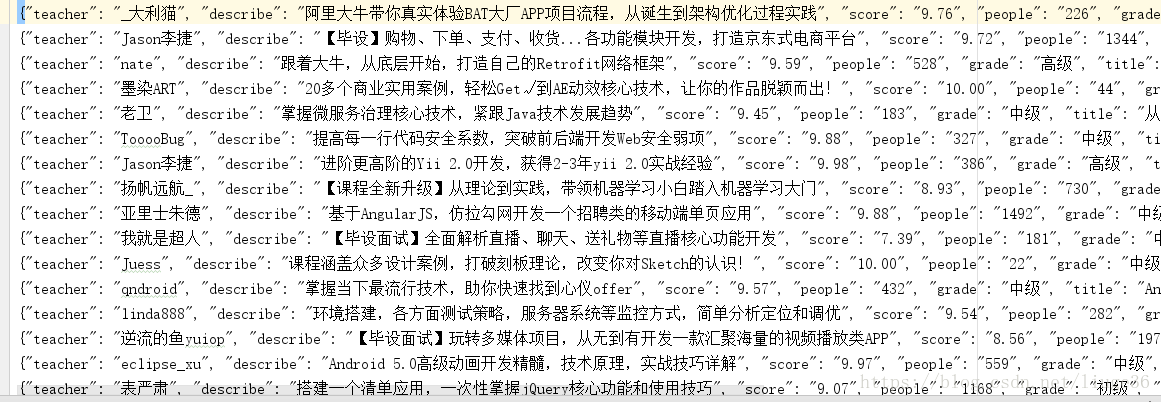

效果图:

准备好各个包

# -*- coding: utf-8 -*-

import requests #第三方下载器

import re #正则表达式

import json #格式化数据用

from requests.exceptions import RequestException #做异常处理

from multiprocessing import Pool #使用多进程

开始编写代码,new一个py文件

1.requests下载页面

response =requests.get(url)

url:当前需要爬取的链接

requests.get()获取页面

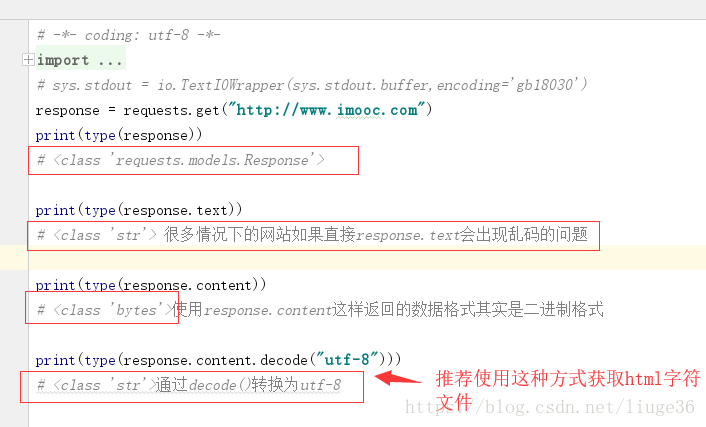

这里需要注意编码的问题;

就像下面这样:

response = requests.get(url)

if response.status_code == 200:

return response.content.decode("utf-8")

return None

这样返回的就是一个string类型的数据

2.except RequestException:捕捉异常

为了代码更加健壮,我们在可能发生异常的地方做异常捕获

try:

response = requests.get(url)

if response.status_code == 200:

return response.content.decode("utf-8")

return None

except RequestException:

return None

更多异常介绍官网

http://www.python-requests.org/en/master/_modules/requests/exceptions/#RequestException

到这里,我们就可以编写main方法进行调用程序了

代码如下:

# -*- coding: utf-8 -*-

import requests

from requests.exceptions import RequestException

def get_one_page(url):

try:

response = requests.get(url)

if response.status_code == 200:

return response.content.decode("utf-8")

return None

except RequestException:

return None

def main():

url = 'https://coding.imooc.com/?page=1'

html = get_one_page(url)

print(html)

if __name__ == '__main__':

main()

这样就可以把页面下载下来了

接着,就是解析页面

3.正则表达式介绍

re.compile()方法:编译正则表达式

通过一个正则表达式字符串 编译生成 一个字符串对象

re.findall(pattern,html)方法:找到所有匹配的内容

参数:

pattern:编译过的正则表达式

html:用response.content.decode("utf-8")得到的页面内容

def parse_one_page(html):

pattern = re.compile('<div class="box">.*?lecturer-info.*?<span>(.*?)</span>.*?shizhan-intro-box.*?title=".*?">'

'(.*?)</p>.*?class="grade">(.*?)</span>.*?imv2-set-sns.*?</i>'

'(.*?)</span>.*?class="big-text">(.*?)</p>.*?shizan-desc.*?>'

'(.*?)</p>.*?</div>',re.S)

items = re.findall(pattern,html)

for item in items:

#格式化每一条数据为字典类型的数据

yield {

'teacher': item[0],

'title': item[1],

'grade': item[2],

'people':item[3],

'score': item[4],

'describe': item[5]

}

完整代码:

# -*- coding: utf-8 -*-

import requests

import re

from requests.exceptions import RequestException

def get_one_page(url):

try:

response = requests.get(url)

if response.status_code == 200:

return response.content.decode("utf-8")

return None

except RequestException:

return None

def parse_one_page(html):

pattern = re.compile('<div class="box">.*?lecturer-info.*?<span>(.*?)</span>.*?shizhan-intro-box.*?title=".*?">'

'(.*?)</p>.*?class="grade">(.*?)</span>.*?imv2-set-sns.*?</i>'

'(.*?)</span>.*?class="big-text">(.*?)</p>.*?shizan-desc.*?>'

'(.*?)</p>.*?</div>',re.S)

items = re.findall(pattern,html)

for item in items:

yield {

'teacher': item[0],

'title': item[1],

'grade': item[2],

'people':item[3],

'score': item[4],

'describe': item[5]

}

def main():

url = 'https://coding.imooc.com/?page=1'

html = get_one_page(url)

for item in parse_one_page(html):

print(item)

if __name__ == '__main__':

main()

保存解析后的数据到本地文件

4.保存文件操作

with open('imooctest.txt','a',encoding='utf-8') as f

with as :打开自动闭合的文件并设立对象f进行操作

参数:

imooctest.txt:文件名字

a:追加方式

encoding:编码格式 不这样设置可能保存的数据会乱码

f.write(json.dumps(content,ensure_ascii =False)+'\n')

json.dumps:将刚才被格式化后的字典转为字符串

ensure_ascii =False 不这样设置可能保存的数据会乱码

+'\n' 每条数据为一行

代码如下:

# -*- coding: utf-8 -*-

import requests

import re

import json

from requests.exceptions import RequestException

def get_one_page(url):

try:

response = requests.get(url)

if response.status_code == 200:

return response.content.decode("utf-8")

return None

except RequestException:

return None

def parse_one_page(html):

pattern = re.compile('<div class="box">.*?lecturer-info.*?<span>(.*?)</span>.*?shizhan-intro-box.*?title=".*?">'

'(.*?)</p>.*?class="grade">(.*?)</span>.*?imv2-set-sns.*?</i>'

'(.*?)</span>.*?class="big-text">(.*?)</p>.*?shizan-desc.*?>'

'(.*?)</p>.*?</div>',re.S)

items = re.findall(pattern,html)

for item in items:

yield {

'teacher': item[0],

'title': item[1],

'grade': item[2],

'people':item[3],

'score': item[4],

'describe': item[5]

}

def write_to_file(content):

with open('imooctest.txt','a',encoding='utf-8') as f:

f.write(json.dumps(content,ensure_ascii=False)+'\n')

f.close()

def main():

url = 'https://coding.imooc.com/?page=1'

html = get_one_page(url)

for item in parse_one_page(html):

print(item)

write_to_file(item)

if __name__ == '__main__':

main()

5.爬取所有页面并以多进程方式

分析页面,会发现,需要爬取的页面如下

https://coding.imooc.com/?page=1

https://coding.imooc.com/?page=2

https://coding.imooc.com/?page=3

https://coding.imooc.com/?page=4

我们需要构造这种格式的页面

主函数可以类似这样:

for i in range(4):

main(i+1)

完整代码:

# -*- coding: utf-8 -*-

import requests

import re

import json

from requests.exceptions import RequestException

from multiprocessing import Pool

def get_one_page(url):

try:

response = requests.get(url)

if response.status_code == 200:

return response.content.decode("utf-8")

return None

except RequestException:

return None

def parse_one_page(html):

pattern = re.compile('<div class="box">.*?lecturer-info.*?<span>(.*?)</span>.*?shizhan-intro-box.*?title=".*?">'

'(.*?)</p>.*?class="grade">(.*?)</span>.*?imv2-set-sns.*?</i>'

'(.*?)</span>.*?class="big-text">(.*?)</p>.*?shizan-desc.*?>'

'(.*?)</p>.*?</div>',re.S)

items = re.findall(pattern,html)

for item in items:

yield {

'teacher': item[0],

'title': item[1],

'grade': item[2],

'people':item[3],

'score': item[4],

'describe': item[5]

}

def write_to_file(content):

with open('imoocAll.txt','a',encoding='utf-8') as f:

f.write(json.dumps(content,ensure_ascii=False)+'\n')

f.close()

def main(page):

url = 'https://coding.imooc.com/?page='+str(page)

html = get_one_page(url)

# parse_one_page(html)

# print(html)

for item in parse_one_page(html):

print(item)

write_to_file(item)

if __name__ == '__main__':

pool = Pool()

pool.map(main,[i+1 for i in range(4)])

# for i in range(4):

# main(i+1)

到这里,我们就能够把慕课网上面的全部实战课程的信息爬取下来,拿到这些数据,你就可以做自己喜爱的分析了

简单python爬虫案例(爬取慕课网全部实战课程信息)的更多相关文章

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- python 爬虫之爬取大街网(思路)

由于需要,本人需要对大街网招聘信息进行分析,故写了个爬虫进行爬取.这里我将记录一下,本人爬取大街网的思路. 附:爬取得数据仅供自己分析所用,并未用作其它用途. 附:本篇适合有一定 爬虫基础 crawl ...

- Python爬虫项目--爬取自如网房源信息

本次爬取自如网房源信息所用到的知识点: 1. requests get请求 2. lxml解析html 3. Xpath 4. MongoDB存储 正文 1.分析目标站点 1. url: http:/ ...

- Python爬虫,爬取腾讯漫画实战

先上个爬取的结果图 最后的结果为每部漫画按章节保存 运行环境 IDE VS2019 Python3.7 先上代码,代码非常简短,包含空行也才50行,多亏了python强大的库 import os im ...

- Node.js爬虫-爬取慕课网课程信息

第一次学习Node.js爬虫,所以这时一个简单的爬虫,Node.js的好处就是可以并发的执行 这个爬虫主要就是获取慕课网的课程信息,并把获得的信息存储到一个文件中,其中要用到cheerio库,它可以让 ...

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

- 网络爬虫之定向爬虫:爬取当当网2015年图书销售排行榜信息(Crawler)

做了个爬虫,爬取当当网--2015年图书销售排行榜 TOP500 爬取的基本思想是:通过浏览网页,列出你所想要获取的信息,然后通过浏览网页的源码和检查(这里用的是chrome)来获相关信息的节点,最后 ...

- from appium import webdriver 使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium)

使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium) - 北平吴彦祖 - 博客园 https://www.cnblogs.com/stevenshushu/p ...

- Python爬虫之爬取站内所有图片

title date tags layut Python爬虫之爬取站内所有图片 2018-10-07 Python post 目标是 http://www.5442.com/meinv/ 如需在非li ...

随机推荐

- JSON格式提取相同属性的某个值

[ {UID:"222",value:"111"}, {UID:"222",value:"103"}, {UID:&qu ...

- unity shader 入门

1.一个简单的顶点/片元着色器基本结构 Shader "Unity Shaders Book/Chapter 5/Simple Shader" { } SubShader { Pa ...

- LeetCode刷题 - (01)两数之和

题目描述 给定一个整数数组nums和一个目标值target,请你在该数组中找出和为目标值的那两个整数,并返回他们的数组下标. 你可以假设每种输入只会对应一个答案.但是,你不能重复利用这个数组中同样的元 ...

- C#开发BIMFACE系列10 服务端API之获取文件下载链接

系列目录 [已更新最新开发文章,点击查看详细] 通过BIMFACE控制台或者调用服务接口上传文件成功后,默认场景下需要下载该源文件,下载文件一般需要知道文件的下载链接即可.BIMACE平台提供 ...

- 通过PHP与Python代码对比浅析语法差异

一.背景 人工智能这几年一直都比较火,笔者一直想去学习一番:因为一直是从事PHP开发工作,对于Python接触并不算多,总是在关键时候面临着基础不牢,地动山摇的尴尬,比如在遇到稍微深入些的问题时候就容 ...

- java Spring-Boot框架学习视频-百度云盘

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明.本文链接:https://blog.csdn.net/lk142500/article/deta ...

- java虚拟机10.内存模型与线程

多任务处理在现代计算机操作系统中是一项必备的功能,让计算机同时去做几件事情,不仅是因为计算机的运算能力强大了,更重要的原因是计算机的运算速度与它的存储和通信子系统速度的差距太大,大量的时间都花费在磁盘 ...

- ios5与ios7数字输入样式一致

<input name="activeCode" id="activeCode" ontouchstart="this.type='numbe ...

- poj 1511 Invitation Cards(dijstra优化)

题目链接:http://poj.org/problem?id=1511 题意:给出n个点和n条有向边,求所有点到源点1的来回最短路之和(保证每个点都可以往返源点1) 题目比较简单就是边和点的个数有点多 ...

- 题解 bzoj 2151 种树

题意 传送门 手写堆大法好啊,题解貌似没有结构体堆的做法,思路有些像配对堆,关于配对堆请自行百度,因为本蒟蒻不会.. 以下是蒟蒻的做法:建立一个大根堆a维护最大价值里面存入它的编号以及价值.听说配对堆 ...