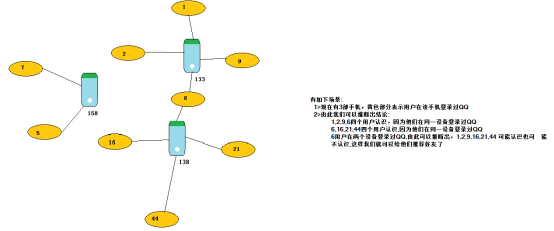

spark graphX作图计算

一、使用graph做好友推荐

import org.apache.spark.graphx.{Edge, Graph, VertexId}

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

//求共同好友

object CommendFriend {

def main(args: Array[String]): Unit = {

//创建入口

val conf: SparkConf = new SparkConf().setAppName("CommendFriend").setMaster("local[*]")

val sc: SparkContext = new SparkContext(conf)

//点的集合

//点

val uv: RDD[(VertexId,(String,Int))] = sc.parallelize(Seq(

(133, ("毕东旭", 58)),

(1, ("贺咪咪", 18)),

(2, ("范闯", 19)),

(9, ("贾璐燕", 24)),

(6, ("马彪", 23)),

(138, ("刘国建", 40)),

(16, ("李亚茹", 18)),

(21, ("任伟", 25)),

(44, ("张冲霄", 22)),

(158, ("郭佳瑞", 22)),

(5, ("申志宇", 22)),

(7, ("卫国强", 22))

))

//边的集合

//边Edge

val ue: RDD[Edge[Int]] = sc.parallelize(Seq(

Edge(1, 133,0),

Edge(2, 133,0),

Edge(9, 133,0),

Edge(6, 133,0),

Edge(6, 138,0),

Edge(16, 138,0),

Edge(44, 138,0),

Edge(21, 138,0),

Edge(5, 158,0),

Edge(7, 158,0)

))

//构建图(连通图)

val graph: Graph[(String, Int), Int] = Graph(uv,ue)

//调用连通图算法

graph

.connectedComponents()

.vertices

.join(uv)

.map{

case (uid,(minid,(name,age)))=>(minid,(uid,name,age))

}.groupByKey()

.foreach(println(_))

//关闭

}

}

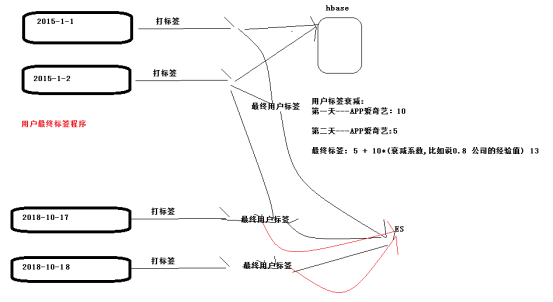

二、用户标签数据合并Demo

测试数据

|

陌上花开 旧事酒浓 多情汉子 APP爱奇艺:10 BS龙德广场:8 多情汉子 满心闯 K韩剧:20 满心闯 喜欢不是爱 不是唯一 APP爱奇艺:10 装逼卖萌无所不能 K欧莱雅面膜:5 |

计算结果数据

|

(-397860375,(List(喜欢不是爱, 不是唯一, 多情汉子, 多情汉子, 满心闯, 满心闯, 旧事酒浓, 陌上花开),List((APP爱奇艺,20), (K韩剧,20), (BS龙德广场,8)))) (553023549,(List(装逼卖萌无所不能),List((K欧莱雅面膜,5)))) |

import org.apache.spark.graphx.{Edge, Graph, VertexId}

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object UserRelationDemo {

def main(args: Array[String]): Unit = {

//创建入口

val conf: SparkConf = new SparkConf().setAppName("CommendFriend").setMaster("local[*]")

val sc: SparkContext = new SparkContext(conf)

//读取数据

val rdd: RDD[String] = sc.textFile("F:\\dmp\\graph")

//点的集合

val uv: RDD[(VertexId, (String, List[(String, Int)]))] = rdd.flatMap(line => {

val arr: Array[String] = line.split(" ")

val tags: List[(String, Int)] = arr.filter(_.contains(":")).map(tagstr => {

val arr: Array[String] = tagstr.split(":")

(arr(0), arr(1).toInt)

}).toList

val filterd: Array[String] = arr.filter(!_.contains(":"))

filterd.map(nickname => {

if(nickname.equals(filterd(0))) {

(nickname.hashCode.toLong, (nickname, tags))

}else{

(nickname.hashCode.toLong, (nickname, List.empty))

}

})

})

//边的集合

val ue: RDD[Edge[Int]] = rdd.flatMap(line => {

val arr: Array[String] = line.split(" ")

val filterd: Array[String] = arr.filter(!_.contains(":"))

filterd.map(nickname => Edge(filterd(0).hashCode.toLong, nickname.hashCode.toLong, 0))

})

//构建图

val graph: Graph[(String, List[(String, Int)]), Int] = Graph(uv,ue)

//连通图算法找关系

graph

.connectedComponents()

.vertices

.join(uv)

.map{

case (uid,(minid,(nickname,list))) => (minid,(List(uid),List(nickname),list))

}

.reduceByKey{

case (t1,t2) =>

(

t1._1++t2._1 distinct ,

t1._2++t2._2 distinct,

t1._3++t2._3.groupBy(_._1).mapValues(_.map(_._2).reduce(_+_))

//.groupBy(_._1).mapValues(_.map(_._2).sum)

// list.groupBy(_._1).mapValues(_.map(_._2).foldLeft(0)(_+_))

)

}

.foreach(println(_))

//关闭

sc.stop()

}

}

三、用户标签数据合并

|

package cn.bw.mock.tags import cn.bw.mock.utils.TagsUtil |

四、用户最终标签和衰减系数

spark graphX作图计算的更多相关文章

- Spark GraphX图计算核心源码分析【图构建器、顶点、边】

一.图构建器 GraphX提供了几种从RDD或磁盘上的顶点和边的集合构建图形的方法.默认情况下,没有图构建器会重新划分图的边:相反,边保留在默认分区中.Graph.groupEdges要求对图进行重新 ...

- Spark GraphX图计算核心算子实战【AggreagteMessage】

一.简介 参考博客:https://www.cnblogs.com/yszd/p/10186556.html 二.代码实现 package graphx import org.apache.log4j ...

- Spark GraphX图计算简单案例【代码实现,源码分析】

一.简介 参考:https://www.cnblogs.com/yszd/p/10186556.html 二.代码实现 package big.data.analyse.graphx import o ...

- Spark GraphX宝刀出鞘,图文并茂研习图计算秘笈与熟练的掌握Scala语言【大数据Spark实战高手之路】

Spark GraphX宝刀出鞘,图文并茂研习图计算秘笈 大数据的概念与应用,正随着智能手机.平板电脑的快速流行而日渐普及,大数据中图的并行化处理一直是一个非常热门的话题.图计算正在被广泛地应用于社交 ...

- 明风:分布式图计算的平台Spark GraphX 在淘宝的实践

快刀初试:Spark GraphX在淘宝的实践 作者:明风 (本文由团队中梧苇和我一起撰写,并由团队中的林岳,岩岫,世仪等多人Review,发表于程序员的8月刊,由于篇幅原因,略作删减,本文为完整版) ...

- 大数据技术之_19_Spark学习_05_Spark GraphX 应用解析 + Spark GraphX 概述、解析 + 计算模式 + Pregel API + 图算法参考代码 + PageRank 实例

第1章 Spark GraphX 概述1.1 什么是 Spark GraphX1.2 弹性分布式属性图1.3 运行图计算程序第2章 Spark GraphX 解析2.1 存储模式2.1.1 图存储模式 ...

- 基于Spark GraphX计算二度关系

关系计算问题描述 二度关系是指用户与用户通过关注者为桥梁发现到的关注者之间的关系.目前微博通过二度关系实现了潜在用户的推荐.用户的一度关系包含了关注.好友两种类型,二度关系则得到关注的关注.关注的好友 ...

- 转载:四两拨千斤:借助Spark GraphX将QQ千亿关系链计算提速20倍

四两拨千斤:借助Spark GraphX将QQ千亿关系链计算提速20倍 时间 2016-07-22 16:57:00 炼数成金 相似文章 (5) 原文 http://www.dataguru.cn/ ...

- Spark GraphX学习资料

<Spark GraphX 大规模图计算和图挖掘> http://book.51cto.com/art/201408/450049.htm http://www.csdn.net/arti ...

随机推荐

- Maven optional关键字透彻图解

写在前面 本来想写一篇「如何自定义Spring Boot Starter」,但是为了更好理解 Starter 的一些设计理念和其中的关键点,所以提前将一些细节内容单独提取出来讲解说明 在 Maven ...

- scrapy爬取京东iPhone11评论(一)

咨询行业中经常接触到文本类信息,无论是分词做词云图,还是整理编码分析用,都非常具有价值. 本文将记录使用scrapy框架爬取京东IPhone11评论的过程,由于一边学习一边实践,更新稍慢请见谅. 1. ...

- 暑期集训20190725 胜地不常(paradise)

[题目描述] 给定两个长度为n的非负整数数组a,b, [输入数据] 第一行一个整数n. 第二行n个整数a1~an. 第三行n个整数b1~bn. [输出数据] 一行一个整数表示答案. [样例输入] 4 ...

- SVD分解

首先,有y = AX,将A看作是对X的线性变换 但是,如果有AX = λX,也就是,A对X的线性变换,就是令X的长度为原来的λ倍数. *说起线性变换,A肯定要是方阵,而且各列线性无关.(回想一下,A各 ...

- 爬虫之scrapy简介

原始的爬虫流程:效率低.同步.阻塞 scrapy执行流程:效率高.异步.非阻塞 scrapy的概念 scrapy是一个爬虫框架 开发速度快 稳定性高 性能优越 scrapy的流程 1. 爬虫模块(Sp ...

- Kubernetes5-集群上搭建基于redis和docker的留言薄

一.简介 1.环境依旧是kubernetes之前文章的架构 2.需要docker的镜像 1)php-forntend web 前端镜像 docker.io-kubeguide-guestbook-ph ...

- CSP-S 95 (sb lsc yy赛)

sb lsc 终于改完题了!(心力交悴.png)

- ToolStrip控件左右拖拽移动效果实现

1.主窗体下部添加一个Panel乘放ToolStrip控件以实现ToolStrip在窗体下部定位.2.当ToolStrip控件中子控件超出屏幕时,拖动控件可以实现滑动效果.拖动到控件边缘距窗体边缘1/ ...

- 深入理解计算机系统 第八章 异常控制流 part2

关于进程,需要关注其提供给应用程序的两个关键抽象: 1.一个独立的逻辑控制流,它提供一个假象,好像我们的程序独占地使用处理器 2.一个私有的地址空间,它提供一个假象,好像我们的程序独占地使用内存系统 ...

- js 把数组中每个元素的某个字段取出

方法一:map() let cities = [ {city:"北京",bOn:false}, {city:"上海",bOn:false}, {city:&qu ...