Python爬虫02——贴吧图片爬虫V2.0

Python小爬虫——贴吧图片爬虫V2.0

贴吧图片爬虫进阶:在上次的第一个小爬虫过后,用了几次发现每爬一个帖子,都要自己手动输入帖子链接,WTF这程序简直反人类!不行了不行了得改进改进。

思路:

- 贴吧的链接可以从每个贴吧首页爬取

- 再从爬取到的贴吧链接中一个个去下载图片

- 图片得按帖子放置好,不然就太乱了

在这期间研究了下Xpath:

Xpath是一门在 XML 文档中查找信息的语言。XPath 可用来在 XML 文档中对元素和属性进行遍历。

简单点来说就是能让你的爬虫通过标签的id、class、name等属性可以获取到标签的属性或内容的一门语言,就不用去写讨厌的正则表达式了(刚开始用正则人都要炸了)

Xpath的学习视频呢,在这里--->Go

当然其实用re也能实现,废话也不多说了,开始正题了

帖子链接的爬取:

我们的目标当然是:壁纸吧、萌妹子、爆照吧等等等等

作为一个绅士还是以壁纸吧来做示范吧:http://tieba.baidu.com/f?kw=%E5%A3%81%E7%BA%B8&ie=utf-8

打开壁纸吧

通过右键检查、或是查看源码找到每个帖子的标签

帖子的标签在这里

<a href="/p/4686986115" title="【壁纸】江湖多风雨,天下已入秋" target="_blank" class="j_th_tit ">【壁纸】江湖多风雨,天下已入秋</a>

应该就是href后面的哪个 "/p/4686986115" 了

点进去果然,就是在前面多了串 http://tieba.baidu.com

OK!那把链接爬取出来就相当容易了:

from lxml import etree def getArticleLinks(url):

html = requests.get(url)

Selector = etree.HTML(html.text)

# 通过Xpath 获取每个帖子的url后缀

url_list = Selector.xpath('//div[@class="threadlist_lz clearfix"]/div/a/@href')

# 在每个后缀前加上百度贴吧的url前缀

for i in range(len(url_list)):

url_list[i] = 'http://tieba.baidu.com' + url_list[i]

return url_list

图片按文件夹下载:

先是一个帖子的图片下载:

def get_img(url):

html = requests.get(url)

# 这里用Xpath或者之前的re拿到img_url_list

Selector = etree.HTML(html.text)

img_url_list = Selector.xpath('//*[@class="BDE_Image"]/@src')

pic_name = 0

# 下载图片

for each in img_url_list:

urllib.urlretrieve(each, 'pic_%s.jpg' % pic_name)

pic_name += 1

其实这样已经差不多了,再来个循环每个帖子链接来一次 get_img 就可以获取到所有的图片,但是这样的话:

- 那么多帖子的图片在一起很乱

- 下一个帖子的图片会把上一个帖子图片覆盖(因为都是pic_00.jpg开始的,且都在一个文件夹内)

我的想法是建一个downloads文件夹,然后在里面按帖子分文件夹存放下载下来的图片

# 该目录下创建一个downloads文件夹存放下载图片

if not os.path.exists('downloads'):

os.mkdir('downloads')

当然是没有的时候建立,有的话就可以不用了

然后按帖子分文件夹

# 这里把帖子url的后缀作为文件夹名,因为不能有'/'所以把它替换成了''

img_dir = 'downloads/' + url_list[i][23:].replace("/", '')

if not os.path.exists(img_dir):

os.mkdir(img_dir)

然后就可以下载了:

def download_img(url_list):

if not os.path.exists('downloads'):

os.mkdir('downloads')

for each in url_list:

img_dir = 'downloads/' + each[23:].replace("/", '')

if not os.path.exists(img_dir):

os.mkdir(img_dir)

get_img(each)

然而并没有一个个图片按帖子放好,文件夹是建好了。

经过研究发现,应该在 get_img 之前应该先把当前目录改为要放的文件夹目录下

os.chdir(path) 可以用来改变python当前所在的文件夹

然后在下载完一个帖子后得移回当前目录,最后的代码就是:

def download_img(url_list):

# 该目录下创建一个downloads文件夹存放下载图片

if not os.path.exists('downloads'):

os.mkdir('downloads')

root_path = os.getcwd()

for each in url_list:

img_dir = 'downloads/' + each[23:].replace("/", '')

if not os.path.exists(img_dir):

os.mkdir(img_dir)

os.chdir(img_dir)

get_img(each)

os.chdir(root_path)

啪啪啪啪啪[完美]

交互:

老样子和之前的第一个小爬虫一样,添加一些交互。

不过我发现,一个贴吧第一页的帖子也贼多,然后由于爬虫暂时还是单线程的

所以若是要将整个第一页爬完,也是要花挺多时间,就稍微修改了下,加了一个帖子个数的输入

最终的代码:

# coding:utf-8

import requests

import os

import urllib

import re

from lxml import etree # 通过url获取每个帖子链接

def getArticleLinks(url):

html = requests.get(url)

Selector = etree.HTML(html.text)

# 通过Xpath 获取每个帖子的url后缀

url_list = Selector.xpath('//div[@class="threadlist_lz clearfix"]/div/a/@href')

# 在每个后缀前加上百度贴吧的url前缀

for i in range(len(url_list)):

url_list[i] = 'http://tieba.baidu.com' + url_list[i]

return url_list # 通过所给帖子链接,下载帖子中所有图片

def get_img(url):

html = requests.get(url)

Selector = etree.HTML(html.text)

img_url_list = Selector.xpath('//*[@class="BDE_Image"]/@src')

pic_name = 0

for each in img_url_list:

urllib.urlretrieve(each, 'pic_%s.jpg' % pic_name)

pic_name += 1 # 为每个帖子创建独立文件夹,并下载图片

def download_img(url_list,page):

# 该目录下创建一个downloads文件夹存放下载图片

if not os.path.exists('downloads'):

os.mkdir('downloads')

root_path = os.getcwd()

for i in range(page):

img_dir = 'downloads/' + url_list[i][23:].replace("/", '')

if not os.path.exists(img_dir):

os.mkdir(img_dir)

os.chdir(img_dir)

get_img(url_list[i])

os.chdir(root_path) if __name__ == '__main__':

print u'-----贴吧图片爬取装置2.0-----'

print u'请输入贴吧地址:',

targetUrl = raw_input('')

if not targetUrl:

print u'---没有地址输入正在使用默认地址(baidu壁纸吧)---'

targetUrl = 'http://tieba.baidu.com/f?kw=%E5%A3%81%E7%BA%B8&ie=utf-8' page = ''

while True:

print u'请输入你要下载的帖子数:',

page = raw_input('')

if re.findall(r'^[0-9]*[1-9][0-9]*$',page):

page = int(page)

break

print u'----------正在下载图片---------'

ArticleLinks = getArticleLinks(targetUrl)

download_img(ArticleLinks,page)

print u'-----------下载成功-----------'

raw_input('Press Enter to exit')

界面:

不要脸的说自我感觉良好23333

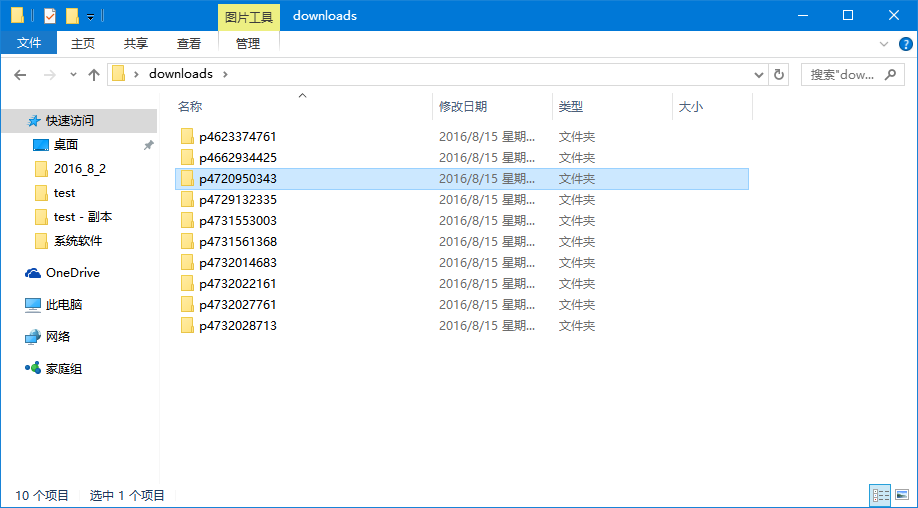

结构是这样滴

内容(爬取的内容怎么和我不一样?我不管23333)

# 结尾的啪啪啪啪啪

Python爬虫02——贴吧图片爬虫V2.0的更多相关文章

- 【Python爬虫实战】 图片爬虫-淘宝图片爬虫--千图网图片爬虫

所谓图片爬虫,就是从互联网中自动把对方服务器上的图片爬下来的爬虫程序.有些图片是直接在html文件里面,有些是隐藏在JS文件中,在html文件中只需要我们分析源码就能得到如果是隐藏在JS文件中,那么就 ...

- python学习笔记(接口自动化框架 V2.0)

这个是根据上次框架版本进行的优化 用python获取excel文件中测试用例数据 通过requets测试接口.并使用正则表达式验证响应信息内容 生成xml文件测试报告 版本更新内容: 1. 整理了Cr ...

- [py]python写一个通讯录step by step V3.0

python写一个通讯录step by step V3.0 参考: http://blog.51cto.com/lovelace/1631831 更新功能: 数据库进行数据存入和读取操作 字典配合函数 ...

- 重要消息:MoviePy v2.0.0.dev1预发布版本已经可以下载安装使用

☞ ░ 前往老猿Python博文目录 ░ 刚刚得知,MoviePy v2.0.0.dev1版本已经预发布,据说解决了多语言支持及TextClip等一系列Bug,大家不妨升级使用.升级指令:pip in ...

- [记录][python]python爬虫,下载某图片网站的所有图集

随笔仅用于学习交流,转载时请注明出处,http://www.cnblogs.com/CaDevil/p/5958770.html 该随笔是记录我的第一个python程序,一个爬去指定图片站点的所有图集 ...

- python scrapy版 极客学院爬虫V2

python scrapy版 极客学院爬虫V2 1 基本技术 使用scrapy 2 这个爬虫的难点是 Request中的headers和cookies 尝试过好多次才成功(模拟登录),否则只能抓免费课 ...

- python爬虫-爬取百度图片

python爬虫-爬取百度图片(转) #!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:16# 文件 :spider ...

- python写的百度图片爬虫

学了一下python正则表达式,写一个百度图片爬虫玩玩. 当技术遇上心术不正的人,就成我这样的2B青年了. python3.6开发.程序已经打包好,下载地址: http://pan.baidu.com ...

- Python图片爬虫

1.今天给大家介绍自己写的一个图片爬虫,说白了就是从网页自动上下载需要的图片 2.首先选取目标为:http://www.zhangzishi.cc/涨姿势这个网站如下图,我们的目标就是爬取该网站福利社 ...

随机推荐

- JAVA加密算法系列-AES

package ***; import java.io.UnsupportedEncodingException; import java.security.InvalidKeyException; ...

- 关于sql语句between and的边界问题

BETWEEN 操作符 操作符 BETWEEN ... AND 会选取介于两个值之间的数据范围.这些值可以是数值.文本或者日期. SQL BETWEEN 语法 SELECT column_name(s ...

- 学Java,是自学还是去培训班学习?

现在正在读在校的最后一个学年,想毕业后从事编程,但是感觉自己技术太差,应该是培训呢?还是去找实习?亦或是有更好的途径? 对于 Android 目前的行业趋势,不知道自己该不该坚持?还是转其他行业? 已 ...

- JS window对象的top、parent、opener含义介绍 以及防止网页被嵌入框架的代码

1.top该变更永远指分割窗口最高层次的浏览器窗口.如果计划从分割窗口的最高层次开始执行命令,就可以用top变量. 2.openeropener用于在window.open的页面引用执行该window ...

- 初识JS

今儿我遇到一特别恐怖的事儿,JS 刚开始的我看到JS感觉是懵逼的,翻开第一页,感觉是棒棒哒,再看第二页,感觉是easy的,看到第三页是恐怖的,当看到的第四页的时候,我感觉今年的清明节是为我准备的 废话 ...

- 记一次使用修改字节码的方法解决java.lang.NoSuchMethodError

接兔兔国际sdk ane 充值界面选择兔币充值就会闪退, 观察logcat 04-19 10:10:54.224: E/AndroidRuntime(20315): FATAL EXCEPTION: ...

- [Oracle]LogMiner工具小结

(一)LogMiner工具的作用Logminer工具主要用来分析redo log和archive log文件.通过该工具,可以轻松获得Oracle redo log和archive log文件的具体内 ...

- 使用虚拟机CentOS7部署CEPH集群

第1章 CEPH部署 1.1 简单介绍 Ceph的部署模式下主要包含以下几个类型的节点 Ø CephOSDs: A Ceph OSD 进程主要用来存储数据,处理数据的replication,恢复 ...

- [效率]Source insight标题栏中路径显示完整路径的方法

使用Source insight的时候,默认是不显示文件的全路径的,这一点有那么一段时间让我很纠结,因为很多函数都是基于硬件架构的,一个函数有很多时间.查看文件的全路径是非常有必要,可以通过以下实现: ...

- 详解Java反射机制

反射是程序在运行状态下,动态的获取某个类的内部信息的一种操作.例如:类名,包名,所有属性的集合,所有方法的集合,构造方法的集合等.该操作发生在程序的运行时状态,所以编译器管不着有关反射的一些代码,通常 ...