【转】python爬虫之腾讯视频vip下载

本文转自如下:

作者:jia666666

原文:https://blog.csdn.net/jia666666/article/details/82466553

版权声明:本文为博主原创文章,转载请附上博文链接!

---------------------

运行环境

IDE:pycharm

python:3.6.5

实现目的

实现对腾讯视频目标url的解析与下载,由于第三方vip解析,只提供在线观看,隐藏想实现对目标视频的下载

实现思路

首先拿到想要看的腾讯电影url,通过第三方vip视频解析网站进行解析,通过抓包,模拟浏览器发送正常请求,通过拿到缓存ts文件,下载视频ts文件,最后通过转换为mp4文件,即可实现正常播放

源码

import re

import os,shutil

import requests,threading

from urllib.request import urlretrieve

from pyquery import PyQuery as pq

from multiprocessing import Pool

class video_down():

def __init__(self,url):

# 拼接全民解析url

self.api='https://jx.618g.com'

self.get_url = 'https://jx.618g.com/?url=' + url

#设置UA模拟浏览器访问

self.head = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'}

#设置多线程数量

self.thread_num=32

#当前已经下载的文件数目

self.i = 0

# 调用网页获取

html = self.get_page(self.get_url)

if html:

# 解析网页

self.parse_page(html)

def get_page(self,get_url):

try:

print('正在请求目标网页....',get_url)

response=requests.get(get_url,headers=self.head)

if response.status_code==200:

#print(response.text)

print('请求目标网页完成....\n 准备解析....')

self.head['referer'] = get_url

return response.text

except Exception:

print('请求目标网页失败,请检查错误重试')

return None

def parse_page(self,html):

print('目标信息正在解析........')

doc=pq(html)

self.title=doc('head title').text()

print(self.title)

url = doc('#player').attr('src')[14:]

html=self.get_m3u8_1(url).strip()

#self.url = url + '800k/hls/index.m3u8'

self.url = url[:-10] +html

print(self.url)

print('解析完成,获取缓存ts文件.........')

self.get_m3u8_2(self.url)

def get_m3u8_1(self,url):

try:

response=requests.get(url,headers=self.head)

html=response.text

print('获取ts文件成功,准备提取信息')

return html[-20:]

except Exception:

print('缓存文件请求错误1,请检查错误')

def get_m3u8_2(self,url):

try:

response=requests.get(url,headers=self.head)

html=response.text

print('获取ts文件成功,准备提取信息')

self.parse_ts_2(html)

except Exception:

print('缓存文件请求错误2,请检查错误')

def parse_ts_2(self,html):

pattern=re.compile('.*?(.*?).ts')

self.ts_lists=re.findall(pattern,html)

print('信息提取完成......\n准备下载...')

self.pool()

def pool(self):

print('经计算需要下载%d个文件' % len(self.ts_lists))

self.ts_url = self.url[:-10]

if self.title not in os.listdir():

os.makedirs(self.title)

print('正在下载...所需时间较长,请耐心等待..')

#开启多进程下载

pool=Pool(16)

pool.map(self.save_ts,[ts_list for ts_list in self.ts_lists])

pool.close()

pool.join()

print('下载完成')

self.ts_to_mp4()

def ts_to_mp4(self):

print('ts文件正在进行转录mp4......')

str='copy /b '+self.title+'\*.ts '+self.title+'.mp4'

os.system(str)

filename=self.title+'.mp4'

if os.path.isfile(filename):

print('转换完成,祝你观影愉快')

shutil.rmtree(self.title)

def save_ts(self,ts_list):

try:

ts_urls = self.ts_url + '{}.ts'.format(ts_list)

self.i += 1

print('当前进度%d/%d'%(self.i,len(self.ts_lists)))

urlretrieve(url=ts_urls, filename=self.title + '/{}.ts'.format(ts_list))

except Exception:

print('保存文件出现错误')

if __name__ == '__main__':

#电影目标url:狄仁杰之四大天王

url='https://v.qq.com/x/cover/r6ri9qkcu66dna8.html'

#电影碟中谍5:神秘国度

url1='https://v.qq.com/x/cover/5c58griiqftvq00.html'

#电视剧斗破苍穹

url2='https://v.qq.com/x/cover/lcpwn26degwm7t3/z0027injhcq.html'

url3='https://v.qq.com/x/cover/33bfp8mmgakf0gi.html'

video_down(url2)

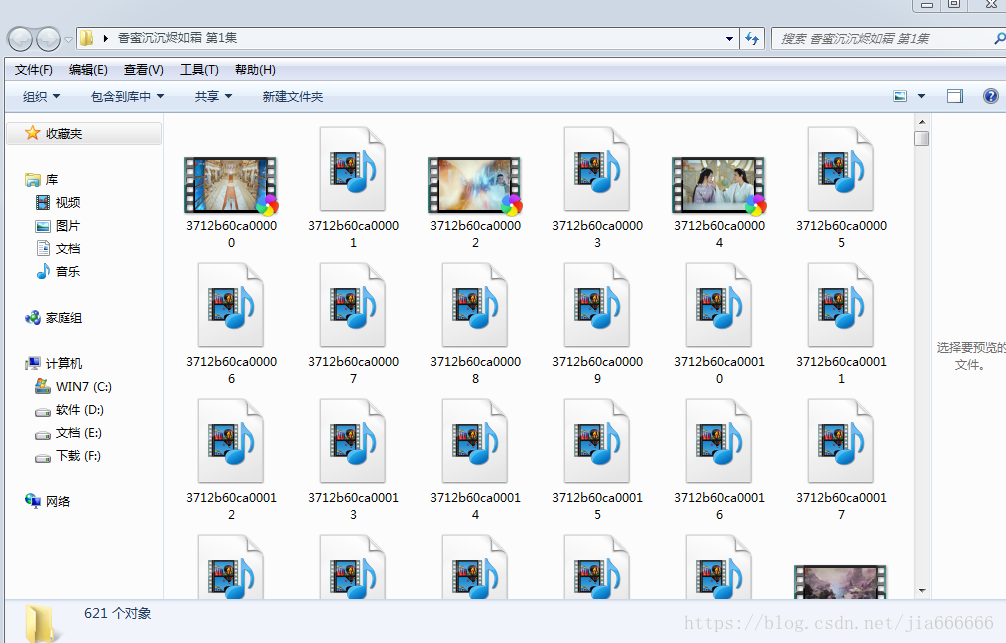

视频缓存ts文件

这里都是一些缓存视频文件,每个只有几秒钟播放,最后需要合并成一个mp4格式的视频,就可以正常播放,默认高清下载

注意这里的进度因为使用多进程下载,进度仅供参考,没有确切显示进度,可以进文件夹查看正常进度,可以理解为显示一次进度,下载一个ts文件

转换MP4

【转】python爬虫之腾讯视频vip下载的更多相关文章

- python 爬取腾讯视频的全部评论

一.网址分析 查阅了网上的大部分资料,大概都是通过抓包获取.但是抓包有点麻烦,尝试了F12,也可以获取到评论.以电视剧<在一起>为例子.评论最底端有个查看更多评论猜测过去应该是 Ajax ...

- Python 爬虫——抖音App视频抓包

APP抓包 前面我们了解了一些关于 Python 爬虫的知识,不过都是基于 PC 端浏览器网页中的内容进行爬取.现在手机 App 用的越来越多,而且很多也没有网页端,比如抖音就没有网页版,那么上面的视 ...

- Python爬虫-抖音小视频-mitmproxy与Appium

目的: 爬取抖音小视频 工具: mitmproxy.Appium 思路: 1. 通过 mitmproxy 截取请求, 找出 response 为 video 的请求. 2. 通过 mitmdu ...

- python爬虫(爬取视频)

爬虫爬视频 爬取步骤 第一步:获取视频所在的网页 第二步:F12中找到视频真正所在的链接 第三步:获取链接并转换成机械语言 第四部:保存 保存步骤代码 import re import request ...

- 1.记我的第一次python爬虫爬取网页视频

It is my first time to public some notes on this platform, and I just want to improve myself by reco ...

- Python爬虫爬取qq视频等动态网页全代码

环境:py3.4.4 32位 需要插件:selenium BeautifulSoup xlwt # coding = utf-8 from selenium import webdriverfrom ...

- Python简单网页爬虫——极客学院视频自动下载

http://blog.csdn.net/supercooly/article/details/51003921

- python 爬取腾讯视频评论

import urllib.request import re import urllib.error headers=('user-agent','Mozilla/5.0 (Windows NT 1 ...

- python爬虫--爬取某网站电影下载地址

前言:因为自己还是python世界的一名小学生,还有很多路要走,所以本文以目的为向导,达到目的即可,对于那些我自己都没弄懂的原理,不做去做过多解释,以免误人子弟,大家可以网上搜索. 友情提示:本代码用 ...

随机推荐

- python迭代器-迭代器取值-for循环-生成器-yield-生成器表达式-常用内置方法-面向过程编程-05

迭代器 迭代器 迭代: # 更新换代(其实也是重复)的过程,每一次的迭代都必须基于上一次的结果(上一次与这一次之间必须是有关系的) 迭代器: # 迭代取值的工具 为什么用迭代器: # 迭代器提供了一种 ...

- Java EE.Servlet.会话管理

一次会话是从客户打开浏览器开始到关闭浏览器结束.记录会话信息的技术称为会话跟踪.常见的会话跟踪技术有Cookie.URL重写和隐藏表单域. 1.Cookie Cookie是一小块可以嵌入到HTTP请求 ...

- K2 smarforms 控件整理

K2 Community – Market – Smatform Controls l K2 blackpearl 1. Drag and Drop Upload Control http: ...

- 使用GDAL实现DEM的地貌晕渲图(三)

目录 1. 原理 1) ArcMap生成彩色晕渲图 2) 彩色色带赋值 3) 颜色叠加 2. 实现 3. 结语 4. 参考 1. 原理 之前在<使用GDAL实现DEM的地貌晕渲图(一)>和 ...

- 02-Kubenetes资源

目录 Kubenetes资源 常用资源对象 标签labels 创建资源的方式 Pod pods.spec.containers 必须 nodeSelector <map [string]stri ...

- Could not load NIB in bundle: 'NSBundle.....

学习NSNotification时遇到了这个问题,错误日志如下: 2015-08-28 17:47:24.617 NSNotificationDemo[7158:786614] *** Termina ...

- [Hei.Captcha] Asp.Net Core 跨平台验证码实现

写在前面 说起来比较丢脸.我们有个手机的验证码发送逻辑需要使用验证码,这块本来项目里面就有验证码绘制逻辑,.Net Framework的,使用的包是System.Drawing,我把这验证码绘制逻辑复 ...

- memcached.c 源码分析

上文分析了memcached的autoconf过程以及configure, make过程,可以看到,memcached可执行文件是由memcached-memcached.o以及其他文件连接后编译出来 ...

- JDK的可视化工具系列 (四) JConsole、VisualVM

JConsole: Java监视与管理控制台 代码清单1: import java.util.*; public class JConsoleDemo { static class OOMObject ...

- 5.Go-封装、继承、接口、多态和断言

面向对象 Go语言开发者认为:面向对象就是特定类型(结构体)有着自己的方法,利用这个方法完成面向对象编程, 并没有提封装.继承.多态.所以Go语言进行面向对象编程时,重点在于灵活使用方法. Go语言有 ...