02 python爬虫-bs4

步骤

- 爬取主页面中的文章详情的url和图片地址

- 下载图片 并请求加文章详情中的页面内容

- 爬取文章详情中的标题、作者、发布时间

代码

import requests

import csv

from bs4 import BeautifulSoup

# 请求的一级页面的地址

q_url = 'http://xinfadi.com.cn/newsCenter.html?current=1'

def get_page():

headers = {

'user-agent': 'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.116 Safari/537.36 UOS'

}

r = requests.get(q_url, headers=headers)

r.encoding = 'utf-8'

res = r.text

return res

def parser_text(content):

# 把页面源代码交给BeautifulSoup进行处理,生成bs对象

# 从bs对象中查找数据

# find(标签,属性=值)

# find_all(标签,属性=值)

# return

soup = BeautifulSoup(content, 'html.parser')

# 找属性id=nowplaying的div 下的 class=list-item 的所有li find找一个 find_all找所有

# li_list = soup.find_all('ul', class_='list_con fl')

# attrs 和 class_ 是一个意思,此时可以避免class关键字

li_list = soup.find_all('ul', attrs={'class': 'list_con fl'})

data_list = list()

for li in li_list:

dataKV = {}

src = li.find('a') # 找li标签下的a标签

# http://xinfadi.com.cn + /news-118.html

dataKV['src'] = q_url.split('/newsCenter')[0] + src.get('href') # 获取href的值

# http://newlands-n.oss-cn-beijing.aliyuncs.com/IMAGE/bf1d68af-8966-4e1e-bcac-3a34233a6970.jpg

img = li.find('img') # 找li标签下的img标签

dataKV['img'] = img.get('src') # 获取src的值

# 下载图片

save_data_b(dataKV['img'])

# 请求详情页面

# http://xinfadi.com.cn/news-137.html

r = requests.get(dataKV['src'])

r.encoding = 'utf-8'

second_res = r.text

second_soup = BeautifulSoup(second_res, 'html.parser')

title = second_soup.find('span', attrs={'class': 'right'}).text

dataKV['title'] = title

spans = second_soup.find('div', attrs={'class': 'ssss'}).find_all('span')

dataKV['author'] = spans[0].text

dataKV['time'] = spans[1].text

data_list.append(dataKV)

# print("======" * 10)

return data_list

# 存为CSV

def save_data_csv(data_list):

headers = data_list[0].keys() # 获取标题

with open('new.csv', 'w', newline='', encoding='utf-8') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

f_csv.writerows(data_list)

# 下载图片 、 mp4 、 zip 都可以这样下载

def save_data_b(url):

r = requests.get(url)

img_name = url.split("/")[-1] # p2892635176.jpg

with open('img/' + img_name, mode='wb') as f:

f.write(r.content)

if __name__ == '__main__':

# 步骤

# 1. 爬取主页面中的文章详情的url和图片地址

# 2. 下载图片 并请求加文章详情中的页面内容

# 3. 爬取文章详情中的标题、作者、发布时间

# 获取页面源代码

text = get_page()

# 解析源代码,获取需要的信息

data_list = parser_text(text)

# 存为csv数据

save_data_csv(data_list)

结果

new.csv

src,img,title,author,time

http://xinfadi.com.cn/news-137.html,http://newlands-n.oss-cn-beijing.aliyuncs.com/IMAGE/bf1d68af-8966-4e1e-bcac-3a34233a6970.jpg,【重要通知】新发地保供车辆司乘人员报备平台,admin,2022-10-13 17:49:47

http://xinfadi.com.cn/news-126.html,http://newlands-n.oss-cn-beijing.aliyuncs.com/IMAGE/2523ea4a-dc2c-461e-b709-270a56241859.jpg,【隆重招商】新发地全国名特优农产品销售中心全新招商,admin,2022-07-18 18:13:42

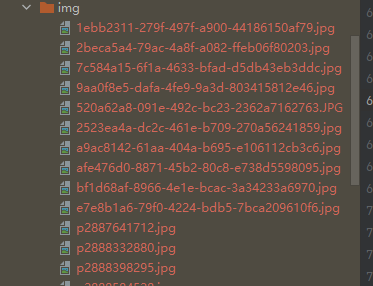

图片

02 python爬虫-bs4的更多相关文章

- python爬虫主要就是五个模块:爬虫启动入口模块,URL管理器存放已经爬虫的URL和待爬虫URL列表,html下载器,html解析器,html输出器 同时可以掌握到urllib2的使用、bs4(BeautifulSoup)页面解析器、re正则表达式、urlparse、python基础知识回顾(set集合操作)等相关内容。

本次python爬虫百步百科,里面详细分析了爬虫的步骤,对每一步代码都有详细的注释说明,可通过本案例掌握python爬虫的特点: 1.爬虫调度入口(crawler_main.py) # coding: ...

- python爬虫的页面数据解析和提取/xpath/bs4/jsonpath/正则(1)

一.数据类型及解析方式 一般来讲对我们而言,需要抓取的是某个网站或者某个应用的内容,提取有用的价值.内容一般分为两部分,非结构化的数据 和 结构化的数据. 非结构化数据:先有数据,再有结构, 结构化数 ...

- python爬虫入门02:教你通过 Fiddler 进行手机抓包

哟~哟~哟~ hi起来 everybody 今天要说说怎么在我们的手机抓包 通过 python爬虫入门01:教你在Chrome浏览器轻松抓包 我们知道了 HTTP 的请求方式 以及在 Chrome 中 ...

- Python爬虫--- 1.1请求库的安装与使用

来说先说爬虫的原理:爬虫本质上是模拟人浏览信息的过程,只不过他通过计算机来达到快速抓取筛选信息的目的所以我们想要写一个爬虫,最基本的就是要将我们需要抓取信息的网页原原本本的抓取下来.这个时候就要用到请 ...

- [Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息

[Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息 2018-07-21 23:53:02 larger5 阅读数 4123更多 分类专栏: 网络爬虫 版权声明: ...

- Python爬虫系统学习(1)

Python爬虫系统化学习(1) 前言:爬虫的学习对生活中很多事情都很有帮助,比如买房的时候爬取房价,爬取影评之类的,学习爬虫也是在提升对Python的掌握,所以我准备用2-3周的晚上时间,提升自己对 ...

- python 爬虫(二)

python 爬虫 Advanced HTML Parsing 1. 通过属性查找标签:基本上在每一个网站上都有stylesheets,针对于不同的标签会有不同的css类于之向对应在我们看到的标签可能 ...

- Python爬虫入门

Python爬虫简介(来源于维基百科): 网络爬虫始于一张被称作种子的统一资源地址(URLs)列表.当网络爬虫访问这些统一资源定位器时,它们会甄别出页面上所有的超链接,并将它们写入一张"待访列表",即 ...

- python爬虫代码

原创python爬虫代码 主要用到urllib2.BeautifulSoup模块 #encoding=utf-8 import re import requests import urllib2 im ...

- 一个简单的多线程Python爬虫(一)

一个简单的多线程Python爬虫 最近想要抓取拉勾网的数据,最开始是使用Scrapy的,但是遇到了下面两个问题: 前端页面是用JS模板引擎生成的 接口主要是用POST提交参数的 目前不会处理使用JS模 ...

随机推荐

- KingbaseES V8R6集群部署案例之---openEuler系统脚本部署故障

案例说明: 在openEuler系统下通过脚本方式部署KingbaseES V8R6集群,脚本执行过程中,加载vip失败.本次故障问题,主要是因为openEuler系统shell和脚本的不兼容引起. ...

- markdown 常用表情符号 (github emoji)

markdown 常用表情(emoji) 官网[非笔者维护,仅做引用] Face Smiling 咧嘴笑 grinning 汗颜笑 sweat_smile 爆笑 rofl 眨眼笑 wink innoc ...

- 通过位运算修改指定bit位的值

通过位运算将指定位的值置0或1 问题样例 假如现在有一个8bit二进制数A,其可以为任何值,所以这里不妨先设A=(xxxxxxxx)2,{x|0,1} 现在需要你将A的几个指定位修改为1或0,例如将A ...

- #排列组合,容斥#洛谷 5684 [CSPJX2019]非回文串

题目 分析 那显然就是\(n!\)减去回文串的方案数 首先如果有超过一个出现奇数次字母那肯定不存在回文串 如果有且仅有一个首先要在次数中选择一个然后其它当偶数处理 偶数那就是首先字母位置选好但顺序可以 ...

- 【直播回顾】OpenHarmony知识赋能五期第五课——多媒体子系统之视频解读

5月19日晚上19点,知识赋能第五期第五节课<OpenHarmony标准系统多媒体子系统之视频解读>,在OpenHarmony开发者成长计划社群内成功举行. 本期课程,由深开鸿资深技术专家 ...

- Go 语言 Printf 函数和格式化动词详解

Printf() 函数可以使用多种格式化动词对输出进行格式化.下面是可以与所有数据类型一起使用的一些通用格式化动词: 以下动词适用于所有数据类型: 动词 描述 %v 以默认格式打印值 %#v 以 Go ...

- django项目部署到centos

服务器是使用的阿里云的centos 7.6 项目使用的是 Python3.9.5 + Django 3.2.4 目标:将django项目部署到centos上,centos + Python + dja ...

- UJCMS 9.1.0 发布,国内开源 java cms

许可协议从GPL-2改为Apache-2.0,更宽松的协议,方便用户将系统集成到自身的应用中. 修复了已知bug,系统更加稳定. 升级日志(9.1.0) 修复前台全文搜索没有结果 web.xml se ...

- 重新整理 .net core 实践篇———承载[外篇]

前言 简单介绍一下承载. 正文 名称叫做承载,其实就是.net core 定义的一套长期运行的服务的规范. 这个服务可以是web服务,也可以是其他服务,比如tcp,或者一些监控服务. 这里以监控服务为 ...

- asp .net core 单页应用

前言 单页应用其实就是 asp.net core 来作为js service,个人觉得这样更好调试,这种比较适合中小型业务. 正文 因为自己写过混合app是ionic,那么就尝试一下angular的单 ...