Python知乎热门话题爬取

本例子是参考崔老师的Python3网络爬虫开发实战写的

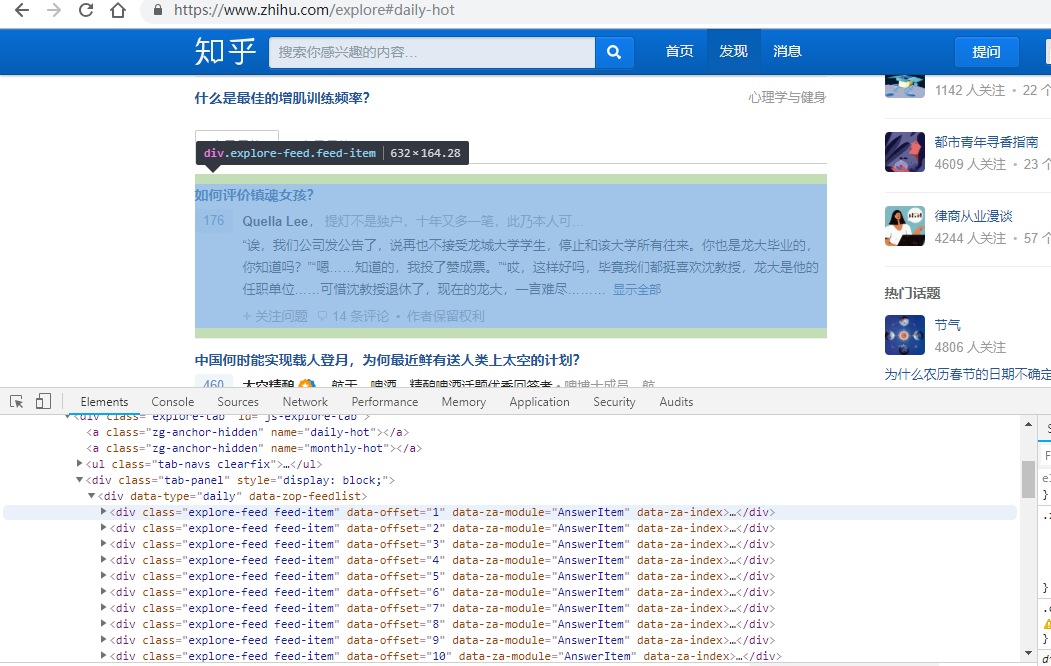

看网页界面:

热门话题都在 explore-feed feed-item的div里面

源码如下:

import requests

from pyquery import PyQuery as pq url='https://www.zhihu.com/explore' #今日最热

#url='https://www.zhihu.com/explore#monthly-hot' #本月最热

headers={

'User-Agent':"Mozilla/5.0 (Windows NT 6.0) AppleWebKit/536.5 (KHTML, like Gecko) Chrome/19.0.1084.36 Safari/536.5",

}

html=requests.get(url,headers=headers).text

doc=pq(html)

#print(doc)

items=doc('.explore-feed.feed-item').items()

for item in items:

question=item.find('h2').text()

#获取问题

print(question)

author=item.find('.author-link').text()

#获取作者

print(author)

answer=pq(item.find('.content').html()).text()

#获取答案(老师写的没看懂,可能需要jquery知识)

print(answer)

print('===='*10)

answer1=item.find('.zh-summary').text()

#自己写的获取答案。。。

print(answer1) #第一种写入方法

file=open('知乎.txt','a',encoding='utf-8')

file.write('\n'.join([question,author,answer]))

file.write('\n'+'****'*50+'\n')

file.close() #第二种写入方法 不需要写关闭方法

with open('知乎.txt','a',encoding='utf-8') as fp:

fp.write('\n'.join([question, author, answer]))

fp.write('\n' + '****' * 50 + '\n')

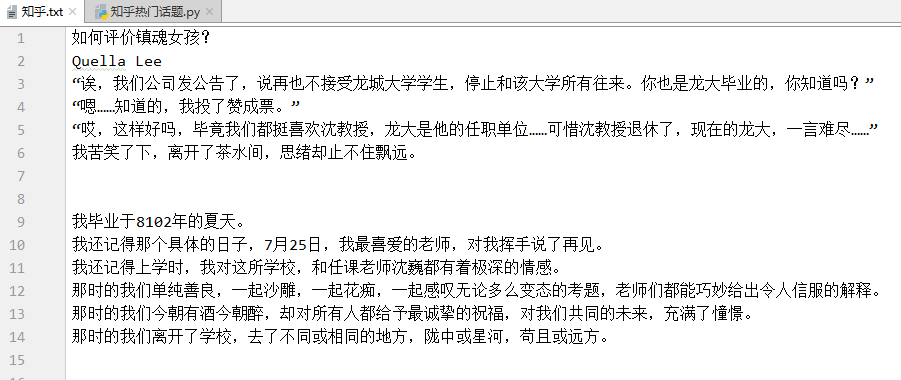

运行结果如下:

不过比较奇怪的地方是 url为今日最热和本月最热 所爬取的结果一模一样。。而且都只能爬下五个div里面的东西,可能是因为知乎是动态界面。需要用到selenium吧

还有就是

answer=pq(item.find('.content').html()).text()

#获取答案(老师写的没看懂,可能需要jquery知识)

这行代码没有看懂。。。。

还得学习jQuery

Python知乎热门话题爬取的更多相关文章

- Python知乎热门话题数据的爬取实战

import requestsfrom pyquery import PyQuery as pq url = 'https://www.zhihu.com/explore'headers = { 'u ...

- Python爬虫入门教程 26-100 知乎文章图片爬取器之二

1. 知乎文章图片爬取器之二博客背景 昨天写了知乎文章图片爬取器的一部分代码,针对知乎问题的答案json进行了数据抓取,博客中出现了部分写死的内容,今天把那部分信息调整完毕,并且将图片下载完善到代码中 ...

- Python爬虫——request实例:爬取网易云音乐华语男歌手top10歌曲

requests是python的一个HTTP客户端库,跟urllib,urllib2类似,但比那两个要简洁的多,至于request库的用法, 推荐一篇不错的博文:https://cuiqingcai. ...

- Python网络爬虫与如何爬取段子的项目实例

一.网络爬虫 Python爬虫开发工程师,从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页 ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- 转 Python爬虫实战一之爬取糗事百科段子

静觅 » Python爬虫实战一之爬取糗事百科段子 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致 ...

- Python爬虫:为什么你爬取不到网页数据

前言: 之前小编写了一篇关于爬虫为什么爬取不到数据文章(文章链接为:Python爬虫经常爬不到数据,或许你可以看一下小编的这篇文章), 但是当时小编也是胡乱编写的,其实里面有很多问题的,现在小编重新发 ...

- Python爬虫实战二之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 前言 亲爱的们,教程比较旧了,百度贴吧页面可能改版,可能代码不 ...

- 【学习笔记】Python 3.6模拟输入并爬取百度前10页密切相关链接

[学习笔记]Python 3.6模拟输入并爬取百度前10页密切相关链接 问题描述 通过模拟网页,实现百度搜索关键词,然后获得网页中链接的文本,与准备的文本进行比较,如果有相似之处则代表相关链接. me ...

随机推荐

- Ten C++11 Features Every C++ Developer Should Use

原版:http://www.codeproject.com/Articles/570638/Ten-Cplusplus-Features-Every-Cplusplus-Developer 译版:ht ...

- Python初学者第七天 字符串及简单操作

7day 数据类型:字符串 1.定义 字符串是一个有序的字符的集合,用于储存和表示基本的文本信息.单.双.三引号之间的内容称之为字符串: a = ‘hello world!’ b = "你好 ...

- 【深入理解JAVA虚拟机】第5部分.高效并发.2.线程安全和锁优化

1 概述 对于这部分的主题“高效并发”来讲,首先需要保证并发的正确性,然后在此基础上实现高效. 2 线程安全 <Java Concurrency In Practice> 的作者Brian ...

- February 1 2017 Week 5 Wednesday

If you can't get a miracle, become one. 如果奇迹没有眷顾你,那就让自己变成奇迹吧. If you think you are bad luck, you did ...

- 入门摄影——尼康DX

学习链接 单反应当怎样入门? - Williams的回答 - 知乎 [摄影教程]尼康数码单反相机使用视频教程_哔哩哔哩 (゜-゜)つロ 干杯~-bilibili 图像品质与图像大小 图像品质:暂选JP ...

- Kill占用指定端口的进程的方法

(1)查询占用指定端口进程的PID 打开cmd命令行,输入netstat -ano|findstr 8080(指定端口号) 最后一列即为占用该端口的进程的PID (2)KILL指定PID的进程 紧接着 ...

- @autoclosure-可以让表达式自动封装成一个闭包:输入的是一个表达式

@autoclosure 在闭包前面加上@autoclosure func or(first:Bool,@autoclosure second:()->Bool) -> Bool { if ...

- PHP-------- JQUERY方式

JQUERY方式 1.根据ID取元素,Jquery对象 var div = $("#one"); 2.根据class取 var div = $(".test&quo ...

- ResourceWarning: unclosed <socket.socket fd=864, family=AddressFamily.AF_INET, type=SocketKind.SOCK_STREAM, proto=0, laddr=('10.100.x.x', 37321), raddr=('10.1.x.x', 8500)>解决办法

将代码封装,并使用unittest调用时,返回如下警告: C:\python3.6\lib\collections\__init__.py:431: ResourceWarning: unclosed ...

- 论文笔记 | A Closer Look at Spatiotemporal Convolutions for Action Recognition

( 这篇博文为原创,如需转载本文请email我: leizhao.mail@qq.com, 并注明来源链接,THX!) 本文主要分享了一篇来自CVPR 2018的论文,A Closer Look at ...