[Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息

一、前言

之前使用原生的 Python 库去爬取网页信息,经常要使用正则表达式,笔者记性不是很好,经常经常忘记相关符号及其作用。

后来使用著名的 Scrapy 框架去爬取信息,感觉太笨重了,特别是一个项目开发到一半,要引入爬虫功能,再使用 Scrapy,就不是那么友好了,其本身就是一个 Web Project。

近来使用一个和之前 Java 爬虫特别简单好使的 Jsoup 框架极其类似的 Beautiful Soup

引入也很简单:

# Python 2+

pip install beautifulsoup4

# Python 3+

pip3 install beautifulsoup4- 1

- 2

- 3

- 4

- 5

使用 Python 爬虫体验当然是比 Java 要好,java开发有点 “做作” —— 每一步都极其格式化(面向对象),Python 则运用自如。

二、需求

现在要爬取 CSDN首页 的今日推荐的 文章 标题 及其 链接,

2.1.这是网页目标内容

2.2.这是网页目标内容对应的源码

三、实践

你猜需要多少行代码,没错,就这几行,就是这么牛逼。

因力求精简,笔者为此费了几个小时通读官方 API 文档数遍。

3.1.代码

from bs4 import BeautifulSoup

from urllib.request import urlopen

html = urlopen("https://www.csdn.net/").read().decode('utf-8')

soup = BeautifulSoup(html,"html.parser")

titles=soup.select("h3[class='company_name'] a") # CSS 选择器

for title in titles:

print(title.get_text(),title.get('href'))# 标签体、标签属性- 1

- 2

- 3

- 4

- 5

- 6

- 7

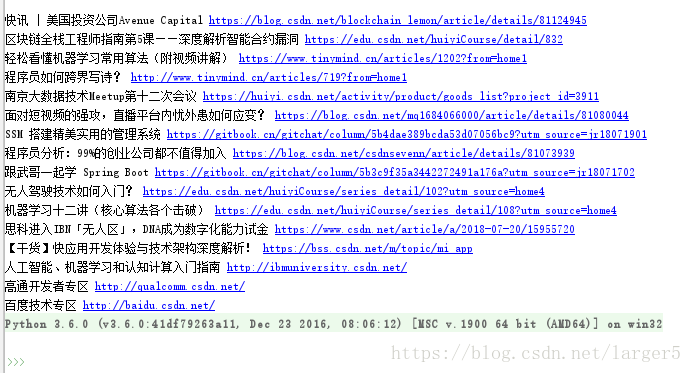

3.2.效果

四、小结

参考文献:

Beautiful Soup 中文文档

[Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息的更多相关文章

- python爬虫之Beautiful Soup基础知识+实例

python爬虫之Beautiful Soup基础知识 Beautiful Soup是一个可以从HTML或XML文件中提取数据的python库.它能通过你喜欢的转换器实现惯用的文档导航,查找,修改文档 ...

- Python爬虫之Beautiful Soup解析库的使用(五)

Python爬虫之Beautiful Soup解析库的使用 Beautiful Soup-介绍 Python第三方库,用于从HTML或XML中提取数据官方:http://www.crummv.com/ ...

- python 爬虫利器 Beautiful Soup

python 爬虫利器 Beautiful Soup Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文 ...

- Python爬虫教程-13-爬虫使用cookie爬取登录后的页面(人人网)(下)

Python爬虫教程-13-爬虫使用cookie爬取登录后的页面(下) 自动使用cookie的方法,告别手动拷贝cookie http模块包含一些关于cookie的模块,通过他们我们可以自动的使用co ...

- Python爬虫库-Beautiful Soup的使用

Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库,简单来说,它能将HTML的标签文件解析成树形结构,然后方便地获取到指定标签的对应属性. 如在上一篇文章通过爬虫 ...

- python爬虫之Beautiful Soup的基本使用

1.简介 简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据.官方解释如下: Beautiful Soup提供一些简单的.python式的函数用来处理导航.搜索 ...

- python标准库Beautiful Soup与MongoDb爬喜马拉雅电台的总结

Beautiful Soup标准库是一个可以从HTML/XML文件中提取数据的Python库,它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式,Beautiful Soup将会节省数小 ...

- python 爬虫5 Beautiful Soup的用法

1.创建 Beautiful Soup 对象 from bs4 import BeautifulSoup html = """ <html><head& ...

- Python爬虫实战(2):爬取京东商品列表

1,引言 在上一篇<Python爬虫实战:爬取Drupal论坛帖子列表>,爬取了一个用Drupal做的论坛,是静态页面,抓取比较容易,即使直接解析html源文件都可以抓取到需要的内容.相反 ...

随机推荐

- Go by Example-Switch分支结构

上一节提到了Go语言中的if/else结构,但是条件过多的时候就不适合用if语句了,这个时候我们就可以使用switch语句了. 基本特性 switch 是一个条件语句,用于将一个表达式的求值结果与可能 ...

- Filename too long Resolution

在git bash中,运行下列命令: git config --global core.longpaths true --global是该参数的使用范围,如果只对本版本库设置该参数,只要在上述命令中去 ...

- 配置 Ubuntu 服务器

Python: apt install python3-pip sudo add-apt-repository ppa:fkrull/deadsnakes sudo apt-get update ap ...

- Tosca new project Repository as MS SQL Server

# 然后对应的服务器就能自己给创建对应的数据库

- android studio: no idea annotations attached to the jdk 1.8 some issues will not be found

Android Studio今天早上打开项目提示错误信息: No IDEA annotations attached to the JDK 1.8 (C:\Program Files\Android\ ...

- LC 516. Longest Palindromic Subsequence

Given a string s, find the longest palindromic subsequence's length in s. You may assume that the ma ...

- 阶段5 3.微服务项目【学成在线】_day18 用户授权_17-细粒度授权-获取当前用户信息

3.4.1需求分析 要想实现只查询自己的课程信息则需要获取当前用户所属的企业id. 1.认证服务在用户认证通过将用户所属公司id等信息存储到jwt令牌中. 2.用户请求到达资源服务后,资源服务需要取出 ...

- 阶段5 3.微服务项目【学成在线】_day17 用户认证 Zuul_11-前端显示当前用户-前端请求jwt

前端代码 sessionStorage也是key/value的格式 页头显示当前用户 查询jwt nginx里面的配置 测试 开启认证服务 进行登陆 跳转到首页就应该立即请求查询. 跳转到首页 coo ...

- JS 时间处理(GMT转换,超24小时加一天,时间差计算)

计算天数,加小时,加分数 Date.prototype.Format = function (fmt) { // author: meizz var o = { "M+": thi ...

- vmware虚拟机网络不通原因之一

我是在华硕笔记本上安装的vmware workstation.而且我用虚拟机的网络模式喜欢选“桥接”模式. 最近在虚拟上做实验,打开虚拟机windows 2003后,网卡配置静态ip后显示状态正常,但 ...