吴裕雄 python 爬虫(1)

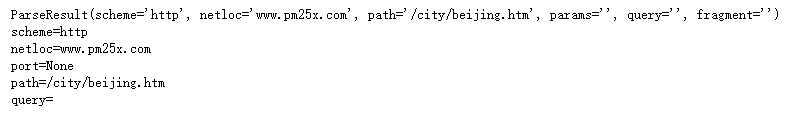

from urllib.parse import urlparse url = 'http://www.pm25x.com/city/beijing.htm'

o = urlparse(url)

print(o) print("scheme={}".format(o.scheme)) # http

print("netloc={}".format(o.netloc)) # www.pm25x.com

print("port={}".format(o.port)) # None

print("path={}".format(o.path)) # /city/beijing.htm

print("query={}".format(o.query)) # 空

import requests url = 'http://www.wsbookshow.com/'

html = requests.get(url)

html.encoding="GBK"

print(html.text)

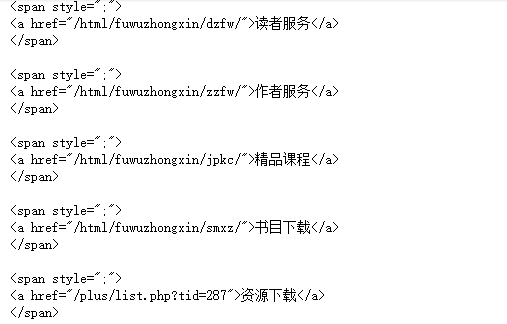

import requests url = 'http://www.wsbookshow.com/'

html = requests.get(url)

html.encoding="gbk" htmllist = html.text.splitlines()

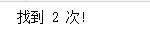

n=0

for row in htmllist:

if "新概念" in row:

n+=1

print("找到 {} 次!".format(n))

import re

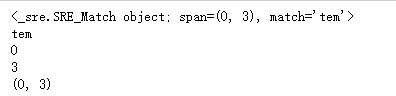

pat = re.compile('[a-z]+') m = pat.match('tem12po')

print(m) if not m==None:

print(m.group())

print(m.start())

print(m.end())

print(m.span())

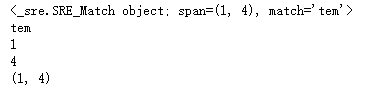

import re

m = re.match(r'[a-z]+','tem12po')

print(m) if not m==None:

print(m.group())

print(m.start())

print(m.end())

print(m.span())

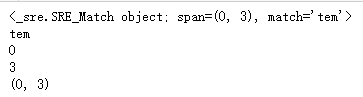

import re

pat = re.compile('[a-z]+')

m = pat.search('3tem12po')

print(m) # <_sre.SRE_Match object; span=(1, 4), match='tem'>

if not m==None:

print(m.group()) # tem

print(m.start()) #

print(m.end()) #

print(m.span()) # (1,4)

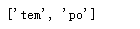

import re

pat = re.compile('[a-z]+') m = pat.findall('tem12po')

print(m) # ['tem', 'po']

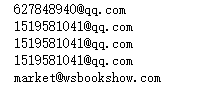

import requests,re

regex = re.compile('[a-zA-Z0-9_.+-]+@[a-zA-Z0-9-]+\.[a-zA-Z0-9-.]+')

url = 'http://www.wsbookshow.com/'

html = requests.get(url)

emails = regex.findall(html.text)

for email in emails:

print(email)

吴裕雄 python 爬虫(1)的更多相关文章

- 吴裕雄 python 爬虫(4)

import requests user_agent = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)AppleWebKit/537.36 (KHTML, li ...

- 吴裕雄 python 爬虫(3)

import hashlib md5 = hashlib.md5() md5.update(b'Test String') print(md5.hexdigest()) import hashlib ...

- 吴裕雄 python 爬虫(2)

import requests from bs4 import BeautifulSoup url = 'http://www.baidu.com' html = requests.get(url) ...

- 吴裕雄--python学习笔记:爬虫基础

一.什么是爬虫 爬虫:一段自动抓取互联网信息的程序,从互联网上抓取对于我们有价值的信息. 二.Python爬虫架构 Python 爬虫架构主要由五个部分组成,分别是调度器.URL管理器.网页下载器.网 ...

- 吴裕雄--python学习笔记:爬虫包的更换

python 3.x报错:No module named 'cookielib'或No module named 'urllib2' 1. ModuleNotFoundError: No module ...

- 吴裕雄--python学习笔记:爬虫

import chardet import urllib.request page = urllib.request.urlopen('http://photo.sina.com.cn/') #打开网 ...

- 吴裕雄 python 神经网络——TensorFlow pb文件保存方法

import tensorflow as tf from tensorflow.python.framework import graph_util v1 = tf.Variable(tf.const ...

- 吴裕雄 python 神经网络——TensorFlow 花瓣分类与迁移学习(4)

# -*- coding: utf-8 -*- import glob import os.path import numpy as np import tensorflow as tf from t ...

- 吴裕雄 python 神经网络——TensorFlow 花瓣分类与迁移学习(3)

import glob import os.path import numpy as np import tensorflow as tf from tensorflow.python.platfor ...

随机推荐

- C#中唯一的三元运算符

条件运算符?:接受三个操作数,是C#中唯一的三元运算符 ; ? : ; //转换成if选择结果如下 ) { j = ; } else { j = ; } 需要根据还可以嵌套三元运算符 ; ) ? : ...

- REST framwork之认证,权限与频率

认证组件 局部视图认证 在app01.service.auth.py: class Authentication(BaseAuthentication): def authenticate(self, ...

- 为什么TCP比UDP可靠真正原因,以及并发编程的基础问题

一 为什么TCP协议比UDP协议传输数据可靠: 我们知道在传输数据的时候,数据是先存在操作系统的缓存中,然后发送给客户端,在客户端也是要经过客户端的操作系统的,因为这个过程涉及到计算机硬件,也就是物 ...

- SOA, EDA, 和 ESB

SOA----面向服务架构,实际上强调的是软件的一种架构,一种支撑软件运行的相对稳定的结构,表面含义如此,其实SOA是一种通过服务整合来解决系统集成的一种思想.不是具体的技术,本质上是一种策略.思想. ...

- angularjs探秘<二>表达式、指令、数据绑定

距离第一篇笔记好久了,抽空把angular的笔记梳理梳理. ng-init:初始化指令,这里可以声明变量,且变量不用指定数据类型(类似js中的var用法). 数值变量与字符串相加默认做字符串拼接运算. ...

- QT学习之QT5.7+opencv3.1安装及显示图像

如果有时间就按照这篇博文一步一步走: http://www.cnblogs.com/howlclat/p/6433097.html, 如果没时间: 直接下载最后的文件就可以了,不要浪费时间再去编译,真 ...

- TessorFlow学习 之 序言

2017.10.23日记录: 感觉平时自己学的还不错的,可是面试的时候才发现自己是个渣渣~~,真的感觉学习不能闭门造车! 面试了图像处理算法工程师-->> 1.精通哪门语言?C.C++.P ...

- concurrent.futures模块 -----进程池 ---线程池 ---回调

concurrent.futures模块提供了高度封装的异步调用接口,它内部有关的两个池 ThreadPoolExecutor:线程池,提供异步调用,其基础就是老版的Pool ProcessPoolE ...

- ES6数组的新增功能,还是很强大的好多地方用的到

map,reduce,filter ,forEach 废话不多说代码走起 map 映射 就是一个对一个 /* 比如:学生成绩分数对应及格不及格 也可以做一些算数运算 */ let chengji ...

- 使用NetBox实现ASP网页封装为EXE教程

简单的形容就是把ASP文件打包 成一个EXE文件,并且不需要在调试的机器上安装IIS即可正常调试.如果按照说明书来操作的话,观看比较繁琐,本人为方便大家使用,现制作一个简单的使用教程. 封装过程 1. ...