python爬虫从入门到放弃(五)之 正则的基本使用(转)

什么是正则表达式

正则表达式是对字符串操作的一种逻辑公式,就是 事先定义好的一些特定字符、及这些特定字符的组合,组成一个“规则字符”,这个“规则字符” 来表达对字符的一种过滤逻辑。

正则并不是python独有的,其他语言也都有正则

python中的正则,封装了re模块

python正则的详细讲解

常用的匹配模式

\w 匹配字母数字及下划线

\W 匹配f非字母数字下划线

\s 匹配任意空白字符,等价于[\t\n\r\f]

\S 匹配任意非空字符

\d 匹配任意数字

\D 匹配任意非数字

\A 匹配字符串开始

\Z 匹配字符串结束,如果存在换行,只匹配换行前的结束字符串

\z 匹配字符串结束

\G 匹配最后匹配完成的位置

\n 匹配一个换行符

\t 匹配一个制表符

^ 匹配字符串的开头

$ 匹配字符串的末尾

. 匹配任意字符,除了换行符,re.DOTALL标记被指定时,则可以匹配包括换行符的任意字符

[....] 用来表示一组字符,单独列出:[amk]匹配a,m或k

[^...] 不在[]中的字符:[^abc]匹配除了a,b,c之外的字符

* 匹配0个或多个的表达式

+ 匹配1个或者多个的表达式

? 匹配0个或1个由前面的正则表达式定义的片段,非贪婪方式

{n} 精确匹配n前面的表示

{m,m} 匹配n到m次由前面的正则表达式定义片段,贪婪模式

a|b 匹配a或者b

() 匹配括号内的表达式,也表示一个组

re.match()

尝试从字符串的起始位置匹配一个模式,如果不是起始位置匹配的话,match()就会返回None

语法格式:

re.match(pattern,string,flags=0)

最常规的匹配

import re content= "hello 123 4567 World_This is a regex Demo"

result = re.match('^hello\s\d\d\d\s\d{4}\s\w{10}.*Demo$',content)

print(result)

print(result.group())

print(result.span())

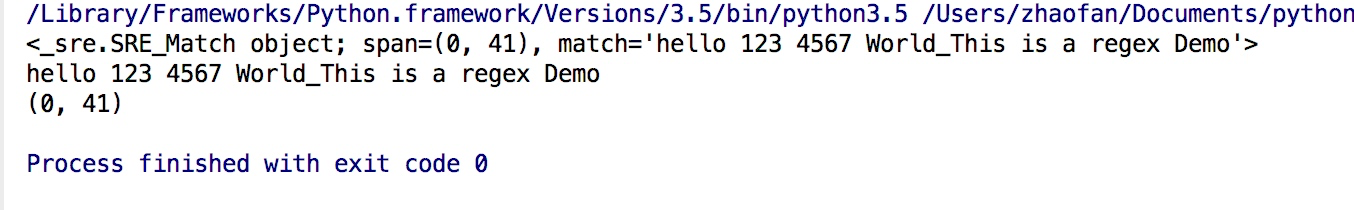

结果如下:

result.group()获取匹配的结果

result.span()获去匹配字符串的长度范围

泛匹配

其实相对来说上面的方式并不是非常方便,其实可以将上述的正则规则进行更改

import re content= "hello 123 4567 World_This is a regex Demo"

result = re.match("^hello.*Demo$",content)

print(result)

print(result.group())

print(result.span())

这段代码的结果和上面常规匹配的结果是一样的,但是写起来会方便很多

匹配目标

如果为了匹配字符串中具体的目标,则需要通过()括起来,例子如下:

import re

content= "hello 1234567 World_This is a regex Demo"

result = re.match('^hello\s(\d+)\sWorld.*Demo$',content)

print(result)

print(result.group())

print(result.group(1))

print(result.span())

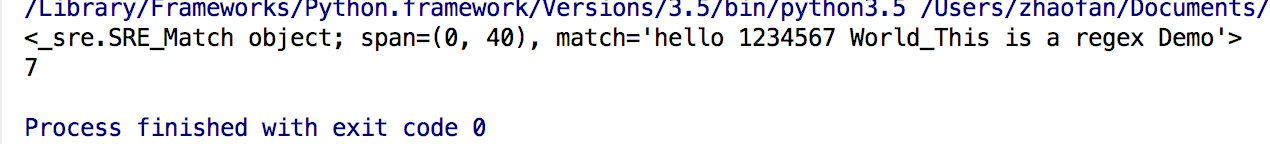

结果如下:

这里需要说一下的是通过re.group()获得结果后,如果正则表达式中有括号,则re.group(1)获取的就是第一个括号中匹配的结果

贪婪匹配

先看下面代码:

import re content= "hello 1234567 World_This is a regex Demo"

result= re.match('^hello.*(\d+).*Demo',content)

print(result)

print(result.group(1))

这段代码的结果是

从结果中可以看出只匹配到了7,并没有匹配到1234567,出现这种情况的原因是前面的.* 给匹配掉了, .*在这里会尽可能的匹配多的内容,也就是我们所说的贪婪匹配,

如果我们想要匹配到1234567则需要将正则表达式改为:

result= re.match('^he.*?(\d+).*Demo',content)

这样结果就可以匹配到1234567

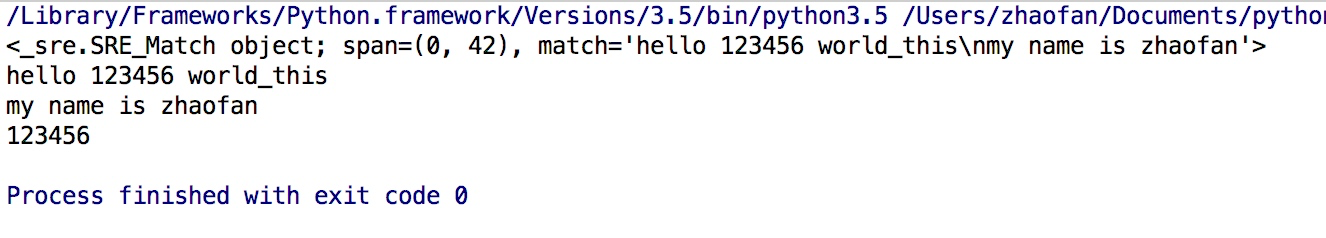

匹配模式

很多时候匹配的内容是存在换行的问题的,这个时候的就需要用到匹配模式re.S来匹配换行的内容

import re content = """hello 123456 world_this

my name is zhaofan

""" result =re.match('^he.*?(\d+).*?zhaofan$',content,re.S)

print(result)

print(result.group())

print(result.group(1))

结果如下

转义

当我们要匹配的内容中存在特殊字符的时候,就需要用到转移符号\,例子如下:

import re

content= "price is $5.00"

result = re.match('price is \$5\.00',content)

print(result)

print(result.group())

对上面的一个小结:

尽量使用泛匹配,使用括号得到匹配目标,尽量使用非贪婪模式,有换行符就用re.S

强调re.match是从字符串的起始位置匹配一个模式

re.search

re.search扫描整个字符串返回第一个成功匹配的结果

import re

content = "extra things hello 123455 world_this is a Re Extra things"

result = re.search("hello.*?(\d+).*?Re",content)

print(result)

print(result.group())

print(result.group(1))

结果如下:

其实这个时候我们就不需要在写^以及$,因为search是扫描整个字符串

注意:所以为了匹配方便,我们会更多的用search,不用match,match必须匹配头部,所以很多时候不是特别方便

匹配演练

例子1:

import re html = '''<div id="songs-list">

<h2 class="title">经典老歌</h2>

<p class="introduction">

经典老歌列表

</p>

<ul id="list" class="list-group">

<li data-view="2">一路上有你</li>

<li data-view="7">

<a href="/2.mp3" singer="任贤齐">沧海一声笑</a>

</li>

<li data-view="4" class="active">

<a href="/3.mp3" singer="齐秦">往事随风</a>

</li>

<li data-view="6"><a href="/4.mp3" singer="beyond">光辉岁月</a></li>

<li data-view="5"><a href="/5.mp3" singer="陈慧琳">记事本</a></li>

<li data-view="5">

<a href="/6.mp3" singer="邓丽君">但愿人长久</a>

</li>

</ul>

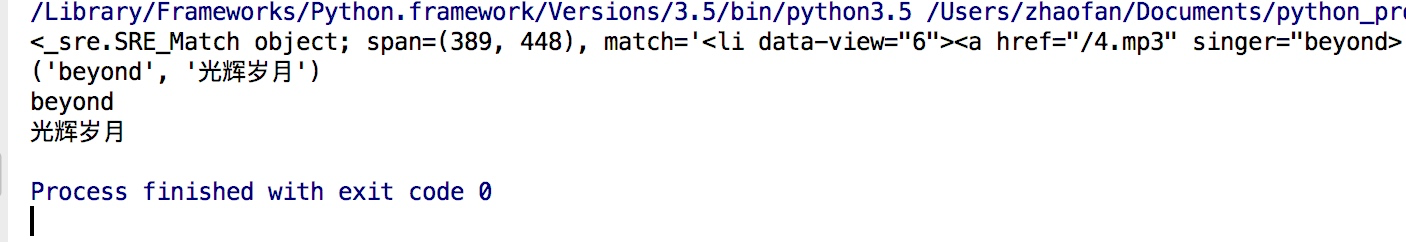

</div>''' result = re.search('<li.*?active.*?singer="(.*?)">(.*?)</a>',html,re.S)

print(result)

print(result.groups())

print(result.group(1))

print(result.group(2))

结果为:

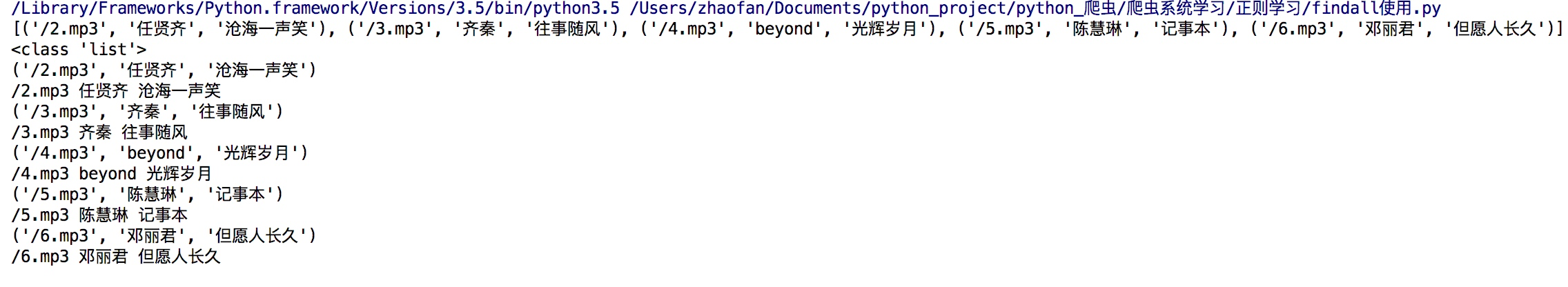

re.findall

搜索字符串,以列表的形式返回全部能匹配的子串

代码例子如下:

import re html = '''<div id="songs-list">

<h2 class="title">经典老歌</h2>

<p class="introduction">

经典老歌列表

</p>

<ul id="list" class="list-group">

<li data-view="2">一路上有你</li>

<li data-view="7">

<a href="/2.mp3" singer="任贤齐">沧海一声笑</a>

</li>

<li data-view="4" class="active">

<a href="/3.mp3" singer="齐秦">往事随风</a>

</li>

<li data-view="6"><a href="/4.mp3" singer="beyond">光辉岁月</a></li>

<li data-view="5"><a href="/5.mp3" singer="陈慧琳">记事本</a></li>

<li data-view="5">

<a href="/6.mp3" singer="邓丽君">但愿人长久</a>

</li>

</ul>

</div>''' results = re.findall('<li.*?href="(.*?)".*?singer="(.*?)">(.*?)</a>', html, re.S)

print(results)

print(type(results))

for result in results:

print(result)

print(result[0], result[1], result[2])

结果如下:

例子2:

import re html = '''<div id="songs-list">

<h2 class="title">经典老歌</h2>

<p class="introduction">

经典老歌列表

</p>

<ul id="list" class="list-group">

<li data-view="2">一路上有你</li>

<li data-view="7">

<a href="/2.mp3" singer="任贤齐">沧海一声笑</a>

</li>

<li data-view="4" class="active">

<a href="/3.mp3" singer="齐秦">往事随风</a>

</li>

<li data-view="6"><a href="/4.mp3" singer="beyond">光辉岁月</a></li>

<li data-view="5"><a href="/5.mp3" singer="陈慧琳">记事本</a></li>

<li data-view="5">

<a href="/6.mp3" singer="邓丽君">但愿人长久</a>

</li>

</ul>

</div>''' results = re.findall('<li.*?>\s*?(<a.*?>)?(\w+)(</a>)?\s*?</li>',html,re.S)

print(results)

for result in results:

print(result[1])

结果如下:

其实这里我们就可以看出

\s*? 这种用法其实就是为了解决有的有换行,有的没有换行的问题

(<a.*?>)? 这种用法是因为html中有的有a标签,有的没有的,?表示匹配一个或0个,正好可以用于匹配

re.sub

替换字符串中每一个匹配的子串后返回替换后的字符串

re.sub(正则表达式,替换成的字符串,原字符串)

例子1

import re

content = "Extra things hello 123455 World_this is a regex Demo extra things"

content = re.sub('\d+','',content)

print(content)

结果会讲数字替换为为空:

例子2,在有些情况下我们替换字符的时候,还想获取我们匹配的字符串,然后在后面添加一些内容,可以通过下面方式实现:

import re

content = "Extra things hello 123455 World_this is a regex Demo extra things"

content = re.sub('(\d+)',r'\1 7890',content)

print(content)

结果如下:

这里需要注意的一个问题是\1是获取第一个匹配的结果,为了防止转义字符的问题,我们需要在前面加上r

re.compile

将正则表达式编译成正则表达式对象,方便复用该正则表达式

import re

content= """hello 12345 world_this

123 fan

""" pattern =re.compile("hello.*fan",re.S) result = re.match(pattern,content)

print(result)

print(result.group())

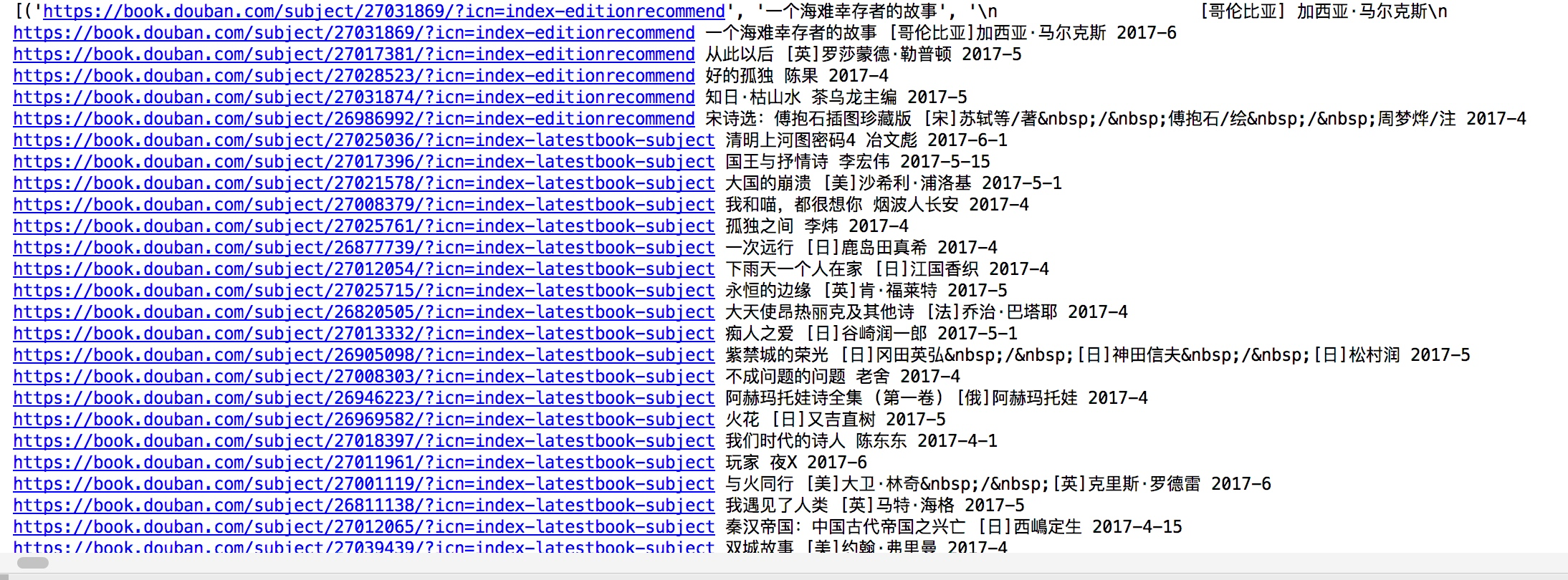

正则的综合练习

获取豆瓣网书籍的页面的书籍信息,通过正则实现

import requests

import re

content = requests.get('https://book.douban.com/').text

pattern = re.compile('<li.*?cover.*?href="(.*?)".*?title="(.*?)".*?more-meta.*?author">(.*?)</span>.*?year">(.*?)</span>.*?</li>', re.S)

results = re.findall(pattern, content)

print(results) for result in results:

url,name,author,date = result

author = re.sub('\s','',author)

date = re.sub('\s','',date)

print(url,name,author,date)

结果如下:

原文地址 http://www.cnblogs.com/zhaof/p/6925674.html

python爬虫从入门到放弃(五)之 正则的基本使用(转)的更多相关文章

- python爬虫从入门到放弃前奏之学习方法

首谈方法 最近在整理爬虫系列的博客,但是当整理几篇之后,发现一个问题,不管学习任何内容,其实方法是最重要的,按照我之前写的博客内容,其实学起来还是很点枯燥不能解决传统学习过程中的几个问题: 这个是普通 ...

- python爬虫从入门到放弃(五)之 正则的基本使用

什么是正则表达式 正则表达式是对字符串操作的一种逻辑公式,就是 事先定义好的一些特定字符.及这些特定字符的组合,组成一个"规则字符",这个"规则字符" 来表达对 ...

- Python爬虫从入门到放弃(十五)之 Scrapy框架中Spiders用法

Spider类定义了如何爬去某个网站,包括爬取的动作以及如何从网页内容中提取结构化的数据,总的来说spider就是定义爬取的动作以及分析某个网页 工作流程分析 以初始的URL初始化Request,并设 ...

- python爬虫从入门到放弃(三)之 Urllib库的基本使用

官方文档地址:https://docs.python.org/3/library/urllib.html 什么是Urllib Urllib是python内置的HTTP请求库包括以下模块urllib.r ...

- python爬虫从入门到放弃(四)之 Requests库的基本使用

什么是Requests Requests是用python语言基于urllib编写的,采用的是Apache2 Licensed开源协议的HTTP库如果你看过上篇文章关于urllib库的使用,你会发现,其 ...

- python爬虫从入门到放弃(六)之 BeautifulSoup库的使用

上一篇文章的正则,其实对很多人来说用起来是不方便的,加上需要记很多规则,所以用起来不是特别熟练,而这节我们提到的beautifulsoup就是一个非常强大的工具,爬虫利器. beautifulSoup ...

- python爬虫从入门到放弃(八)之 Selenium库的使用

一.什么是Selenium selenium 是一套完整的web应用程序测试系统,包含了测试的录制(selenium IDE),编写及运行(Selenium Remote Control)和测试的并行 ...

- Python爬虫从入门到放弃(十一)之 Scrapy框架整体的一个了解

这里是通过爬取伯乐在线的全部文章为例子,让自己先对scrapy进行一个整理的理解 该例子中的详细代码会放到我的github地址:https://github.com/pythonsite/spider ...

- Python爬虫从入门到放弃(十二)之 Scrapy框架的架构和原理

这一篇文章主要是为了对scrapy框架的工作流程以及各个组件功能的介绍 Scrapy目前已经可以很好的在python3上运行Scrapy使用了Twisted作为框架,Twisted有些特殊的地方是它是 ...

随机推荐

- Linux入门——SSH免密登录

SSH免密登录 1.简介 SSH是一种网络协议,用于计算机之间的加密登录. 本文针对的实现是OpenSSH,它是自由软件,应用非常广泛. 2.初始化公钥私钥 有rsa,dsa两种加密方式,生成的公钥私 ...

- DQL数据查询

set hive.fetch.task.conversion=more; -- 避免触发MR job select distinct name from employee_id limit 2; -- ...

- 『Python基础-6』if语句, if-else语句

# 『Python基础-6』if语句, if-else语句 目录: 条件测试 if语句 if-else语句 1. 条件测试 每条if语句的核心都是一个值为True或False的表达式,这种表达式被称为 ...

- rtsp over tcp并设置多个options

版权声明:本文为博主原创文章,未经博主允许不得转载. var vlc=document.getElementById("vlc"); var options = new Array ...

- centos下安装python的过程

Linux下默认系统自带python2.6的版本,这个版本被系统很多程序所依赖,所以不建议删除,如果使用最新的Python3那么我们知道编译安装源码包和系统默认包之间是没有任何影响的,所以可以安装py ...

- 成都Uber优步司机奖励政策(3月17日)

滴快车单单2.5倍,注册地址:http://www.udache.com/ 如何注册Uber司机(全国版最新最详细注册流程)/月入2万/不用抢单:http://www.cnblogs.com/mfry ...

- Intellij打包jar文件,“java.lang.SecurityException: Invalid signature file digest for Manifest main attrib

下面是使用Intellij 打包jar文件的步骤,之后会有运行jar文件时遇到的错误. 打包完成. ================================================== ...

- Git学习系列 (二)

#克隆目录并重命名为newname,默认目录名是使用.git前的grit git clone git://github.com/schacon/grit.git newname #将所有已经跟踪过的文 ...

- ajax跨域请求php

在众多站群中,不同功能的系统使用独立的一个域名,各系统之间存在相互调用的关系.使用js的XMLHttpRequest调用其他域名提示跨域权限不足.有些可能认为都同属于同一个顶级域名或者说域名一模一样怎 ...

- 基于Spring的最简单的定时任务实现与配置(二)

接上一篇,原本我以为我实现的方式很简单了,在准备写(一)的时候,就去查了查别人是怎么实现定时任务的.不查还好,这一查,发现还有更简单的.所以就会有这篇文章. 本文主要是讨论,在完成Spring 项目搭 ...