scrapy练习1

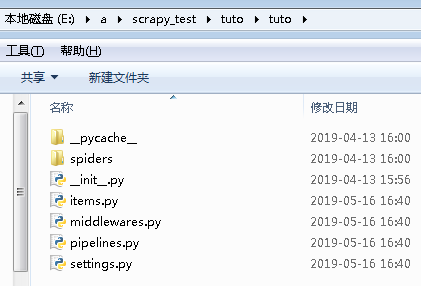

1.建立项目:

#建立名为tuto的项目

scrapy startproject tuto

2.进入项目目录:

cd tuto

3.建立域名任务:

#minyan任务名;后面是任务对应的域名

scrapy genspider minyan quotes.toscrape.com

cmd全程记录:

E:\a\scrapy_test>scrapy startproject tuto

New Scrapy project 'tuto', using template directory 'c:\python\python37\lib\site

-packages\scrapy\templates\project', created in:

E:\a\scrapy_test\tuto You can start your first spider with:

cd tuto

scrapy genspider example example.com E:\a\scrapy_test>cd tuto E:\a\scrapy_test\tuto>scrapy genspider minyan quotes.toscrape.com

Created spider 'minyan' using template 'basic' in module:

tuto.spiders.minyan E:\a\scrapy_test\tuto>

4.pycharm打开项目,建立用于调试的文件:main.py

用到的函数解析:https://www.cnblogs.com/chenxi188/p/10876690.html

main.py:

# -*- coding: utf-8 -*-

__author__='pasaulis'

import sys,os

from scrapy.cmdline import execute #获取到当前目录,添加到环境变量,方便运行cmd不必再去找目录

#.append()添加到环境变量;.dirname()输出不含文件名的路径;.abspath(__file__)得到当前文件的绝对路径

sys.path.append(os.path.dirname(os.path.abspath(__file__))) #调用命令运行爬虫scrapy crawl 爬虫名minyan.py中(name的值)

execute(["scrapy","crawl","minyan"])

查看页面,确定需要解析哪些数据,在items.py里写出:

import scrapy class TutoItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

text=scrapy.Field()

author=scrapy.Field()

tags=scrapy.Field()

#pass

minyan.py:

# -*- coding: utf-8 -*-

import scrapy

from tuto.items import TutoItem #从tuto文件夹下的items.py导入其中的类TutoItem用于创建列表 class MinyanSpider(scrapy.Spider):

name = 'minyan'

allowed_domains = ['quotes.toscrape.com']

start_urls = ['http://quotes.toscrape.com/'] def parse(self, response):

quotes=response.css('.quote')

for quote in quotes:

item=TutoItem()

item['text']=quote.css('.text::text').extract_first()

item['author']=quote.css('.author::text').extract_first()

item['tags']=quote.css('.keywords::attr(content)').extract_first()

yield item #下一页

next=response.css('.next > a::attr(href)').extract_first()

url=response.urljoin(next) #补全网址

yield scrapy.Request(url=url,callback=self.parse) #请求下一页,并回调自身方法

settings.py把此条改为false

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

运行代码:

在pycharm最下terminal里: scrapy crawl mingyan

或main.py里运行

scrapy练习1的更多相关文章

- Scrapy框架爬虫初探——中关村在线手机参数数据爬取

关于Scrapy如何安装部署的文章已经相当多了,但是网上实战的例子还不是很多,近来正好在学习该爬虫框架,就简单写了个Spider Demo来实践.作为硬件数码控,我选择了经常光顾的中关村在线的手机页面 ...

- scrapy爬虫docker部署

spider_docker 接我上篇博客,为爬虫引用创建container,包括的模块:scrapy, mongo, celery, rabbitmq,连接https://github.com/Liu ...

- scrapy 知乎用户信息爬虫

zhihu_spider 此项目的功能是爬取知乎用户信息以及人际拓扑关系,爬虫框架使用scrapy,数据存储使用mongo,下载这些数据感觉也没什么用,就当为大家学习scrapy提供一个例子吧.代码地 ...

- ubuntu 下安装scrapy

1.把Scrapy签名的GPG密钥添加到APT的钥匙环中: sudo apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --recv 6272 ...

- 网络爬虫:使用Scrapy框架编写一个抓取书籍信息的爬虫服务

上周学习了BeautifulSoup的基础知识并用它完成了一个网络爬虫( 使用Beautiful Soup编写一个爬虫 系列随笔汇总 ), BeautifulSoup是一个非常流行的Python网 ...

- Scrapy:为spider指定pipeline

当一个Scrapy项目中有多个spider去爬取多个网站时,往往需要多个pipeline,这时就需要为每个spider指定其对应的pipeline. [通过程序来运行spider],可以通过修改配置s ...

- scrapy cookies:将cookies保存到文件以及从文件加载cookies

我在使用scrapy模拟登录新浪微博时,想将登录成功后的cookies保存到本地,下次加载它实现直接登录,省去中间一系列的请求和POST等.关于如何从本次请求中获取并在下次请求中附带上cookies的 ...

- Scrapy开发指南

一.Scrapy简介 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中. Scrapy基于事件驱动网络框架 Twis ...

- 利用scrapy和MongoDB来开发一个爬虫

今天我们利用scrapy框架来抓取Stack Overflow里面最新的问题(),并且将这些问题保存到MongoDb当中,直接提供给客户进行查询. 安装 在进行今天的任务之前我们需要安装二个框架,分别 ...

- python3 安装scrapy

twisted(网络异步框架) wget https://pypi.python.org/packages/dc/c0/a0114a6d7fa211c0904b0de931e8cafb5210ad82 ...

随机推荐

- 如何形成自己的的绘画风格?/ Bookness插画教程分享

搬运地址 :http://wemedia.ifeng.com/46042525/wemedia.shtml ---------------------------------------------- ...

- BBS那些事儿

目录 1 注册 2 登陆 3 图片验证码相关 4 首页相关,Django Admin后台录入数据 5 注销功能 6 修改密码 7 用户头像展示,media配置 8 个人站点,个人侧边栏 9 侧边栏筛选 ...

- 数据结构——KMP(串)

KMP一个非常经典的字符串模式匹配算法,虽然网上有很多kmp算法的博客,但是为了更好的理解kmp我还是自己写了一遍(这个kmp的字符串存储是基于堆的(heap),和老师说的定长存储略有不同,字符串索引 ...

- decodeURIComponent 测试

var test1="http://www.wljcz.com/My first/"; var nn=encodeURI(test1); var now=decodeURI(tes ...

- spring mvc绑定参数之日期类型转换

问题复现步骤: 1.提交表单,参数为: 2.接收参数类型为product实体类,如下 3.错误日志如下: org.springframework.validation.BindException: o ...

- oracle数据泵导出导入

先创建一个目录:比如 Create or Replace directory DATA_PUMP_DIR as 'D:\DataPipe'; 然后给导入导出的用户赋权限: Grant read ...

- 导出execl

string filepath = Utils.GetMapPath("/upload/excel/"); filepath = filepath + fileName + &qu ...

- java基础源码 (3)--Annotation(注解)

借鉴博客地址:https://www.cnblogs.com/skywang12345/p/3344137.html /** * The common interface extended by al ...

- 【剑指Offer】面试题03. 数组中重复的数字

题目 找出数组中重复的数字. 在一个长度为 n 的数组 nums 里的所有数字都在 0-n-1 的范围内.数组中某些数字是重复的,但不知道有几个数字重复了,也不知道每个数字重复了几次.请找出数组中任意 ...

- 进度5_家庭记账本App_数据库的添加和查看

今天继续在昨天的基础上完成了家庭记账单的在数据库中的添加和查看功能 在之前的基础上舍弃了Fragment,重新在百度上找到了学习资料,并且自我完成了实践 首先在之前的基础上创建CostListAdap ...