使用nodejs的puppeteer库爬取瓜子二手车网站

const puppeteer = require('puppeteer');

(async () => {

const fs = require("fs");

const rootUrl = 'https://www.guazi.com'

const workPath = './contents';

if (!fs.existsSync(workPath)) {

fs.mkdirSync(workPath)

}

const browser = await (puppeteer.launch({ headless: false }));

const page = await browser.newPage()

await page.setViewport({ width: 1128, height: 736 });

await page.setRequestInterception(true); // 拦截器

page.on('request', request => { //拦截图片

if (request.resourceType() === 'image')

request.abort();

else

request.continue();

});

await page.goto("https://www.guazi.com/fuzhou/buy")

const m_cityList = await page.evaluate(() => { // 获取所有城市

const elements = Array.from(document.querySelectorAll('.all-city dl'))

return elements.map(s => {

let dd = s.getElementsByTagName("dd").item(0)

let ddList = []

for (let i = 0; i < dd.getElementsByTagName("a").length; i++) {

ddList.push({

"cityName": dd.getElementsByTagName("a").item(i).innerHTML,

"url": dd.getElementsByTagName("a").item(i).getAttribute("href")

})

}

return ddList

})

})

//数组扁平化

const flattenNew = arr => arr.reduce((prev, next) => Object.prototype.toString.call(next) == '[object Array]' ? prev.concat(flattenNew(next)) : prev.concat(next), [])

const cityList = flattenNew(m_cityList)

console.log("城市列表爬取完毕")

await page.waitFor(2000 + Math.round(Math.random() * 100))

for (let i = 0; i < cityList.length; i++) {

await page.waitFor(1000 + Math.round(Math.random() * 100))

await page.goto(rootUrl + cityList[i].url)

console.log("跳转到" + cityList[i].cityName)

console.log("开始爬取" + cityList[i].cityName + "的所有二手车品牌")

try {

let brandList = await page.evaluate(() => { //品牌

let Array = []

const dl = document.querySelectorAll('.screen').item(0).getElementsByTagName("dl")

const div = dl.item(0).getElementsByTagName("dd").item(0).getElementsByTagName("div").item(1)

const ul = div.getElementsByTagName("ul")

for (let i = 0; i < ul.length; i++) {

let li = ul.item(i).getElementsByTagName("li")

for (let j = 0; j < li.length; j++) {

let a = li.item(j).getElementsByTagName("p").item(0).getElementsByTagName("a")

for (let k = 0; k < a.length; k++) {

Array.push({

"brand": a.item(k).innerHTML,

"url": a.item(k).getAttribute("href")

})

}

}

}

return Array

})

console.log(cityList[i].cityName + "的所有二手车品牌爬取完毕")

for (let j = 0; j < brandList.length; j++) {

console.log("开始爬取" + cityList[i].cityName + "-" + brandList[j].brand + "的所有车系")

await page.waitFor(1000 + Math.round(Math.random() * 100))

await page.goto(rootUrl + brandList[j].url)

try {

const carTypeList = await page.evaluate(() => { //车型

let Array = []

const dl = document.querySelectorAll('.screen').item(0).getElementsByTagName("dl")

const div = dl.item(1).getElementsByTagName("dd").item(0).getElementsByTagName("div").item(1)

const li = div.getElementsByTagName("ul").item(0).getElementsByTagName("li")

for (let j = 0; j < li.length; j++) {

let a = li.item(j).getElementsByTagName("p").item(0).getElementsByTagName("a")

for (let k = 0; k < a.length; k++) {

Array.push({

"carType": a.item(k).innerHTML.replace(/\s*/g, ""),

"url": a.item(k).getAttribute("href")

})

}

}

return Array

})

console.log(cityList[i].cityName + "-" + brandList[j].brand + "的所有车系爬取完毕")

for (let k = 0; k < carTypeList.length; k++) {

await page.waitFor(1000 + Math.round(Math.random() * 100))

console.log("开始爬取" + cityList[i].cityName + "-" + brandList[j].brand + "-" + carTypeList[k].carType + "的所有二手车")

let newUrl = rootUrl + carTypeList[k].url

pathArray = newUrl.split("/") //拿到第一页url,得到后面的页面的url

let urlArray = []

try {

await page.goto(newUrl)

const pageNum = await page.evaluate(() => { //获取总页数

let li = document.querySelectorAll("ul.pageLink").item(0).getElementsByTagName("li")

let liNum = li.length

return li.item(li.length - 2).getElementsByTagName("a").item(0).getElementsByTagName("span").item(0).innerHTML

})

for (let i = 1; i <= pageNum; i++) { //将所有的页面存入数组中

urlArray.push(newUrl.replace(new RegExp("/" + pathArray[pathArray.length - 1], 'g'), "/o" + i + "/" + pathArray[pathArray.length - 1]))

}

} catch (error) {

console.log(cityList[i].cityName + "-" + brandList[j].brand + "-" + carTypeList[k].carType + "的所有二手车列表爬取失败,该车型可能只有少量或者没有")

}

if (urlArray.length != 0) {

for (let i = 0; i < urlArray.length; i++) {

await page.goto(urlArray[i]);

const list = await page.evaluate(() => {

let carArray = []

let li = document.querySelectorAll("ul.carlist").item(0).getElementsByTagName("li")

for (let i = 0; i < li.length; i++) {

a = li.item(i).getElementsByTagName("a").item(0)

carArray.push({

"url": a.getAttribute("href"),

"imgUrl": a.getElementsByTagName("img").item(0).getAttribute("src"),

"carName": a.getElementsByTagName("h2").item(0).innerHTML,

"carData": (a.getElementsByTagName("div").item(0).innerHTML).replace(new RegExp('<span class="icon-pad">', 'g'), "").replace(new RegExp('</span>', 'g'), ""),

"price": a.getElementsByTagName("div").item(1).getElementsByTagName("p").item(0).innerHTML.replace(new RegExp('<span>', 'g'), "").replace(new RegExp('</span>', 'g'), "").replace(/\s*/g, "")

})

}

return carArray

})

await page.waitFor(500 + Math.round(Math.random() * 100))

console.log(list)

}

}else{

try {

const list = await page.evaluate(() => {

let carArray = []

let li = document.querySelectorAll("ul.carlist").item(0).getElementsByTagName("li")

console.log("该车型少量")

for (let i = 0; i < li.length; i++) {

a = li.item(i).getElementsByTagName("a").item(0)

carArray.push({

"url": a.getAttribute("href"),

"imgUrl": a.getElementsByTagName("img").item(0).getAttribute("src"),

"carName": a.getElementsByTagName("h2").item(0).innerHTML,

"carData": (a.getElementsByTagName("div").item(0).innerHTML).replace(new RegExp('<span class="icon-pad">', 'g'), "").replace(new RegExp('</span>', 'g'), ""),

"price": a.getElementsByTagName("div").item(1).getElementsByTagName("p").item(0).innerHTML.replace(new RegExp('<span>', 'g'), "").replace(new RegExp('</span>', 'g'), "").replace(/\s*/g, "")

})

}

return carArray

})

await page.waitFor(500 + Math.round(Math.random() * 100))

console.log(list)

} catch (error) {

console.log("该车型没有")

}

}

}

} catch (error) {

console.log(cityList[i].cityName + "-" + brandList[i].brand + "的所有车系爬取失败")

}

}

} catch (error) {

console.log(cityList[i].cityName + "二手车品牌爬取失败")

}

await page.waitFor(1000 + Math.round(Math.random() * 100))

}

})();

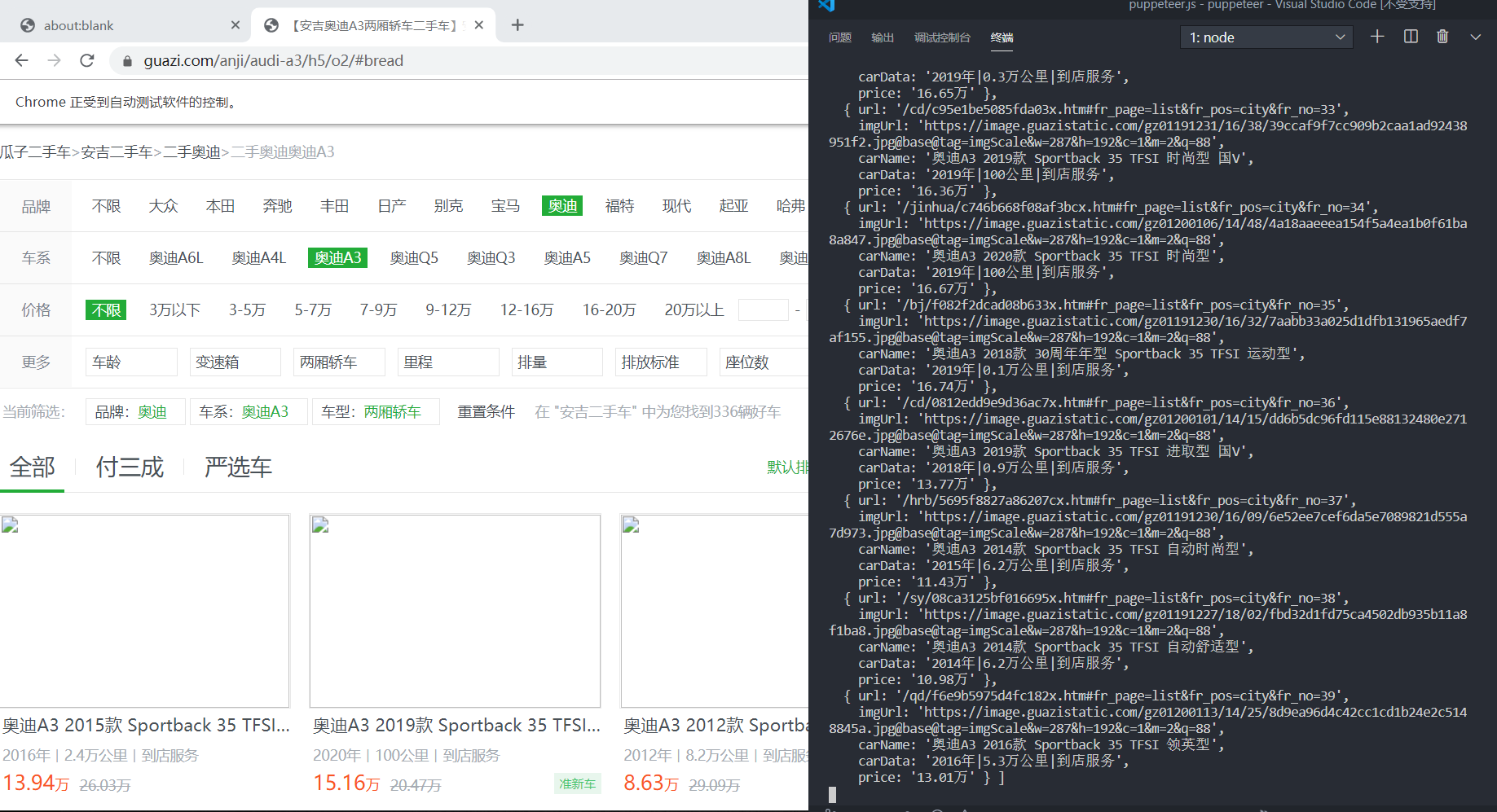

时间比较赶,先附上代码和运行截图

有兴趣的可以 看一下项目地址

https://gitee.com/xu_hui_hong/nodejs_puppeteer_guazi2

使用nodejs的puppeteer库爬取瓜子二手车网站的更多相关文章

- Python——爬取瓜子二手车

# coding:utf8 # author:Jery # datetime:2019/5/1 5:16 # software:PyCharm # function:爬取瓜子二手车 import re ...

- python爬虫学习之使用BeautifulSoup库爬取开奖网站信息-模块化

实例需求:运用python语言爬取http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html这个开奖网站所有的信息,并且保存为txt文件和excel文件. 实 ...

- Python scrapy框架爬取瓜子二手车信息数据

项目实施依赖: python,scrapy ,fiddler scrapy安装依赖的包: 可以到https://www.lfd.uci.edu/~gohlke/pythonlibs/ 下载 pywi ...

- nodejs中使用cheerio爬取并解析html网页

nodejs中使用cheerio爬取并解析html网页 转 https://www.jianshu.com/p/8e4a83e7c376 cheerio用于node环境,用法与语法都类似于jquery ...

- 一起学爬虫——使用xpath库爬取猫眼电影国内票房榜

之前分享了一篇使用requests库爬取豆瓣电影250的文章,今天继续分享使用xpath爬取猫眼电影热播口碑榜 XPATH语法 XPATH(XML Path Language)是一门用于从XML文件中 ...

- python爬虫学习(三):使用re库爬取"淘宝商品",并把结果写进txt文件

第二个例子是使用requests库+re库爬取淘宝搜索商品页面的商品信息 (1)分析网页源码 打开淘宝,输入关键字“python”,然后搜索,显示如下搜索结果 从url连接中可以得到搜索商品的关键字是 ...

- Python 爬取所有51VOA网站的Learn a words文本及mp3音频

Python 爬取所有51VOA网站的Learn a words文本及mp3音频 #!/usr/bin/env python # -*- coding: utf-8 -*- #Python 爬取所有5 ...

- scrapy爬取西刺网站ip

# scrapy爬取西刺网站ip # -*- coding: utf-8 -*- import scrapy from xici.items import XiciItem class Xicispi ...

- Python开发爬虫之BeautifulSoup解析网页篇:爬取安居客网站上北京二手房数据

目标:爬取安居客网站上前10页北京二手房的数据,包括二手房源的名称.价格.几室几厅.大小.建造年份.联系人.地址.标签等. 网址为:https://beijing.anjuke.com/sale/ B ...

随机推荐

- TypeError: Cannot assign to read only property 'exports' of object '#<Object>'

我的项目在mac上运行的很好,结果windows电脑,就一直报这个错误 解决方案: babel增加 @babel/plugin-transform-modules-commonjs 参考文章: htt ...

- JVM_双亲委派机制

双亲委派机制及作用 什么是双亲委派机制 当`.class`文件需要被加载时,它首先把这个任务委托给他的上级类加载器,层层往上委托,如果上级的类加载器没有加载过,自己才会去加载这个类. 源码分析 pro ...

- SQL Server存储过程模拟HTTP请求POST和GET协议

/****** Object: StoredProcedure [dbo].[sp_http_get] Script Date: 05/23/2020 15:47:09 ******/ SET ANS ...

- uniapp打包发版到linux服务器步骤----H5端

最近在写uni-app项目,项目打包部署到服务器后,搞了好一会一直打开是空白页,原来自己有几个地方疏忽了,现把步骤整理一下: 第1步:编辑配置 mainifest.json 文件 tip:运行的基础路 ...

- 小BUG大原理:重写WebMvcConfigurationSupport后SpringBoot自动配置失效

一.背景 公司的项目前段时间发版上线后,测试反馈用户的批量删除功能报错.正常情况下看起来应该是个小 BUG,可怪就怪在上个版本正常,且此次发版未涉及用户功能的改动.因为这个看似小 BUG 我了解到不少 ...

- 转 vue过滤器使用

简单介绍一下过滤器,顾名思义,过滤就是一个数据经过了这个过滤之后出来另一样东西,可以是从中取得你想要的,或者给那个数据添加点什么装饰,那么过滤器则是过滤的工具.例如,从['abc','abd','ad ...

- C# 数据操作系列 - 16 SqlSugar 完结篇

0. 前言 前一篇我们详细的介绍了SqlSugar的增删改查,那些已经满足我们在日常工程开发中的使用了.但是还有一点点在开发中并不常用,但是却非常有用的方法.接下来让我们一起来看看还有哪些有意思的内容 ...

- 【深度学习】PyTorch之Squeeze()和Unsqueeze()

1. unsqueeze() 该函数用来增加某个维度.在PyTorch中维度是从0开始的. import torch a = torch.arange(0, 9) print(a) 结果: tenso ...

- 公有继承中派生类Student对基类Person成员的访问 代码参考

#include <iostream> #include <cstring> using namespace std; class Person { private: char ...

- RabbitMQ--其他几种模式

本文是作者原创,版权归作者所有.若要转载,请注明出处. 本文RabbitMQ版本为rabbitmq-server-3.7.17,erlang为erlang-22.0.7.请各位去官网查看版本匹配和下载 ...