[CVPR2017] Visual Translation Embedding Network for Visual Relation Detection 论文笔记

http://www.ee.columbia.edu/ln/dvmm/publications/17/zhang2017visual.pdf

Visual Translation Embedding Network for Visual Relation Detection Hanwang Zhang† , Zawlin Kyaw‡ , Shih-Fu Chang† , Tat-Seng Chua‡ †Columbia University, ‡National University of Singapore

p.p1 { margin: 0.0px 0.0px 0.0px 0.0px; font: 15.0px Arial; color: #323333 }

p.p2 { margin: 0.0px 0.0px 0.0px 0.0px; font: 13.0px Arial; color: #323333 }

p.p3 { margin: 0.0px 0.0px 0.0px 0.0px; font: 13.0px Arial; color: #323333; min-height: 15.0px }

li.li2 { margin: 0.0px 0.0px 0.0px 0.0px; font: 13.0px Arial; color: #323333 }

span.s1 { }

ul.ul1 { list-style-type: disc }

ul.ul2 { list-style-type: circle }

ul.ul3 { list-style-type: square }

亮点

- 视觉关系预测问题的分析与化简:把一种视觉关系理解为在特征空间从主语到宾语的一种变换,很有效、很直白

- 实验设计的很棒,从多角度进行了分析对比:语言空间划分,多任务对物体检测的提升,零次学习等。

现有工作

- Mature visual detection [16, 35]

- Burgeoning visual captioning and question answering [2, 4]

- directly bridge the visual model (e.g., CNN) and the language model (e.g., RNN), but fall short in modeling and understanding the relationships between objects.

- poor generalization ability

- Visual Relation Detection: a visual relation as a subject-predicate-object triplet

- joint models, a relation triplet is considered as a unique class [3, 9, 33, 37].

- the long-tailed distribution is an inherent defect for scalability.

- separate model

- modeling the large visual variance of predicates is challenging.

- language priors to boost relation detection

主要思想

Translation Embedding 视觉关系预测的难点主要是:对于N个物体和R种谓语,有N^2R种关系,是一个组合爆炸问题。解决这个问题常用的办法是:

- 估计谓语,不估计关系,缺点:对于不同的主语、宾语,图像视觉差异巨大

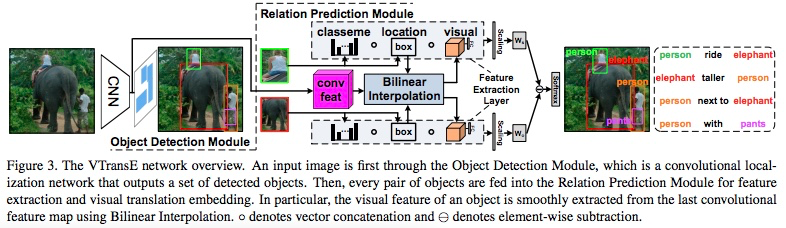

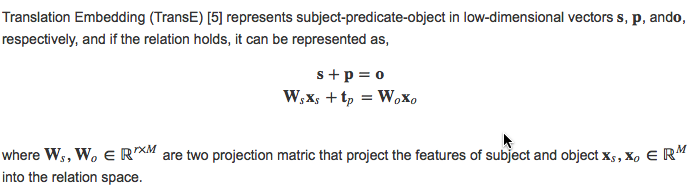

受Translation Embedding (TransE) 启发,文章中将视觉关系看作在特征空间上从主语到宾语的一种映射,在低维空间上关系元组可看作向量变换,例如person+ride ≈ bike.

Knowledge Transfer in Relation 物体的识别和谓语的识别是互惠的。通过使用类别名、位置、视觉特征三种特征和端对端训练网络,使物体和谓语之前的隐含关系在网络中能够学习到。

算法

Visual Translation Embedding

p.p1 { margin: 0.0px 0.0px 0.0px 0.0px; font: 14.0px Arial; color: #323333 }

span.s1 { }

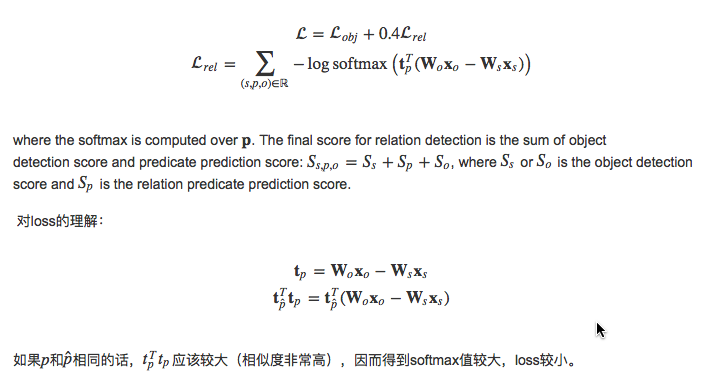

Loss function

p.p1 { margin: 0.0px 0.0px 0.0px 0.0px; font: 14.0px Arial; color: #323333 }

p.p2 { margin: 0.0px 0.0px 0.0px 0.0px; font: 14.0px Arial; color: #323333; min-height: 16.0px }

span.s1 { }

Feature Extraction Layer

classname + location + visual feature 不同的特征对不同的谓语(动词、介词、空间位置、对比)都有不一样的作用

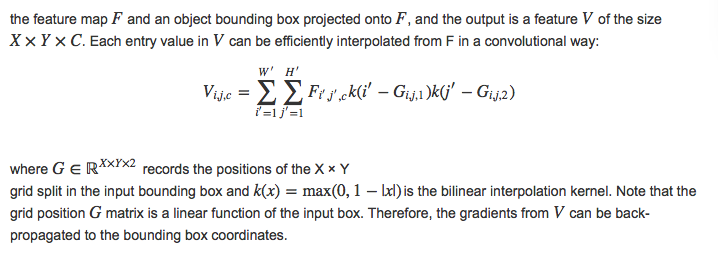

Bilinear Interpolation

In order to achieve object-relation knowledge transfer, the relation error should be back-propagated to the object detection network and thus refines the objects. We replace the RoI pooling layer with bilinear interpolation [18]. It is a smooth function of two inputs:

p.p1 { margin: 0.0px 0.0px 0.0px 0.0px; font: 16.0px Arial; color: #323333 }

p.p2 { margin: 0.0px 0.0px 0.0px 0.0px; font: 14.0px Arial; color: #323333 }

li.li2 { margin: 0.0px 0.0px 0.0px 0.0px; font: 14.0px Arial; color: #323333 }

span.s1 { }

ul.ul1 { list-style-type: disc }

结果

Translation embeding: +18%

object detection +0.6% ~ 0.3%

State-of-art:

- Phrase Det. +3% ~ 6%

- Relation Det. +1%

- Retrieval -1% ~ 2%

- Zero-shot phrase detection

- Phrase Det. -0.7% (without language prior)

- Relation Det. -1.4%

- Retrieval +0.2%

问题

- 两个物体之间可能有多种关系,比如person ride elephant,同时也存在person short elephant但是文章中的方法无法表示多样化的关系

- 没有使用语言先验知识,使用多模态信息可能会有所提升

[CVPR2017] Visual Translation Embedding Network for Visual Relation Detection 论文笔记的更多相关文章

- [CVPR2017] Deep Self-Taught Learning for Weakly Supervised Object Localization 论文笔记

http://openaccess.thecvf.com/content_cvpr_2017/papers/Jie_Deep_Self-Taught_Learning_CVPR_2017_paper. ...

- 论文笔记系列-Neural Network Search :A Survey

论文笔记系列-Neural Network Search :A Survey 论文 笔记 NAS automl survey review reinforcement learning Bayesia ...

- 谣言检测()《Data Fusion Oriented Graph Convolution Network Model for Rumor Detection》

论文信息 论文标题:Data Fusion Oriented Graph Convolution Network Model for Rumor Detection论文作者:Erxue Min, Yu ...

- 论文笔记: Dual Deep Network for Visual Tracking

论文笔记: Dual Deep Network for Visual Tracking 2017-10-17 21:57:08 先来看文章的流程吧 ... 可以看到,作者所总结的三个点在于: 1. ...

- 论文笔记:Visual Semantic Navigation Using Scene Priors

Visual Semantic Navigation Using Scene Priors 2018-10-21 19:39:26 Paper: https://arxiv.org/pdf/1810 ...

- Deep Reinforcement Learning for Visual Object Tracking in Videos 论文笔记

Deep Reinforcement Learning for Visual Object Tracking in Videos 论文笔记 arXiv 摘要:本文提出了一种 DRL 算法进行单目标跟踪 ...

- 论文笔记之:Visual Tracking with Fully Convolutional Networks

论文笔记之:Visual Tracking with Fully Convolutional Networks ICCV 2015 CUHK 本文利用 FCN 来做跟踪问题,但开篇就提到并非将其看做 ...

- 论文速读(Jiaming Liu——【2019】Detecting Text in the Wild with Deep Character Embedding Network )

Jiaming Liu--[2019]Detecting Text in the Wild with Deep Character Embedding Network 论文 Jiaming Liu-- ...

- 论文笔记之:Action-Decision Networks for Visual Tracking with Deep Reinforcement Learning

论文笔记之:Action-Decision Networks for Visual Tracking with Deep Reinforcement Learning 2017-06-06 21: ...

随机推荐

- 解决UIScrollView,UIImageView等控件不能响应touch事件的问题

关于UIScrollView,UIImageView等控件不能响应touch事件,主要涉及到事件响应者链的问题,如果在UIScrollView,UIImageView等控件添加了子View,这样事件响 ...

- ListView中ConvertView和ViewHolder

1.概述 ListView是Android中非常常见的控件通过Adapter架起数据与界面显示的桥梁,MVC思想在其中得到了很好地体现: M:model 数据模型 添加到ListView中显示的 ...

- 字符转码开源库libiconv目前还不支持64位

最新版的libiconv 1.14目前还不支持64位系统,只能编译出32位库. libiconv 1.14下载地址: http://ftp.gnu.org/pub/gnu/libiconv/libic ...

- Leetcode_35_Search Insert Position

本文是在学习中的总结,欢迎转载但请注明出处:http://blog.csdn.net/pistolove/article/details/43739647 Given a sorted array a ...

- STL算法设计理念 - 预定义函数对象

预定义函数对象基本概念:标准模板库STL提前定义了很多预定义函数对象 1)使用预定义函数对象: #include <iostream> #include <cstdio> #i ...

- SMO实现

#include "stdio.h" #include <vector> using namespace std; float function(float alfa[ ...

- 如何手动实现C语言中的字符串操作

学了字符串操作,很多人也许学了大概知道怎么用,但是太久没用就忘了,恰恰这是找软件工程师或者嵌入式工程师以及C,C++相关的笔试面试必考的题目!接下来我们来看看如何手动实现这些相关的函数. 废话不多说, ...

- AngularJS进阶(五)Angular实现下拉菜单多选

Angular实现下拉菜单多选 写这篇文章时,引用文章地址如下: http://ngmodules.org/modules/angularjs-dropdown-multiselect http:// ...

- 开源项目Git地址

1.陈明.李建勋.邓覃思 fog-aliyun https://git.oschina.net/dengqinsi/fog-aliyun.git 2.吴俊.骆仲军.袁良福 CDN的H5助 ...

- 关于L298N的应用

最近在开发一个基于STM32的智能小车,用的底板是野火ISO mini的板子.如图: 这里有个电机驱动模块L298N,说起它,我还真的泪奔,前阵子被卖家坑了,拿上去一接电源马上就烧了,这都怪我粗心大意 ...