(六)hadoop系列之__hadoop分布式集群环境搭建

配置hadoop(master,slave1,slave2)

说明:

NameNode: master

DataNode: slave1,slave2 --------------------------------------------------------

A. 修改主机的master 和 slaves

i. 配置slaves

# vi hadoop/conf/slaves

添加:192.168.126.20

192.168.126.30

...节点 ip ii. 配置master

添加:192.168.126.10

...主机 ip

-------------------------------------------------------- B. 配置master .xml文件

i. 配置core-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/had/hadoop/data</value>

<description>A base for other temporary directories.</description>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://192.168.126.10:9000</value>

</property>

</configuration> ii. 配置hdfs-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

<description>Default block replication.

The actual number of replications can be specified when the file is created.

The default is used if replication is not specified in create time.

</description>

</property>

</configuration> iii.mapred-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>192.168.126.10:9001</value>

</property>

</configuration> -------------------------------------------------------------

C. 配置slave1,slave2 (同上)

i. core-site.xml

ii. mapred-site.xml

--------------------------------------------------------------- D. 配置 master,slave1,slave2的hadoop系统环境

$ vi /home/hadoop/.bashrc

添加:

export HADOOP_HOME=/home/hadoop/hadoop-0.20.2

export HADOOP_CONF_DIR=$HADOOP_HOME/conf

export PATH=/home/hadoop/hadoop-0.20.2/bin:$PATH

----------------------------------------------------------------

注意:有时候会出现以下错误信息

。。。

11/08/18 17:02:35 INFO ipc.Client: Retrying connect to server: localhost/192.168.126 .10:9000. Already tried 0 time(s).

Bad connection to FS. command aborted.

此时需要把根目录下的tmp文件里面的内容删掉,然后重新格式化即可。

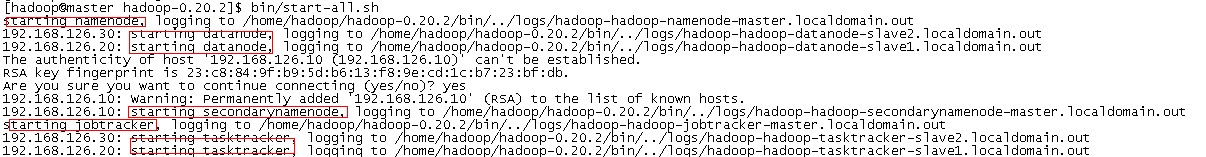

启动Hadoop:

完成后进行测试:

测试 $ bin/hadoop fs -put ./README.txt test1

$ bin/hadoop fs -ls

Found 1 items

drwxr-xr-x - hadoop supergroup 0 2013-07-14 00:51 /user/hadoop/test1

$hadoop jar hadoop-0.20.2-examples.jar wordcount /user/hadoop/test1/README.txt output1

结果出现以下问题

注:测试过程当中会有一些错误信息。一下是我在安装的过程当中碰到的几个问题。

1.org.apache.hadoop.ipc.RemoteException: org.apache.hadoop.hdfs.server.namenode.SafeModeException: Cannot delete /home/hadoop/hadoop-datastore

/hadoop-hadoop/mapred/system/job_201307132331_0005. Name node is in safe mode.

关闭安全模式:

bin/hadoop dfsadmin -safemode leave

2.org.apache.hadoop.ipc.RemoteException: java.io.IOException: File /user/hadoop/test1/README.txt could only be replicated to 0 nodes,

instead of 1

情况1. hadoop.tmp.dir 磁盘空间不足。

解决方法: 换个足够空间的磁盘即可。

情况2. 查看防火墙状态

/etc/init.d/iptables status

/etc/init.d/iptables stop//关闭所有的防火墙

情况3.先后启动namenode、datanode(我的是这种情况)

参考文章:http://sjsky.iteye.com/blog/1124545

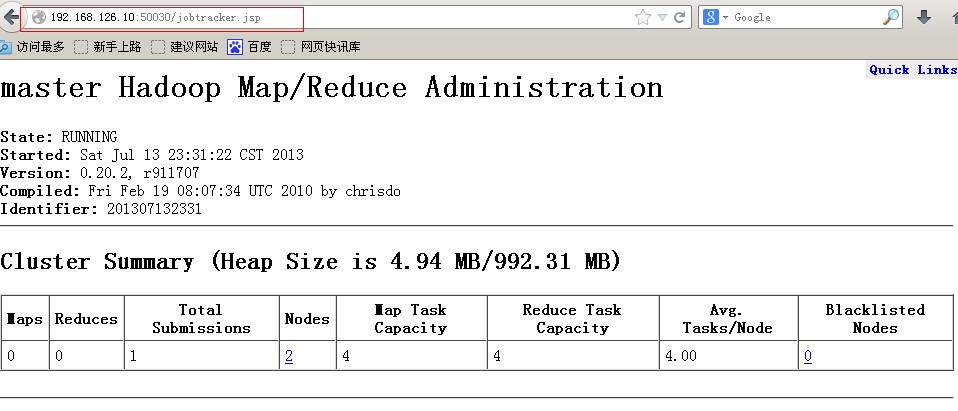

最后执行界面如下:

查看hdfs运行状态(web):http://192.168.126.10:50070/dfshealth.jsp

查看map-reduce信息(web):http://192.168.126.10:50030/jobtracker.jsp

整个Hadoop集群搭建结束。

(六)hadoop系列之__hadoop分布式集群环境搭建的更多相关文章

- Spark 1.6.1分布式集群环境搭建

一.软件准备 scala-2.11.8.tgz spark-1.6.1-bin-hadoop2.6.tgz 二.Scala 安装 1.master 机器 (1)下载 scala-2.11.8.tgz, ...

- Hadoop完全分布式集群环境搭建

1. 在Apache官网下载Hadoop 下载地址:http://hadoop.apache.org/releases.html 选择对应版本的二进制文件进行下载 2.解压配置 以hadoop-2.6 ...

- ZooKeeper 完全分布式集群环境搭建

1. 搭建前准备 示例共三台主机,主机IP映射信息如下: 192.168.32.101 s1 192.168.32.102 s2 192.168.32.103 s3 2.下载ZooKeeper, 以 ...

- Kafka 完全分布式集群环境搭建

思路: 先在主机s1上安装配置,然后远程复制到其它两台主机s2.s3上, 并分别修改配置文件server.properties中的broker.id属性. 1. 搭建前准备 示例共三台主机,主机IP映 ...

- Hadoop伪分布式集群环境搭建

本教程讲述在单机环境下搭建Hadoop伪分布式集群环境,帮助初学者方便学习Hadoop相关知识. 首先安装Hadoop之前需要准备安装环境. 安装Centos6.5(64位).(操作系统再次不做过多描 ...

- 阿里云ECS服务器部署HADOOP集群(一):Hadoop完全分布式集群环境搭建

准备: 两台配置CentOS 7.3的阿里云ECS服务器: hadoop-2.7.3.tar.gz安装包: jdk-8u77-linux-x64.tar.gz安装包: hostname及IP的配置: ...

- Hadoop+HBase+ZooKeeper分布式集群环境搭建

一.环境说明 集群环境至少需要3个节点(也就是3台服务器设备):1个Master,2个Slave,节点之间局域网连接,可以相互ping通,下面举例说明,配置节点IP分配如下: Hostname IP ...

- Hadoop学习(一):完全分布式集群环境搭建

1. 设置免密登录 (1) 新建普通用户hadoop:useradd hadoop(2) 在主节点master上生成密钥对,执行命令ssh-keygen -t rsa便会在home文件夹下生成 .ss ...

- Spark 2.2.0 分布式集群环境搭建

集群机器: 1台 装了 ubuntu 14.04的 台式机 1台 装了ubuntu 16.04 的 笔记本 (机器更多时同样适用) 1.需要安装好Hadoop分布式环境 参照:Hadoop分类 ...

随机推荐

- ruby Rspec+jenkins+allure持续集成

1.Allure2使用说明 2.ruby下载allure的gem gem install allure-rspec 3.修改源码 C:\Ruby23-x64\lib\ruby\gems\2.3.0\g ...

- Leecode刷题之旅-C语言/python-383赎金信

/* * @lc app=leetcode.cn id=383 lang=c * * [383] 赎金信 * * https://leetcode-cn.com/problems/ransom-not ...

- sourcetree的安装及使用

sourcetree下载地址:https://www.sourcetreeapp.com/ 点击安装包安装 此前需要跳转到bitbucket登录,我没有账号,所以我直接跳转到到https://bitb ...

- spark 例子wordcount topk

spark 例子wordcount topk 例子描述: [单词计算wordcount ] [词频排序topk] 单词计算在代码方便很简单,基本大体就三个步骤 拆分字符串 以需要进行记数的单位为K,自 ...

- 20145226夏艺华 Exp6 信息搜集与漏洞扫描

20145226夏艺华 Exp6 信息搜集与漏洞扫描 基础问题回答 哪些组织负责DNS,IP的管理? · 全球根服务器均由美国政府授权的ICANN统一管理,负责全球的域名根服务器.DNS和IP地址管理 ...

- 【java笔记】Calendar.getInstance()是什么意思

Calendar类是个抽象类,因此本身不能被实例化,然而在却创建了Calendar 的对象,但并不是抽象类可以创建对象这个对象并不是Calendar 自身实例,而是其子类实例,这是在getInstan ...

- 深度学习开源库tiny-dnn的使用(MNIST)

tiny-dnn是一个基于DNN的深度学习开源库,它的License是BSD 3-Clause.之前名字是tiny-cnn是基于CNN的,tiny-dnn与tiny-cnn相关又增加了些新层.此开源库 ...

- 一个自己实现的string

最近实现了一个string类,添加了一些c++11元素. 除了基本的构造析构函数,拷贝构造和赋值函数,另外添加移动拷贝和赋值函数.default是一个很方便的特性有木有. //default cons ...

- hdu - 6282,2018CCPC湖南全国邀请赛G题,字符串,规律

HDU – 6282 http://acm.hdu.edu.cn/showproblem.php?pid=6282 by Hzu_Tested 题意:给出两个字符串S和T,只由a,b,c三种字符组成( ...

- Linux内核学习笔记(4)-- wait、waitpid、wait3 和 wait4

进程调用 exit() 退出执行后,被设置为僵死状态,这时父进程可以通过 wait4() 系统调用查询子进程是否终结,之后再进行最后的操作,彻底删除进程所占用的内存资源. wait4() 系统调用由 ...