Wasserstein CNN: Learning Invariant Features for NIR-VIS Face Recognition

承接上上篇博客,在其基础上,加入了Wasserstein distance和correlation prior 。其他相关工作、网络细节(maxout operator)、训练方式和数据处理等基本和前文一致。以下是这两点改进的大概:

- Wasserstein convolutional neural network(WCNN)的低级层利用容易得到的大量VIS光谱训练,高级层划分为3部分:the NIR layer, the VIS layer and the NIR-VIS shared layer。前两层旨在学习模态明确特征(modality-specific features),最后一层学习模态不变特征子空间(modality-invariant feature subspace)。Wasserstein distance用在最后一层来估量两种异质图像特征分布的不相似性。即WCNN通过最小化NIR分布与VIS分布之间的Wasserstein 距离来得到深度不变表征。

- 为了避免小规模异质数据的过拟合,一个correlation piori引入到WCNN的全连接层中,最后同之前博客中一样,交替优化。这个correlation由一个非凸低秩限制来实现(a non-convex low-rank constraint)。当训练集较小时这个prior尤其重要。

文章的四大贡献:

- 端到端网络学习模态不变特征,这个结构自然的结合了不变特征提取和子空间学习。两个正交子空间分别建模身份及光谱信息,(一张人脸图其实包括了人脸身份信息+人脸光谱信息)。这个网络用来同时提前NIR和VIS特征。

Wasserstein distance引入,度量NIR和VIS模态的分布差异,相比之前的sample-level的度量,这个Wasserstein distance更有效减少两种模态的分布差异,提高性能。

- correlation prior引入,减轻在全连接层中小规模数据产生的过拟合问题,这个先验提高了WCNN在小数据集的表现。

- 在CASIA NIR-VIS 2.0 人脸数据集上的性能达到了SOTA。

异质人脸识别(验证)的四大类方法:

- mage synthesis、

- Feature representation、

- Subspace learning、

- Deep learning

网络结构

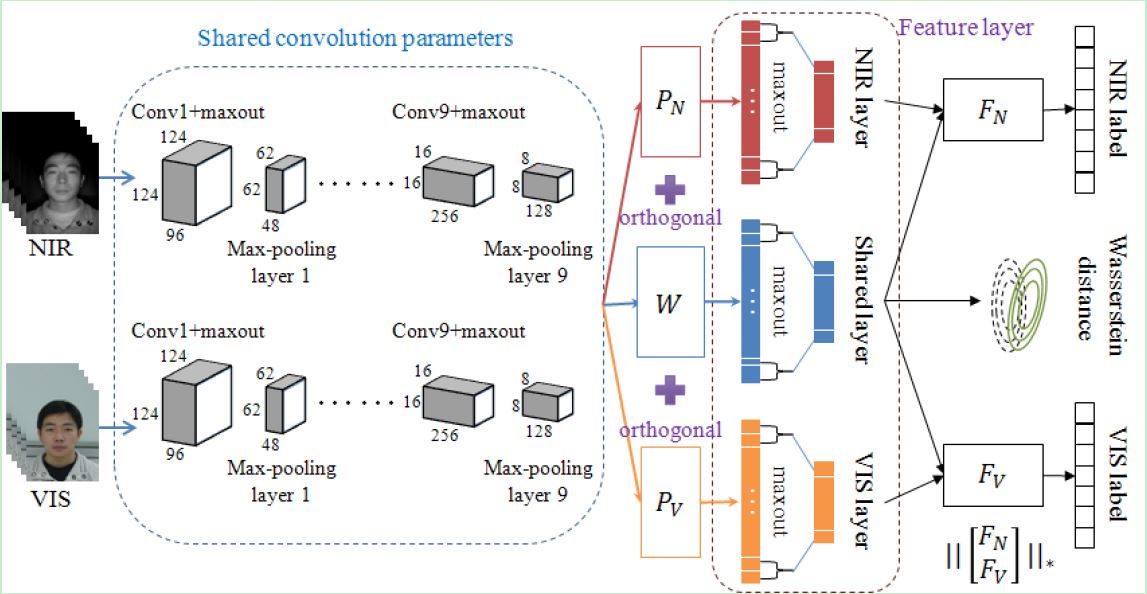

Fig 1. An illustration of our proposed Wasserstein CNN architecture. The Wasserstein distance is used to measure the difference between NIR

and VIS distributions in the modality invariant subspace (spanned by matrix W). At the testing time, both NIR and VIS features are exacted from

the shared layer of one single neural network and compared in cosine distance.

网络解释如下:

1. Modality Invariant Subspace

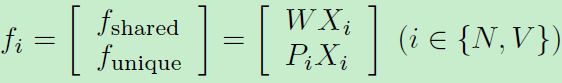

减轻NIR-VIS外观差异,即想办法移除掉光谱(外观)差异,那么只剩下identity信息就容易匹配了。之前的方法都是移除一些principal subspaces,假定这些子空间是包含光谱信息的。受此启发,这里引入三个映射矩阵(见上图):W,PN,PV。W用来将建模 modeling identity invariant information,P用来建模 variant spectrum information。所以输入两张图,得到三个特征:

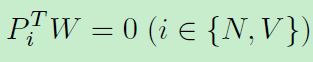

其中WX和PX分别表示共享特征和独立特征,考虑到子空间中分解特性,限制其互相无关:

这个限制可减少参数空间,减轻过拟合。将特征表示和子空间学习两个独立步骤和合为一步。

2. The Wasserstein Distance

NIR和VIS图像的gap是异质图像识别的主要问题。之前的方法引导sample-level的限制来解决这个gap。比如有contrastive loss和triplet loss等都施加在NIR-VIS sample pairs上。这些方法仅仅考虑NIR-VIS samples的关系而非NIR-VIS 分布的关系。近来Wasserstein distance在GAN中度量模型分布和真实分布扮演了重要的角色。受到Wasserstein GAN和BEGAN的启发,我们利用Wasserstein distance来测量NIR和VIS数据分布之间的一致性。假定在非线性特征映射后同一subject遵从高斯分布。施加 Wasserstein distance 在同一subject(即同一个体identity)的分布上。具体实现细节见paper,比较好理解。

3. Correlation Prior

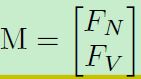

过拟合问题。NIR-VIS数据集通常比纯VIS数据集小得多。全连接的参数最多。本文将WCNN的全连接层分解为两个矩阵:FN、FV。分别对应NIR和VIS模态。我们希望M(下式)高度相关,使得M.T*M为一块对角矩阵。一个相关的M将减少估计的参数空间,减轻过拟合。进一步探索M的核范数。其余细节见paper。

4. loss

其中第一项为分类损失,第二项为W距离,第三项为proir约束。beta1=beta2=1,beta3=0.001,说明这个prior在这里不是很重要。

5. CONCLUSIONS

Same as before

Wasserstein CNN: Learning Invariant Features for NIR-VIS Face Recognition的更多相关文章

- Learning Invariant Deep Representation for NIR-VIS Face Recognition

查找异质图像匹配的过程中,发现几篇某组的论文,都是关于NIR-VIS的识别问题,提到了许多处理异质图像的处理方法,网络结构和idea都很不错,记录其中一篇. 其余两篇: Wasserstein CNN ...

- Machine Learning : Pre-processing features

from:http://analyticsbot.ml/2016/10/machine-learning-pre-processing-features/ Machine Learning : Pre ...

- 【DeepLearning】Exercise:Learning color features with Sparse Autoencoders

Exercise:Learning color features with Sparse Autoencoders 习题链接:Exercise:Learning color features with ...

- Paper-[arXiv 1710.03144]Island Loss for Learning Discriminative Features in Facial Expression

[arXiv 1710.03144]Island Loss for Learning Discriminative Features in Facial Expression ABSTRACT 作者在 ...

- Computer Vision_18_Image Stitching:Automatic Panoramic Image Stitching using Invariant Features——2007

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- Learning Discriminative Features with Class Encoder

近来论文看了许多,但没多少时间总结下来.今天暂时记录一篇比较旧的论文,选择理由是 Discriminative features. 做图像说白了就是希望有足够有判别性的特征,这样在分类或者匹配.检索的 ...

- Learning Rich Features from RGB-D Images for Object Detection and Segmentation论文笔记

相关工作: 将R-CNN推广到RGB-D图像,引入一种新的编码方式来捕获图像中像素的地心姿态,并且这种新的编码方式比单纯使用深度通道有了明显的改进. 我们建议在每个像素上用三个通道编码深度图像:水平视 ...

- 论文笔记:Learning Region Features for Object Detection

中心思想 继Relation Network实现可学习的nms之后,MSRA的大佬们觉得目标检测器依然不够fully learnable,这篇文章类似之前的Deformable ROI Pooling ...

- 【Discriminative Localization】Learning Deep Features for Discriminative Localization 论文解析(转)

文章翻译: 翻译 以下文章来源: 链接

随机推荐

- Synchronous XMLHttpRequest on the main thread is deprecated because of its detrimental effects to the end user's experience. For more jquery-1.12.4.js:10208

ajax执行请求之后返回了数据但是不执行success()函数,原因是返回得数据类型不是ajax请求中设定的:dataType:"json",因为是一个Map<Object, ...

- hdu 2815 Mod Tree (exBSGS)

http://acm.hdu.edu.cn/showproblem.php?pid=2815 //解 K^D ≡ N mod P #include<map> #include<cma ...

- JS常用类

JS常用类 一.Number 1.常用数字 整数:10 小数:3.14 科学计数法:1e5 | 1e-5 正负无穷:Infinity | -Infinity 2.常用进制 二进制:0b1010 八进制 ...

- MapReduce实现词频统计

问题描述:现在有n个文本文件,使用MapReduce的方法实现词频统计. 附上统计词频的关键代码,首先是一个通用的MapReduce模块: class MapReduce: __doc__ = ''' ...

- 改变this指向的三种方法

call.apply.bind三者为改变this指向的方法. 共同点:第一个参数都为改变this的指针.若第一参数为null/undefined,this默认指向window call(无数个参数) ...

- 细说logback之简介

官网:https://logback.qos.ch/https://logback.qos.ch/manual/index.html logback手册1.下载logback是slf4j的原生实现,所 ...

- docker 系列 - Java程序制作Docker Image推荐方案(转载)

本文转自 https://segmentfault.com/a/1190000016449865 , 感谢作者! 本文的源代码在:https://github.com/chanjarste... 这 ...

- CSS3 transform-origin 属性

<!DOCTYPE html> <html> <head> <style> #div1 { position: relative; height: 20 ...

- windows eclipse安装lombok插件

1.下载lombok.jar,lombok.jar官方下载地址:https://projectlombok.org/download 2.双击下载好的lombak.jar,安装步骤如下: 2-1.关闭 ...

- tcp_listen函数

#include <netdb.h> #include <unistd.h> #include <stddef.h> #include <strings.h& ...