【爬虫实战】用Python采集任意小红书笔记下的评论,爬了10000多条,含二级评论!

一、爬取目标

您好!我是@马哥python说 ,一名10年程序猿。

我们继续分享Python爬虫的案例,今天爬取小红书上指定笔记("巴勒斯坦"相关笔记)下的评论数据。

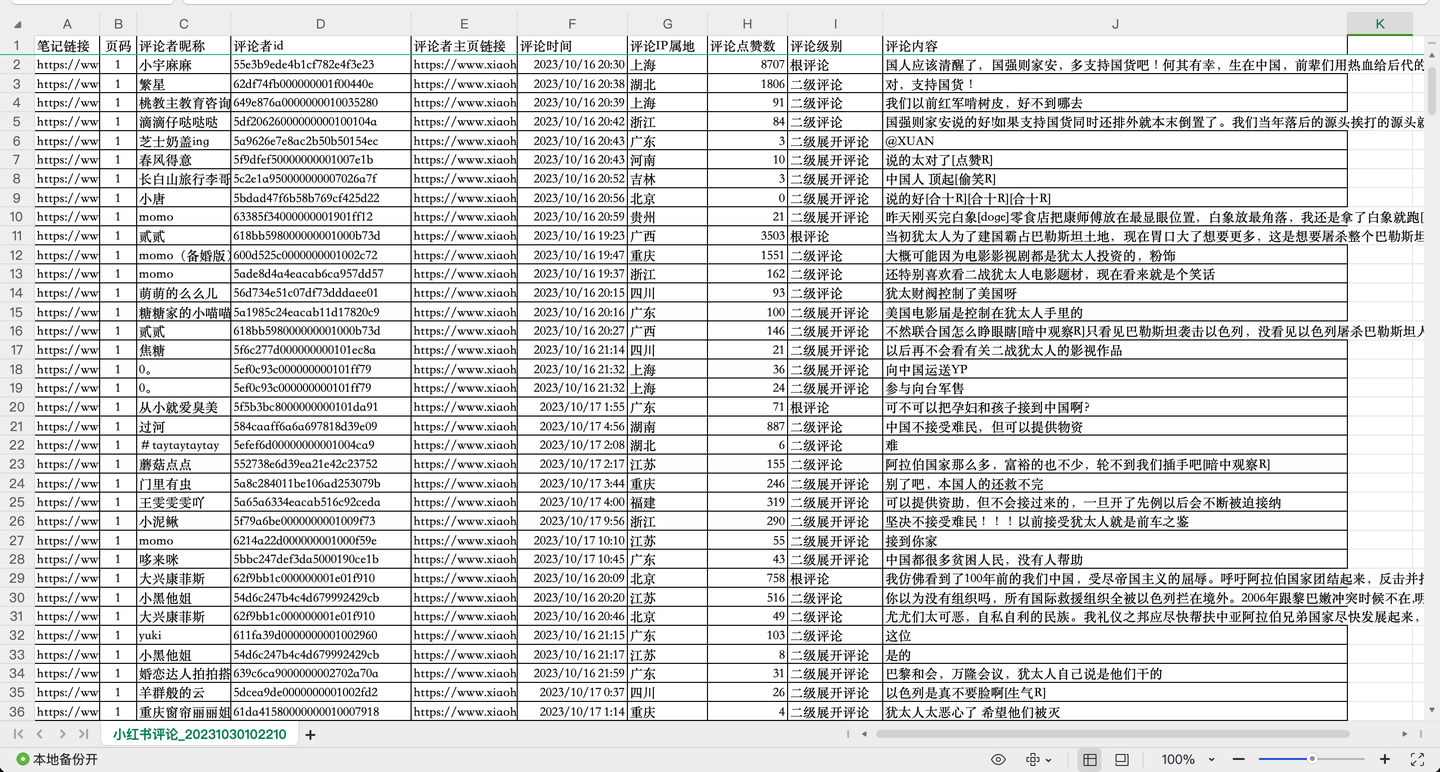

老规矩,先展示结果:

截图1:

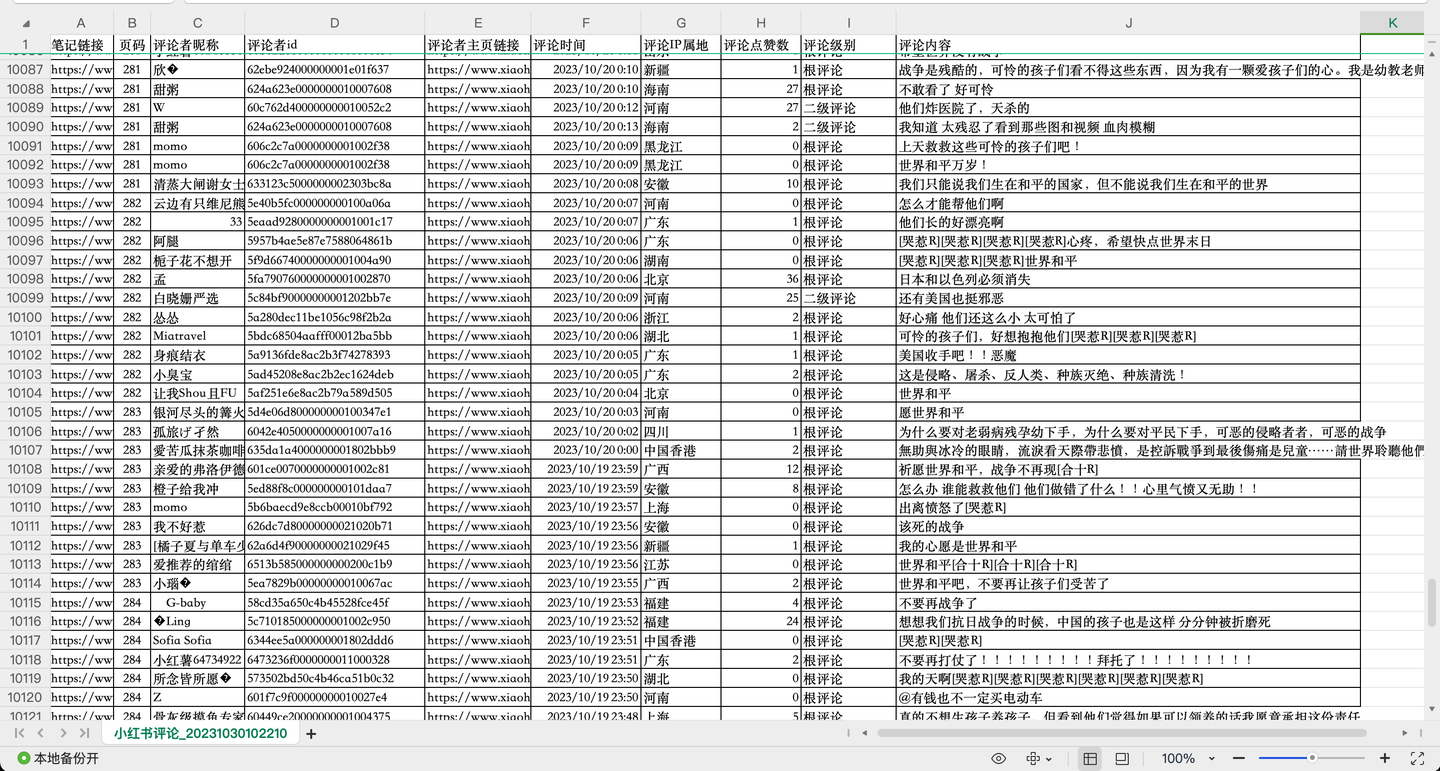

截图2:

截图3:

共爬取了1w多条"巴勒斯坦"相关评论,每条评论含10个关键字段,包括:

笔记链接, 页码, 评论者昵称, 评论者id, 评论者主页链接, 评论时间, 评论IP属地, 评论点赞数, 评论级别, 评论内容。

其中,评论级别包括:根评论、二级评论及二级展开评论。

二、爬虫代码讲解

2.1 分析过程

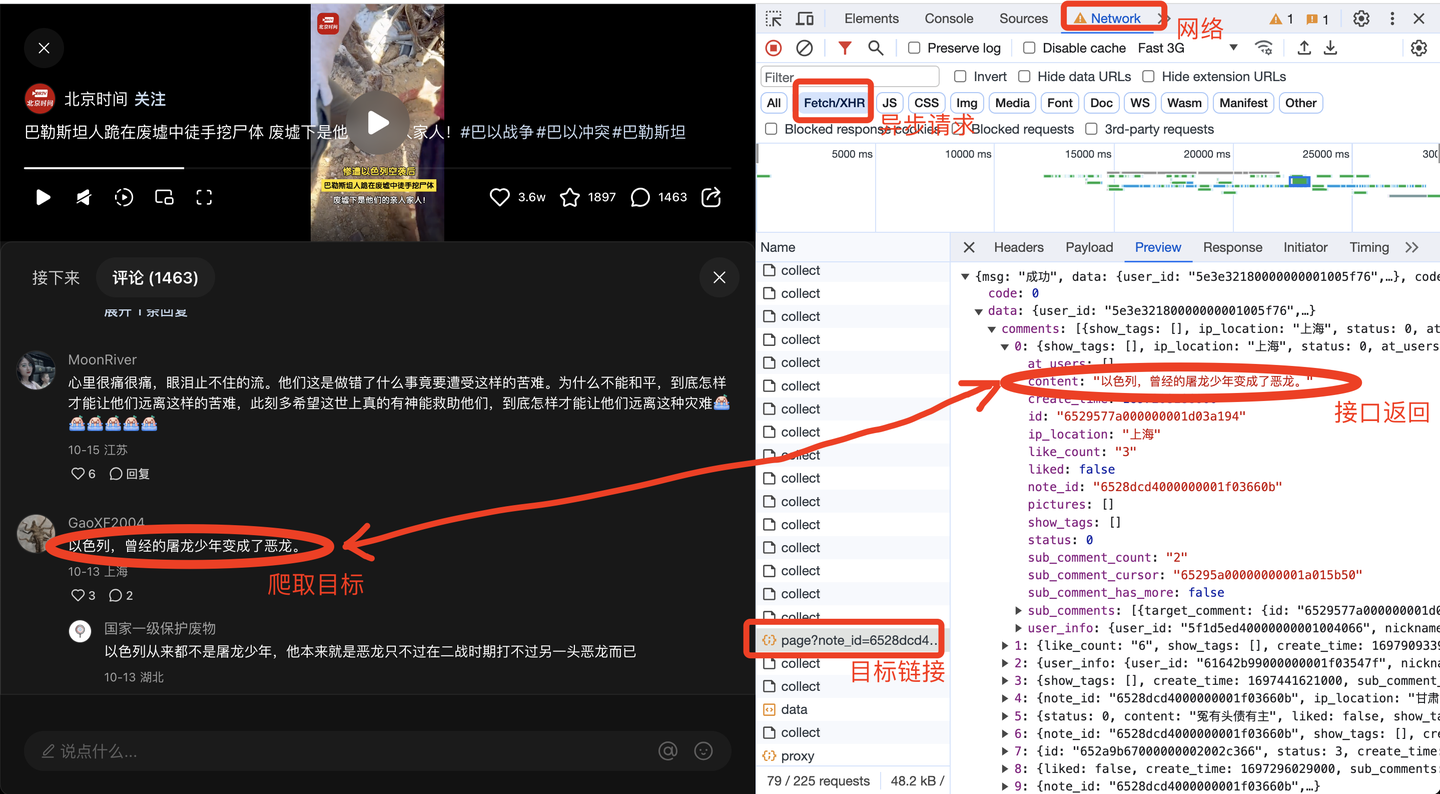

任意打开一个小红书笔记的评论,打开浏览器的开发者模式,网络,XHR,找到目标链接的预览数据,如下:

由此便得到了前端请求链接,下面开始开发爬虫代码。

2.2 爬虫代码

首先,导入需要用到的库:

import requests

from time import sleep

import pandas as pd

import os

import time

import datetime

import random

定义一个请求头:

# 请求头

h1 = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36',

# cookie需定期更换

'Cookie': '换成自己的cookie值',

}

经过我的实际测试,请求头包含User-Agent和Cookie这两项,即可实现爬取。

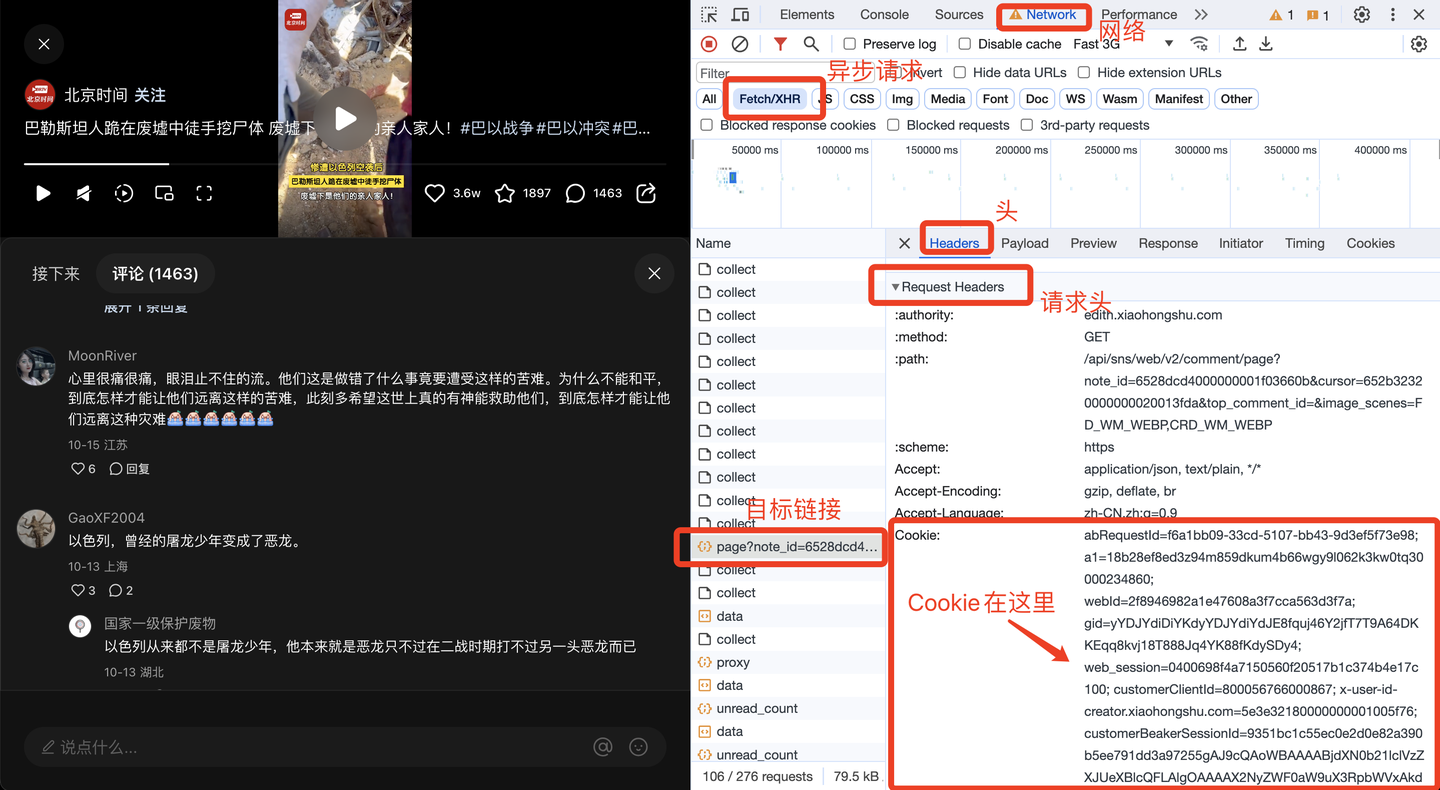

其中,Cookie很关键,需要定期更换。那么Cookie从哪里获得呢?方法如下:

下面,开发翻页逻辑。

由于我并不知道一共有多少页,往下翻多少次,所以采用while循环,直到触发终止条件,循环才结束。

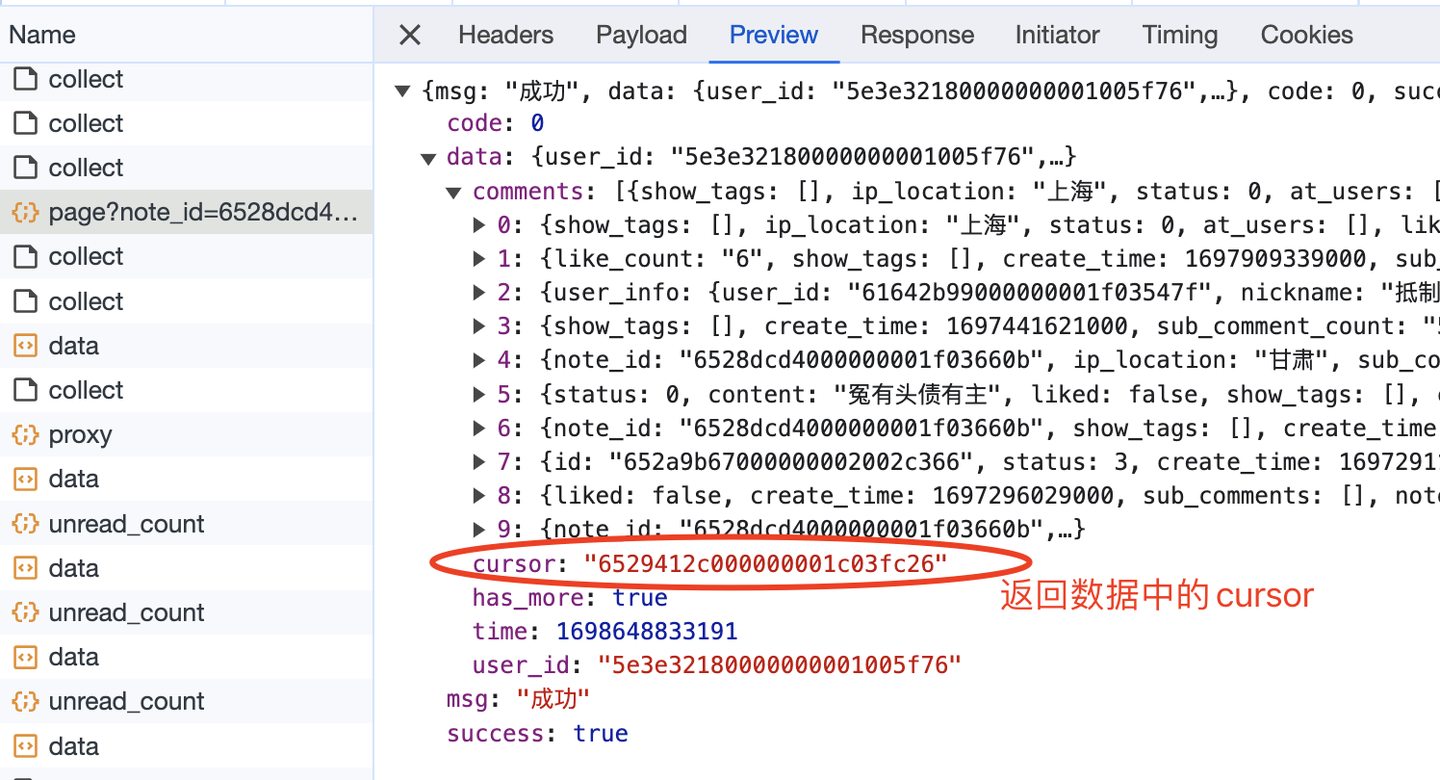

那么怎么定义终止条件呢?我注意到,在返回数据里有一个叫做"has_more"的参数,大胆猜测它的含义,是否有更多数据,正常情况它的值是true。如果它的值是false,代表没有更多数据了,即到达最后一页了,也就该终止循环了。

因此,核心代码结构应该是这样(以下是伪代码,主要是表达逻辑,请勿直接copy):

while True:

# 发送请求

r = requests.get(url, headers=h1)

# 解析数据

json_data = r.json()

# 逐条解析

for c in json_data['data']['comments']:

# 评论内容

content = c['content']

content_list.append(content)

# 保存数据到csv

。。。

# 判断终止条件

next_cursor = json_data['data']['cursor']

if not json_data['data']['has_more']:

print('没有下一页了,终止循环!')

break

page += 1

另外,还有一个关键问题,如何进行翻页。

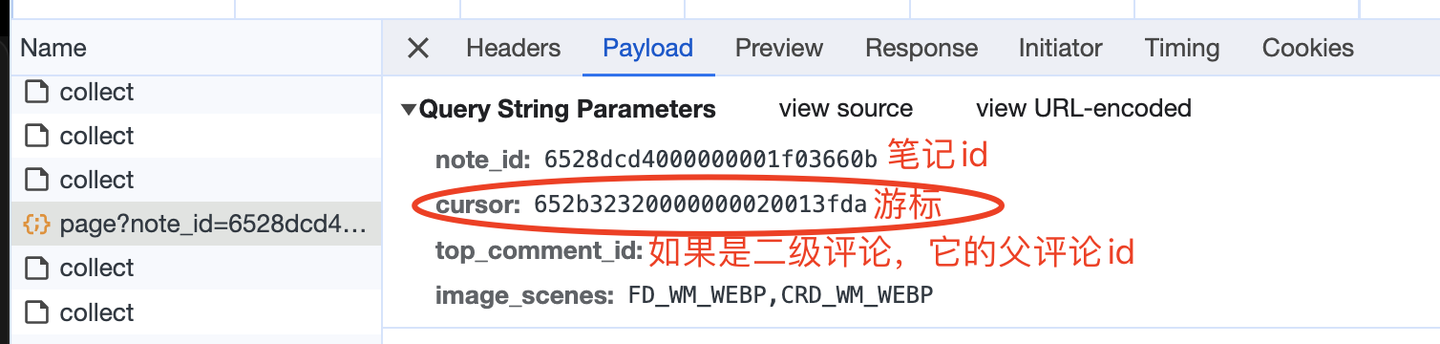

查看请求参数,如下:

这里的游标,就是向下翻页的依据,因为每次请求的返回数据中,也有一个cursor:

大胆猜测,返回数据中的cursor,就是给下一页请求用的cursor,所以,这部分的逻辑实现应该如下(以下是伪代码,主要是表达逻辑,请勿直接copy):

while True:

if page == 1:

url = 'https://edith.xiaohongshu.com/api/sns/web/v2/comment/page?note_id={}&top_comment_id=&image_scenes=FD_WM_WEBP,CRD_WM_WEBP'.format(

note_id)

else:

url = 'https://edith.xiaohongshu.com/api/sns/web/v2/comment/page?note_id={}&top_comment_id=&image_scenes=FD_WM_WEBP,CRD_WM_WEBP&cursor={}'.format(

note_id, next_cursor)

# 发送请求

r = requests.get(url, headers=h1)

# 解析数据

json_data = r.json()

# 得到下一页的游标

next_cursor = json_data['data']['cursor']

另外,我在第一章节提到,还爬到了二级评论及二级展开评论,怎么做到的呢?

经过分析,返回数据中有个节点sub_comment_count代表子评论数量,如果大于0代表该评论有子评论,进而可以从sub_comments节点中爬取二级评论。

其中,二级展开评论,请求参数中的root_comment_id代表父评论的id,其他逻辑同理,不再赘述。

最后,是顺理成章的保存csv数据:

# 保存数据到DF

df = pd.DataFrame(

{

'笔记链接': 'https://www.xiaohongshu.com/explore/' + note_id,

'页码': page,

'评论者昵称': nickname_list,

'评论者id': user_id_list,

'评论者主页链接': user_link_list,

'评论时间': create_time_list,

'评论IP属地': ip_list,

'评论点赞数': like_count_list,

'评论级别': comment_level_list,

'评论内容': content_list,

}

)

# 设置csv文件表头

if os.path.exists(result_file):

header = False

else:

header = True

# 保存到csv

df.to_csv(result_file, mode='a+', header=header, index=False, encoding='utf_8_sig')

至此,爬虫代码开发完毕。

完整代码中,还包含转换时间戳、随机等待时长、解析其他字段、保存Dataframe数据、多个笔记同时循环爬取等关键逻辑,详见演示视频。

三、演示视频

代码演示:【Python爬虫】用python爬了10000条小红书评论,以#巴勒斯坦#为例

我是@马哥python说,一名10年程序猿,持续分享python干货中!

【爬虫实战】用Python采集任意小红书笔记下的评论,爬了10000多条,含二级评论!的更多相关文章

- 【2022知乎爬虫】我用Python爬虫爬了2300多条知乎评论!

您好,我是 @马哥python说,一枚10年程序猿. 一.爬取目标 前些天我分享过一篇微博的爬虫: https://www.cnblogs.com/mashukui/p/16414027.html 但 ...

- Python简单网络爬虫实战—下载论文名称,作者信息(下)

在Python简单网络爬虫实战—下载论文名称,作者信息(上)中,学会了get到网页内容以及在谷歌浏览器找到了需要提取的内容的数据结构,接下来记录我是如何找到所有author和title的 1.从sou ...

- python核心编程一书笔记之第一篇

#!/usr/bin/env python# -*- coding:utf-8 -*- #env 是一个命令用来寻找系统中的python解释器.第二条解释使用utf-8编码 在类unix系统中允许py ...

- 简单python爬虫编写,Python采集妹子图!

疫情期间在家闲来无事,每天打游戏荒废了一段时间.我觉得自己不能在这么颓废下去,就立马起身写了一点python代码(本人只是python新手). 很多人学习python,不知道从何学起.很多人学习pyt ...

- python参考手册一书笔记之第一篇上

在python2和python3的版本差异很大输出hello world的方法在2里支持在3里就不支持了. print 'hello world' #在2中支持 print ('hello world ...

- python网络爬虫实战PDF高清完整版免费下载|百度云盘|Python基础教程免费电子书

点击获取提取码:vg1y python网络爬虫实战帮助读者学习Python并开发出符合自己要求的网络爬虫.网络爬虫,又被称为网页蜘蛛,网络机器人,是一种按照一定的规则,自动地抓取互联网信息的程序或者脚 ...

- selenium2自动化测试实战--基于Python语言

自动化测试基础 一. 软件测试分类 1.1 根据项目流程阶段划分软件测试 1.1.1 单元测试 单元测试(或模块测试)是对程序中的单个子程序或具有独立功能的代码段进行测试的过程. 1.1.2 集成测试 ...

- Python爬虫实战(4):豆瓣小组话题数据采集—动态网页

1, 引言 注释:上一篇<Python爬虫实战(3):安居客房产经纪人信息采集>,访问的网页是静态网页,有朋友模仿那个实战来采集动态加载豆瓣小组的网页,结果不成功.本篇是针对动态网页的数据 ...

- Python爬虫实战---抓取图书馆借阅信息

Python爬虫实战---抓取图书馆借阅信息 原创作品,引用请表明出处:Python爬虫实战---抓取图书馆借阅信息 前段时间在图书馆借了很多书,借得多了就容易忘记每本书的应还日期,老是担心自己会违约 ...

- Python爬虫实战八之利用Selenium抓取淘宝匿名旺旺

更新 其实本文的初衷是为了获取淘宝的非匿名旺旺,在淘宝详情页的最下方有相关评论,含有非匿名旺旺号,快一年了淘宝都没有修复这个. 可就在今天,淘宝把所有的账号设置成了匿名显示,SO,获取非匿名旺旺号已经 ...

随机推荐

- Lazy(Func<T>)的异常缓存问题

Lazy可以提供多线程环境下的安全保障,但是用不好也是会跳到坑里. 我这里使用Lazy<t>(Func<T>)来创建一个Lazy实例,然后在需要的地方访问它的Value属性,它 ...

- TCP 链接关闭 -- 客户端为什么需要60秒的time_wait状态

客户端主动关闭连接时( FIN-> ACK<- FIN<- ACK->),在发送最后一个ack后会进入TIME_WAIT状态,停留2个MSL时间,进入CLOSED状态 MSL就 ...

- GSAP 基础

GreenSock Animation Platform (GSAP) 是一个业界知名的动画库,它被1100多万个网站使用,有超过50%的获奖的网站都是用了它.不管是在原生环境中,还是任意的框架中,你 ...

- Angular 报错 Cannot Resolve Module

file:///E:/C#/angular-client/src/app/app.component.sass?FngResource 一些文件解释不到,最后发现是这个目录的问题,里面有个特殊的字符 ...

- SpringBoot 启动流程分析(寻找扩展点)

1.SpringBoot maven 依赖版本 <?xml version="1.0" encoding="UTF-8"?> <project ...

- 从module_init看内核模块

开篇 module_init是linux内核提供的一个宏, 可以用来在编写内核模块时注册一个初始化函数, 当模块被加载的时候, 内核负责执行这个初始化函数. 在编写设备驱动程序时, 使用这个宏看起来理 ...

- 新一代开源流数据湖平台Apache Paimon入门实操-上

@ 目录 概述 定义 核心功能 适用场景 架构原理 总体架构 统一存储 基本概念 文件布局 部署 环境准备 环境部署 实战 Catalog 文件系统 Hive Catalog 创建表 创建Catalo ...

- 下一代MES系统架构分析与选型参考

本文分享自华为云社区<工业互联网系列(十一):下一代MES系统架构分析与选型参考>,作者:云起MAE . 目前国内制造执行系统MES市场尚处于"功能机"混战年代,市场集 ...

- 语音合成技术3:HierVST: Hierarchical Adaptive Zero-shot Voice Style Transfer

HierVST: 分层自适应零样本语音风格转换 摘要: 尽管语音风格转换(VST)领域取得了快速进展,但最近的零样本VST系统仍然缺乏将新的说话者的语音风格进行转换的能力.在本文中,我们提出了Hier ...

- Go面经 | 成都Go面试这么卷?卷王介绍:游戏行业 3年经验 20k+

Go最新面经分享:算法.并发模型.缓存落盘.etcd.actor模型.epoll等等... 本文先分享2段面经,文末总结了关键问题的复盘笔记.一定要看到最后! 求职者情况 分享一下好友的最新面经. 简 ...