sqoop一些语法的使用

参数详细资料 观看这个博客

http://shiyanjun.cn/archives/624.html

Sqoop可以在HDFS/Hive和关系型数据库之间进行数据的导入导出,其中主要使用了import和export这两个工具。这两个工具非常强大,提供了很多选项帮助我们完成数据的迁移和同步。比如,下面两个潜在的需求:

- 业务数据存放在关系数据库中,如果数据量达到一定规模后需要对其进行分析或同统计,单纯使用关系数据库可能会成为瓶颈,这时可以将数据从业务数据库数据导入(import)到Hadoop平台进行离线分析。

- 对大规模的数据在Hadoop平台上进行分析以后,可能需要将结果同步到关系数据库中作为业务的辅助数据,这时候需要将Hadoop平台分析后的数据导出(export)到关系数据库。

这里,我们介绍Sqoop完成上述基本应用场景所使用的import和export工具,通过一些简单的例子来说明这两个工具是如何做到的。

import和export工具有些通用的选项,如下表所示:

| 选项 | 含义说明 |

--connect <jdbc-uri> |

指定JDBC连接字符串 |

--connection-manager <class-name> |

指定要使用的连接管理器类 |

--driver <class-name> |

指定要使用的JDBC驱动类 |

--hadoop-mapred-home <dir> |

指定$HADOOP_MAPRED_HOME路径 |

--help |

打印用法帮助信息 |

--password-file |

设置用于存放认证的密码信息文件的路径 |

-P |

从控制台读取输入的密码 |

--password <password> |

设置认证密码 |

--username <username> |

设置认证用户名 |

--verbose |

打印详细的运行信息 |

--connection-param-file <filename> |

可选,指定存储数据库连接参数的属性文件 |

数据导入工具import

import工具,是将HDFS平台外部的结构化存储系统中的数据导入到Hadoop平台,便于后续分析。我们先看一下import工具的基本选项及其含义,如下表所示:

| 选项 | 含义说明 |

--append |

将数据追加到HDFS上一个已存在的数据集上 |

--as-avrodatafile |

将数据导入到Avro数据文件 |

--as-sequencefile |

将数据导入到SequenceFile |

--as-textfile |

将数据导入到普通文本文件(默认) |

--boundary-query <statement> |

边界查询,用于创建分片(InputSplit) |

--columns <col,col,col…> |

从表中导出指定的一组列的数据 |

--delete-target-dir |

如果指定目录存在,则先删除掉 |

--direct |

使用直接导入模式(优化导入速度) |

--direct-split-size <n> |

分割输入stream的字节大小(在直接导入模式下) |

--fetch-size <n> |

从数据库中批量读取记录数 |

--inline-lob-limit <n> |

设置内联的LOB对象的大小 |

-m,--num-mappers <n> |

使用n个map任务并行导入数据 |

-e,--query <statement> |

导入的查询语句 |

--split-by <column-name> |

指定按照哪个列去分割数据 |

--table <table-name> |

导入的源表表名 |

--target-dir <dir> |

导入HDFS的目标路径 |

--warehouse-dir <dir> |

HDFS存放表的根路径 |

--where <where clause> |

指定导出时所使用的查询条件 |

-z,--compress |

启用压缩 |

--compression-codec <c> |

指定Hadoop的codec方式(默认gzip) |

--null-string <null-string> |

果指定列为字符串类型,使用指定字符串替换值为null的该类列的值 |

--null-non-string <null-string> |

如果指定列为非字符串类型,使用指定字符串替换值为null的该类列的值 |

bin/sqoop help 可以查看出帮助文档 英文的 看不懂

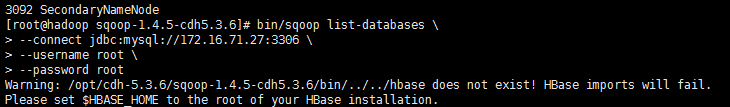

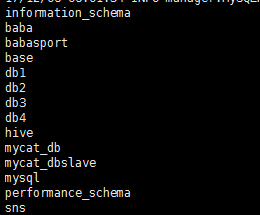

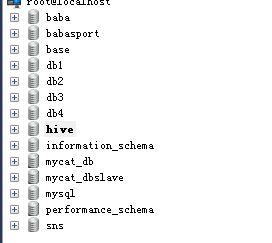

1:sqoop查看mysql有多少个数据库

bin/sqoop list-databases \

--connect jdbc:mysql://172.16.71.27:3306 \

--username root \

--password root

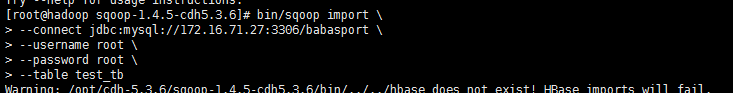

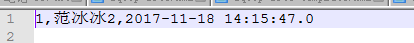

2:将mysql表中数据导入到hdfs中 imports

bin/sqoop import \

--connect jdbc:mysql://172.16.71.27:3306/babasport \

--username root \

--password root \

--table test_tb

ps:如果没有指定hdfs的目录 默认会将数据存到系统当前登录用户下 以表名称命名的文件夹下

ps : 复制的时候一定要注意下 \ 的位置 少个空格都会报错。。。 默认会有4个MapReduce在执行 这里测试数据只有2条 so。。。

数据默认以逗号隔开 可以根据需求进行指定

导入数据至指定hdfs目录

bin/sqoop import \

--connect jdbc:mysql://hadoop-senior.ibeifeng.com:3306/test \

--username root \

--password 123456 \

--table my_user \

--target-dir /user/beifeng/sqoop/imp_my_user \

--num-mappers 1

ps: num-mappers 1 指定执行MapReduce的个数为1

target-dir 指定hdfs的目录

sqoop 底层的实现就是MapReduce,import来说,仅仅运行Map Task

数据存储文件

* textfile

* orcfile

* parquet

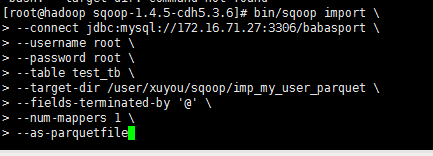

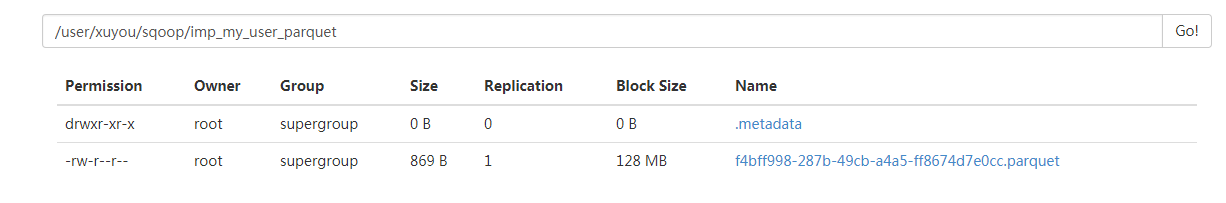

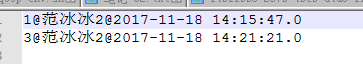

将数据按照parquet文件格式导出到hdfs指定目录

bin/sqoop import \

--connect jdbc:mysql://172.16.71.27:3306/babasport \

--username root \

--password root \

--table test_tb \

--target-dir /user/xuyou/sqoop/imp_my_user_parquet \

--fields-terminated-by '@' \

--num-mappers 1 \

--as-parquetfile

ps fields-terminated-by '@' 数据已@隔开

as-parquetfile 数据按照parquet文件格式存储

columns id,name 这个属性 可以只导入id已经name 这两个列的值

* 在实际的项目中,要处理的数据,需要进行初步清洗和过滤

* 某些字段过滤

* 条件

* join

bin/sqoop import \

--connect jdbc:mysql://hadoop-senior.ibeifeng.com:3306/test \

--username root \

--password 123456 \

--query 'select id, account from my_user where $CONDITIONS' \

--target-dir /user/beifeng/sqoop/imp_my_user_query \

--num-mappers 1

ps: query 这个属性代替了 table 可以通过用sql 语句来导出数据

(where $CONDITIONS' 是固定写法 如果需要条件查询可以 select id, account from my_user where $CONDITIONS' and id > 1)

压缩导入至hdfs的数据 可以指定格式

bin/sqoop import \

--connect jdbc:mysql://hadoop-senior.ibeifeng.com:3306/test \

--username root \

--password 123456 \

--table my_user \

--target-dir /user/beifeng/sqoop/imp_my_sannpy \

--delete-target-dir \

--num-mappers 1 \

--compress \

--compression-codec org.apache.hadoop.io.compress.SnappyCodec \

--fields-terminated-by '\t'

ps:compress 这个属性 是 开启压缩功能

compression-codec 这个属性是 指定压缩的压缩码 本次是SnappyCodec

sqoop一些语法的使用的更多相关文章

- hadoop问题集(1)

参考: http://dataunion.org/22887.html 1.mapreduce_shuffle does not exist 执行任何时报错: Container launch ...

- sqoop的基本语法详解及可能遇到的错误

1 sqoop介绍 Apache Sqoop是专为Apache Hadoop和结构化数据存储如关系数据库之间的数据转换工具的有效工具.你可以使用Sqoop从外部结构化数据存储的数据导入到Hadoop分 ...

- Oozie分布式任务的工作流——Sqoop篇

Sqoop的使用应该是Oozie里面最常用的了,因为很多BI数据分析都是基于业务数据库来做的,因此需要把mysql或者oracle的数据导入到hdfs中再利用mapreduce或者spark进行ETL ...

- Sqoop 结合多种系统的具体应用

Sqoop与HDFS结合 下面我们结合 HDFS,介绍 Sqoop 从关系型数据库的导入和导出. Sqoop import 它的功能是将数据从关系型数据库导入 HDFS 中,其流程图如下所示. 我们来 ...

- Hive学习之七《 Sqoop import 从关系数据库抽取到HDFS》

一.什么是sqoop Sqoop是一款开源的工具,主要用于在Hadoop(Hive)与传统的数据库(mysql.postgresql...)间进行数据的传递,可以将一个关系型数据库(例如 :MySQL ...

- sqoop关系型数据迁移原理以及map端内存为何不会爆掉窥探

序:map客户端使用jdbc向数据库发送查询语句,将会拿到所有数据到map的客户端,安装jdbc的原理,数据全部缓存在内存中,但是内存没有出现爆掉情况,这是因为1.3以后,对jdbc进行了优化,改进j ...

- sqoop数据迁移(基于Hadoop和关系数据库服务器之间传送数据)

1:sqoop的概述: (1):sqoop是apache旗下一款“Hadoop和关系数据库服务器之间传送数据”的工具.(2):导入数据:MySQL,Oracle导入数据到Hadoop的HDFS.HIV ...

- Flume+Sqoop+Azkaban笔记

大纲(辅助系统) 离线辅助系统 数据接入 Flume介绍 Flume组件 Flume实战案例 任务调度 调度器基础 市面上调度工具 Oozie的使用 Oozie的流程定义详解 数据导出 sqoop基础 ...

- Sqoop 使用详解(内含对官方文档的解析)

Sqoop 是 Cloudera 公司创造的一个数据同步工具,现在已经完全开源了. 目前已经是 hadoop 生态环境中数据迁移的首选,另外还有 ali 开发的 DataX 属于同类型工具,由于社区的 ...

随机推荐

- 把a文件删除b文件中的相同的行

grep -vxFf b.txt a.txt > newa.txt 更好的方法是 comm - - b.txt a.txt > newa.txt 来自Tool in unix to sub ...

- DNS服务器的解析

---恢复内容开始--- DNS前言: 英特网作为域名和IP地址相互映射的一个分不式数据库,能够使用户更方便的访问互联网.而不用去记住能够被机器直接读取的IP地址的过程叫做域名解析(或主机名解析).D ...

- linux php 访问sql server设置

1.安装freeTDS wget ftp://ftp.freetds.org/pub/freetds/stable/freetds-stable.tgz 1.1.进入到你下载的目录然后解压.tar - ...

- 如何更好的使用JAVA线程池

这篇文章结合Doug Lea大神在JDK1.5提供的JCU包,分别从线程池大小参数的设置.工作线程的创建.空闲线程的回收.阻塞队列的使用.任务拒绝策略.线程池Hook等方面来了解线程池的使用,其中涉及 ...

- 【Linux笔记】CentOS&RHEL YUM基础知识

以下内容收集自网络,以作参考. 一.YUM是什么 YUM = Yellow dog Updater, Modified. 主要功能是更方便的添加/删除/更新RPM包. 它能自动解决包的倚赖性问题. 它 ...

- node+express搭建个人网站(1)

我的个人网站 http://yangchaojie.top/ 首先了解一下node Node.js 是一个基于 Chrome V8 引擎的 JavaScript 运行环境. Node.js 使用了一个 ...

- 第134天:移动web开发的一些总结(二)

1.响应式布局 开发一个页面,在所有的设备上都能够完美展示. 媒体查询:@media screen and (max-width:100px) { } 媒体类型:screen(屏幕) print(打印 ...

- jquery 添加与删除的规律 当要添加时候要定位到自己的父元素 当要删除时候 通过事件函数传入的this找到自己的父元素进行删除

jquery 添加与删除的规律 当要添加时候要定位到自己的父元素 当要删除时候 通过事件函数传入的this找到自己的父元素进行删除

- 3.5 面向连接的运输:TCP

3.5 面向连接的运输:TCP 3.5.1 TCP连接 TCP进行传输之间要进行三次握手建立连接,这个连接不是物理意义上的有一根电线连接,而是应用端两个应用,在逻辑上是已经建立连接了. TCP 不需 ...

- bzoj1912【Apio2010】patrol 巡逻

题解: 显然需要分类讨论了,首先理解k==0即原图时按照dfs序来说 , 每条边至少走两次: k==1,相当于可以省去dfs回溯时第二次走过某条路径的浪费,所以答案是k==0的答案-直径 : k==2 ...