Normalization Methods

概

整理一下各种normalization方法.

主要内容

对于每一层, 可以简化的理解为:

\]

其中\(h^{l}\)是前一层的输入, \(W, b\)分别为该层的权重和偏置, \(f\)是对应的激活函数.

但是仅按照这种方式搭建的网络训练不稳定还非常慢, 这也是为什么各种normalization方法被提出的初衷.

这些方法可以统一为:

\]

这里用\(g(\cdot)\)表示某种normalization方法.

为了方便起见, 另外令

y = g(x).

\]

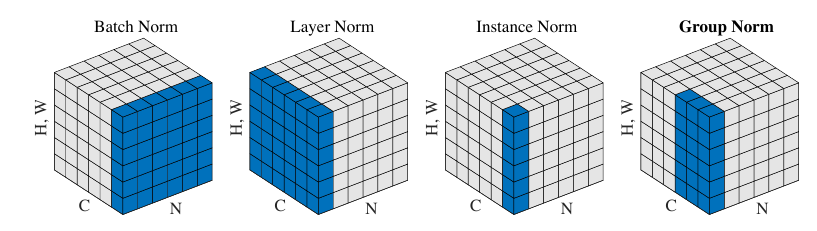

总的示意图如下(图片来自Group Normalization):

Batch Normalization

该normalization方法思想是最朴素的, 即每一次我们都recentering一下数据:

\]

这里\(\mu,\sigma\)分别表示\(x\)的均值和标准差.

但是上述的标准化存在均值和标准差的估计问题, 故在训练中我们取一个batch作为估计:

\]

其中\(x^i, i=1,2,\cdots, n\)为一个batch的数据.

在实际中, 为了安全和可扩展, 采取如下形式:

\]

其中\(\gamma, \beta\)为weight 和 bias, \(\epsilon\)常取1e-5.

在训练中, 每次forward pass都会更新running_mean \(\mu\), running_var \(\sigma^2\):

\sigma^2 = (1 - m) \cdot \sigma^2 + m \cdot \hat{\sigma}^2.

\]

这里\(m\)是用于滑动平均的momentum, 这里采取这种形式是为了和Pytorch的实现保持一致, 其选择\(m=0.1\).

在evaluation中, 我们变使用\(\mu, \sigma^2\)来normalization:

\]

注: 在处理\(dim=1\)(即向量数据)的时候, 均值和方差的计算就是普通的, 但是\(dim=2\)的时候, 比如常见的卷积mapping, 其结构为\(N \times C \times H \times W\), 则其均值方差是对于每一个通道计算的, 即\(\mu,\sigma \in \mathbb{R}^C\), 同理\(\gamma, \beta \in \mathbb{R}^C\).

Layer Normalization

显然, batch normalization的batch size 不能太小, 而layer normalization 可以处理这一点, 因为它是针对单个样本而言的.

其同样采取

\]

的形式, 只是

\]

这里\(x_i\)表示\(x\)的第\(i\)个分量, 特征维度为\(H\).

注: 在Pytorch的实现中, \(\gamma, \beta\)都是element-wise的, 即如果我们选取\(C \times H \times W\), 则\(\gamma, \beta \in \mathbb{R}^{C \times H \times W}\).

Instance Normalization

instance normalization 主要是用于消除图片之间的contrast而提出的:

\]

注意, instance的normalization同样是基于单个样本而言的, 对于卷积层而言\(N \times C \times H \times W\):

\hat{\sigma} := \sqrt{\frac{1}{HW}\sum_i \sum_j (x_{ij} - \hat{\mu})^2},

\]

显然\(\hat{\mu}, \hat{\sigma} \in \mathbb{R}^C\). 对于向量数据而言, 和layernorm其实是一致的.

注: instance normalization 通常没有放射变换(即舍弃\(\gamma, \beta\)).

Group Normalization

GN则是根据通道\(C\)分成\(G\)个group, 对每一个group沿着\(H, W\)方向估计:

\hat{\sigma}_g := \sqrt{\frac{1}{(C / G) \cdot HW} \sum_{i=1}^H\sum_{j=1}^W\sum_{k=(g - 1)\cdot \frac{C}{G} + 1}^{g * \frac{C}{G}} (x_{kij} - \hat{\mu}_g)^2}, \\

g = 1, 2, \cdots, G.

\]

注: 这里假设\(C\)能够整除\(G\).

注: 当\(G=C\)的时候, GN 就是 IN, \(G=1\)的时候, GN就是LN.

Normalization Methods的更多相关文章

- 机器学习中的标准化方法(Normalization Methods)

希望这篇随笔能够从一个实用化的角度对ML中的标准化方法进行一个描述.即便是了解了标准化方法的意义,最终的最终还是要:拿来主义,能够在实践中使用. 动机:标准化的意义是什么? 我们为什么要标准化?想象我 ...

- JabRef 文献管理软件

JabRef 文献管理软件简明教程 大多只有使用LaTeX撰写科技论文的研究人员才能完全领略到JabRef的妙不可言,但随着对Word写作平台上BibTeX4Word插件的开发和便利应用,使用Word ...

- 大规模视觉识别挑战赛ILSVRC2015各团队结果和方法 Large Scale Visual Recognition Challenge 2015

Large Scale Visual Recognition Challenge 2015 (ILSVRC2015) Legend: Yellow background = winner in thi ...

- LaTeX 的对参考文献的处理

LaTeX 的对参考文献的处理实在是非常的方便,我用过几次,有些体会,写出来供大家 参考.当然,自己的功力还不够深,有些地方问题一解决就罢手了,没有细究. LaTeX 对参考文献的处理有这 ...

- BIBTeX制作参考文献

一篇关于Latex的参考文献的好文章!基本问题都能解答~ 文章来源:http://www.cnblogs.com/longdouhzt/archive/2012/06/21/2557965.html ...

- latex bib format

LaTeX 的对参考文献的处理实在是非常的方便,我用过几次,有些体会,写出来供大家参考.当然,自己的功力还不够深,有些地方问题一解决就罢手了,没有细究. LaTeX 对参考文献的处理有这么一些优点: ...

- Spiking-YOLO : 前沿性研究,脉冲神经网络在目标检测的首次尝试 | AAAI 2020

论文提出Spiking-YOLO,是脉冲神经网络在目标检测领域的首次成功尝试,实现了与卷积神经网络相当的性能,而能源消耗极低.论文内容新颖,比较前沿,推荐给大家阅读 来源:晓飞的算法工程笔记 公众 ...

- Video processing systems and methods

BACKGROUND The present invention relates to video processing systems. Advances in imaging technology ...

- 数据预处理中归一化(Normalization)与损失函数中正则化(Regularization)解惑

背景:数据挖掘/机器学习中的术语较多,而且我的知识有限.之前一直疑惑正则这个概念.所以写了篇博文梳理下 摘要: 1.正则化(Regularization) 1.1 正则化的目的 1.2 正则化的L1范 ...

随机推荐

- linux "/tmp/crontab.14QJ49":1: bad minute errors in crontab file, can't install" 错误

目录 报错及原因 crontab语句格式 报错及原因 这个错误的原因是crontab格式错误 "/tmp/crontab.sdXvj4":5: bad minute errors ...

- ASP.NET Core中使用固定窗口限流

算法原理 固定窗口算法又称计数器算法,是一种简单的限流算法.在单位时间内设定一个阈值和一个计数值,每收到一个请求则计数值加一,如果计数值超过阈值则触发限流,如果达不到则请求正常处理,进入下一个单位时间 ...

- 商业爬虫学习笔记day5

一. 发送post请求 import requests url = "" # 发送post请求 data = { } response = requests.post(url, d ...

- OC-引用计数器,内存管理,野指针

总结 全局断点 →-->+-->Add Exception Breakpoint 开启僵尸监听 打开Edit scheme -->Diagnostics-->Enable Zo ...

- OpenStack之四: keystone验证服务(端口5000)

#官网地址:https://docs.openstack.org/keystone/stein/install/keystone-install-rdo.html #:创建库,并授权 MariaDB ...

- I/O流之字节流

在程序中所有的数据都是以流的形式进行传输或保存的,程序需要数据时要使用输入流读取数据,而当程序需要将一些数据保存起来时,就要使用输出流完成对于操作文件内容,要进行文件内容的操作就需要通过Java提供的 ...

- 【C#】【MySQL】【GridView】删除出现Parameter index is out of range

[编程语言]C# [数据库]MySQL [控件]GridView [问题描述]GridView控件中自带[删除],[编辑],[选择],三个按钮[编辑],[选择]正常使用,但是在使用删除时,却报错Par ...

- Nginx HTTP块配置

1 配置块的嵌套 http { upstream {...} split_clients {...} map {...} geo {...} server { if () {...} location ...

- [BUUCTF]REVERSE——[FlareOn4]login

[FlareOn4]login 附件 步骤: 是个网页,直接打开,查看网页源码 百度了几个函数 charCodeAt(0)是返回当前字符的Unicode 编码 String.fromCharCode返 ...

- 成本计划的输出(Project)

<Project2016 企业项目管理实践>张会斌 董方好 编著 所谓"输出"就是把数据摆出来让人看,好吧,这种"看",可以直接在屏幕上看,也可以打 ...