Hadoop【MR的分区、排序、分组】

[toc]

一.分区

问题:按照条件将结果输出到不同文件中

自定义分区步骤

1.自定义继承Partitioner类,重写getPartition()方法

2.在job驱动Driver中设置自定义的Partitioner

3.在Driver中根据分区数设置reducetask数

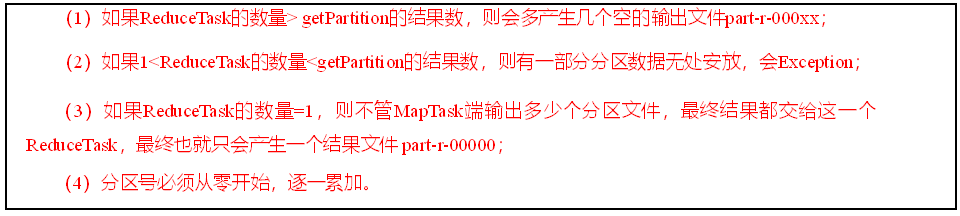

分区数和reducetask关系

案例实操

将统计结果按照手机归属地不同省份输出到不同文件中(分区),手机号136、137、138、139开头都分别放到一个独立的4个文件中,其他开头的放到一个文件中

(1)自定义分区类

MyPartitioner.class

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Partitioner;

public class MyPartioner extends Partitioner<Text, FlowBean> {

@Override

public int getPartition(Text text, FlowBean flowBean, int numPartitions) {

String phone = text.toString();

if (phone.startsWith("136")) {

return 0;

} else if (phone.startsWith("137")) {

return 1;

} else if (phone.startsWith("138")) {

return 2;

}else if (phone.startsWith("139")){

return 3;

}else {

return 4;

}

}

}

(2)在Driver类设置分区和reducetask数

//设置自定义partitioner

job.setPartitionerClass(MyPartioner.class);

//设置reducetask数量

job.setNumReduceTasks(5);

二.全排序、分区排序、分组

当自定义的对象作为key,按照指定条件进行排序

实现排序的2种方式

1.对象实现WritableComparable接口

实现WritableComparable接口,重写compareTo方法,就可以实现排序(二次排序)

public class OrderBean implements WritableComparable<OrderBean> {

//自定义排序,先按pid升序,再按pname降序

@Override

public int compareTo(OrderBean o) {

int compare = this.pid.compareTo(o.pid);

if (compare == 0) {

return -this.pname.compareTo(o.pname);

}

return compare;

}

}

2.继承WritableComparator类

自定义比较器继承WritableComparator类,父类构造方法增加需要比较的Bean对象,

//继承WritableComparator类

public class MyGroupCompartor extends WritableComparator {

public MyGroupCompartor(){

//增加Bean对象

super(OrderBean.class,true);

}

// 对Bean的排序方法

@Override

public int compare(WritableComparable a, WritableComparable b) {

OrderBean oa = (OrderBean) a;

OrderBean ob = (OrderBean) b;

return oa.getPid().compareTo(ob.getPid());

}

}

全排序

不分区,只有一个reducetask,针对Key进行排序

分区排序

针对key全排序,然后针对key进行分区

辅助排序【自定义分组】

分析:已经对key进行排序,比如key对象为OrderBean的排序是id,pname的二次排序

,在进入reduce()的分组希望是id相同的进入一组,那么就需要自定义分组针对id进行分组

OrderBean

id pname amount

1 小米

1 2400

1 1500

2 华为

2 2400

2 3400

自定义分组比较器

MyGroupCompartor.class

import org.apache.hadoop.io.WritableComparable;

import org.apache.hadoop.io.WritableComparator;

public class MyGroupCompartor extends WritableComparator {

public MyGroupCompartor(){

super(OrderBean.class,true);

}

@Override

public int compare(WritableComparable a, WritableComparable b) {

OrderBean oa = (OrderBean) a;

OrderBean ob = (OrderBean) b;

return oa.getPid().compareTo(ob.getPid());

}

}

在Driver类中声明自定义分组

job.setGroupingComparatorClass(MyGroupCompartor.class);

Hadoop【MR的分区、排序、分组】的更多相关文章

- Hadoop Mapreduce分区、分组、二次排序过程详解[转]

原文地址:Hadoop Mapreduce分区.分组.二次排序过程详解[转]作者: 徐海蛟 教学用途 1.MapReduce中数据流动 (1)最简单的过程: map - reduce (2) ...

- 2 weekend110的hadoop的自定义排序实现 + mr程序中自定义分组的实现

我想得到按流量来排序,而且还是倒序,怎么达到实现呢? 达到下面这种效果, 默认是根据key来排, 我想根据value里的某个排, 解决思路:将value里的某个,放到key里去,然后来排 下面,开始w ...

- Hadoop Mapreduce分区、分组、二次排序

1.MapReduce中数据流动 (1)最简单的过程: map - reduce (2)定制了partitioner以将map的结果送往指定reducer的过程: map - partiti ...

- Hadoop Mapreduce分区、分组、二次排序过程详解

转载:http://blog.tianya.cn/m/post.jsp?postId=53271442 1.MapReduce中数据流动 (1)最简单的过程: map - reduce (2)定制了 ...

- Hadoop日记Day18---MapReduce排序分组

本节所用到的数据下载地址为:http://pan.baidu.com/s/1bnfELmZ MapReduce的排序分组任务与要求 我们知道排序分组是MapReduce中Mapper端的第四步,其中分 ...

- 9.2.3 hadoop reduce端连接-分区分组聚合

1.1.1 reduce端连接-分区分组聚合 reduce端连接则是利用了reduce的分区功能将stationid相同的分到同一个分区,在利用reduce的分组聚合功能,将同一个st ...

- 【Hadoop】Hadoop MR 自定义分组 Partition机制

1.概念 2.Hadoop默认分组机制--所有的Key分到一个组,一个Reduce任务处理 3.代码示例 FlowBean package com.ares.hadoop.mr.flowgroup; ...

- 【Hadoop】Hadoop MR 自定义排序

1.概念 2.代码示例 FlowSort package com.ares.hadoop.mr.flowsort; import java.io.IOException; import org.apa ...

- Hadoop MapReduce 二次排序原理及其应用

关于二次排序主要涉及到这么几个东西: 在0.20.0 以前使用的是 setPartitionerClass setOutputkeyComparatorClass setOutputValueGrou ...

随机推荐

- 测试开发【提测平台】分享13-远程搜索和路由$route使用实现新建提测需求

微信搜索[大奇测试开],关注这个坚持分享测试开发干货的家伙. 本篇继续提测平台开发,按惯例先给出学习的思维导图,以便快速了解学习知识和平台功能实现的重点. 基本知识点学习 远程搜索 显示的数据通过输入 ...

- Oracle 11G单机 无网络环境静默安装

参考文章https://blog.csdn.net/xiaoyu19910321/article/details/89856514 环境centos 7.6最小化安装 1,关闭防护墙selinux,配 ...

- es6实现继承详解

ES6中通过class关键字,定义类 class Parent { constructor(name,age){ this.name = name; this.age = age; } speakSo ...

- Redis源码分析(skiplist)

源码版本: redis-4.0.1 源码位置: server.h :zskiplistNode和zskiplist的数据结构定义. t_zset.c: 以zsl开头的函数是SkipList相关的操作函 ...

- Git基本教程

git的发展 Git 两周开发 Linus开发,主要是为了管理大量人员维护代码 Git分布式版本控制系统 基本命令 history:查看之前用过的命令 vimtutor git配置 查看配置 git ...

- Bootstrap-2栅格系统

栅格系统(使用最新版本bootstrap) Grid options(网格配置) Responsive classes(响应式class) Gutters(间距) Alignment(对齐方式) Re ...

- SpringCloud config native 配置

1.概述 最近项目使用springCloud 框架,使用config搭建git作为配置中心. 在私有化部署中,出现很多比较麻烦的和鸡肋的设计. 每次部署都需要安装gitlab 有些环境安装完gitla ...

- 生产者消费者模型及Golang简单实现

简介:介绍生产者消费者模型,及go简单实现的demo. 一.生产者消费者模型 生产者消费者模型:某个模块(函数等〉负责产生数据,这些数据由另一个模块来负责处理(此处的模块是广义的,可以是类.函数.协程 ...

- Spark-StructuredStreaming 下的checkpointLocation分析以及对接 Grafana 监控和提交Kafka Lag 监控

一.Spark-StructuredStreaming checkpointLocation 介绍 Structured Streaming 在 Spark 2.0 版本于 2016 年引入, 是基于 ...

- [cf10E]Greedy Change

对于$w$的表示方案,可以用序列描述,即$x_{i}$表示第$i$种货币的数量 贪心策略得到的方案即是(对应序列)字典序最大的方案,并定义最优策略得到的方案为在最小化货币总数的基础上,(对应序列)字典 ...