Hbase(三) hbase协处理器与二级索引

一、协处理器—Coprocessor

1、 起源

Hbase 作为列族数据库最经常被人诟病的特性包括:无法轻易建立“二级索引”,难以执 行求和、计数、排序等操作。比如,在旧版本的(<0.92)Hbase 中,统计数据表的总行数,需 要使用 Counter 方法,执行一次 MapReduce Job 才能得到。虽然 HBase 在数据存储层中集成

了 MapReduce,能够有效用于数据表的分布式计算。然而在很多情况下,做一些简单的相 加或者聚合计算的时候, 如果直接将计算过程放置在 server 端,能够减少通讯开销,从而获 得很好的性能提升。于是, HBase 在 0.92 之后引入了协处理器(coprocessors),实现一些激动

人心的新特性:能够轻易建立二次索引、复杂过滤器(谓词下推)以及访问控制等。

2、协处理器有两种: observer 和 endpoint

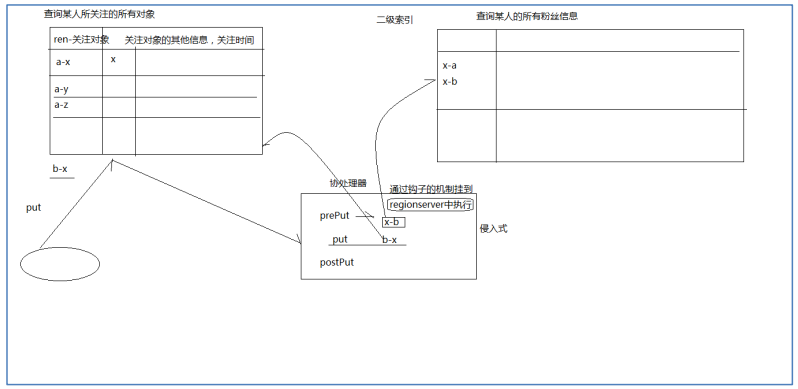

(1) Observer 类似于传统数据库中的触发器,当发生某些事件的时候这类协处理器会被 Server 端调用。Observer Coprocessor 就是一些散布在 HBase Server 端代码中的 hook 钩子, 在固定的事件发生时被调用。比如: put 操作之前有钩子函数 prePut,该函数在 put 操作

执行前会被 Region Server 调用;在 put 操作之后则有 postPut 钩子函数

以 HBase0.92 版本为例,它提供了三种观察者接口:

● RegionObserver:提供客户端的数据操纵事件钩子: Get、 Put、 Delete、 Scan 等。

● WALObserver:提供 WAL 相关操作钩子。

● MasterObserver:提供 DDL-类型的操作钩子。如创建、删除、修改数据表等。

到 0.96 版本又新增一个 RegionServerObserver

下图是以 RegionObserver 为例子讲解 Observer 这种协处理器的原理:

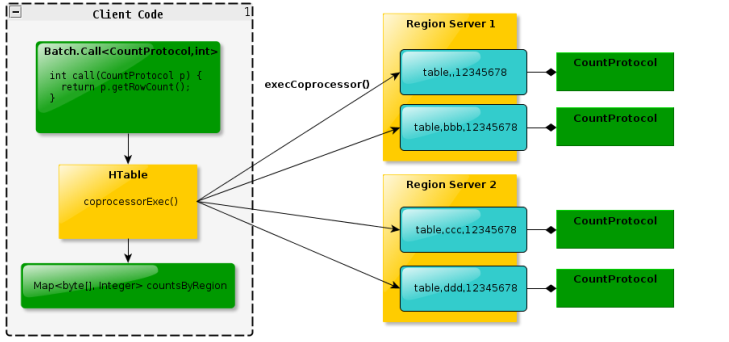

(2) Endpoint 协处理器类似传统数据库中的存储过程,客户端可以调用这些 Endpoint 协处 理器执行一段 Server 端代码,并将 Server 端代码的结果返回给客户端进一步处理,最常 见的用法就是进行聚集操作。如果没有协处理器,当用户需要找出一张表中的最大数据,即

max 聚合操作,就必须进行全表扫描,在客户端代码内遍历扫描结果,并执行求最大值的 操作。这样的方法无法利用底层集群的并发能力,而将所有计算都集中到 Client 端统一执 行,势必效率低下。利用 Coprocessor,用户可以将求最大值的代码部署到 HBase Server 端,

HBase 将利用底层 cluster 的多个节点并发执行求最大值的操作。即在每个 Region 范围内 执行求最大值的代码,将每个 Region 的最大值在 Region Server 端计算出,仅仅将该 max 值返回给客户端。在客户端进一步将多个 Region 的最大值进一步处理而找到其中的最大值。

这样整体的执行效率就会提高很多

下图是 EndPoint 的工作原理:

(3)总结

Observer 允许集群在正常的客户端操作过程中可以有不同的行为表现

Endpoint 允许扩展集群的能力,对客户端应用开放新的运算命令

observer 类似于 RDBMS 中的触发器,主要在服务端工作

endpoint 类似于 RDBMS 中的存储过程,主要在 client 端工作

observer 可以实现权限管理、优先级设置、监控、 ddl 控制、 二级索引等功能

endpoint 可以实现 min、 max、 avg、 sum、 distinct、 group by 等功能

二、协处理器加载方式

协处理器的加载方式有两种,我们称之为静态加载方式( Static Load) 和动态加载方式 ( Dynamic Load)。 静态加载的协处理器称之为 System Coprocessor,动态加载的协处理器称 之为 Table Coprocessor

1、静态加载

通过修改 hbase-site.xml 这个文件来实现, 启动全局 aggregation,能过操纵所有的表上 的数据。只需要添加如下代码:

<property>

<name>hbase.coprocessor.user.region.classes</name>

<value>org.apache.hadoop.hbase.coprocessor.AggregateImplementation</value>

</property>

为所有 table 加载了一个 cp class,可以用” ,”分割加载多个 class

2、动态加载

启用表 aggregation,只对特定的表生效。通过 HBase Shell 来实现。

disable 指定表。 hbase> disable 'mytable'

添加 aggregation

hbase> alter 'mytable', METHOD => 'table_att','coprocessor'=>

'|org.apache.Hadoop.hbase.coprocessor.AggregateImplementation||'

重启指定表 hbase> enable 'mytable'

3、协处理器卸载

三、二级索引案例

row key 在 HBase 中是以 B+ tree 结构化有序存储的,所以 scan 起来会比较效率。单表以 row key 存储索引, column value 存储 id 值或其他数据 ,这就是 Hbase 索引表的结构。

由于 HBase 本身没有二级索引( Secondary Index)机制,基于索引检索数据只能单纯地依靠 RowKey,为了能支持多条件查询,开发者需要将所有可能作为查询条件的字段一一拼接到 RowKey 中,这是 HBase 开发中极为常见的做法

在社交类应用中,经常需要快速检索各用户的关注列表 guanzhu,同时,又需要反向检索各 种户的粉丝列表 fensi,为了实现这个需求,最佳实践是建立两张互为反向的表:

插入一条关注信息时,为了减轻应用端维护反向索引表的负担,可用 Observer 协处理器实 现:

实现步骤:

(1)代码:

package com.ghgj.hbase;

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.Cell;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.client.Durability;

import org.apache.hadoop.hbase.client.HTable;

import org.apache.hadoop.hbase.client.Put;

import org.apache.hadoop.hbase.coprocessor.BaseRegionObserver;

import org.apache.hadoop.hbase.coprocessor.ObserverContext;

import org.apache.hadoop.hbase.coprocessor.RegionCoprocessorEnvironment;

import org.apache.hadoop.hbase.regionserver.wal.WALEdit;

public class TestCoprocessor extends BaseRegionObserver {

static Configuration config = HBaseConfiguration.create();

static HTable table = null;

static{

config.set("hbase.zookeeper.quorum",

"hadoop01:2181,hadoop02:2181,hadoop03:2181,hadoop04:2181,hadoop05:2181");

try {

table = new HTable(config, "guanzhu");

} catch (Exception e) {

e.printStackTrace();

}

}

@Override

public void prePut(ObserverContext<RegionCoprocessorEnvironment> e,

Put put, WALEdit edit, Durability durability) throws IOException {

// super.prePut(e, put, edit, durability);

byte[] row = put.getRow();

Cell cell = put.get("f1".getBytes(), "from".getBytes()).get(0);

Put putIndex = new

Put(cell.getValueArray(),cell.getValueOffset(),cell.getValueLength());

putIndex.addColumn("f1".getBytes(), "from".getBytes(), row);

table.put(putIndex);

table.close();

}

}

(2)打成 jar 包( cppp.jar),上传到 hdfs 中的 hbasecp 目录下

hadoop fs -put cppp.jar /hbasecp

(3)建hbase表,按以下顺序操作

(4)现在插入数据进行验证,命令行和代码都可以

testput("fensi","c","f1","from","b");

Hbase(三) hbase协处理器与二级索引的更多相关文章

- HBase协处理器同步二级索引到Solr(续)

一. 已知的问题和不足二.解决思路三.代码3.1 读取config文件内容3.2 封装SolrServer的获取方式3.3 编写提交数据到Solr的代码3.4 拦截HBase的Put和Delete操作 ...

- HBase协处理器同步二级索引到Solr

一. 背景二. 什么是HBase的协处理器三. HBase协处理器同步数据到Solr四. 添加协处理器五. 测试六. 协处理器动态加载 一. 背景 在实际生产中,HBase往往不能满足多维度分析,我们 ...

- HBase 协处理器实现二级索引

HBase在0.92之后引入了coprocessors,提供了一系列的钩子,让我们能够轻易实现访问控制和二级索引的特性.下面简单介绍下两种coprocessors,第一种是Observers,它实际类 ...

- HBase学习(四) 二级索引 rowkey设计

HBase学习(四) 一.HBase的读写流程 画出架构 1.1 HBase读流程 Hbase读取数据的流程:1)是由客户端发起读取数据的请求,首先会与zookeeper建立连接2)从zookeepe ...

- HBase 二级索引与Coprocessor协处理器

Coprocessor简介 (1)实现目的 HBase无法轻易建立“二级索引”: 执行求和.计数.排序等操作比较困难,必须通过MapReduce/Spark实现,对于简单的统计或聚合计算时,可能会因为 ...

- Phoneix(三)HBase集成Phoenix创建二级索引

一.Hbase集成Phoneix 1.下载 在官网http://www.apache.org/dyn/closer.lua/phoenix/中选择提供的镜像站点中下载与安装的HBase版本对应的版本. ...

- HBase协处理器的使用(添加Solr二级索引)

给HBase添加一二级索引,HBase协处理器结合solr 代码如下 package com.hbase.coprocessor; import java.io.IOException; import ...

- HBase 二级索引与Join

二级索引与索引Join是Online业务系统要求存储引擎提供的基本特性.RDBMS支持得比较好,NOSQL阵营也在摸索着符合自身特点的最佳解决方案. 这篇文章会以HBase做为对象来探讨如何基于Hba ...

- 085 HBase的二级索引,以及phoenix的安装(需再做一次)

一:问题由来 1.举例 有A列与B列,分别是年龄与姓名. 如果想通过年龄查询姓名. 正常的检索是通过rowkey进行检索. 根据年龄查询rowkey,然后根据rowkey进行查找姓名. 这样的效率不高 ...

随机推荐

- Android 8.0 NavigationBar 颜色问题。

1. packages/SystemUI/src/com/android/systemui/statusbar/phone/LightBarController.java public void on ...

- [转]Zookeeper系列(一)

一.ZooKeeper的背景 1.1 认识ZooKeeper ZooKeeper---译名为“动物园管理员”.动物园里当然有好多的动物,游客可以根据动物园提供的向导图到不同的场馆观赏各种类型的动物,而 ...

- PS1修改xshell命令行样式

linux 其他知识目录 在/root/.bashrc下加入如下代码. export PS1='\n\e[1;37m[\e[m\e[1;32m\u\e[m\e[1;33m@\e[m\e[1;35m\H ...

- [Ubuntu] sogou中文输入法安装

I install sogou 中文输入法 successfully, after following below steps: 1. install sogou pingyin by deb pac ...

- [leetcode-914-X of a Kind in a Deck of Cards]

In a deck of cards, each card has an integer written on it. Return true if and only if you can choos ...

- django的htpp请求之WSGIRequest

WSGIRequest对象 Django在接收到http请求之后,会根据http请求携带的参数以及报文信息创建一个WSGIRequest对象,并且作为视图函数第一个参数传给视图函数.这个参数就是dja ...

- Wormholes POJ 3259(SPFA判负环)

Description While exploring his many farms, Farmer John has discovered a number of amazing wormholes ...

- Java 学习笔记 ------第四章 认识对象

本章学习目标: 区分基本类型与类类型 了解对象与参考的关系 从打包器认识对象 以对象观点看待数组 认识字符串的特性 一."=" 和 "==" 当=用于基本类型时 ...

- 【分层最短路】Joyride

http://codeforces.com/gym/101873 C 多开一维状态记录时间,d[i][t] = 经过时间t走到节点i的最小花费 每一个状态分别向"原地等待"与&qu ...

- 论文爬取 & 词频统计2.0

一.Github地址 课程项目要求 队友博客 二.具体分工 031602225 林煌伟 :负责C++部分主要功能函数的编写,算法的设计以及改进优化 031602230 卢恺翔 : 爬虫 ...