hive学习笔记之五:分桶

欢迎访问我的GitHub

https://github.com/zq2599/blog_demos

内容:所有原创文章分类汇总及配套源码,涉及Java、Docker、Kubernetes、DevOPS等;

《hive学习笔记》系列导航

本篇概览

本文是《hive学习笔记》的第五篇,前文学习了分区表,很容易发现分区表的问题:

- 分区字段的每个值都会创建一个文件夹,值越多文件夹越多;

- 不合理的分区会导致有的文件夹下数据过多,有的过少;

此时可以考虑分桶的方式来分解数据集,分桶原理可以参考MR中的HashPartitioner,将指定字段的值做hash后,根据桶的数量确定该记录放在哪个桶中,另外,在join查询和数据取样时,分桶都能提升查询效率;

- 接下来开始实战;

配置

- 执行以下设置,使得hive根据桶的数量自动调整上一轮reducers数量:

set hive.enforce.bucketing = true;

- 如果不执行上述设置,您需要自行设置mapred.reduce.tasks参数,以控制reducers数量,本文咱们配置为hive自动调整;

准备数据

接下来先准备外部表t13,往里面添加一些数据,将t13作为后面分桶表的数据源:

- 表名t13,只有四个字段:

create external table t13 (name string, age int, province string, city string)

row format delimited

fields terminated by ','

location '/data/external_t13';

- 创建名为013.txt的文件,内容如下:

tom,11,guangdong,guangzhou

jerry,12,guangdong,shenzhen

tony,13,shanxi,xian

john,14,shanxi,hanzhong

- 将013.txt中的四条记录载入t13:

load data

local inpath '/home/hadoop/temp/202010/25/013.txt'

into table t13;

分桶

- 创建表t14,指定字段分桶,桶数量为16:

create table t14 (name string, age int, province string, city string)

clustered by (province, city) into 16 buckets

row format delimited

fields terminated by ',';

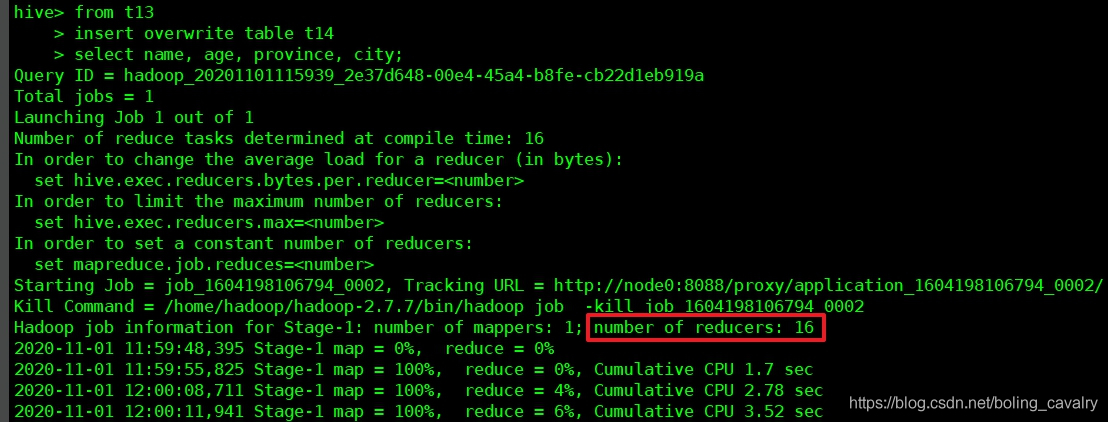

- 从t13导入数据,注意语法是from t13开始,要用overwrite关键字:

from t13

insert overwrite table t14

select name, age, province, city;

- 导入过程如下图所示,可见reducer数量已被自动调整为桶数量:

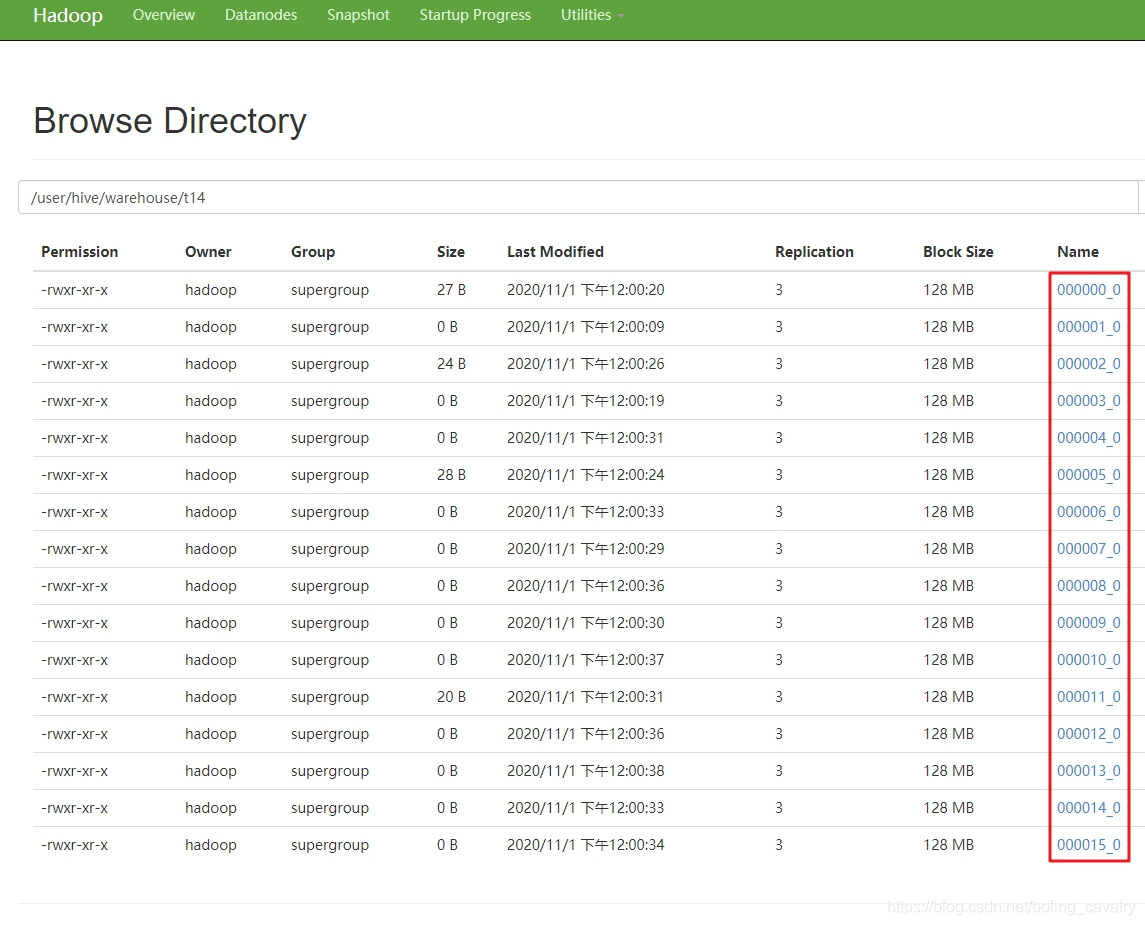

- 导入后,查看hdfs,可见被分为16个文件,(和分区对比一下,分区是不同的文件夹):

取样

执行以下语句,取样查看t14的数据:

hive> select * from t14 tablesample(bucket 1 out of 2 on province, city);

OK

tom 11 guangdong guangzhou

john 14 shanxi hanzhong

Time taken: 0.114 seconds, Fetched: 2 row(s)

- 至此,分桶操作就完成了,基础知识的实践已经完成,接下来开始一些进阶实践;

你不孤单,欣宸原创一路相伴

欢迎关注公众号:程序员欣宸

微信搜索「程序员欣宸」,我是欣宸,期待与您一同畅游Java世界...

https://github.com/zq2599/blog_demos

hive学习笔记之五:分桶的更多相关文章

- hive学习笔记之一:基本数据类型

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之三:内部表和外部表

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之四:分区表

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之六:HiveQL基础

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之七:内置函数

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之九:基础UDF

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Hive动态分区和分桶(八)

Hive动态分区和分桶 1.Hive动态分区 1.hive的动态分区介绍 hive的静态分区需要用户在插入数据的时候必须手动指定hive的分区字段值,但是这样的话会导致用户的操作复杂度提高,而且在 ...

- hive学习笔记之十:用户自定义聚合函数(UDAF)

欢迎访问我的GitHub 这里分类和汇总了欣宸的全部原创(含配套源码):https://github.com/zq2599/blog_demos 本篇概览 本文是<hive学习笔记>的第十 ...

- hive学习笔记之十一:UDTF

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

随机推荐

- UI设计师、平面设计师常用的网站大全,初学者必备,大家都在用!

UI设计师.平面设计师常用的网站大全,初学者必备,大家都在用! 国外的花瓣--Pinterest • The world's catalog of ideas 颜格视觉--app界面设计大全--电商. ...

- CRM系统实现自动化的“三部曲”

在了解CRM系统的自动化的时候,我们先来看一下CRM能干什么. 从上面的流程图我们就可以看出,CRM可以管理售前,售中和售后的整个客户生命周期. 为什么在复杂的客户生命周期中需要自动化呢? 当然是为了 ...

- jenkins邮件报警机制配置

1.下载email插件 Jenkins配置email前需要先安装email插件:Email Extension.Email Extension Template Plugin 2.系统配置 在Jenk ...

- micro 从cli的tag中获取配置

官方文档: https://micro.mu/docs/go-config.html https://github.com/micro/go-micro/tree/master/config/sour ...

- WIKI和JIRA-安装与使用

1.Wiki介绍1.1 Wiki(多人协作的写作系统)是一种超文本系统,这种超文本系统支持面向社群的协作式写作,即人人可编辑.在公司的项目管理中,可以把它当作文档管理和信息组织(Portlet)系统来 ...

- CentOS 7.3 安装指南 作者: Matei Cezar 译者: LCTT geekpi

CentOS 7.3 安装指南 作者: Matei Cezar 译者: LCTT geekpi | 2016-12-20 09:12 评论: 11 收藏: 4 分享: 1 基于 Red Hat 企 ...

- 063.Python前端Django分页器

Django的分页器 1 前期准备 创建一个数据库,用于存放数据 mysql> create database pager default charset=utf8; mysql> use ...

- Java 进制及转换

Java 整型的表现形式 Java 数据类型中有四种整型,分别是 byte.short.int.long,而整型定义下的数据还会按进制来区分: 十进制整数:都是以 0-9 这九个数字组成,不能以 0 ...

- Python将PDF转为TXT

PDFMiner----python的PDF解析器和分析器 1.官方文档:http://www.unixuser.org/~euske/python/pdfminer/index.html 2.特征 ...

- Archlinux常用软件推荐 更新于2021年4月

记录一下常用软件 必装软件 包管理工具 yay 代替pacman的包管理 yaourt 备用 终端工具 zsh oh-my-zsh-git 搭配zsh利器` proxychains4 终端代理工具` ...