spark-1

先测试搭好的spark集群:

本地模式测试:

在spark的目录下:

./bin/run-example SparkPi 10 --master local[2]

验证成功:

集群模式 Spark Standalone:

spark-shell --master yarn-client 集群模式Spark Standalone

验证成功:

集群模式 Spark on Yarn集群上yarn-cluster模式:

./bin/spark-submit --class org.apache.spark.examples.SparkPi --master yarn-cluster examples/jars/spark-examples_2.11-2.0.2.jar 10

实现一个wordcount将文件导入scala中:

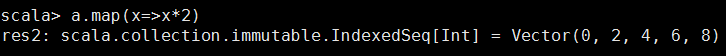

先尝试一下map函数,map不改变数据的结构,但可以对数据进行操作

相当于对每个值,做了乘2的操作。

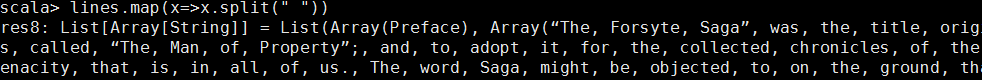

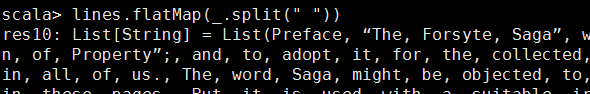

用空格分隔

将每一行用空格做分隔。

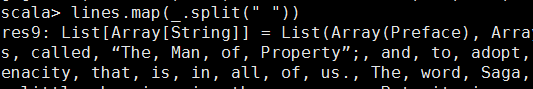

简化,_是通配符,代表每个x

将map之后的数据打平,等价于 lines.map(x=>x.split(" ")).flatten

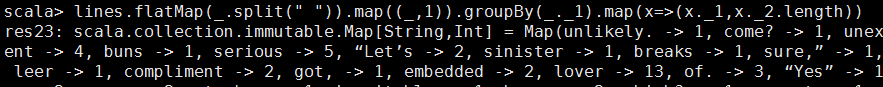

将每个单词后面加一个“1”字符,

groupby操作

从tuple(forgotten,1)中把第一个单词提出来forgotten作为key,

把整个tuple作为value,收集到一个list中

这样对应的value是一个list里面包含所有对应key的tuple

例:

_1:forgotten -> _2:List((forgotten,1), (forgotten,1), (forgotten,1))

整个list大小就是对应key:forgotten出现的次数

下方的map(x=>(x._1,x._2.length)) 只能用这种形式因为是两个tunple.当中的length也可换成size.

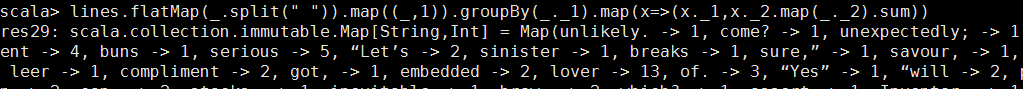

如果不通过list大小来算具体单词的次数(词频):

要将map中读的list中的第二个值相加.,也可以把sum改成reduce(_+_)

reduce(_+_)计算原理:

List(1, 1, 1) ((1+1)+1)

sum += x

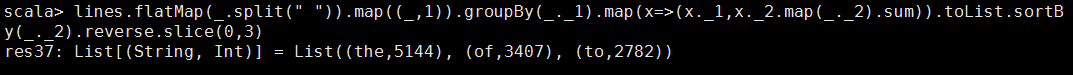

按数字反向排序:

取前三个:

其他方法:

lines.flatMap(_.split(" "))

.map((_,1))

.groupBy(_._1)

.mapValues(_.size)

返回的是一个Map(dict),key:单词,value:词频

lines.flatMap(_.split(" "))

.map((_,1))

.groupBy(_._1)

.mapValues(_.size)

.toArray

.sortWith(_._2>_._2)

.slice(0,10)

sortBy(_._2).reverse == sortWith(_._2>_._2)

_._2表示按照第二个进行排序

mkString(拼接字符串)

正则去取多余的符号

正则:

python import re

p = r'[0-9]+'

p.findall(s)这个是一个数组

p.findall(s)[0] scala:

val p = "[0-9]+".r

val s = "546465sfgidg"

p.findAllIn(s)是一个迭代器

p.findAllIn(s).toArray 将迭代器转为数组形式. p.findAllIn(s).foreach(x=>println(x))

foreach也是扫一遍数据 p.findAllIn(s).mkString("") #变成字符串

mkString("[","","]")

取标点,只取数字和字符

val p = "[0-9a-zA-Z]+".r

lines.flatMap(_.split(" "))

.map(x=>(p.findAllIn(x).mkString(""),1))

.groupBy(_._1)

.mapValues(_.size)

.toArray

.sortWith(_._2>_._2)

.slice(0,10) lines.flatMap(_.split(" ")).map(x=>(p.findAllIn(x).mkString(""),1))

fold函数:

def f(){}

lines.map(f)

a.foldLeft(0)(_+_)

sum = 0

for i in a:

sum += i

return sum

tuple求和

sum = 0

for i in a:

sum += i[1] #1相当于第二个值,相当于scala中的_.__2

return sum

a.foldLeft(0)(_+_._2) #_._2是第二个,0没有变.0相当于sum=0

map的嵌套操作;

spark-1的更多相关文章

- Spark踩坑记——Spark Streaming+Kafka

[TOC] 前言 在WeTest舆情项目中,需要对每天千万级的游戏评论信息进行词频统计,在生产者一端,我们将数据按照每天的拉取时间存入了Kafka当中,而在消费者一端,我们利用了spark strea ...

- Spark RDD 核心总结

摘要: 1.RDD的五大属性 1.1 partitions(分区) 1.2 partitioner(分区方法) 1.3 dependencies(依赖关系) 1.4 compute(获取分区迭代列表) ...

- spark处理大规模语料库统计词汇

最近迷上了spark,写一个专门处理语料库生成词库的项目拿来练练手, github地址:https://github.com/LiuRoy/spark_splitter.代码实现参考wordmaker ...

- Hive on Spark安装配置详解(都是坑啊)

个人主页:http://www.linbingdong.com 简书地址:http://www.jianshu.com/p/a7f75b868568 简介 本文主要记录如何安装配置Hive on Sp ...

- Spark踩坑记——数据库(Hbase+Mysql)

[TOC] 前言 在使用Spark Streaming的过程中对于计算产生结果的进行持久化时,我们往往需要操作数据库,去统计或者改变一些值.最近一个实时消费者处理任务,在使用spark streami ...

- Spark踩坑记——初试

[TOC] Spark简介 整体认识 Apache Spark是一个围绕速度.易用性和复杂分析构建的大数据处理框架.最初在2009年由加州大学伯克利分校的AMPLab开发,并于2010年成为Apach ...

- Spark读写Hbase的二种方式对比

作者:Syn良子 出处:http://www.cnblogs.com/cssdongl 转载请注明出处 一.传统方式 这种方式就是常用的TableInputFormat和TableOutputForm ...

- (资源整理)带你入门Spark

一.Spark简介: 以下是百度百科对Spark的介绍: Spark 是一种与 Hadoop 相似的开源集群计算环境,但是两者之间还存在一些不同之处,这些有用的不同之处使 Spark 在某些工作负载方 ...

- Spark的StandAlone模式原理和安装、Spark-on-YARN的理解

Spark是一个内存迭代式运算框架,通过RDD来描述数据从哪里来,数据用那个算子计算,计算完的数据保存到哪里,RDD之间的依赖关系.他只是一个运算框架,和storm一样只做运算,不做存储. Spark ...

- (一)Spark简介-Java&Python版Spark

Spark简介 视频教程: 1.优酷 2.YouTube 简介: Spark是加州大学伯克利分校AMP实验室,开发的通用内存并行计算框架.Spark在2013年6月进入Apache成为孵化项目,8个月 ...

随机推荐

- oracle 链接

<properties> <!--配置Hibernate方言 --> <property name="hibernate.dialect" value ...

- poi读取word的内容

pache POI是Apache软件基金会的开放源码函式库,POI提供API给Java程序对Microsoft Office格式档案读和写的功能. 1.读取word 2003及word 2007需要的 ...

- C++取反交换两个数的值

int a = 1; int b = 2; cout << "a: "<< a << endl; cout << "b: ...

- echarts双y轴折线图柱状图混合实时更新图

先看下效果,自己用ps做了张gif图,发现很好玩啊..不喜勿喷 自己下载个echarts.min.js 直接上代码: <!DOCTYPE html><html><head ...

- 清楚理解const_cast类型转换

1.任何使用原常量的地方, 已经直接编码到代码中去了.故后续转换类型并不能改变原定义 2.const_cast转换, 是使用了新指针或者引用,指向了原定义的内存,故而可以修改该内存. 使用也得用新指针 ...

- ELF文件加载与动态链接(一)

关于ELF文件的详细介绍,推荐阅读: ELF文件格式分析 —— 滕启明.ELF文件由ELF头部.程序头部表.节区头部表以及节区4部分组成. 通过objdump工具和readelf工具,可以观察ELF文 ...

- 安装Python 3.6 在Ubuntu 16.04 LTS 版本

Collecting tensorflow Could not find a version that satisfies the requirement tensorflow (from versi ...

- 【leetcode】429. N-ary Tree Level Order Traversal

problem 429. N-ary Tree Level Order Traversal solution1:Iteration /* // Definition for a Node. class ...

- 洛谷P1357 花园(状态压缩 + 矩阵快速幂加速递推)

题目链接:传送门 题目: 题目描述 小L有一座环形花园,沿花园的顺时针方向,他把各个花圃编号为1~N(<=N<=^).他的环形花园每天都会换一个新花样,但他的花园都不外乎一个规则,任意相邻 ...

- Go Example--strings

package main import ( "fmt" s "strings" ) var p = fmt.Println func main() { //st ...