AotucCrawler 快速爬取图片

AotucCrawler 快速爬取图片

今天介绍一款自动化爬取图片项目。

GitHub: https://github.com/YoongiKim/AutoCrawler

Google, Naver multiprocess image web crawler (Selenium)

关键字

- 爬虫网站:Google、Naver (美、韩两大搜索引擎)

- 运行方式:Multiprocess(多进程)

- 爬取格式:image (图片)

- 基于自动化工具:Selenium (不解释)

如何使用

Git克隆

AutoCrawler项目到本地自行安装

Chrome浏览器安装依赖

> pip -r requirements.txt

certifi: 包含了很多可信任知名公司的证书/公钥。chardet:提供自动检测字符编码的功能。idna: 提供"对于RFC5891中定义的IDNA协议(Internationalised Domain Names in Applications)的支持"。requests: 依赖于上面三个基础库,他主要用于根据图片链接下载图片。selenium: 用于启动浏览器,爬取图片链接。webdriver-manager: 用来管理selenium浏览器驱动的项目。

仔细分析别人项目,不管是源码还是依赖库都会有收获。

webdriver-manager就是我发现的一个宝藏项目,它简化的浏览器驱动的管理。

- 打开

keywords.txt文件,编写爬取的关键字。

cat

dog

- 运行

main.py文件

> python main.py

参数说明:

--skip true:如果下载的关键字已经存在,是否跳过关键字,重新下载时需要设置。

--threads 4: 下载使用线程数量

--google true: 从google.com 下载。

--naver true: 从naver.com 下载。

--full false: 下载全分辨率图像而不是缩略图 (慢)。

--face false: Face search mode。

--no_gui auto: 使用 GUI 模式. (headless模式) 全分辨率模式可以加速, 但是缩略图模式不稳定。 默认auto模式,如果full=false 默认使用使用GUI,如果full=true默认Headless模式。(可用于docker linux系统)。

--limit 0: 设置最大图片下载范围。 (0: 无限制)

--proxy-list: 逗号分隔的代理列表,如: socks://127.0.0.1:1080, http://127.0.0.1:1081,每个线程从列表中随即选择一个。

例如:

> python main.py --threads 2 --google true --naver false --full false --limit 50

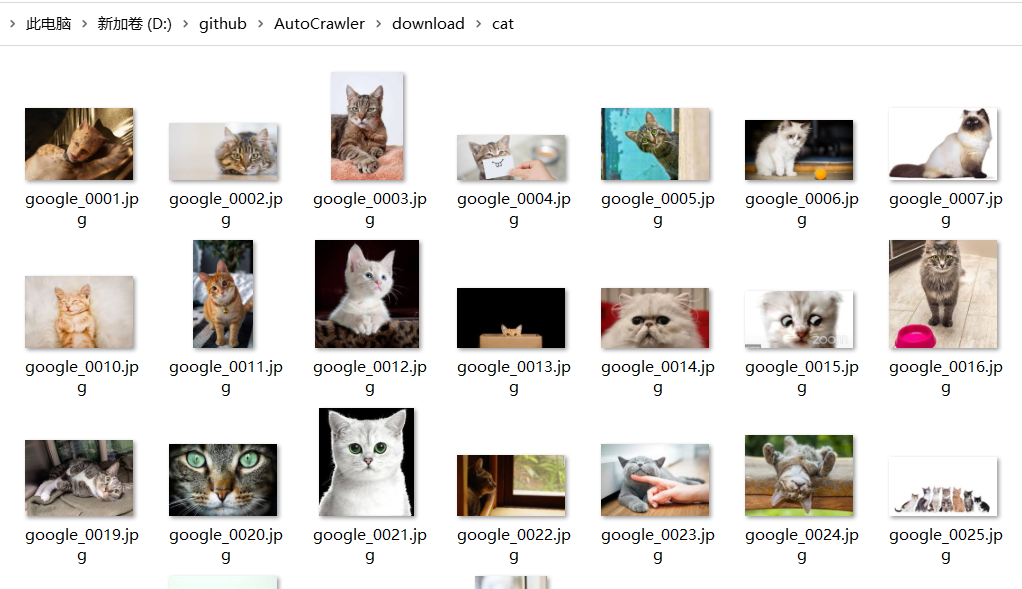

- 爬取的图片保存于

downloads/目录。

小结

因为使用的是Google网站,没有梯子的同学有点郁闷。项目本身并不复杂,两个python文件加一起不到1000行代码,我们完全可以花点时间替换为国内可访问的搜索引擎。

下载图片只是为了欣赏猫猫狗狗吗?当然不是,我们可用下载的图片训练 AI。

AotucCrawler 快速爬取图片的更多相关文章

- Java jsoup爬取图片

jsoup爬取百度瀑布流图片 是的,Java也可以做网络爬虫,不仅可以爬静态网页的图片,也可以爬动态网页的图片,比如采用Ajax技术进行异步加载的百度瀑布流. 以前有写过用Java进行百度图片的抓取, ...

- python如何使用request爬取图片

下面是代码的简单实现,变量名和方法都是跑起来就行,没有整理,有需要的可以自己整理下: image2local: import requests import time from lxml import ...

- [python爬虫] 爬取图片无法打开或已损坏的简单探讨

本文主要针对python使用urlretrieve或urlopen下载百度.搜狗.googto(谷歌镜像)等图片时,出现"无法打开图片或已损坏"的问题,作者对它进行简单的探讨.同时 ...

- scrapy爬虫,爬取图片

一.scrapy的安装: 本文基于Anacoda3, Anacoda2和3如何同时安装? 将Anacoda3安装在C:\ProgramData\Anaconda2\envs文件夹中即可. 如何用con ...

- scrapy爬虫系列之三--爬取图片保存到本地

功能点:如何爬取图片,并保存到本地 爬取网站:斗鱼主播 完整代码:https://files.cnblogs.com/files/bookwed/Douyu.zip 主要代码: douyu.py im ...

- 孤荷凌寒自学python第八十二天学习爬取图片2

孤荷凌寒自学python第八十二天学习爬取图片2 (完整学习过程屏幕记录视频地址在文末) 今天在昨天基本尝试成功的基础上,继续完善了文字和图片的同时爬取并存放在word文档中. 一.我准备爬取一个有文 ...

- 孤荷凌寒自学python第八十一天学习爬取图片1

孤荷凌寒自学python第八十一天学习爬取图片1 (完整学习过程屏幕记录视频地址在文末) 通过前面十天的学习,我已经基本了解了通过requests模块来与网站服务器进行交互的方法,也知道了Beauti ...

- 爬取图片过程遇到的ValueError: Missing scheme in request url: h 报错与解决方法

一 .scrapy整体框架 1.1 scrapy框架图 1.2 scrapy框架各结构解析 item:保存抓取的内容 spider:定义抓取内容的规则,也是我们主要编辑的文件 pipelines:管道 ...

- python网络爬虫之使用scrapy爬取图片

在前面的章节中都介绍了scrapy如何爬取网页数据,今天介绍下如何爬取图片. 下载图片需要用到ImagesPipeline这个类,首先介绍下工作流程: 1 首先需要在一个爬虫中,获取到图片的url并存 ...

随机推荐

- 初识Linux shell

目录 初识Linux shell Linux 深入探究Linux内核 系统内存管理 交换空间 页面 换出 软件程序管理 Linux中的进程 Linux系统的运行级 硬件设备管理 插入设备驱动代码的方法 ...

- PTA实验11-1-7 藏头诗 (15分)

实验11-1-7 藏头诗 (15分) 本题要求编写一个解密藏头诗的程序. 输入格式: 输入为一首中文藏头诗,一共四句,每句一行.注意:一个汉字占两个字节. 输出格式: 取出每句的第一个汉字并连接在一起 ...

- C++手动加载CLR运行托管程序(CLR Hosting)

转载自:http://www.linuxidc.com/Linux/2012-10/72293.htm 机制介绍 有些时候主程序是通过C/C++实现的,但是我们希望通过托管代码来扩展非托管程序,从而也 ...

- Vue Router 常见问题(push报错、push重复路由刷新)

Vue Router 常见问题 用于记录工作遇到的Vue Router bug及常用方案 router.push报错,Avoided redundant navigation to current l ...

- 【UE4 C++】 外部图片读取、Texture 保存 png

蓝图版 导入外部图片 file://E:/UE___Projects_Test/MyProjectAAA/Plugins/WXimage.jpg 导出图图片 一般导出 .hdr 文件 导出 png 设 ...

- 第五课第四周笔记3:Multi-Head Attention多头注意力

Multi-Head Attention多头注意力 让我们进入并了解多头注意力机制. 符号变得有点复杂,但要记住的事情基本上只是你在上一个视频中学到的自我注意机制的四个大循环. 让我们看一下每次计算自 ...

- [no code][scrum meeting] Alpha 5

项目 内容 会议时间 2020-04-10 会议主题 后端技术讨论 会议时长 30min 参会人员 全体成员 $( "#cnblogs_post_body" ).catalog() ...

- Intellij IDEA 2021.2.3 最新版免费激活教程(可激活至 2099 年,亲测有效)

申明,本教程 Intellij IDEA 最新版破解.激活码均收集与网络,请勿商用,仅供个人学习使用,如有侵权,请联系作者删除.如条件允许,建议大家购买正版. 本教程更新于:2021 年 10 月 ...

- Linux多线程编程实例解析

Linux系统下的多线程遵循POSIX线程接口,称为 pthread.编写Linux下的多线程程序,需要使用头文件pthread.h,连接时需要使用库libpthread.a.顺便说一下,Linux ...

- Photoshop cc 绿色版 最新版 下载

Photoshop cc 绿色版 下载 Photoshop cc 绿色版 最新版下载百度网盘下载 Photoshop 下载提取码: dh6z 作为一个程序员, 不懂点基本的作图都不配"新时代 ...