python爬虫--用xpath爬豆瓣电影

- 将目标网站下的页面抓取下来

- 将抓取下来的数据根据一定规则进行提取

- 将目标网站下的页面抓取下来

import requests

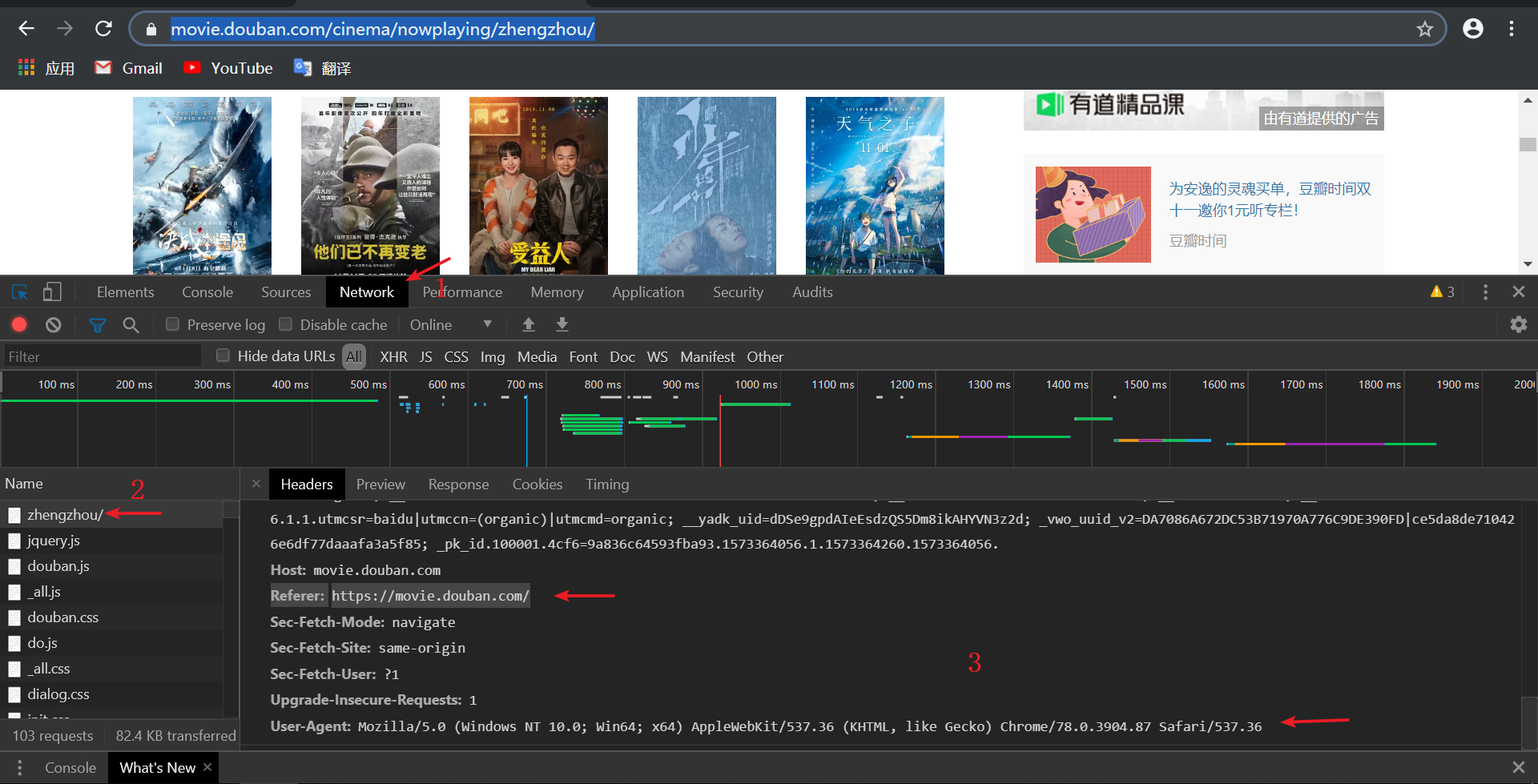

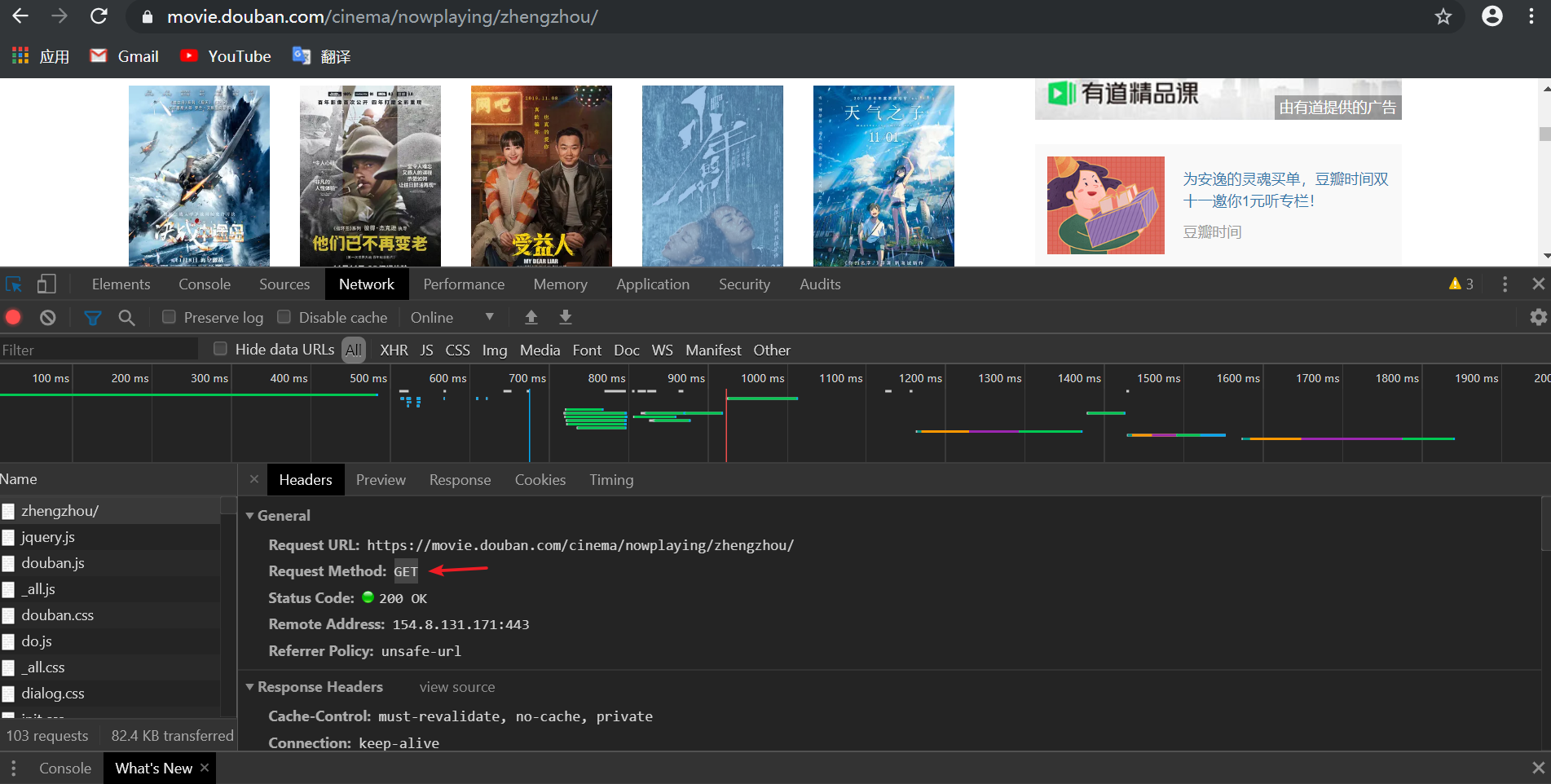

headers = {

#请求身份/默认为User-Agent:python

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.87 Safari/537.36',

'Referer': 'https://movie.douban.com/'

}

url = 'https://movie.douban.com/cinema/nowplaying/zhengzhou/'

response = requests.get(url,headers=headers) #响应

#print(response.text)

text = response.text

from lxml import etree

html = etree.HTML(text)

ul = html.xpath("//ul[@class='lists']")[0]

#print(etree.tostring(ul,encoding='utf-8').decode('utf-8'))

lis = ul.xpath('./li')

for li in lis:

#print(etree.tostring(li,encoding='utf-8').decode('utf-8'))

title = li.xpath('@data-title')[0]

#print(title)

score = li.xpath('@data-score')[0]

# print(score)

poster = li.xpath('.//img/@src')[0]

# print(poster)

request.urlretrieve(poster, 'D:/A/' + score + title + '.jpg')

下载到D盘下A目录中,文件名为 评分+影名.jpg

2.显示进度条

fns_num = 1

num = len(lis)

for li in lis:

···

print("\r完成进度: {:.2f}%".format(fns_num * 100 / num), end="")

fns_num += 1

#coding=UTF-8 import requests

from lxml import etree

from urllib import request headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.87 Safari/537.36',

'Referer': 'https://movie.douban.com/'

}

url = 'https://movie.douban.com/cinema/nowplaying/zhengzhou/'

response = requests.get(url,headers=headers)

# print(response.text)

text = response.text html = etree.HTML(text)

ul = html.xpath("//ul[@class='lists']")[0]

# print(etree.tostring(ul,encoding='utf-8').decode('utf-8'))

lis = ul.xpath("./li")

# movies = []

fns_num = 1

num = len(lis)

for li in lis:

# print(etree.tostring(li,encoding='utf-8').decode('utf-8'))

title = li.xpath('@data-title')[0]

# print(title)

score = li.xpath('@data-score')[0]

# print(score)

poster = li.xpath('.//img/@src')[0]

# print(poster) request.urlretrieve(poster, 'D:/A/' + score + title + '.jpg')

print("\r完成进度: {:.2f}%".format(fns_num * 100 / num), end="")

fns_num += 1

python爬虫--用xpath爬豆瓣电影的更多相关文章

- 一个简单python爬虫的实现——爬取电影信息

最近在学习网络爬虫,完成了一个比较简单的python网络爬虫.首先为什么要用爬虫爬取信息呢,当然是因为要比人去收集更高效. 网络爬虫,可以理解为自动帮你在网络上收集数据的机器人. 网络爬虫简单可以大致 ...

- Python爬虫教程-17-ajax爬取实例(豆瓣电影)

Python爬虫教程-17-ajax爬取实例(豆瓣电影) ajax: 简单的说,就是一段js代码,通过这段代码,可以让页面发送异步的请求,或者向服务器发送一个东西,即和服务器进行交互 对于ajax: ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- python简单爬豆瓣电影排名

爬豆瓣电影 网站分析: 1 打开https://movie.douban.com,选择 [排行榜],然后随便选择一类型,我这里选择科幻 2 一直浏览网页,发现没有下一的标签,是下滑再加载的,可 ...

- 非常全的一份Python爬虫的Xpath博文

非常全的一份Python爬虫的Xpath博文 Xpath 是 python 爬虫过程中非常重要的一个用来定位的一种语法. 一.开始使用 首先我们需要得到一个 HTML 源代码,用来模拟爬取网页中的源代 ...

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- python爬虫:XPath语法和使用示例

python爬虫:XPath语法和使用示例 XPath(XML Path Language)是一门在XML文档中查找信息的语言,可以用来在XML文档中对元素和属性进行遍历. 选取节点 XPath使用路 ...

- Python爬虫之xpath语法及案例使用

Python爬虫之xpath语法及案例使用 ---- 钢铁侠的知识库 2022.08.15 我们在写Python爬虫时,经常需要对网页提取信息,如果用传统正则表达去写会增加很多工作量,此时需要一种对数 ...

随机推荐

- tomcat设置好环境变量,依然无法通过cmd startup命令启动

Windows环境下JDK安装与环境变量配置详细的图文教程 https://www.cnblogs.com/liuhongfeng/p/4177568.html Windows环境下maven 环 ...

- a^b(取模运算)

a^b(sdtbu oj 1222) Description 对于任意两个正整数a,b(0 <= a, b < 10000)计算ab各位数字的和的各位数字的和的各位数字的和的各位数字的和. ...

- LeetCode 中等题解(1)

16 最接近的三数之和 Question 给定一个包括 n 个整数的数组 nums 和 一个目标值 target.找出 nums 中的三个整数,使得它们的和与 target 最接近.返回这三个数的和. ...

- C++中new和malloc区别

面试中new和malloc区别会被经常问到,审视了自己,发现不知道该怎么表达 整理一下: 1.从属性 new/delete是C++关键字,需要编译器支持: malloc/free是库函数,需要头文件支 ...

- CorelDRAW常用工具之橡皮擦工具

很多作图以及设计软件都会自带橡皮擦工具,但对于专业做平面设计的小伙伴来说,普通的橡皮工具肯定是无法满足日常作图需求的,今天来看看CorelDRAW的橡皮擦能玩出什么花样来. 1.擦除对象 CorelD ...

- CorelDRAW 条形码改不了字体如何解决?

看到有朋友提问说CorelDRAW条码生成设置里面的字体不能更改,是灰色的,不能选择.这个默认字体怎么改? 出现问题:条码生成设置里面的字体不能更改,是灰色的,不能选择. 解决方法一:找到C盘字体文件 ...

- synchronized关键字的内存语义

以下内容摘自:Java并发编程之美 加锁和释放锁的语义:当获取锁以后会清空锁块内本地内存中将会被用到的共享变量,在使用这些共享变量的时从主内存进行加载,在释放锁时将本地内存中修改的 共享变量刷新到主内 ...

- Python正则表达式大全

前言 正则表达式是对字符串(包括普通字符(例如,a 到 z 之间的字母)和特殊字符(称为"元字符"))操作的一种逻辑公式,就是用事先定义好的一些特定字符.及这些特定字符的组合,组成 ...

- 一张图彻底理解Spring如何解决循环依赖!!

写在前面 最近,在看Spring源码,看到Spring解决循环依赖问题的源码时,不得不说,源码写的太烂了.像Spring这种顶级的项目源码,竟然存在着这种xxx的代码.看了几次都有点头大,相信很多小伙 ...

- 网络管理监视很重要!学编程的你知道哪些不错的网络监控工具?2020 最好的Linux网络监控工具分享给你

以下文章来源于新钛云服 翻译:侯明明 前言 虽然这个清单包含开源的和闭源的产品,但它着重于介绍基于 Linux 的网络监控工具, 少数常用工具只能在 Windows,Pandora 或其他系统上运行, ...