Python爬虫(一)——开封市58同城租房信息

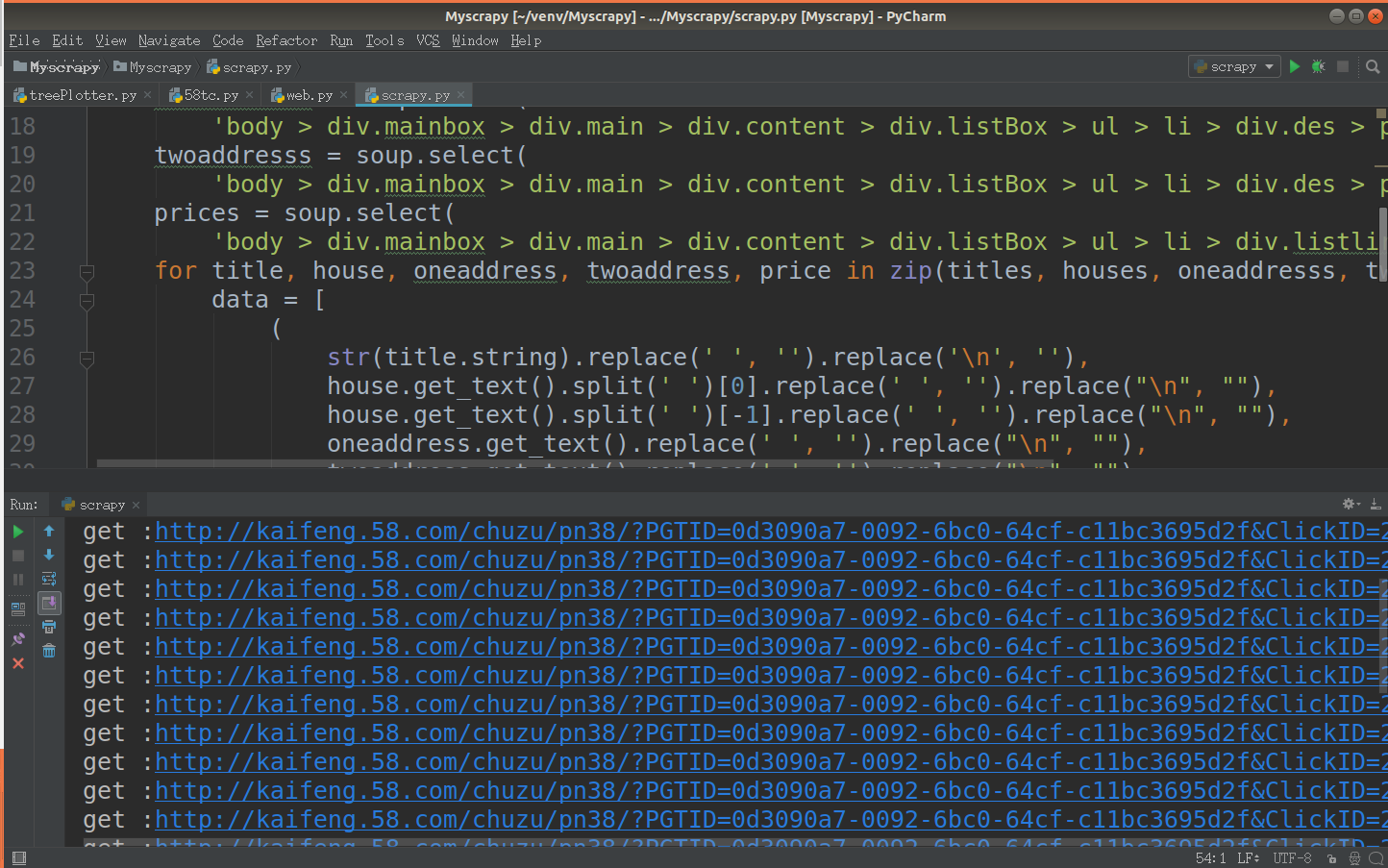

代码:

# coding=utf-8

import sys

import csv

import requests

from bs4 import BeautifulSoup reload(sys)

sys.setdefaultencoding('utf-8')

# 请求头设置 def download(url):

db_data = requests.get(url)

soup = BeautifulSoup(db_data.text, 'lxml')

titles = soup.select(

'body > div.mainbox > div.main > div.content > div.listBox > ul > li > div.des > h2 > a:nth-of-type(1)')

houses = soup.select('body > div.mainbox > div.main > div.content > div.listBox > ul > li > div.des > p.room')

oneaddresss = soup.select(

'body > div.mainbox > div.main > div.content > div.listBox > ul > li > div.des > p.add > a:nth-of-type(1)')

twoaddresss = soup.select(

'body > div.mainbox > div.main > div.content > div.listBox > ul > li > div.des > p.add > a:nth-of-type(2)')

prices = soup.select(

'body > div.mainbox > div.main > div.content > div.listBox > ul > li > div.listliright > div.money > b')

for title, house, oneaddress, twoaddress, price in zip(titles, houses, oneaddresss, twoaddresss, prices):

data = [

(

str(title.string).replace(' ', '').replace('\n', ''),

house.get_text().split(' ')[0].replace(' ', '').replace("\n", ""),

house.get_text().split(' ')[-1].replace(' ', '').replace("\n", ""),

oneaddress.get_text().replace(' ', '').replace("\n", ""),

twoaddress.get_text().replace(' ', '').replace("\n", ""),

price.get_text().replace(' ', '').replace("\n", "")

)

] csvfile = open('kf.csv', 'ab')

writer = csv.writer(csvfile)

print('write one house')

writer.writerows(data)

csvfile.close() # 初始化csv文件

def info():

csvinfo = open('kf.csv', 'ab')

begcsv = csv.writer(csvinfo)

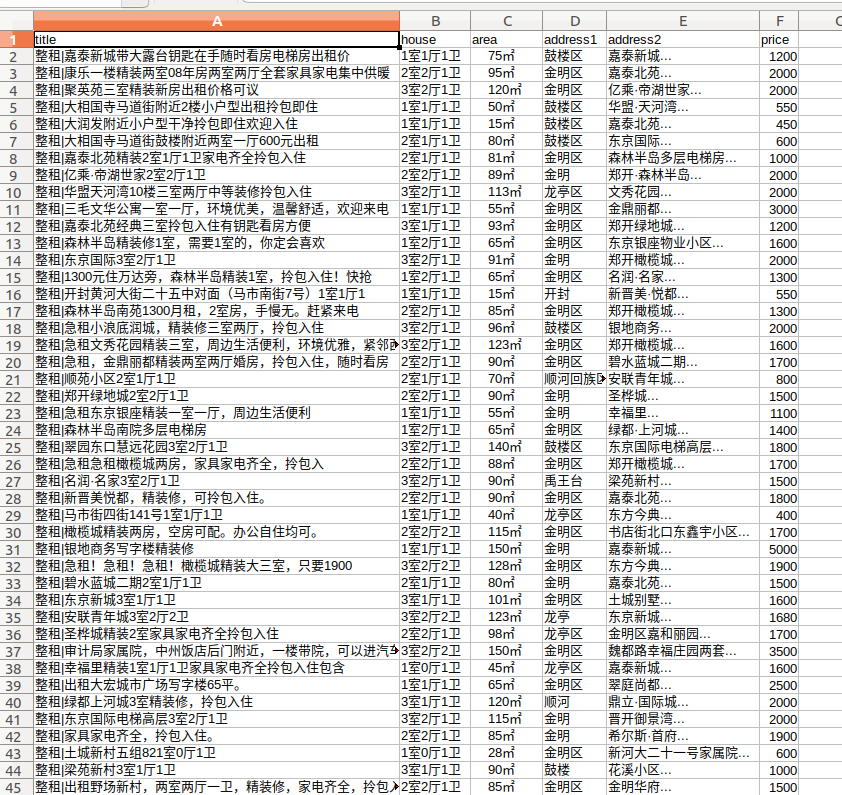

begcsv.writerow(['title', 'house', 'area', 'address1', 'address2', 'price'])

csvinfo.close() if __name__ == '__main__':

info()

download(url)

Python爬虫(一)——开封市58同城租房信息的更多相关文章

- Python爬虫(四)——开封市58同城数据模型训练与检测

前文参考: Python爬虫(一)——开封市58同城租房信息 Python爬虫(二)——对开封市58同城出租房数据进行分析 Python爬虫(三)——对豆瓣图书各模块评论数与评分图形化分析 数据的构建 ...

- 养只爬虫当宠物(Node.js爬虫爬取58同城租房信息)

先上一个源代码吧. https://github.com/answershuto/Rental 欢迎指导交流. 效果图 搭建Node.js环境及启动服务 安装node以及npm,用express模块启 ...

- Python爬虫(三)——开封市58同城出租房决策树构建

决策树框架: # coding=utf-8 import matplotlib.pyplot as plt decisionNode = dict(boxstyle=') leafNode = dic ...

- python爬虫:找房助手V1.0-爬取58同城租房信息

1.用于爬取58上的租房信息,限成都,其他地方的,可以把网址改改: 2.这个爬虫有一点问题,就是没用多线程,因为我用了之后总是会报: 'module' object has no attribute ...

- Python爬虫实战---抓取图书馆借阅信息

Python爬虫实战---抓取图书馆借阅信息 原创作品,引用请表明出处:Python爬虫实战---抓取图书馆借阅信息 前段时间在图书馆借了很多书,借得多了就容易忘记每本书的应还日期,老是担心自己会违约 ...

- python3爬虫-爬取58同城上所有城市的租房信息

from fake_useragent import UserAgent from lxml import etree import requests, os import time, re, dat ...

- 用Python写爬虫爬取58同城二手交易数据

爬了14W数据,存入Mongodb,用Charts库展示统计结果,这里展示一个示意 模块1 获取分类url列表 from bs4 import BeautifulSoup import request ...

- Python开发网络爬虫抓取某同城房价信息

前言: 苦逼的我从某某城市换到另一个稍微大点的某某城市,面临的第一个问题就是买房,奋斗10多年,又回到起点,废话就不多说了,看看如何设计程序把某同城上的房价数据抓取过来. 方案:方案思路很简单,先把网 ...

- Python爬虫(二)——对开封市58同城出租房数据进行分析

出租房面积(area) 出租房价格(price) 对比信息 代码 import matplotlib as mpl import matplotlib.pyplot as plt import pan ...

随机推荐

- pandas功能使用rename, reindex, set_index 详解

pandas rename 功能 在使用 pandas 的过程中经常会用到修改列名称的问题,会用到 rename 或者 reindex 等功能,每次都需要去查文档 当然经常也可以使用 df.colum ...

- A - Black Box 优先队列

来源poj1442 Our Black Box represents a primitive database. It can save an integer array and has a spec ...

- SetTimer API函数

位于user32.dll中,可以每隔一段时间执行一段时间执行一件事的时候,可以使用它. 使用定时器,通常告诉Windows一个时间间隔,然后Windows以此时间间隔周期性触发程序. 发送WM_TIM ...

- C#在WinForm下使用HttpWebRequest上传文件

转自:http://blog.csdn.net/shihuan10430049/article/details/3734398 这段时间因项目需要,要实现WinForm下的文件上传,个人觉得采用FTP ...

- layui封装自定义模块

转自:https://lianghongbo.cn/blog/430585105a35948c layui是国人开发的一款非常简洁的UI框架,使用了模块化加载方式,因此在使用过程中我们难免需要添加自己 ...

- 剑指offer——python【第49题】把字符串转换成整数

题目描述 将一个字符串转换成一个整数(实现Integer.valueOf(string)的功能,但是string不符合数字要求时返回0),要求不能使用字符串转换整数的库函数. 数值为0或者字符串不是一 ...

- Django中URL有关

django 模板中url的处理 在模板中直接添加‘/home’这样的链接是十分不推荐的,因为这是一个相对的链接,在不同网页中打开可能会返回不一样的结果. 所以推荐的是 1 <a href= ...

- MongoDB分片集群原理、搭建及测试详解

随着技术的发展,目前数据库系统对于海量数据的存储和高效访问海量数据要求越来越高,MongoDB分片机制就是为了解决海量数据的存储和高效海量数据访问而生. MongoDB分片集群由mongos路由进程( ...

- [daily] 比端口转发更高级的ssh device tunnel转发

没有什么能够阻挡,你对自由的向往. 场景: 我有一台设备Server100,在某一个f复杂的内网里,需要多次ssh跳转可以访问到.但是它不能直接访问internet. 我现在需要在我的ssh路径上,搭 ...

- Ubuntu 使用命令行连接无线网

一.查看可以使用的无线网: nmcli dev wifi 二.连接无线网: nmcli dev wifi connect ‘essid’(网络名称) password ‘password’(密码) 可 ...