Qt音视频开发15-动态切换解码内核的设计

一、前言

动态切换解码内核这个需求也是源自客户的真实需求,既然是动态切换,那肯定是运行期间切换,而不是通过改变标志位重新编译程序来切换,最开始做的就是这种方式,这样就是实现起来简单,但是用起来不够方便,随着编程架构技术的精进,抽象基类的运用水平逐渐提升,发现视频控件UI层可以不用变,不同内核发出的信号一样,UI层接收信号处理就好,至于底层的解码线程,可以动态销毁和指定,可以任意指定使用某种解码线程(ffmpeg内核、vlc内核、mpv内核、厂家sdk内核等),指定后绑定信号到UI就好,UI可以不用管是哪一种内核,拿到数据绘制就好。

为何要这样设计?一方面可以很方便的做不同内核之间差异的对比; 一方面为何满足不同用户需求,比如某些特定格式的文件用vlc可以正常播放,那就可以选择切换到这个内核就好,海康的视频流带了人工智能分析后的方框等,那就用海康的sdk内核就好,当然最通用跨平台最好的当然是ffmpeg内核,性能也是最好的。

- VideoCore_QMedia=采用qmedia解析(qt自带且依赖本地解码器且部分平台支持)

- VideoCore_FFmpeg=采用ffmpeg解析(通用性最好)

- VideoCore_Vlc=采用vlc解析(支持本地文件最好)

- VideoCore_Mpv=采用mpv解析(支持本地文件最好且跨平台最多)

- VideoCore_Qtav=采用qtav解析(框架结构最好/基于ffmpeg)

- VideoCore_HaiKang=采用海康sdk解析

- VideoCore_DaHua=采用大华sdk解析

- VideoCore_YuShi=采用宇视sdk解析

- VideoCore_EasyPlayer=采用easyplayer解析

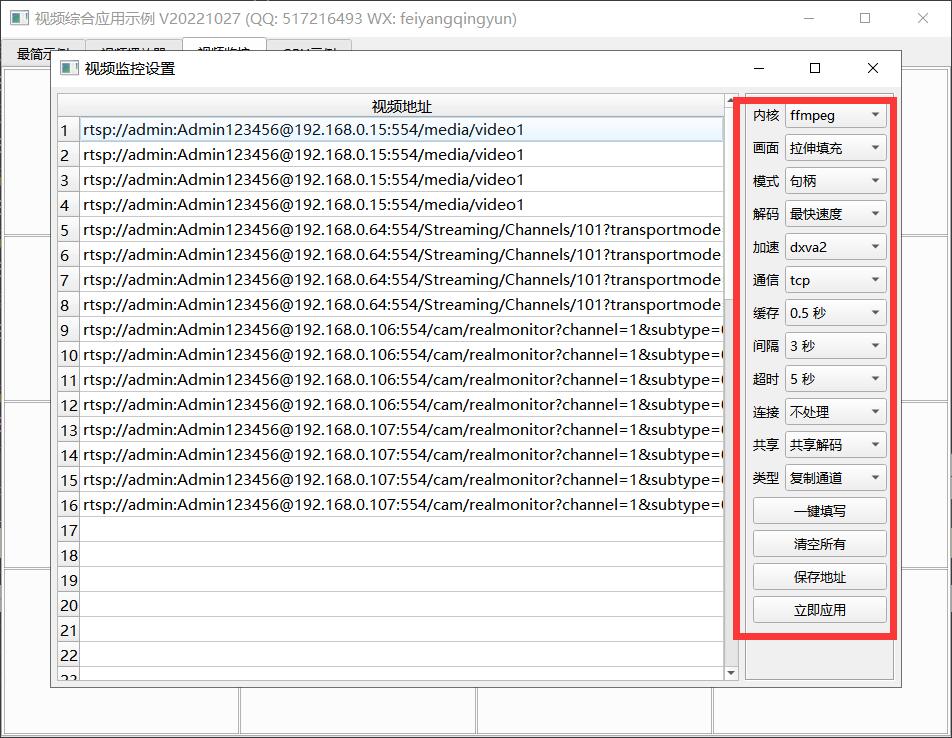

二、效果图

三、体验地址

- 国内站点:https://gitee.com/feiyangqingyun

- 国际站点:https://github.com/feiyangqingyun

- 个人作品:https://blog.csdn.net/feiyangqingyun/article/details/97565652

- 体验地址:https://pan.baidu.com/s/1d7TH_GEYl5nOecuNlWJJ7g 提取码:01jf 文件名:bin_video_demo/bin_linux_video。

四、相关代码

void VideoWidget::connectThreadSignal()

{

if (!videoThread) {

return;

}

//后面带个参数指定信号唯一(如果多次连接信号会自动去重)

connect(videoThread, SIGNAL(started()), this, SLOT(started()), Qt::UniqueConnection);

connect(videoThread, SIGNAL(finished()), this, SLOT(finished()), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receivePlayStart(int)), this, SLOT(receivePlayStart(int)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receivePlayFinsh()), this, SLOT(receivePlayFinsh()), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receiveImage(QImage, int)), this, SLOT(receiveImage(QImage, int)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(snapImage(QImage, QString)), this, SLOT(snapImage(QImage, QString)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receiveFrame(int, int, quint8 *, int)), this, SLOT(receiveFrame(int, int, quint8 *, int)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receiveFrame(int, int, quint8 *, quint8 *, quint8 *, quint32, quint32, quint32)),

this, SLOT(receiveFrame(int, int, quint8 *, quint8 *, quint8 *, quint32, quint32, quint32)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receiveFrame(int, int, quint8 *, quint8 *, quint32, quint32)),

this, SLOT(receiveFrame(int, int, quint8 *, quint8 *, quint32, quint32)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receiveLevel(qreal, qreal)), this, SIGNAL(sig_receiveLevel(qreal, qreal)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receivePlayStart(int)), this, SIGNAL(sig_receivePlayStart(int)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receivePlayFinsh()), this, SIGNAL(sig_receivePlayFinsh()), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receivePlayFinsh()), bannerWidget, SLOT(receivePlayFinsh()), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receiveMuted(bool)), bannerWidget, SLOT(receiveMuted(bool)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(recorderStateChanged(RecorderState, QString)), bannerWidget, SLOT(recorderStateChanged(RecorderState, QString)), Qt::UniqueConnection);

connect(videoThread, SIGNAL(receiveSizeChanged()), this, SLOT(receiveSizeChanged()));

//根据默认音量大小和静音状态触发下信号

if (videoPara.videoCore == VideoCore_FFmpeg) {

QMetaObject::invokeMethod(videoThread, "receiveVolume", Q_ARG(int, widgetPara.soundValue));

QMetaObject::invokeMethod(videoThread, "receiveMuted", Q_ARG(bool, widgetPara.soundMuted));

}

}

void VideoWidget::disconnectThreadSignal()

{

if (!videoThread) {

return;

}

disconnect(videoThread, SIGNAL(started()), this, SLOT(started()));

disconnect(videoThread, SIGNAL(finished()), this, SLOT(finished()));

disconnect(videoThread, SIGNAL(receivePlayStart(int)), this, SLOT(receivePlayStart(int)));

disconnect(videoThread, SIGNAL(receivePlayFinsh()), this, SLOT(receivePlayFinsh()));

disconnect(videoThread, SIGNAL(receiveImage(QImage, int)), this, SLOT(receiveImage(QImage, int)));

disconnect(videoThread, SIGNAL(snapImage(QImage, QString)), this, SLOT(snapImage(QImage, QString)));

disconnect(videoThread, SIGNAL(receiveFrame(int, int, quint8 *, int)), this, SLOT(receiveFrame(int, int, quint8 *, int)));

disconnect(videoThread, SIGNAL(receiveFrame(int, int, quint8 *, quint8 *, quint8 *, quint32, quint32, quint32)),

this, SLOT(receiveFrame(int, int, quint8 *, quint8 *, quint8 *, quint32, quint32, quint32)));

disconnect(videoThread, SIGNAL(receiveFrame(int, int, quint8 *, quint8 *, quint32, quint32)),

this, SLOT(receiveFrame(int, int, quint8 *, quint8 *, quint32, quint32)));

disconnect(videoThread, SIGNAL(receiveLevel(qreal, qreal)), this, SIGNAL(sig_receiveLevel(qreal, qreal)));

disconnect(videoThread, SIGNAL(receivePlayStart(int)), this, SIGNAL(sig_receivePlayStart(int)));

disconnect(videoThread, SIGNAL(receivePlayFinsh()), this, SIGNAL(sig_receivePlayFinsh()));

disconnect(videoThread, SIGNAL(receivePlayFinsh()), bannerWidget, SLOT(receivePlayFinsh()));

disconnect(videoThread, SIGNAL(receiveMuted(bool)), bannerWidget, SLOT(receiveMuted(bool)));

disconnect(videoThread, SIGNAL(recorderStateChanged(RecorderState, QString)), bannerWidget, SLOT(recorderStateChanged(RecorderState, QString)));

disconnect(videoThread, SIGNAL(receiveSizeChanged()), this, SLOT(receiveSizeChanged()));

}

bool VideoWidget::init()

{

//视频地址不能为空

if (videoPara.videoUrl.isEmpty()) {

return false;

}

//如果没有解码内核则不用继续

if (videoPara.videoCore == VideoCore_None) {

return false;

}

//初始化参数

VideoHelper::initPara(widgetPara, videoPara);

//线程正在运行不用继续

if (isRunning) {

return false;

}

//句柄模式则句柄控件在前否则遮罩控件在前

if (widgetPara.videoMode == VideoMode_Hwnd) {

coverWidget->stackUnder(hwndWidget);

} else {

hwndWidget->stackUnder(coverWidget);

}

//已经存在同名的线程则取同名线程

VideoThread *thread = VideoThread::getVideoThread(widgetPara, videoPara);

if (thread) {

isShared = true;

videoThread = thread;

//默认音量大小和静音状态取共享线程的

widgetPara.soundValue = thread->getVolume();

widgetPara.soundMuted = thread->getMuted();

//硬件加速也要取共享线程的

hardware = thread->getHardware();

videoPara.hardware = thread->getHardware();

} else {

//创建新的采集线程

videoThread = VideoHelper::newVideoThread(hwndWidget, videoPara.videoCore);

//设置视频通道唯一标识

videoThread->setFlag(widgetPara.videoFlag);

//加入到采集线程队列

if (widgetPara.sharedData) {

VideoThread::videoThreads << videoThread;

}

//设置对应参数

videoThread->setVideoMode(widgetPara.videoMode);

VideoHelper::initVideoThread(videoThread, videoPara);

}

//绑定信号槽

connectThreadSignal();

return true;

}

bool VideoWidget::open(const QString &videoUrl)

{

//线程正常说明还在运行需要先停止

if (videoThread) {

this->stop();

qApp->processEvents();

}

//重新初始化和播放

videoPara.videoUrl = videoUrl;

if (this->init()) {

this->play();

return true;

} else {

return false;

}

}

void VideoWidget::play()

{

//如果是图片则只显示图片就行

image = QImage(videoPara.videoUrl);

if (!image.isNull()) {

videoThread->setVideoSize(QString("%1x%2").arg(image.width()).arg(image.height()));

this->setImage(image);

return;

}

//采用已经存在的采集线程如果处于解码正常阶段则还要发几个信号通知

if (videoThread->getIsOk()) {

QMetaObject::invokeMethod(this, "receivePlayStart", Qt::DirectConnection, Q_ARG(int, 0));

QMetaObject::invokeMethod(videoThread, "receiveSizeChanged", Qt::DirectConnection);

QMetaObject::invokeMethod(videoThread, "receiveDuration", Qt::DirectConnection, Q_ARG(qint64, videoThread->getDuration()));

}

//已经在运行阶段还要发送已经开始的信号

if (videoThread->isRunning()) {

isRunning = true;

QMetaObject::invokeMethod(this, "sig_receivePlayStart", Qt::DirectConnection, Q_ARG(int, 0));

}

//启动播放线程

videoThread->play();

//初始化标签信息和图形信息

this->osdChanged();

this->graphChanged();

}

void VideoWidget::stop()

{

//立即隐藏悬浮条

bannerWidget->setVisible(false);

//关闭的时候将遮罩控件移到最前

hwndWidget->stackUnder(coverWidget);

//处于运行状态才可以停止

if (videoThread && videoThread->isRunning()) {

//先判断当前线程的引用计数是0才需要真正停止

if (videoThread->refCount > 0) {

//减少引用计数

videoThread->refCount--;

//执行停止信号

QMetaObject::invokeMethod(this, "receivePlayFinsh", Qt::DirectConnection);

QMetaObject::invokeMethod(this, "sig_receivePlayFinsh", Qt::DirectConnection);

//取消信号关联

disconnectThreadSignal();

videoThread = NULL;

} else {

//停止播放

videoThread->stop();

//取消信号关联

disconnectThreadSignal();

//从队列中移除

VideoThread::videoThreads.removeOne(videoThread);

//释放线程

videoThread->debug("删除线程", "");

videoThread->deleteLater();

videoThread = NULL;

}

}

//复位标志位并将线程置空(没有这个的话可能会出现野指针的情况)

isRunning = false;

isShared = false;

videoThread = NULL;

videoPara.reset();

AbstractVideoWidget::clear();

}

五、功能特点

5.1 基础功能

- 支持各种音频视频文件格式,比如mp3、wav、mp4、asf、rm、rmvb、mkv等。

- 支持本地摄像头设备,可指定分辨率、帧率。

- 支持各种视频流格式,比如rtp、rtsp、rtmp、http等。

- 本地音视频文件和网络音视频文件,自动识别文件长度、播放进度、音量大小、静音状态等。

- 文件可以指定播放位置、调节音量大小、设置静音状态等。

- 支持倍速播放文件,可选0.5倍、1.0倍、2.5倍、5.0倍等速度,相当于慢放和快放。

- 支持开始播放、停止播放、暂停播放、继续播放。

- 支持抓拍截图,可指定文件路径,可选抓拍完成是否自动显示预览。

- 支持录像存储,手动开始录像、停止录像,部分内核支持暂停录像后继续录像,跳过不需要录像的部分。

- 支持无感知切换循环播放、自动重连等机制。

- 提供播放成功、播放完成、收到解码图片、收到抓拍图片、视频尺寸变化、录像状态变化等信号。

- 多线程处理,一个解码一个线程,不卡主界面。

5.2 特色功能

- 同时支持多种解码内核,包括qmedia内核(Qt4/Qt5/Qt6)、ffmpeg内核(ffmpeg2/ffmpeg3/ffmpeg4/ffmpeg5)、vlc内核(vlc2/vlc3)、mpv内核(mpv1/mp2)、海康sdk、easyplayer内核等。

- 非常完善的多重基类设计,新增一种解码内核只需要实现极少的代码量,就可以应用整套机制。

- 同时支持多种画面显示策略,自动调整(原始分辨率小于显示控件尺寸则按照原始分辨率大小显示,否则等比例缩放)、等比例缩放(永远等比例缩放)、拉伸填充(永远拉伸填充)。所有内核和所有视频显示模式下都支持三种画面显示策略。

- 同时支持多种视频显示模式,句柄模式(传入控件句柄交给对方绘制控制)、绘制模式(回调拿到数据后转成QImage用QPainter绘制)、GPU模式(回调拿到数据后转成yuv用QOpenglWidget绘制)。

- 支持多种硬件加速类型,ffmpeg可选dxva2、d3d11va等,mpv可选auto、dxva2、d3d11va,vlc可选any、dxva2、d3d11va。不同的系统环境有不同的类型选择,比如linux系统有vaapi、vdpau,macos系统有videotoolbox。

- 解码线程和显示窗体分离,可指定任意解码内核挂载到任意显示窗体,动态切换。

- 支持共享解码线程,默认开启并且自动处理,当识别到相同的视频地址,共享一个解码线程,在网络视频环境中可以大大节约网络流量以及对方设备的推流压力。国内顶尖视频厂商均采用此策略。这样只要拉一路视频流就可以共享到几十个几百个通道展示。

- 自动识别视频旋转角度并绘制,比如手机上拍摄的视频一般是旋转了90度的,播放的时候要自动旋转处理,不然默认是倒着的。

- 自动识别视频流播放过程中分辨率的变化,在视频控件上自动调整尺寸。比如摄像机可以在使用过程中动态配置分辨率,当分辨率改动后对应视频控件也要做出同步反应。

- 音视频文件无感知自动切换循环播放,不会出现切换期间黑屏等肉眼可见的切换痕迹。

- 视频控件同时支持任意解码内核、任意画面显示策略、任意视频显示模式。

- 视频控件悬浮条同时支持句柄、绘制、GPU三种模式,非绝对坐标移来移去。

- 本地摄像头设备支持指定设备名称、分辨率、帧率进行播放。

- 录像文件同时支持打开的视频文件、本地摄像头、网络视频流等。

- 瞬间响应打开和关闭,无论是打开不存在的视频或者网络流,探测设备是否存在,读取中的超时等待,收到关闭指令立即中断之前的操作并响应。

- 支持打开各种图片文件,支持本地音视频文件拖曳播放。

- 视频控件悬浮条自带开始和停止录像切换、声音静音切换、抓拍截图、关闭视频等功能。

- 音频组件支持声音波形值数据解析,可以根据该值绘制波形曲线和柱状声音条,默认提供了声音振幅信号。

- 各组件中极其详细的打印信息提示,尤其是报错信息提示,封装的统一打印格式。针对现场复杂的设备环境测试极其方便有用,相当于精确定位到具体哪个通道哪个步骤出错。

- 代码框架和结构优化到最优,性能强悍,持续迭代更新升级。

- 源码支持Qt4、Qt5、Qt6,兼容所有版本。

5.3 视频控件

- 可动态添加任意多个osd标签信息,标签信息包括名字、是否可见、字号大小、文本文字、文本颜色、标签图片、标签坐标、标签格式(文本、日期、时间、日期时间、图片)、标签位置(左上角、左下角、右上角、右下角、居中、自定义坐标)。

- 可动态添加任意多个图形信息,这个非常有用,比如人工智能算法解析后的图形区域信息直接发给视频控件即可。图形信息支持任意形状,直接绘制在原始图片上,采用绝对坐标。

- 图形信息包括名字、边框大小、边框颜色、背景颜色、矩形区域、路径集合、点坐标集合等。

- 每个图形信息都可指定三种区域中的一种或者多种,指定了的都会绘制。

- 内置悬浮条控件,悬浮条位置支持顶部、底部、左侧、右侧。

- 悬浮条控件参数包括边距、间距、背景透明度、背景颜色、文本颜色、按下颜色、位置、按钮图标代码集合、按钮名称标识集合、按钮提示信息集合。

- 悬浮条控件一排工具按钮可自定义,通过结构体参数设置,图标可选图形字体还是自定义图片。

- 悬浮条按钮内部实现了录像切换、抓拍截图、静音切换、关闭视频等功能,也可以自行在源码中增加自己对应的功能。

- 悬浮条按钮对应实现了功能的按钮,有对应图标切换处理,比如录像按钮按下后会切换到正在录像中的图标,声音按钮切换后变成静音图标,再次切换还原。

- 悬浮条按钮单击后都用名称唯一标识作为信号发出,可以自行关联响应处理。

- 悬浮条空白区域可以显示提示信息,默认显示当前视频分辨率大小,可以增加帧率、码流大小等信息。

- 视频控件参数包括边框大小、边框颜色、焦点颜色、背景颜色(默认透明)、文字颜色(默认全局文字颜色)、填充颜色(视频外的空白处填充黑色)、背景文字、背景图片(如果设置了图片优先取图片)、是否拷贝图片、缩放显示模式(自动调整、等比例缩放、拉伸填充)、视频显示模式(句柄、绘制、GPU)、启用悬浮条、悬浮条尺寸(横向为高度、纵向为宽度)、悬浮条位置(顶部、底部、左侧、右侧)。

5.4 内核ffmpeg

- 支持各种音视频文件、本地摄像头设备,各种视频流网络流。

- 支持开始播放、暂停播放、继续播放、停止播放、设置播放进度、倍速播放。

- 可设置音量、静音切换、抓拍图片、录像存储。

- 自动提取专辑信息比如标题、艺术家、专辑、专辑封面,自动显示专辑封面。

- 完美支持音视频同步和倍速播放。

- 解码策略支持速度优先、质量优先、均衡处理、最快速度。

- 支持手机视频旋转角度显示,比如一般手机拍摄的视频是旋转了90度的,解码显示的时候需要重新旋转90度才是正的。

- 自动转换yuv420格式,比如本地摄像头是yuyv422格式,有些视频文件是xx格式,统一将非yuv420格式转换,然后再进行处理。

- 支持硬解码dxva2、d3d11va等,性能极高尤其是大分辨率比如4K视频。

- 视频响应极低延迟0.2s左右,极速响应打开视频流0.5s左右,专门做了优化处理。

- 硬解码和GPU绘制组合,极低CPU占用,比海康大华等客户端更优。

- 支持视频流中的各种音频格式,AAC、PCM、G.726、G.711A、G.711Mu、G.711ulaw、G.711alaw、MP2L2等都支持,推荐选择AAC兼容性跨平台性最好。

- 视频存储支持yuv、h264、mp4多种格式,音频存储支持pcm、wav、aac多种格式。默认视频mp4格式、音频aac格式。

- 支持分开存储音频视频文件,也支持合并到一个mp4文件,默认策略是无论何种音视频文件格式存储,最终都转成mp4及aac格式,然后合并成音视频一起的mp4文件。

- 支持本地摄像头实时视频显示带音频输入输出,音视频录制合并到一个mp4文件。

- 支持H264/H265编码(现在越来越多的监控摄像头是H265视频流格式)生成视频文件,内部自动识别切换编码格式。

- 自动识别视频流动态分辨率改动,重新打开视频流。

- 支持用户信息中包含特殊字符(比如用户信息中包含+#@等字符)的视频流播放,内置解析转义处理。

- 纯qt+ffmpeg解码,非sdl等第三方绘制播放依赖,gpu绘制采用qopenglwidget,音频播放采用qaudiooutput。

- 同时支持ffmpeg2、ffmpeg3、ffmpeg4、ffmpeg5版本,全部做了兼容处理。如果需要支持xp需要选用ffmpeg3及以下。

Qt音视频开发15-动态切换解码内核的设计的更多相关文章

- Android开发 音视频开发需要了解的专业术语知识

前言 在摸索一段时间的音视频开发后,越来越发现这个坑的深度真是特别的深. 除了了解Android自带的音视频处理API以外,还得了解一些视频与音频方面的知识.这篇博客就是主要讲解这方面的专业术语.内容 ...

- Android IOS WebRTC 音视频开发总结(八十五)-- 使用WebRTC广播网络摄像头视频(下)

本文主要介绍WebRTC (我们翻译和整理的,译者:weizhenwei,校验:blacker),最早发表在[编风网] 支持原创,转载必须注明出处,欢迎关注我的微信公众号blacker(微信ID:bl ...

- WebRTC 音视频开发

WebRTC 音视频开发 webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译 ...

- 转:Android IOS WebRTC 音视频开发总结 (系列文章集合)

随笔分类 - webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译和整理的,译 ...

- 【秒懂音视频开发】02_Windows开发环境搭建

音视频开发库的选择 每个主流平台基本都有自己的音视频开发库(API),用以处理音视频数据,比如: iOS:AVFoundation.AudioUnit等 Android:MediaPlayer.Med ...

- Android IOS WebRTC 音视频开发总结(六)-- iOS开发之含泪经验

前段时间在搞webrtc iOS开发,所以将标题改为了Android IOS WebRTC 音视频开发总结, 下面都是开发过程中的经验总结,转载请说明出处(博客园RTC.Blacker): 1. IO ...

- Android 音视频开发学习思路

Android 音视频开发这块目前的确没有比较系统的教程或者书籍,网上的博客文章也都是比较零散的.只能通过一点点的学习和积累把这块的知识串联积累起来. 初级入门篇: Android 音视频开发(一) ...

- 音视频开发-FFmpeg

音视频开发是个非常复杂的,庞大的开发话题,初涉其中,先看一下结合 OEIP(开源项目) 新增例子. 可以打开flv,mp4类型文件,以及rtmp协议音视频数据,声音的播放使用SDL. 把采集的麦/声卡 ...

- Python音视频开发:消除抖音短视频Logo的图形化工具实现

☞ ░ 前往老猿Python博文目录 ░ 一.引言 在<Python音视频开发:消除抖音短视频Logo和去电视台标的实现详解>节介绍了怎么通过Python+Moviepy+OpenCV实现 ...

- Moviepy音视频开发:视频转gif动画或jpg图片exe图形化工具开发案例

☞ ░ 前往老猿Python博文目录 ░ 一.引言 老猿之所以学习和研究Moviepy的使用,是因为需要一个将视频转成动画的工具,当时在网上到处搜索查找免费使用工具,结果找了很多自称免费的工具,但转完 ...

随机推荐

- signalR的身份认证

- kubernetes中pod的隔离策略

配置容器级别的安全控制 使用宿主机的网络模式 可以通过设置pod的spec的hostNetwork参数为true开启容器的"host"network模式 spec: hostNet ...

- CNI 基准测试:Cilium 网络性能分析

原文链接:https://cilium.io/blog/2021/05/11/cni-benchmark 作者:Thomas Graf 译者:罗煜.张亮,均来自KubeSphere 团队 Thomas ...

- 微软nuget国内源

https://www.cnblogs.com/Leo_wl/p/16328650.html 为解决国内访问NuGet服务器速度不稳定的问题 ,这里推荐使用NuGet微软官方中国国内镜像 地址:htt ...

- ESP32+L298N+MQTT+4G无线远程监控+四驱动小破车

ESP32+L298N+MQTT+4G无线远程监控+四驱动小破车 小车源代码 注意修改WIFI 信息 #include <analogWrite.h> #include <WiFi. ...

- 2024年全国大学生信息安全竞赛安徽省赛-WP

2024年全国大学生信息安全竞赛安徽省赛-WP 没有re,不会...... 0X01 初赛(CTF) MISC 图像损坏 损坏的GIF文件,补上缺失的文件头 用puzz拆分GIF,得到多个图片 ...

- TPS和QPS区别与计算

1.定义 TPS(Transactions Per Second):每秒事务数.事务是指一个完整的业务处理过程,例如用户完成一次购物支付的过程,从挑选商品.下单.支付到生成订单,这一系列操作可以看作是 ...

- 组装一台100TB全闪存100G光纤网络海景房幻彩RGB文件服务器【翼王】

视频地址: https://www.youtube.com/watch?v=lzPSIzbYrlU

- 4.8 Linux解压.bz2格式的文件(bunzip2命令)

要解压".bz2"格式的压缩包文件,除了使用"bzip2 -d 压缩包名"命令外,还可以使用 bunzip2 命令. bunzip2 命令的使用和 gunzip ...

- kubernetes组件大全

master节点组件 控制平面的组件我们会找一台单独的机器来部署,我们习惯上把部署控制平面组件的机器称为master节点,以下都会用master节点来代替控制平面这个概念,master节点的组件能够对 ...