爬虫_电影天堂 热映电影(xpath)

写了一天才写了不到100行。不过总归是按自己的思路完成了

import requests

from lxml import etree

import time BASE = 'http://www.dytt8.net'

def get_one_page(url):

headers = {'User-Agent': 'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.75 Safari/537.36'}

try: response = requests.get(url, headers=headers)

response.encoding = response.apparent_encoding

return response.text

except:

return 0 def parse_one_page_href(html):

str_hrefs = []

html_element = etree.HTML(html)

# //div[@class="co_content8"]/ul/table//a/@href

hrefs = html_element.xpath('//table[@class="tbspan"]//a/@href')

for href in hrefs:

href = BASE + href

str_hrefs.append(href)

return str_hrefs """

return

['http://www.dytt8.net/html/gndy/dyzz/20180731/57193.html',

'http://www.dytt8.net/html/gndy/dyzz/20180730/57192.html',

......

'http://www.dytt8.net/html/gndy/dyzz/20180702/57064.html',

'http://www.dytt8.net/html/gndy/dyzz/20180630/57056.html']

""" def get_all_pages(page_nums):

hrefs = []

for index in range(1, page_nums + 1):

url = 'http://www.dytt8.net/html/gndy/dyzz/list_23_' + str(index) + '.html'

html = get_one_page(url)

while html == 0:

time.sleep(3)

html = get_one_page(url)

hrefs.extend(parse_one_page_href(html))

return hrefs def get_detail(page_nums):

movie = []

hrefs = get_all_pages(page_nums)

for href in hrefs: #href: every page url

informations = {} response = requests.get(href)

response.encoding = response.apparent_encoding

html = response.text html_element = etree.HTML(html) title = html_element.xpath('//font[@color="#07519a"]/text()')[0]

informations['title'] = title image_src = html_element.xpath('//p//img/@src')

informations['image_src'] = image_src[0] download_url = html_element.xpath('//td[@bgcolor="#fdfddf"]/a/@href')

informations['download_url'] = download_url texts = html_element.xpath('//div[@id="Zoom"]//p/text()')

for index, text in enumerate(texts): if text.startswith('◎片 名'):

text = text.replace('◎片 名', '').strip()

informations['english_name'] = text elif text.startswith('◎产 地'):

text = text.replace('◎产 地', '').strip()

informations['location'] = text elif text.startswith('◎上映日期'):

text = text.replace('◎上映日期', '').strip()

informations['date'] = text elif text.startswith('◎片 长'):

text = text.replace('◎片 长', '').strip()

informations['time'] = text elif text.startswith('◎导 演'):

text = text.replace('◎导 演', '').strip()

informations['director'] = text elif text.startswith('◎主 演'):

text = text.replace('◎主 演', '').strip()

actors = []

actors.append(text)

for x in range(index+1, len(texts)):

actor = texts[x].strip()

if texts[x].startswith('◎简 介'):

break

actors.append(actor)

informations['actors'] = actors elif text.startswith('◎简 介 '):

text = text.replace('◎简 介 ', '').strip()

intros = []

# intros.append(text)

for x in range(index+1, len(texts)):

intro = texts[x].strip()

if texts[x].startswith('◎获奖情况'):

break

intros.append(intro)

informations['intros'] = intros

movie.append(informations)

return movie def main():

page_nums = 1 #

movie = get_detail(page_nums)

print(movie) if __name__ == '__main__':

main()

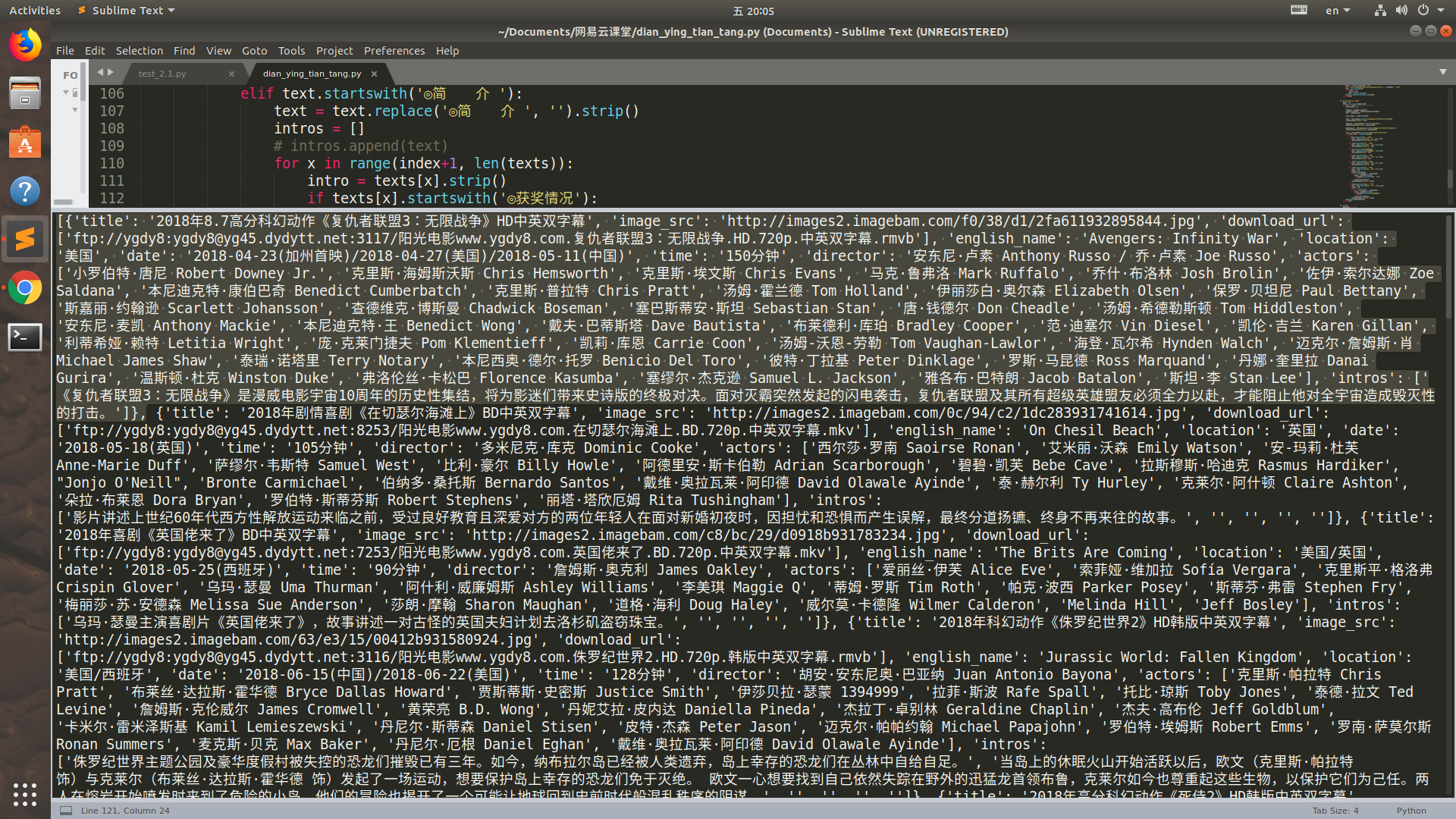

运行结果:(选中的是一部电影, 一页中有25部电影,网站里一共有176页)

感受到了代码的魅力了吗

爬虫_电影天堂 热映电影(xpath)的更多相关文章

- python爬虫——爬取淘票票正在热映电影

今天正好学习了一下python的爬虫,觉得收获蛮大的,所以写一篇博客帮助想学习爬虫的伙伴们. 这里我就以一个简单地爬取淘票票正在热映电影为例,介绍一下一个爬虫的完整流程. 首先,话不多说,上干货——源 ...

- Node.js 抓取电影天堂新上电影节目单及ftp链接

代码地址如下:http://www.demodashi.com/demo/12368.html 1 概述 本实例主要使用Node.js去抓取电影的节目单,方便大家使用下载. 2 node packag ...

- 爬虫_豆瓣全部正在热映电影 (xpath)

单纯地练习一下xpath import requests from lxml import etree def get_url(url): html = requests.get(url) retur ...

- python爬虫——词云分析最热门电影《后来的我们》

1 模块库使用说明 1.1 requests库 requests 是用Python语言编写,基于 urllib,采用 Apache2 Licensed 开源协议的 HTTP 库.它比 urllib 更 ...

- python利用requests和threading模块,实现多线程爬取电影天堂最新电影信息。

利用爬到的数据,基于Django搭建的一个最新电影信息网站: n1celll.xyz (用的花生壳动态域名解析,服务器在自己的电脑上,纯属自娱自乐哈.) 今天想利用所学知识来爬取电影天堂所有最新电影 ...

- LOL电影天堂下载攻略

LOL电影天堂&&飘花电影网下载攻略 CreateTime--2017年7月27日08:52:29Author:Marydon 以进击的巨人为例 下载地址:http://www.l ...

- Python多线程爬虫爬取电影天堂资源

最近花些时间学习了一下Python,并写了一个多线程的爬虫程序来获取电影天堂上资源的迅雷下载地址,代码已经上传到GitHub上了,需要的同学可以自行下载.刚开始学习python希望可以获得宝贵的意见. ...

- scrapy电影天堂实战(二)创建爬虫项目

公众号原文 创建数据库 我在上一篇笔记中已经创建了数据库,具体查看<scrapy电影天堂实战(一)创建数据库>,这篇笔记创建scrapy实例,先熟悉下要用到到xpath知识 用到的xpat ...

- 用python+selenium抓取豆瓣电影中的正在热映前12部电影并按评分排序

抓取豆瓣电影(http://movie.douban.com/nowplaying/chengdu/)中的正在热映前12部电影,并按照评分排序,保存至txt文件 #coding=utf-8 from ...

随机推荐

- POJ - 3244-Difference between Triplets

其实我最开始没有这道题...是做到UPC-11079-小P的决斗,训练结束后然后搜索了一波,才了解这个题的. 非常牛逼的题...这么多人做出来了...我好菜... 对于每对三元组Ta=(La,Ja,K ...

- pandas数据清洗策略2

首先,我们先要读入数据: 然后检查数据出现的问题: 1.没有表头,增加表头 2.去除重复值: df.duplicate()使用布尔数据查看数据表中是否有重复值,df.drop_duplicates() ...

- 通过C#调用,实现js加密代码的反混淆,并运行js函数

前一篇我测试了vba调用htmlfile做反混淆,并执行js加密函数的代码.本文换成C#实现. 联系QQ:564955427 C#操作JS函数,可以通过ScriptControl组件,但这个组件只能在 ...

- PS调出冷绿色电影画面风格

原图 一.按照惯例先磨皮,我修照片的习惯是,先拉一层色阶,使直方图平均分配,画面会显得没那么灰,当然,这只是个人喜好,先加后加都没所谓. 二.由于脸部的亮度不够,显得有点脏.所以这一步主要是通过拉曲线 ...

- shell正则表达

shell正则表达 .*和.?的比较: 比如说匹配输入串A: 101000000000100 使用 1.*1 将会匹配到1010000000001,匹配方法:先匹配至输入串A的最后, 然后向前匹配,直 ...

- 2019省赛训练组队赛3.31周四-17fj

https://vjudge.net/contest/289558#overview A - Frog Therearex frogs and y chicken in a garden. Kim f ...

- 本地数据访问时出现跨域问题Cross origin requests are only supported for protocol schemes: ……

从桌面找到Chrome图标,右键属性,快捷方式,起始位置(安装路径) 注:在cmd中访问Program Files文件的方法 %ProgramFiles%=C:\Program Files %Prog ...

- hashCode和equals的关系分析

hashCode:说白了,简单的就看做一个函数,但是该函数有可能出现:对于某个x值,存在不止一个y值与之对应.这种情况就叫哈希碰撞. 那么: 1.如果hashCode相等,两个对象不一定是同一个对象( ...

- springboot No Identifier specified for entity的解决办法

今天在做一个项目的时候遇到一个问题,实体类忘了指定主键id,然后报如下错误,也是自己粗心大意造成的,在此记录下. java.lang.IllegalStateException: Failed to ...

- scrapy全站爬取拉勾网及CrawSpider介绍

一.指定模板创建爬虫文件 命令 创建成功后的模板,把http改为https 二.CrawSpider源码介绍 1.官网介绍: 这是用于抓取常规网站的最常用的蜘蛛,因为它通过定义一组规则为跟踪链接提供了 ...