爬虫实现51job谁看过我的简历多条记录功能

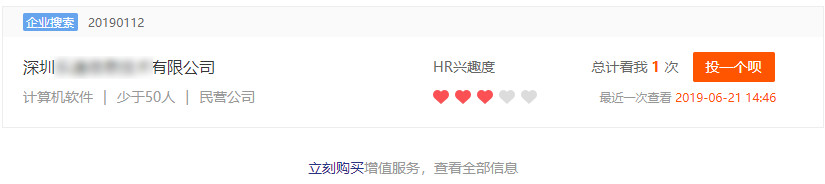

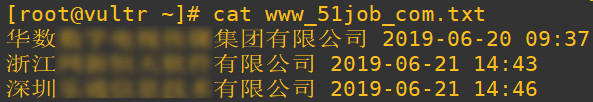

默认情况下51job只能看到最近一条记录,查看更多记录需要付费。

本文利用爬虫定时抓取记录,并追加写入到文本的方式获取完整的记录信息。

import requests

from bs4 import BeautifulSoup class www_51job_com(object):

def __init__(self):

self.url = "https://i.51job.com/userset/resume_browsed.php?lang=c" self.headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.102 Safari/537.36"

} self.cookies = "替换你的cookie" def get_url(self,url):

cookies_dict = {}

for i in self.cookies.split("; "):

cookies_dict[i.split("=")[0]] = i.split("=")[1] response = requests.get(url=url,headers=self.headers,cookies=cookies_dict)

return response.content.decode('gbk') def soup(self,data):

soup_data = BeautifulSoup(data,'lxml')

company = soup_data.select("body > div.content > div.exrt > div.lmsg > div.e > div.txt > div.li.l1 > p > a")[0].get_text()

care_time = soup_data.select("body > div.content > div.exrt > div.lmsg > div.e > div.txt > div.li.l3 > div.f12 > span")[0].get_text()

return company +' '+ care_time def save_file(self,company_caretime):

with open('www_51job_com.txt','a+',encoding='utf-8') as f:

f.seek(0)

lines = f.readlines()

try:

if lines[-1] != company_caretime+'\n':

f.write(company_caretime + '\n')

except IndexError:

f.write(company_caretime+'\n') def run(self):

response = self.get_url(self.url)

result = self.soup(response)

self.save_file(result) if __name__ == '__main__':

personal_center = www_51job_com()

personal_center.run()

爬虫实现51job谁看过我的简历多条记录功能的更多相关文章

- 萝卜招聘网 http://www.it9s.com 可以发布免费下载简历求职 ,免费!免费!全部免费!找工作看过来 免费下载简历 !

萝卜招聘网 http://www.it9s.com 可以发布免费下载简历求职 ,免费!免费!全部免费!找工作看过来 免费下载简历 !萝卜招聘网 http://www.it9s.com 可以发布 ...

- 第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能

第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能 Django实现搜索功能 1.在Django配置搜索结果页的路由映 ...

- CSDN日报20170328——《你看那个人他像一条狗》

[程序人生]你看那个人他像一条狗 作者:清纯的微笑 今年三十了,到了传说中程序猿最应该迷茫的年龄了,那么我迷茫吗,没的说,依照华为34岁就要劝退的要求,我还有4年的程序生涯. [微信小程序]重磅!个人 ...

- 体验了把做HR的感觉,上午看了40份简历,说说感受

原文链接:http://huachichi.info/2013/06/26/experience-of-being-a-hr/ 这两天准备从IBM离职,不要问我为什么要在这么bug的时间离职,总之 ...

- python爬虫-《笔趣看》网小说《悟空看私聊》

小编是个爱看小说的人,哈哈 # -*- coding:UTF-8 -*- ''' 类说明:下载<笔趣看>网小说<悟空看私聊> ''' from bs4 import Beaut ...

- 【Python3爬虫】网络小说更好看?十四万条书籍信息告诉你

一.前言简述 因为最近微信读书出了网页版,加上自己也在闲暇的时候看了两本书,不禁好奇什么样的书更受欢迎,哪位作者又更受读者喜欢呢?话不多说,爬一下就能有个了解了. 二.页面分析 首先打开微信读书:ht ...

- 看完知乎上500条答案,我为大家整理了这21个B站学习类UP主

原文之前发在我的知乎,转载请注明出处. 虽然,今天算法文章还没更新┏(゜ロ゜;)┛,但还是溜过来跑个题~ 之前看到了博客上有小伙伴在分享自己的B站资源,才突然意识到自己其实也积攒了很多优秀UP的资 ...

- 清空网站浏览记录就行啦?看Python如何实时监控网站浏览记录

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 需求: (1) 获取你对象chrome前一天的浏览记录中的所有网址(url ...

- 打开黑盒:从 MySQL架构设计出发,看它是如何执行一条 SQL语句的

1.把MySQL当个黑盒子一样执行SQL语句 我们的系统采用数据库连接池的方式去并发访问数据库,然后数据库自己其实也会维护一个连接池,其中管理了各种系统跟这台数据库服务器建立的所有连接 当我们的系统只 ...

随机推荐

- CodeForces 835D - Palindromic characteristics | Codeforces Round #427 (Div. 2)

证明在Tutorial的评论版里 /* CodeForces 835D - Palindromic characteristics [ 分析,DP ] | Codeforces Round #427 ...

- toggle([speed],[easing],[fn]) 用于绑定两个或多个事件处理器函数,以响应被选元素的轮流的 click 事件。

toggle([speed],[easing],[fn]) 概述 用于绑定两个或多个事件处理器函数,以响应被选元素的轮流的 click 事件. 如果元素是可见的,切换为隐藏的:如果元素是隐藏的,切换为 ...

- 強悍的Linq

在使用Linq轉化XML,ActiveDirectory,Datatable,Array,List,Dictionary后意識到Linq的強大.VS居然還提供專門的LINQ Explorer,不覺明厲 ...

- Win2008 R2 IIS FTP防火墙的配置

注意以下两个选项要在防火墙下开启,否则将会访问失败.

- 【csp模拟赛2】 爆搜 方格加数

[题目描述] xyz1048576正在玩一个关于矩阵的游戏. 一个n*m的矩阵,矩阵中每个数都是[1,12]内的整数.你可以执行下列两个操作任意多次: (1)指定一行,将该行所有数字+1. (2)指定 ...

- 【luoguP2483】k短路([SDOI2010]魔法猪学院)

题目描述 iPig在假期来到了传说中的魔法猪学院,开始为期两个月的魔法猪训练.经过了一周理论知识和一周基本魔法的学习之后,iPig对猪世界的世界本原有了很多的了解:众所周知,世界是由元素构成的:元素与 ...

- django-配置相关

1 自己配置一个静态文件夹 settings.py中 # 用户上传的文件配置 MEDIA_URL = '/media/' MEDIA_ROOT = os.path.join(BASE_DIR, 'me ...

- The Road to SDN: An Intellectual History of Programmable Networks

文章名称:The Road to SDN: An Intellectual History of Programmable Networks 文章来源:Feamster N , Rexford J , ...

- LVS集群之IP TUN模式以及网站压力测试

今天来看一下LVS的第三种模式IP TUN. TUN方式,是通过给数据包加上新的IP头部来实现,这个可以跨整个广域网. 环境: 主机名 IP 系统 角色 tiandong63 RIP:192.168. ...

- Java多线程之ThreadPoolExecutor详解使用

1.概述 我将讲解JAVA原生线程池的基本使用,并由此延伸出JAVA中和线程管理相关的类结构体系,然后我们详细描述JAVA原生线程池的结构和工作方式 2.为什么要使用线程池 前文我们已经讲到,线程是一 ...