使用Selenium&PhantomJS的方式爬取代理

前面已经爬取了代理,今天我们使用Selenium&PhantomJS的方式爬取快代理 :快代理 - 高速http代理ip每天更新。

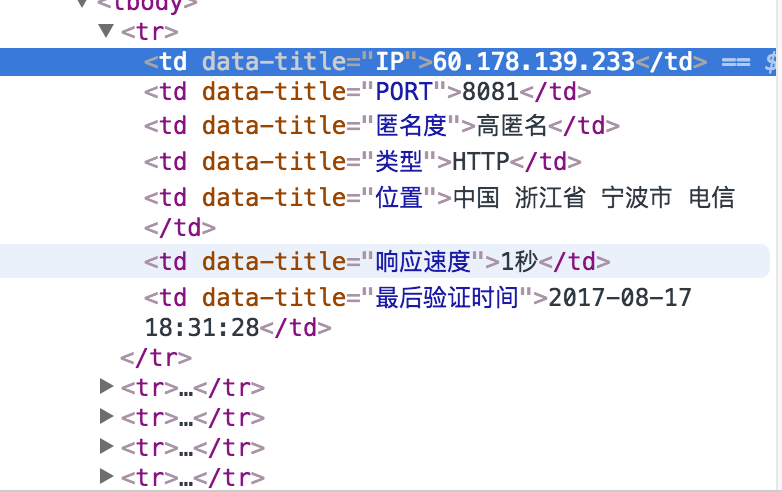

首先分析一下快代理,如下

使用谷歌浏览器,检查,发现每个代理信息都在tr里面,每个tr里面包含多个td,就是IP的信息。

这个结构我们可以通过多种方法抓取,例如bs4、xpath、selenium等

这里我们演示selenium方法。具体解释在下面代码中都有的。

from selenium import webdriver class Item(object):

'''

模拟scrapy框架

写item类

用以表示每个代理

'''

ip = None #IP地址

port = None #端口

anonymous = None #是否匿名

type = None #http 或者https

local = None #物理地址

speed = None #速度 class GetProxy(object):

def __init__(self):

self.starturl = 'http://www.kuaidaili.com/free/inha/'

self.urls = self.get_urls()

self.proxylist = self.get_proxy_list(self.urls)

self.filename = 'proxy.txt'

self.saveFile(self.filename,self.proxylist) def get_urls(self):

'''

:return: 返回代理url列表

'''

urls = []

for i in range(1,3):

url = self.starturl + str(i)

urls.append(url)

return urls def get_proxy_list(self,urls):

'''

爬取代理列表

:param urls:

:return:

'''

browser = webdriver.PhantomJS()

proxy_list = [] for url in urls:

browser.get(url) # 通过get方法打开

browser.implicitly_wait(3)

elements = browser.find_elements_by_xpath('//tbody/tr') #找到每个代理的位置

for element in elements:

item = Item()

item.ip = element.find_element_by_xpath('./td[1]').text

item.port = element.find_element_by_xpath('./td[2]').text

item.anonymous = element.find_element_by_xpath('./td[3]').text

item.local = element.find_element_by_xpath('./td[4]').text

item.speed = element.find_element_by_xpath('./td[5]').text

print(item.ip)

proxy_list.append(item) browser.quit()

return proxy_list def saveFile(self,filename,proxy_list):

'''

将爬取的信息保存到本地

:param filename:

:param proxy_list:

:return:

'''

with open(filename,'w') as f:

for item in proxy_list:

f.write(item.ip + '\t')

f.write(item.port + '\t')

f.write(item.anonymous + '\t')

f.write(item.local + '\t')

f.write(item.speed + '\n\n') if __name__ == '__main__':

Get = GetProxy()

下面我们展示一下爬取的结果

如果用到代理的话,还需要对这些IP进行测试一下。

使用Selenium&PhantomJS的方式爬取代理的更多相关文章

- 使用selenium+phantomJS实现网页爬取

有些网站反爬虫技术设计的非常好,很难采用WebClient等技术进行网页信息爬取,这时可以考虑采用selenium+phantomJS模拟浏览器(其实是真实的浏览器)的方式进行信息爬取.之前一直使用的 ...

- selenium&phantomjs实战--漫话爬取

为什么直接保存当前网页,而不是找到所有漫话链接,再有针对性的保存图片? 因为防盗链的原因,当直接保存漫话链接图片时,只能保存到防盗链的图片. #!/usr/bin/env python # _*_ c ...

- 针对源代码和检查元素不一致的网页爬虫——利用Selenium、PhantomJS、bs4爬取12306的列车途径站信息

整个程序的核心难点在于上次豆瓣爬虫针对的是静态网页,源代码和检查元素内容相同:而在12306的查找搜索过程中,其网页发生变化(出现了查找到的数据),这个过程是动态的,使得我们在审查元素中能一一对应看到 ...

- Selenium+Chrome/phantomJS模拟浏览器爬取淘宝商品信息

#使用selenium+Carome/phantomJS模拟浏览器爬取淘宝商品信息 # 思路: # 第一步:利用selenium驱动浏览器,搜索商品信息,得到商品列表 # 第二步:分析商品页数,驱动浏 ...

- Scrapy 通过登录的方式爬取豆瓣影评数据

Scrapy 通过登录的方式爬取豆瓣影评数据 爬虫 Scrapy 豆瓣 Fly 由于需要爬取影评数据在来做分析,就选择了豆瓣影评来抓取数据,工具使用的是Scrapy工具来实现.scrapy工具使用起来 ...

- python爬虫爬取代理IP

# #author:wuhao # #--*------------*-- #-****#爬取代理IP并保存到Excel----#爬取当日的代理IP并保存到Excel,目标网站xicidaili.co ...

- Python爬虫-代理池-爬取代理入库并测试代理可用性

目的:建立自己的代理池.可以添加新的代理网站爬虫,可以测试代理对某一网址的适用性,可以提供获取代理的 API. 整个流程:爬取代理 ----> 将代理存入数据库并设置分数 ----> 从数 ...

- Python实训day07pm【Selenium操作网页、爬取数据-下载歌曲】

练习1-爬取歌曲列表 任务:通过两个案例,练习使用Selenium操作网页.爬取数据.使用无头模式,爬取网易云的内容. ''' 任务:通过两个案例,练习使用Selenium操作网页.爬取数据. 使用无 ...

- 爬虫实例——爬取淘女郎相册(通过selenium、PhantomJS、BeautifulSoup爬取)

环境 操作系统:CentOS 6.7 32-bit Python版本:2.6.6 第三方插件 selenium PhantomJS BeautifulSoup 代码 # -*- coding: utf ...

随机推荐

- Hibernate学习2—Hibernate4 CRUD体验初步

接着上一节,工程结构: jar包没有变化: 一.HibernateUtil 封装: com.cy.util.HibernateUtil.java: package com.cy.util; impor ...

- 编译安装x264

网上也有相应的教程,之所以在这里重申一遍,是因为我试了网上很多的编译方法,都出现了问题,为此将此编译安装方法记录下来. 首先是 获取x264的网站:http://www.videolan.org/de ...

- java做web抓取

就像许多现代科技一样,从网站提取信息这一功能也有多个框架可以选择.最流行的有JSoup.HTMLUnit和Selenium WebDriver.我们这篇文章讨论JSoup.JSoup是个开源项目,提供 ...

- 简单租房子实例详解---(session、ajax、json前后台数据处理、分页)

本次实例我们结合session.ajax.json前后台数据处理.分页技术做一个租房信息系统 一共有五个界面:包括 管理员和用户的登录界面 登录界面的后台 <?php session_start ...

- Windbg查看w3wp进程占用的内存及.NET内存泄露,死锁分析

https://www.cnblogs.com/startpoint/p/4194052.html https://www.cnblogs.com/lyl6796910/p/7613664.html ...

- C++中结构体与类的区别 1

转载来源:http://blog.sina.com.cn/s/blog_48f587a80100k630.html C++中的struct对C中的struct进行了扩充,它已经不再只是一个包含不同数据 ...

- 判断和调整library cache,data dictionary cache,buffer cache性能

Oracle SGA是oracle的内存结构,存放着oracle通过oracle进程读写的内存数据.sga分为好多组件,比如shared pool,buffer cache,redo log buff ...

- Android屏幕适配方案——基于最小宽度(Smallest-width)限定符

转自:https://www.cnblogs.com/error404/p/3815739.html 一.关于布局适配建议 1.不要使用绝对布局 2.尽量使用match_parent 而不是fill_ ...

- 基于Tesseract的身份证识别Android端应用

以开源的Tesseract为基础,做了一个身份证识别的app. 图片资源是百度找的,而且手机对着电脑屏幕拍照,拍出很多花纹,影响比较大,所以误差不小,实测对着自己身份证拍照会好很多. 效果图: 1.拍 ...

- Elasticsearch-2.4.3的单节点安装(多种方式图文详解)

前提: Elasticsearch-2.4.3的下载(图文详解) 1.新建es安装目录 [root@djt002 local]# mkdir elasticsearch [root@djt002 lo ...