Python爬取imdb电影数据并存储到mysql数据库

数据获取方式:微信搜索关注【靠谱杨阅读人生】回复【电影】。

整理不易,资源付费,谢谢支持。

Python爬虫代码:

1 import re

2 import time

3 import traceback

4

5 from bs4 import BeautifulSoup

6 from lxml import etree

7 import pymysql

8 import requests

9 #连接数据库 获取游标

10 def get_conn():

11 """

12 :return: 连接,游标

13 """

14 # 创建连接

15 conn = pymysql.connect(host="82.157.112.34",

16 user="root",

17 password="root",

18 db="MovieRankings",

19 charset="utf8")

20 # 创建游标

21 cursor = conn.cursor() # 执行完毕返回的结果集默认以元组显示

22 if ((conn != None) & (cursor != None)):

23 print("数据库连接成功!游标创建成功!")

24 else:

25 print("数据库连接失败!")

26 return conn, cursor

27 #关闭数据库连接和游标

28 def close_conn(conn, cursor):

29 if cursor:

30 cursor.close()

31 if conn:

32 conn.close()

33 return 1

34 def get_imdb():

35

36 # url='https://www.imdb.cn/feature-film/1-0-0-0/?page=1'

37 headers={

38 'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.93 Safari/537.36'

39 }

40 dataRes=[] #最终结果集

41 temp_list=[] #暂时结果集

42

43 # print(all_li)

44

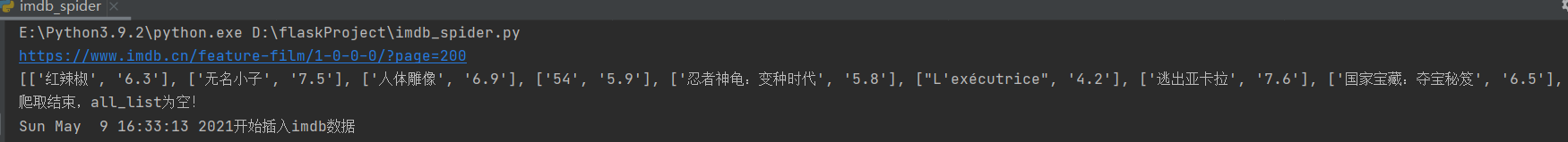

45 for i in range(200,202):

46 url_='https://www.imdb.cn/feature-film/1-0-0-0/?page='+str(i)

47 response = requests.get(url=url_, headers=headers)

48 # print(response)

49 response.encoding = 'utf-8'

50 page_text = response.text

51 # print(page_text)

52 etree_ = etree.HTML(page_text)

53 all_li = etree_.xpath('//div[@class="hot_box"]/ul/li') #获取所有li

54 #判断all_li是否为空

55 if(len(all_li)==0):

56 print("爬取结束,all_list为空!")

57 if(len(dataRes)!=0):

58 return dataRes;

59 else:

60 return ;

61 print(url_)

62 for li in all_li:

63 name=li.xpath('./a[1]/img/@alt')

64 if(len(name)==0):

65 name.append("电影名错误")

66 # print(name)

67 #存姓名

68 temp_list.append(name[0])

69

70 score=li.xpath('./span[@class="img_score"]/@title')

71 if(len(score)==0):

72 score.append("imdb暂无评分")

73 # print(score)

74 #存分数

75 temp_list.append(score[0])

76 # print(temp_list)

77 #存到dataRes 把temp_list置为空

78 dataRes.append(temp_list)

79 temp_list=[]

80 print(dataRes)

81 return dataRes

82 def insert_imdb():

83 """

84 插入imdb数据

85 :return:

86 """

87 cursor = None

88 conn = None

89 try:

90 list_=[]

91 list = get_imdb()

92 if(type(list)!=type(list_)):

93 return ;

94 print(f"{time.asctime()}开始插入imdb数据")

95 conn, cursor = get_conn()

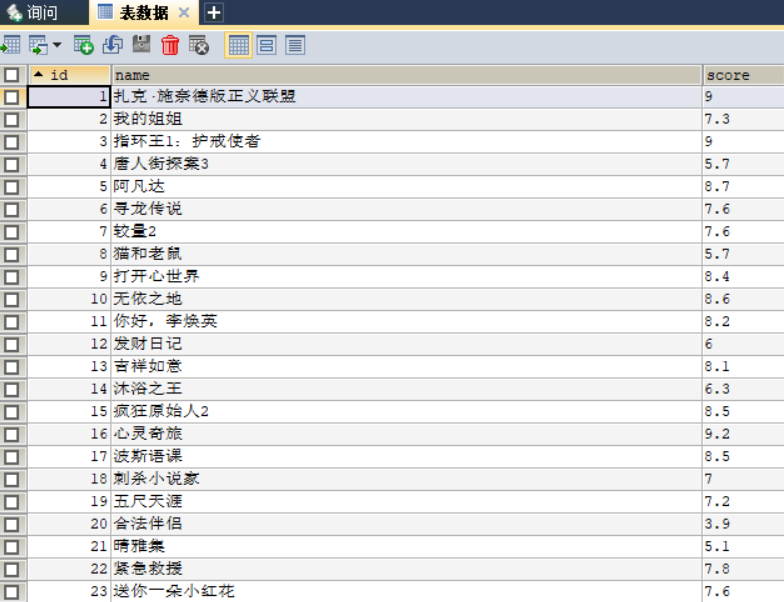

96 sql = "insert into movieimdb (id,name,score) values(%s,%s,%s)"

97 for item in list:

98 try:

99 print(item)

100 cursor.execute(sql, [0, item[0], item[1]])

101 except pymysql.err.IntegrityError:

102 print("重复!跳过!")

103 conn.commit() # 提交事务 update delete insert操作

104 print(f"{time.asctime()}插入imdb数据完毕")

105 finally:

106 close_conn(conn, cursor)

107 return;

108 # def get_dblen():

109 # conn,cursor=

110 # num_=

111

112 if __name__ == '__main__':

113 # get_imdb()

114 insert_imdb()

数据库

Python爬取imdb电影数据并存储到mysql数据库的更多相关文章

- Python爬取招聘信息,并且存储到MySQL数据库中

前面一篇文章主要讲述,如何通过Python爬取招聘信息,且爬取的日期为前一天的,同时将爬取的内容保存到数据库中:这篇文章主要讲述如何将python文件压缩成exe可执行文件,供后面的操作. 这系列文章 ...

- 爬取豆瓣电影top250并存储到mysql数据库

import requests from lxml import etree import re import pymysql import time conn= pymysql.connect(ho ...

- node 爬虫 --- 将爬取到的数据,保存到 mysql 数据库中

步骤一:安装必要模块 (1)cheerio模块 ,一个类似jQuery的选择器模块,分析HTML利器. (2)request模块,让http请求变的更加简单 (3)mysql模块,node连接mysq ...

- 利用Python爬取豆瓣电影

目标:使用Python爬取豆瓣电影并保存MongoDB数据库中 我们先来看一下通过浏览器的方式来筛选某些特定的电影: 我们把URL来复制出来分析分析: https://movie.douban.com ...

- Python爬取豆瓣电影top

Python爬取豆瓣电影top250 下面以四种方法去解析数据,前面三种以插件库来解析,第四种以正则表达式去解析. xpath pyquery beaufifulsoup re 爬取信息:名称 评分 ...

- 利用Python爬取朋友圈数据,爬到你开始怀疑人生

人生最难的事是自我认知,用Python爬取朋友圈数据,让我们重新审视自己,审视我们周围的圈子. 文:朱元禄(@数据分析-jacky) 哲学的两大问题:1.我是谁?2.我们从哪里来? 本文 jacky试 ...

- python 爬取豆瓣电影评论,并进行词云展示

python 爬取豆瓣电影评论,并进行词云展示 本文旨在提供爬取豆瓣电影<我不是药神>评论和词云展示的代码样例 1.分析URL 2.爬取前10页评论 3.进行词云展示 1.分析URL 我不 ...

- python 爬取猫眼电影top100数据

最近有爬虫相关的需求,所以上B站找了个视频(链接在文末)看了一下,做了一个小程序出来,大体上没有修改,只是在最后的存储上,由txt换成了excel. 简要需求:爬虫爬取 猫眼电影TOP100榜单 数据 ...

- python爬取豆瓣电影信息数据

题外话+ 大家好啊,最近自己在做一个属于自己的博客网站(准备辞职回家养老了,明年再战)在家里 琐事也很多, 加上自己 一回到家就懒了(主要是家里冷啊! 广东十几度,老家几度,躲在被窝瑟瑟发抖,) 由于 ...

- python爬虫-爬取豆瓣电影数据

#!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:27# 文件 :spider_05.py# IDE :PyChar ...

随机推荐

- SpringBoot下Akka的简单使用

SpringBoot下Akka的简单使用 Akka框架实现一个异步消息传输,通过定义演员来处理业务逻辑. 首先引入依赖 <!-- akka --> <dependency> & ...

- docker启动nginx https自签名证书配置

启动测试应用时, 有时需要自己配置证书签名: 1 使用系统自带openssl openssl req \ > -x509 \ > -nodes \ > -days 365 \ > ...

- Docker实践之06-访问仓库

目录 什么是仓库 一.Docker Hub 注册 登录 拉取镜像 推送镜像 自动创建 二.私有仓库 Docker Registry 安装Docker Registry 在私有仓库上传/搜索/下载镜像 ...

- Flask遇到的坑及解决办法

flask_script 在使用第三方包flask_script时,报一下错误 ModuleNotFoundError: No module named 'flask._compat' 问题时flas ...

- Vue3学习(二十)- 富文本插件wangeditor的使用

写在前面 学习.写作.工作.生活,都跟心情有很大关系,甚至有时候我更喜欢一个人独处,戴上耳机coding的感觉. 明显现在的心情,比中午和上午好多了,心情超棒的,靠自己解决了两个问题: 新增的时候点击 ...

- Jenkins配置SpringBoot项目启动脚本

目录 背景 脚本编写 变量说明 使用说明 Q&A jenkins部署时错误 背景 上一篇Jenkins配置介绍了Jenkins远程部署的相关配置和步骤,但是最后的部署脚本只适用于部署原始tom ...

- 【Azure Logic App】消费型逻辑应用在消费Service Bus时遇见消息并发速度慢,消息积压

问题描述 消费型逻辑应用(Consumption Logic App)使用触发器模式消费 Azure Service Bus的消息,当Service Bus中存在大量消息等待消费时,Logic App ...

- 【Azure Developer】Python 读取 json文件及过滤出需要的结果

问题描述 首先,有名为 campsites.json 的JSON数据文件,数据格式为 { "type": "FeatureCollection", " ...

- Zabbix“专家坐诊”第185期问答汇总

问题一 Q:Zabbix5.0版本,如图,请问这里怎么修改回localhost? A:找到文件conf/zabbix.conf.php,改下图这个位置 问题二 Q:大家好,我有个疑问请教下,zabbi ...

- arch安装xfce4的时候,出现无法设置开机启动的问题

sudo systemctl enable lightdm Failed to enable unit: File /etc/systemd/system/display-manager.serv ...