吴裕雄 python 爬虫(2)

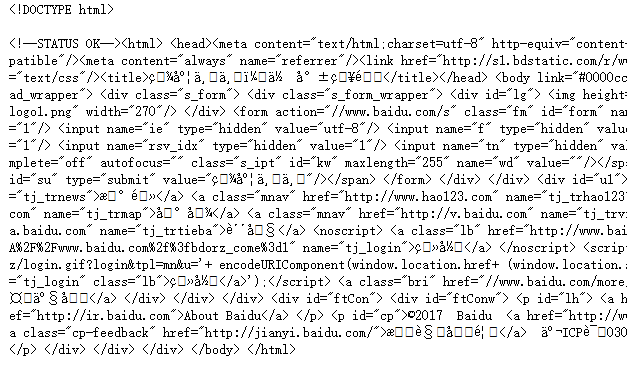

import requests from bs4 import BeautifulSoup url = 'http://www.baidu.com'

html = requests.get(url)

sp = BeautifulSoup(html.text, 'html.parser')

print(sp)

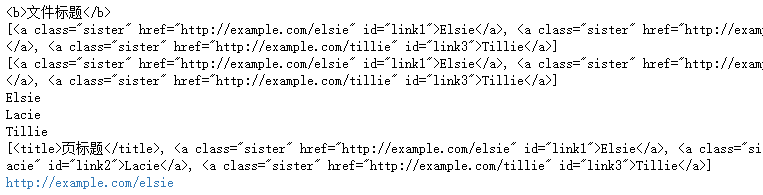

html_doc = """

<html><head><title>页标题</title></head> <p class="title"><b>文件标题</b></p> <p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p> <p class="story">...</p>

""" from bs4 import BeautifulSoup sp = BeautifulSoup(html_doc,'html.parser') print(sp.find('b')) # 返回值:<b>文件标题</b> print(sp.find_all('a')) #返回值: [<b>文件标题</b>] print(sp.find_all("a", {"class":"sister"})) data1=sp.find("a", {"href":"http://example.com/elsie"})

print(data1.text) # 返回值:Elsie data2=sp.find("a", {"id":"link2"})

print(data2.text) # 返回值:Lacie data3 = sp.select("#link3")

print(data3[0].text) # 返回值:Tillie print(sp.find_all(['title','a'])) data1=sp.find("a", {"id":"link1"})

print(data1.get("href")) #返回值: http://example.com/elsie

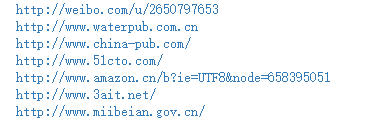

import requests from bs4 import BeautifulSoup url = 'http://www.wsbookshow.com/'

html = requests.get(url)

html.encoding="gbk" sp=BeautifulSoup(html.text,"html.parser")

links=sp.find_all(["a","img"]) # 同时读取 <a> 和 <img>

for link in links:

href=link.get("href") # 读取 href 属性的值

# 判断值是否为非 None,以及是不是以http://开头

if((href != None) and (href.startswith("http://"))):

print(href)

import requests from bs4 import BeautifulSoup url = 'http://www.taiwanlottery.com.tw/'

html = requests.get(url)

sp = BeautifulSoup(html.text, 'html.parser') data1 = sp.select("#rightdown")

print(data1)

data2 = data1[0].find('div', {'class':'contents_box02'})

print(data2)

print()

data3 = data2.find_all('div', {'class':'ball_tx'})

print(data3)

import requests

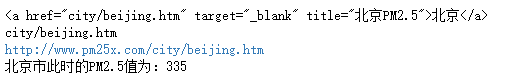

from bs4 import BeautifulSoup url1 = 'http://www.pm25x.com/' #获得主页面链接

html = requests.get(url1) #抓取主页面数据

sp1 = BeautifulSoup(html.text, 'html.parser') #把抓取的数据进行解析 city = sp1.find("a",{"title":"北京PM2.5"}) #从解析结果中找出title属性值为"北京PM2.5"的标签

print(city)

citylink=city.get("href") #从找到的标签中取href属性值

print(citylink)

url2=url1+citylink #生成二级页面完整的链接地址

print(url2) html2=requests.get(url2) #抓取二级页面数据

sp2=BeautifulSoup(html2.text,"html.parser") #二级页面数据解析

#print(sp2)

data1=sp2.select(".aqivalue") #通过类名aqivalue抓取包含北京市pm2.5数值的标签

pm25=data1[0].text #获取标签中的pm2.5数据

print("北京市此时的PM2.5值为:"+pm25) #显示pm2.5值

import requests,os

from bs4 import BeautifulSoup

from urllib.request import urlopen url = 'http://www.tooopen.com/img/87.aspx' html = requests.get(url)

html.encoding="utf-8" sp = BeautifulSoup(html.text, 'html.parser') # 建立images目录保存图片

images_dir="E:\\images\\"

if not os.path.exists(images_dir):

os.mkdir(images_dir) # 取得所有 <a> 和 <img> 标签

all_links=sp.find_all(['a','img'])

for link in all_links:

# 读取 src 和 href 属性内容

src=link.get('src')

href = link.get('href')

attrs=[src,src]

for attr in attrs:

# 读取 .jpg 和 .png 檔

if attr != None and ('.jpg' in attr or '.png' in attr):

# 设置图片文件完整路径

full_path = attr

filename = full_path.split('/')[-1] # 取得图片名

ext = filename.split('.')[-1] #取得扩展名

filename = filename.split('.')[-2] #取得主文件名

if 'jpg' in ext: filename = filename + '.jpg'

else: filename = filename + '.png'

print(attr)

# 保存图片

try:

image = urlopen(full_path)

f = open(os.path.join(images_dir,filename),'wb')

f.write(image.read())

f.close()

except:

print("{} 无法读取!".format(filename))

吴裕雄 python 爬虫(2)的更多相关文章

- 吴裕雄 python 爬虫(4)

import requests user_agent = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)AppleWebKit/537.36 (KHTML, li ...

- 吴裕雄 python 爬虫(3)

import hashlib md5 = hashlib.md5() md5.update(b'Test String') print(md5.hexdigest()) import hashlib ...

- 吴裕雄 python 爬虫(1)

from urllib.parse import urlparse url = 'http://www.pm25x.com/city/beijing.htm' o = urlparse(url) pr ...

- 吴裕雄--python学习笔记:爬虫基础

一.什么是爬虫 爬虫:一段自动抓取互联网信息的程序,从互联网上抓取对于我们有价值的信息. 二.Python爬虫架构 Python 爬虫架构主要由五个部分组成,分别是调度器.URL管理器.网页下载器.网 ...

- 吴裕雄--python学习笔记:爬虫包的更换

python 3.x报错:No module named 'cookielib'或No module named 'urllib2' 1. ModuleNotFoundError: No module ...

- 吴裕雄--python学习笔记:爬虫

import chardet import urllib.request page = urllib.request.urlopen('http://photo.sina.com.cn/') #打开网 ...

- 吴裕雄 python 神经网络——TensorFlow pb文件保存方法

import tensorflow as tf from tensorflow.python.framework import graph_util v1 = tf.Variable(tf.const ...

- 吴裕雄 python 神经网络——TensorFlow 花瓣分类与迁移学习(4)

# -*- coding: utf-8 -*- import glob import os.path import numpy as np import tensorflow as tf from t ...

- 吴裕雄 python 神经网络——TensorFlow 花瓣分类与迁移学习(3)

import glob import os.path import numpy as np import tensorflow as tf from tensorflow.python.platfor ...

随机推荐

- C#常用类操作

C#提供了许多可以直接使用的类代码. 1. Convert类 Convert类提供了很多静态方法成员,用于实现数据类型的转换. Convert类的常用方法 ...

- Solr高效利用:Solr实现SQL的查询与统计

1.如何高效使用Solr查询功能 ?2.单个字段分组统计如何实现? 3.IN条件查询有几种方式? 4.多个字段分组统计是否只支持count? Cloudera公司已经推出了基于Hadoop平台的查询统 ...

- 安全测试1_Web知识简介

接下去所有的安全测试都是本人学习安全测试的过程,随笔中会截取云课堂视频中的图片(比较生动和形象,便于理解),主要目的是方便自己以后复习和巩固! 1.Web发展阶段概述: 2.web安全我能提发展形势: ...

- hadoop2.4的伪集群的搭建

1.准备Linux环境 1.0先将虚拟机的网络模式选为NAT 1.1修改主机名 vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=itcast ### ...

- uiautomator 代码记录 :BT接收测试

package rom; import java.lang.*; import java.util.Random; import java.io.File; import com.android.ui ...

- win7 CMD登录本机MySQL数据库管理

- 【Social Listening实战】当数据分析遭遇心理动力学:用户深层次的情感需求浮出水面

本文转自知乎 作者:苏格兰折耳喵 ----------------------------------------------------- 本文篇幅较长,分为五部分,在中间部分有关于心理分析工具的介 ...

- 16.纯 CSS 创作一个渐变色动画边框

原文地址:https://segmentfault.com/a/1190000014785816 感想:边框是伪元素::after来的: HTML代码: <div class="box ...

- Google maps javascript API

https://developers.google.com/maps/documentation/javascript/datalayer .... GeoJSON 是一种针对互联网上共享地理空间数据 ...

- git 简单的操作命令

1, 克隆已存在项目 => git clone url 2, 拉取代码 => git pull 3, 配置账号密码 git config --global user.email &quo ...