25.Spark下载源码和安装和使用

安装scala

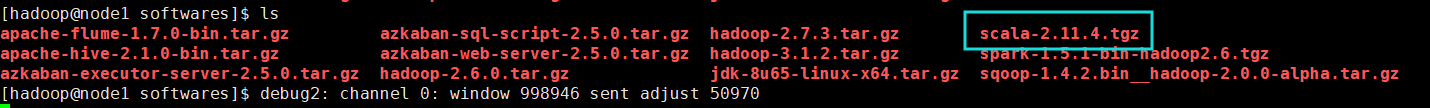

上传安装包

解压

配置scala相关的环境变量

export SCALA_HOME=/opt/modules/scala-2.11.4

export PATH=$PATH:$SCALA_HOME/bin

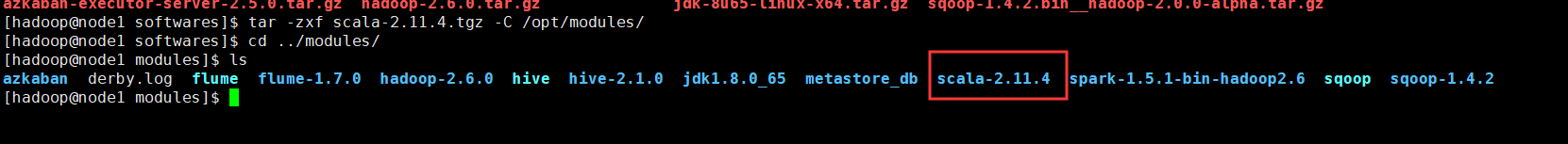

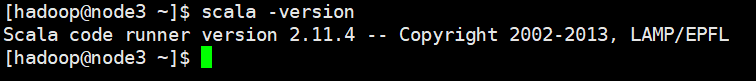

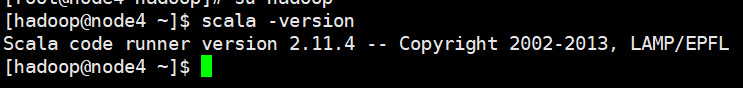

验证scala安装是否成功

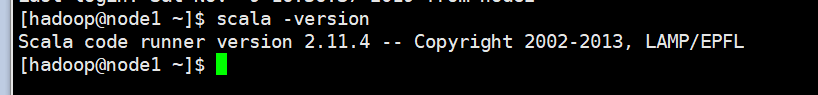

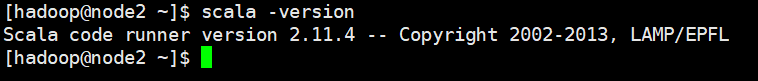

把scala分发给node2 node3 node4

scp -r scala-2.11./ hadoop@node2:/opt/modules/ scp -r scala-2.11./ hadoop@node3:/opt/modules/ scp -r scala-2.11./ hadoop@node4:/opt/modules/

分别给node2 node3 node4配置scala的环境变量,并使其生效

#scala

export SCALA_HOME=/opt/modules/scala-2.11.

export PATH=$PATH:$SCALA_HOME/bin

spark安装包下载地址:https://archive.apache.org/dist/spark/spark-1.5.1/

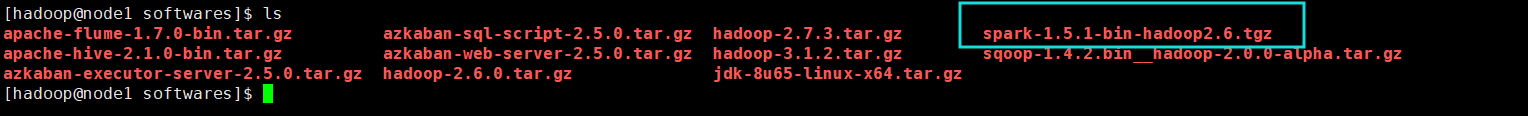

上传安装包导集群

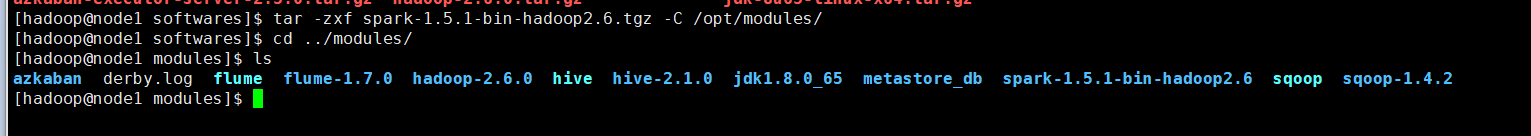

解压安装包

配置spark的环境变量

#spark

export SPARK_HOME=/opt/modules/spark-1.5.-bin-hadoop2.

export PATH=$PATH:$SPARK_HOME/bin

export CLASSPATH=.:$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib

使环境变量生效

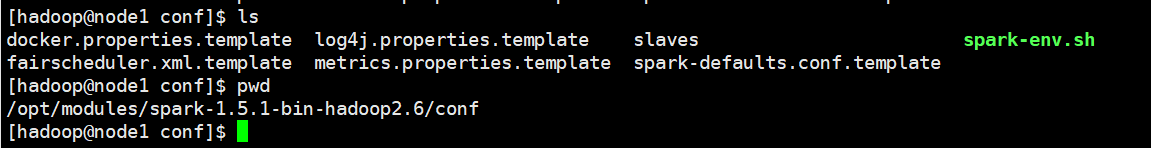

修改spark配置文件

修改spark-env.sh文件

vim spark-env.sh文件

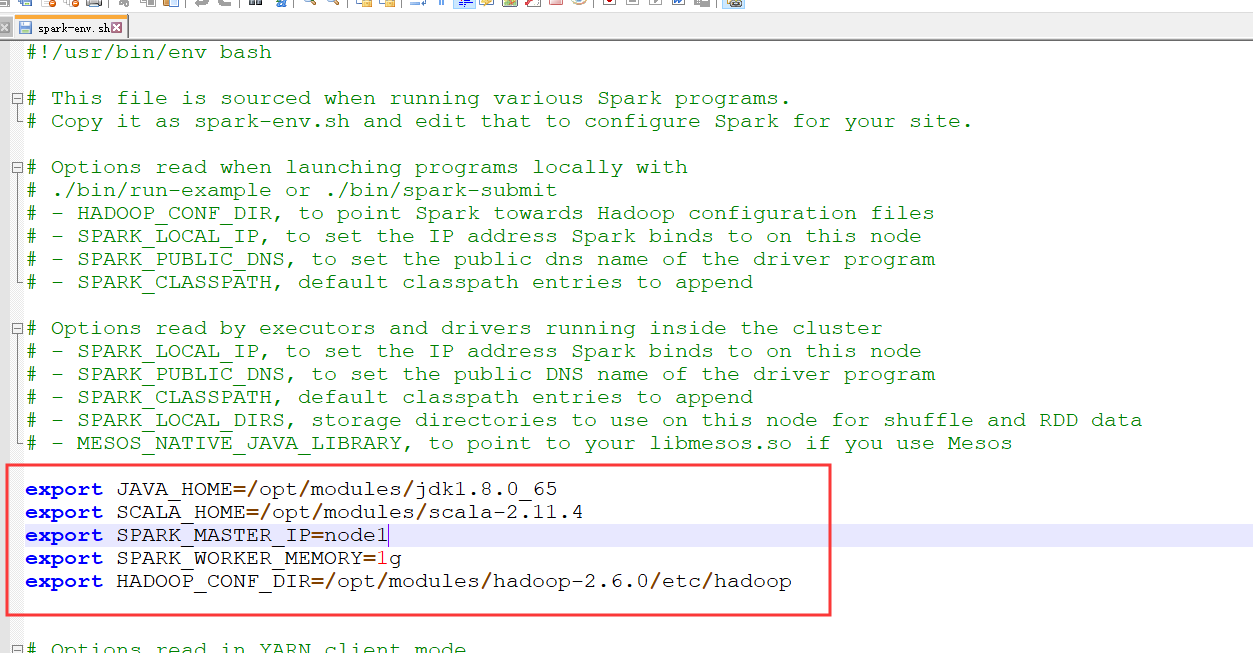

添加以下语句

export JAVA_HOME=/opt/modules/jdk1..0_65

export SCALA_HOME=/opt/modules/scala-2.11.

export SPARK_MASTER_IP=node1

export SPARK_WORKER_MEMORY=1g

export HADOOP_CONF_DIR=/opt/modules/hadoop-2.6./etc/hadoop

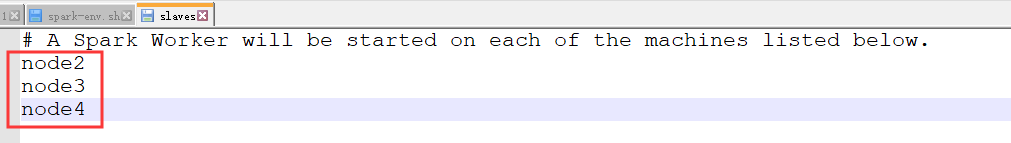

修改slaves文件

vim slaves

将spark安装包分发给node2 node3 node4

scp -r spark-1.5.-bin-hadoop2./ hadoop@node2:/opt/modules/ scp -r spark-1.5.-bin-hadoop2./ hadoop@node3:/opt/modules/ scp -r spark-1.5.-bin-hadoop2./ hadoop@node4:/opt/modules/

再给node2 node3 node4配置spark的环境变量

#spark

export SPARK_HOME=/opt/modules/spark-1.5.-bin-hadoop2.

export PATH=$PATH:$SPARK_HOME/bin

export CLASSPATH=.:$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib

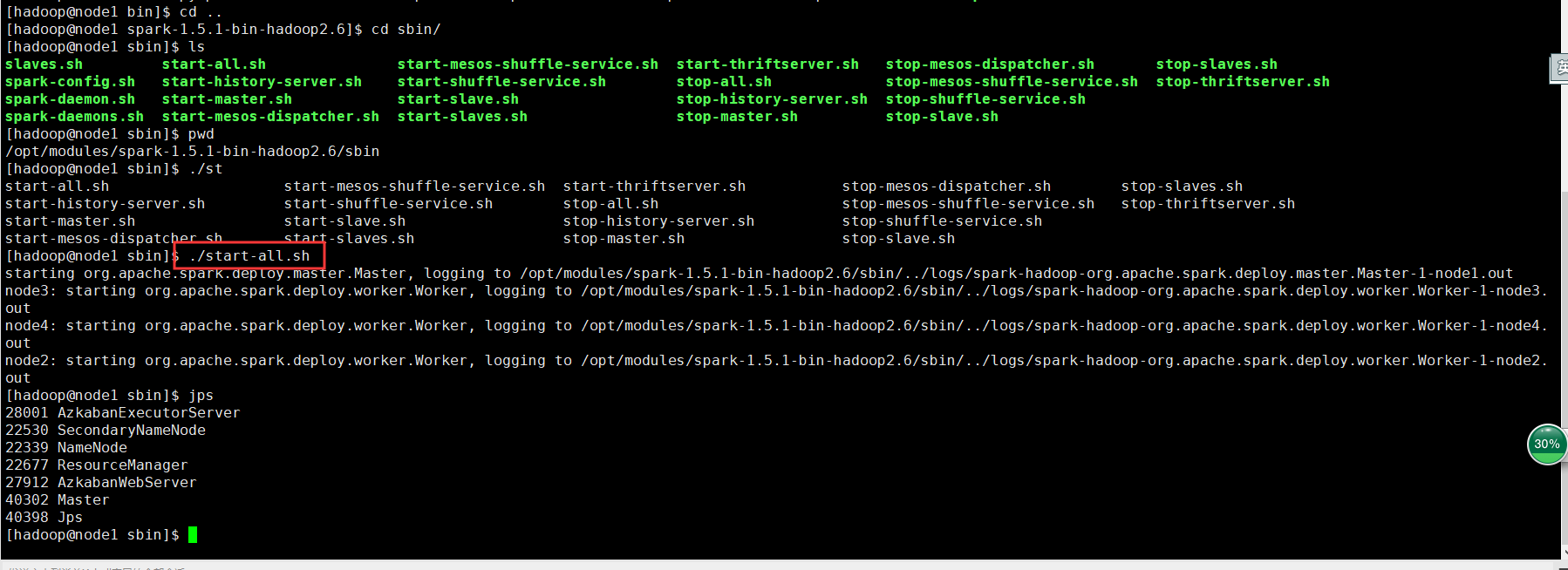

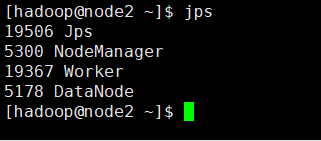

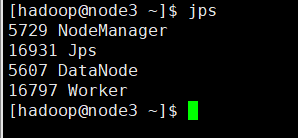

在spark目录下的sbin目录执行./start-all.sh

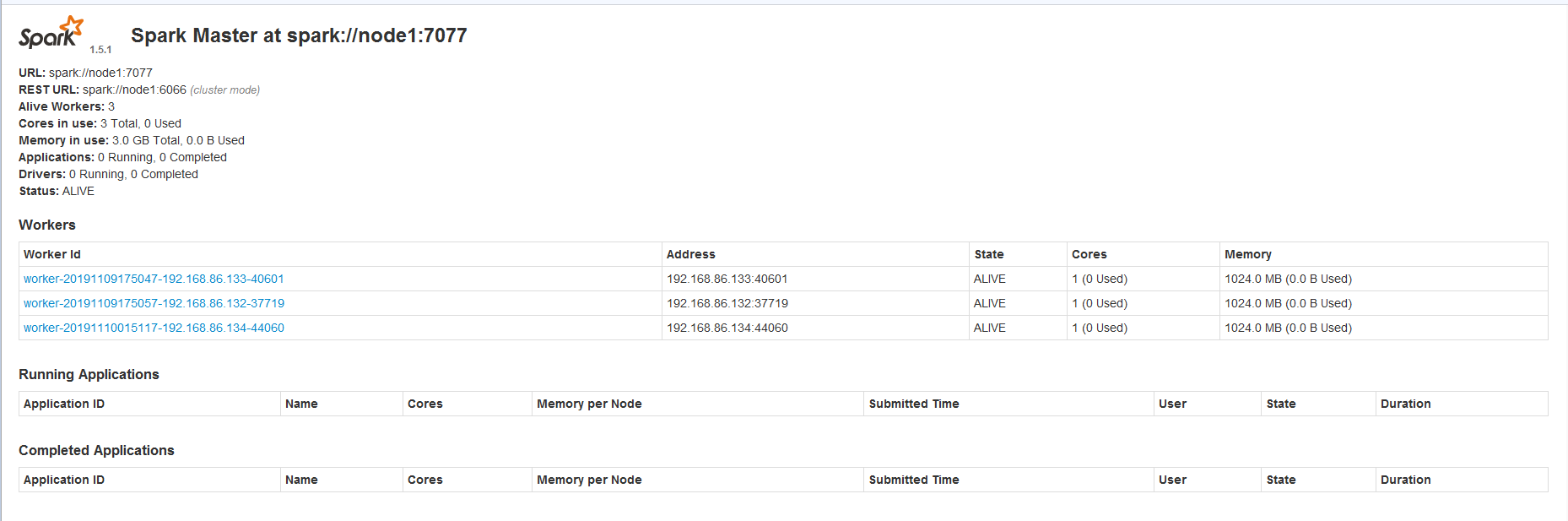

在浏览器打开地址http://node1:8080/

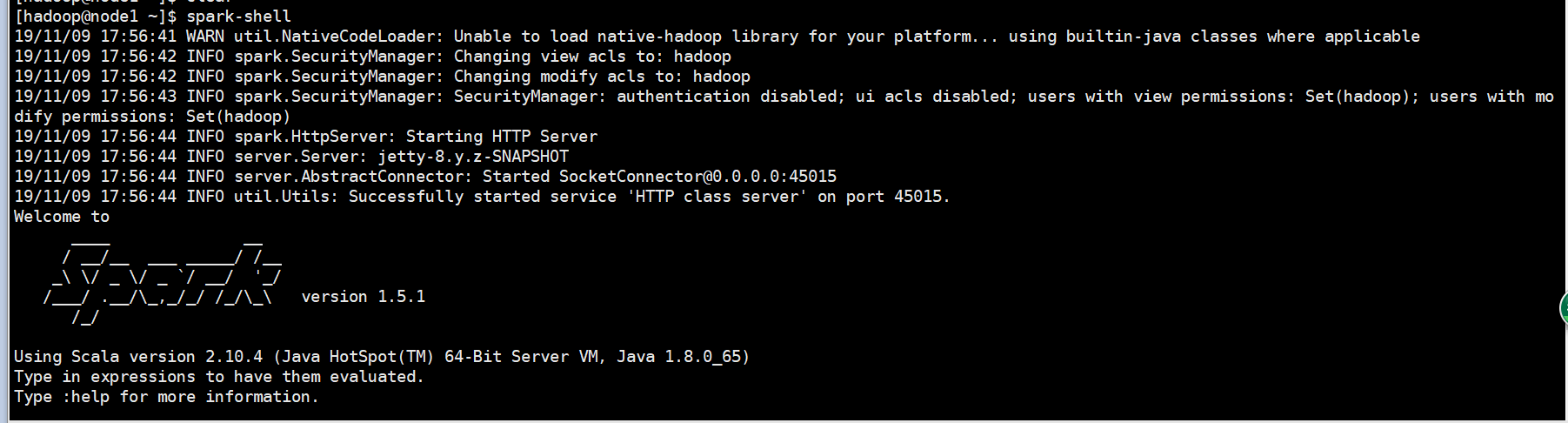

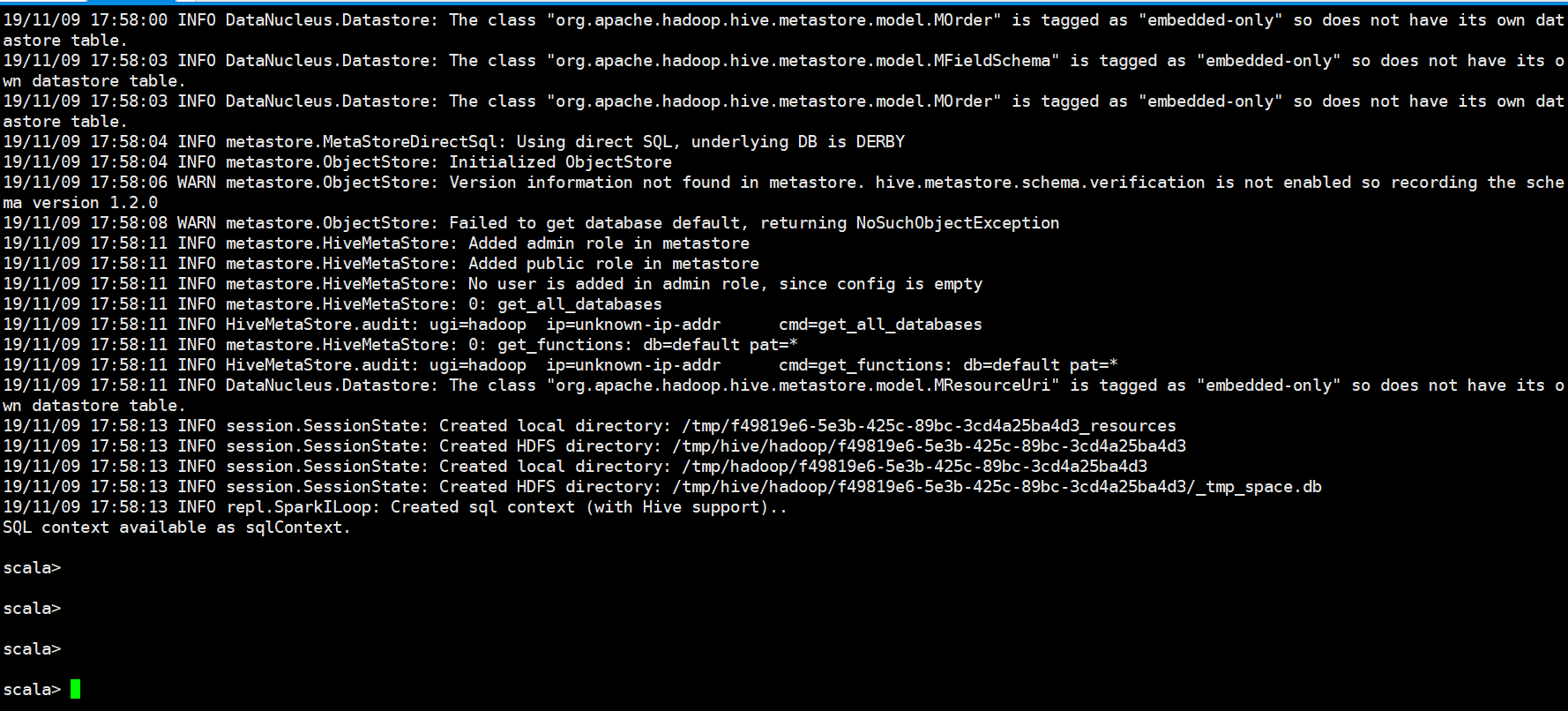

启动spark-shell

启动成功!!!!

25.Spark下载源码和安装和使用的更多相关文章

- yum换源,rpm包下载,源码包安装

一.yum更换源 yum自带源地址一般斗是国外的,可能下载速度略慢,我们可以自己换成国内的源,比如163等.比如配置163的yum源:1.先删除默认源文件dvd.repo # rm -f /etc/y ...

- ubuntu下载源码clang + llvm+lldb 编译+安装

[本文可能涉及到Ubuntu安装以下工具:] A.g++ B.gcc C.make D.cmake E.clang(10.0.1)(必须) F.llvm(10.0.1)(必须) G.lldb(10.0 ...

- Linux系列(38) - 源码包安装(2)

安装前准备 安装C语言编译器"gcc" yum -y install gcc --c 源码包语言编译器 下载源码包 安装注意事项 源代码保存位置:/usr/local/src/ 软 ...

- spark最新源码下载并导入到开发环境下助推高质量代码(Scala IDEA for Eclipse和IntelliJ IDEA皆适用)(以spark2.2.0源码包为例)(图文详解)

不多说,直接上干货! 前言 其实啊,无论你是初学者还是具备了有一定spark编程经验,都需要对spark源码足够重视起来. 本人,肺腑之己见,想要成为大数据的大牛和顶尖专家,多结合源码和操练编程. ...

- yum更换国内源 yum下载rpm包 源码包安装

7.6 yum更换国内源 7.7 yum下载rpm包 7.8/7.9 源码包安装 yum更换国内源 cd /etc/yum.repo.d/ 删除源 rm -f dvd.repo rm -f C ...

- yum更换国内源、yum下载rpm包、源码包安装 使用介绍

第5周第4次课(4月19日) 课程内容: 7.6 yum更换国内源7.7 yum下载rpm包7.8/7.9 源码包安装 7.6 yum更换国内源 当yum仓库的软件不好用时,例如很多yum源都是国外的 ...

- Linux centosVMware yum更换国内仓库源、yum下载rpm包、源码包安装

一.yum更换国内仓库源 cd /etc/yum.repos.d/ rm -f dvd.repo wget http://mirrors.163.com/.help/CentOS7-Base-163. ...

- 总结源码编译安装mysql

最近在学习源码编译安装LAMP.LNMP时,一直遇到一个难题,就是就是mysql无论怎么源码编译安装,到最后启动服务都提示"Starting MySQL.The server quit wi ...

- (升级版)Spark从入门到精通(Scala编程、案例实战、高级特性、Spark内核源码剖析、Hadoop高端)

本课程主要讲解目前大数据领域最热门.最火爆.最有前景的技术——Spark.在本课程中,会从浅入深,基于大量案例实战,深度剖析和讲解Spark,并且会包含完全从企业真实复杂业务需求中抽取出的案例实战.课 ...

随机推荐

- jsp 页面 javax.servlet.jsp.JspException cannot be resolved to a type 异常

<dependencies><dependency><groupId>javax.servlet</groupId><artifactId> ...

- commit 没有提交图片,但是出现了commit的修改

.gitignore里面写上 image/cache/ 就好了

- GitHub发卡系统zfaka配置历程

GitHub发卡系统zfaka配置历程 1项目介绍 ZFAKA发卡系统(本系统基于yaf+layui开发) 项目地址 https://github.com/zlkbdotnet/zfaka 我 ...

- 总结js常用的dom操作(js的dom操作API)

转载:https://www.haorooms.com/post/js_dom_api 前言 很多同学用惯了jquery操作dom,让他们用js操作的时候,常常力不从心,本文总结了常用的js的dom操 ...

- 服务器(Linux)上运行python总结

跑实验换了几次服务器了,每次遇到相似问题都要重新百度,而且每次百度搜索出的顺序都不一样,又得重新找半天,这次把遇到的问题都总结一下. 1.准备 PuTTY和FileZilla FileZilla使用F ...

- 个微信小程序云开发云函数

1. project.config.json写上云函数所在目录"cloudfunctionRoot": "cloudfunctions/",如图 2. app. ...

- ajax 提交 form表单 ,后台执行两次的问题

网上大多的答案是说同步不同步的问题,但是我把异步改成同步也不行.async: false, // 单击时表单检查 $('.btn-next a').click(function () { if ...

- python -- 安装+pip+requests

python3 安装库 sudo python3 -m pip install beautifulsoup4 步骤1:安装pyenv 为了能顺利的将系统的python和下载的python版本呼唤, ...

- Angular 中的 dom 操作(ViewChild)以及父子组件中通过 ViewChild 调用子组件的方法

<app-header #header></app-header> <div #myBox> 我是一个dom节点 </div> <button ( ...

- Javescript——变量声明的区别

原文链接:ES6 Syntax and Feature Overview View on GitHub Keyword Scope Hoisting Can Be Reassigned Can Be ...