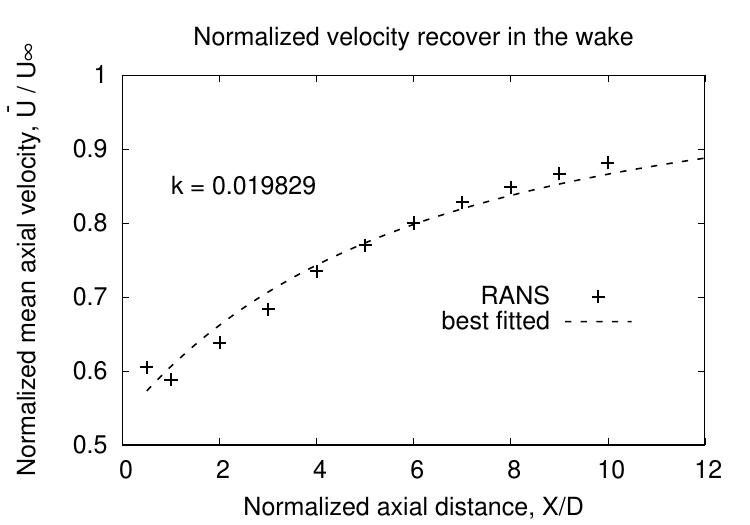

k fit in Park Model

software: Gnuplot

input: area_averaged_axial_mean_velocity_TI_1.txt

# One Rotor, front, eldad blade

# TSR , TI =%

#X/D X half width, Ux U Ux/U

0.5 0.23 0.275 0.363 0.6 0.605

0.46 0.93 0.353 0.6 0.588333333

0.92 0.316 0.383 0.6 0.638333333

1.38 0.334 0.41 0.6 0.683333333

1.84 0.349 0.441 0.6 0.735

2.3 0.365 0.462 0.6 0.77

2.76 0.379 0.48 0.6 0.8

3.22 0.39 0.497 0.6 0.828333333

3.68 0.405 0.509 0.6 0.848333333

4.14 0.42 0.52 0.6 0.866666667

4.6 0.431 0.529 0.6 0.881666667

gnuplot code

a = 0.6*(1-sqrt(1-0.7133))

d=0.46

f(x) = (0.6-a*d*d/((d+2*k*x)*(d+2*k*x)))/0.6

fit f(x) 'area_averaged_axial_mean_velocity_TI_1.txt' using 1:6 via k

# plotting

set terminal postscript eps font 24

set out 'k_fit_ti_1_tsr5.eps'

set autoscale

unset log

unset label

unset pm3d

set xtic auto

set ytic auto

unset grid

# set title 'Normalized velocity recover in the wake'

set xlabel "Normalized axial distance, X/D"

set xrange [*:12]

# r0 initial pulse

set yrange [0.5:1]

set ylabel "Normalized mean axial velocity, ~U{0.8-} / U{/Symbol \245}"

set style line 1 lt 1 lc rgb "black" lw 4 pt 1 ps 2

set style line 2 lt 2 lc rgb "black" lw 4 pt 3 ps 2

set style line 3 lt 3 lc rgb "black" lw 4 pt 5 ps 2

set style line 4 lt 4 lc rgb "black" lw 4 pt 7 ps 2

set style line 5 lt 5 lc rgb "black" lw 4

set style line 6 lt 6 lc rgb "brown" lw 4

k_value = sprintf("k = %.3f", k)

set label 1 at 1, 0.85 k_value

set key at graph 0.9, 0.3

set key spacing 1

plot 'area_averaged_axial_mean_velocity_TI_1.txt' using 1:6 ls 1 with points title 'RANS', f(x) lw 3 title "best fitted"

output:

k fit in Park Model的更多相关文章

- Python的主成分分析PCA算法

这篇文章很不错:https://blog.csdn.net/u013082989/article/details/53792010 为什么数据处理之前要进行归一化???(这个一直不明白) 这个也很不错 ...

- The Model Complexity Myth

The Model Complexity Myth (or, Yes You Can Fit Models With More Parameters Than Data Points) An oft- ...

- 高斯混合模型Gaussian Mixture Model (GMM)——通过增加 Model 的个数,我们可以任意地逼近任何连续的概率密分布

从几何上讲,单高斯分布模型在二维空间应该近似于椭圆,在三维空间上近似于椭球.遗憾的是在很多分类问题中,属于同一类别的样本点并不满足“椭圆”分布的特性.这就引入了高斯混合模型.——可以认为是基本假设! ...

- k近邻聚类简介

简介 在所有机器学习算法中,k近邻(K-Nearest Neighbors,KNN)相对是比较简单的. 尽管它很简单,但事实证明它在某些任务中非常有效,甚至更好.它可以用于分类和回归问题! 然而,它更 ...

- 4.K均值算法应用

一.课堂练习 from sklearn.cluster import KMeans import matplotlib.pyplot as plt import numpy as np from sk ...

- Scikit-learn:模型评估Model evaluation

http://blog.csdn.net/pipisorry/article/details/52250760 模型评估Model evaluation: quantifying the qualit ...

- 最大似然估计实例 | Fitting a Model by Maximum Likelihood (MLE)

参考:Fitting a Model by Maximum Likelihood 最大似然估计是用于估计模型参数的,首先我们必须选定一个模型,然后比对有给定的数据集,然后构建一个联合概率函数,因为给定 ...

- Coxph model Pvalue Select

I am calculating cox propotional hazards models with the coxph function from the survival package. ...

- 1.K近邻算法

(一)K近邻算法基础 K近邻(KNN)算法优点 思想极度简单 应用数学知识少(近乎为0) 效果好 可以解释机器学习算法使用过程中的很多细节问题 更完整的刻画机器学习应用的流程 图解K近邻算法 上图是以 ...

随机推荐

- 普通app自动化测试与手游app自动化测试的区别

[转载] 手游自动化测试与App自动化测试技术上的区别 手游和App的开发技术不同,导致了两者的自动化测试技术完全不同.一般来说,安卓应用是使用Android SDK开发的,利用Java编写.那么在A ...

- Appium安装说明

1.安装Appium前,需要先安装node.js .node.js官方网站:https://nodejs.org/, 这里我以Windows 10为例进行安装,选择Windows installer( ...

- AtCoder Grand Contest 016 E - Poor Turkeys

题目传送门:https://agc016.contest.atcoder.jp/tasks/agc016_e 题目大意: 有\(N\)只火鸡,现有\(M\)个人,每个人指定了两只火鸡\(x,y\),每 ...

- (好题)树状数组+离散化+DFS序+离线/莫队 HDOJ 4358 Boring counting

题目传送门 题意:给你一棵树,树上的每个节点都有树值,给m个查询,问以每个点u为根的子树下有多少种权值恰好出现k次. 分析:首先要对权值离散化,然后要将树形转换为线形,配上图:.然后按照右端点从小到大 ...

- 二分搜索 Codeforces Round #299 (Div. 2) C. Tavas and Karafs

题目传送门 /* 题意:给定一个数列,求最大的r使得[l,r]的数字能在t次全变为0,每一次可以在m的长度内减1 二分搜索:搜索r,求出sum <= t * m的最大的r 详细解释:http:/ ...

- [转]C#综合揭秘——细说多线程(上)

引言 本文主要从线程的基础用法,CLR线程池当中工作者线程与I/O线程的开发,并行操作PLINQ等多个方面介绍多线程的开发. 其中委托的BeginInvoke方法以及回调函数最为常用. 而 I/O线程 ...

- android开发学习 ------- git - 将代码回滚到任意版本

不小心将一个东西错误提交到git - 远程仓库上 参考 https://www.cnblogs.com/wancy86/p/5848024.html 你的git可能关联了多个远程仓库,每个关联的代码 ...

- javascript 找出数字数组中最大的数

找出数字数组中最大的数 var Match = (function(){ var arr = null; var len = 0; return { max:function(arr,len){ ar ...

- 前端之HTML语法及常用标签

html语法: 1.常规标记: <标记 属性=“属性值” 属性=“属性值”></标记>: 2.空标记: <标记 属性=“属性值” 属性=“属性值”/> 注意事项: ...

- CF750D New Year and Fireworks

题意: 放烟花. 一个烟花从某一起点开始,沿着当前方向移动指定数量的格子之后爆炸分成两部分,分别沿着当前方向的左上和右上方向移动.而每一部分再沿着当前方向移动指定数量的格子之后爆炸分成两部分.如此递归 ...