【Python】【爬虫】【爬狼】004_正则规则模板及其应用

# 正则规则模板 与 应用(一)

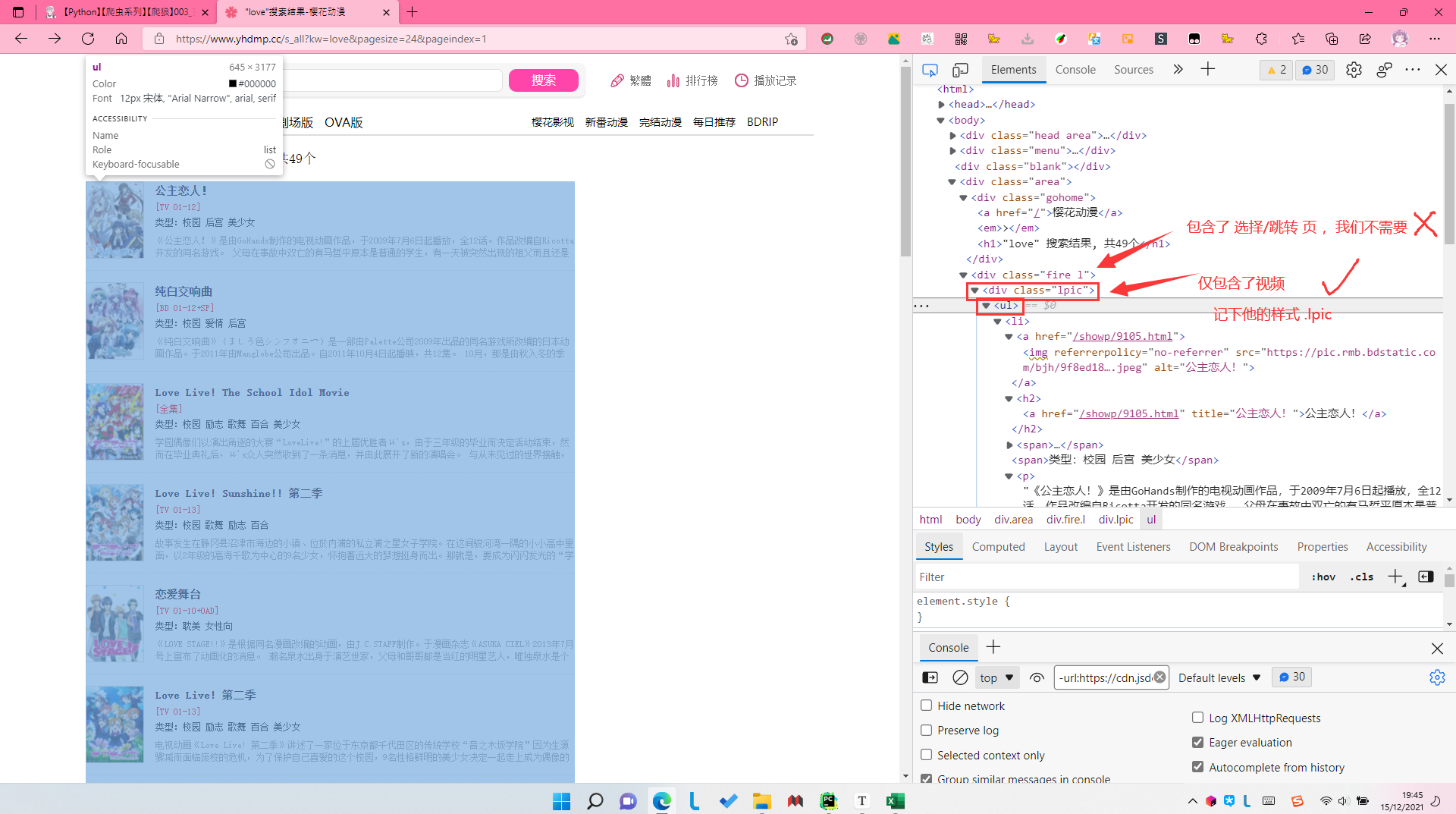

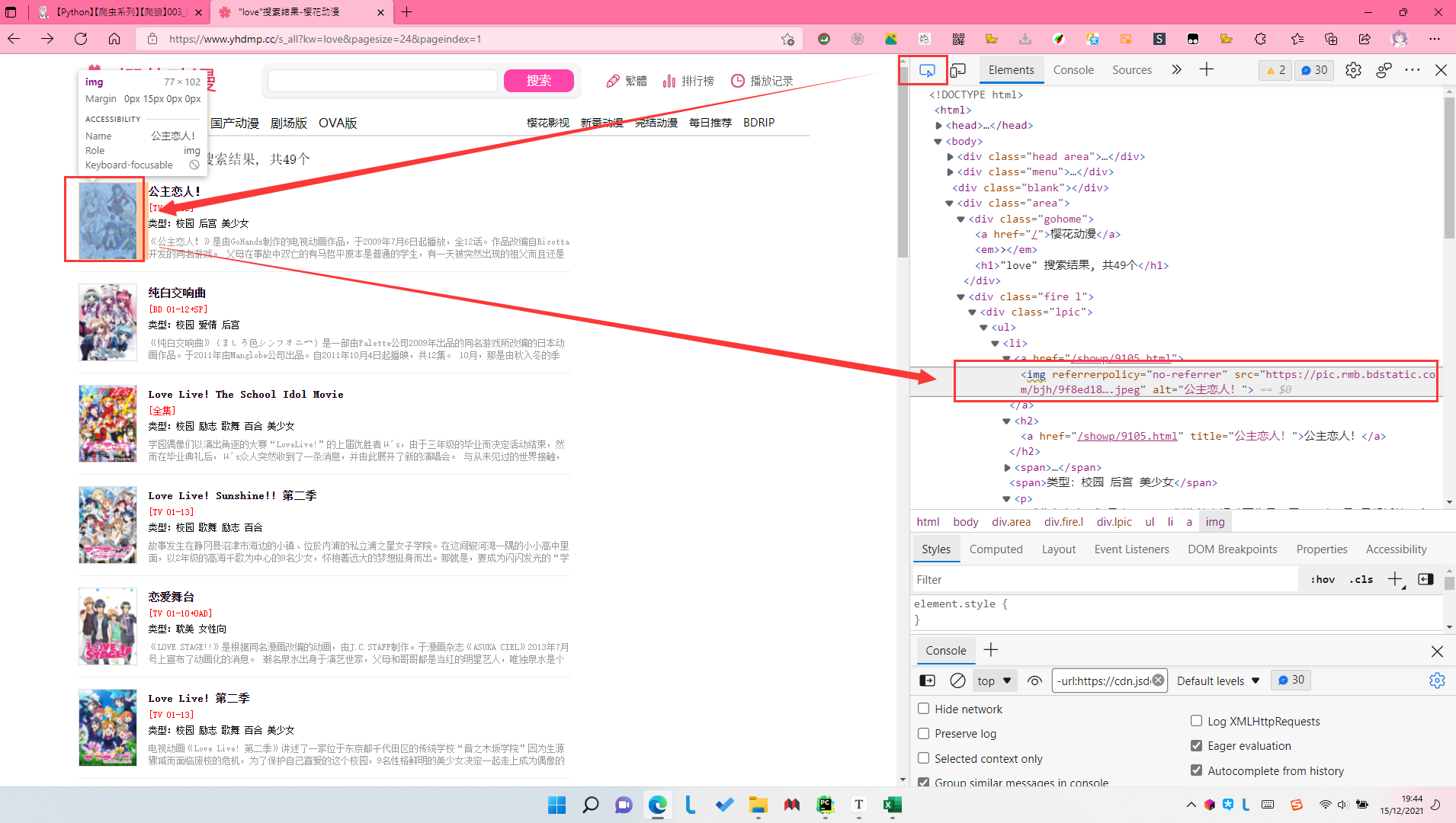

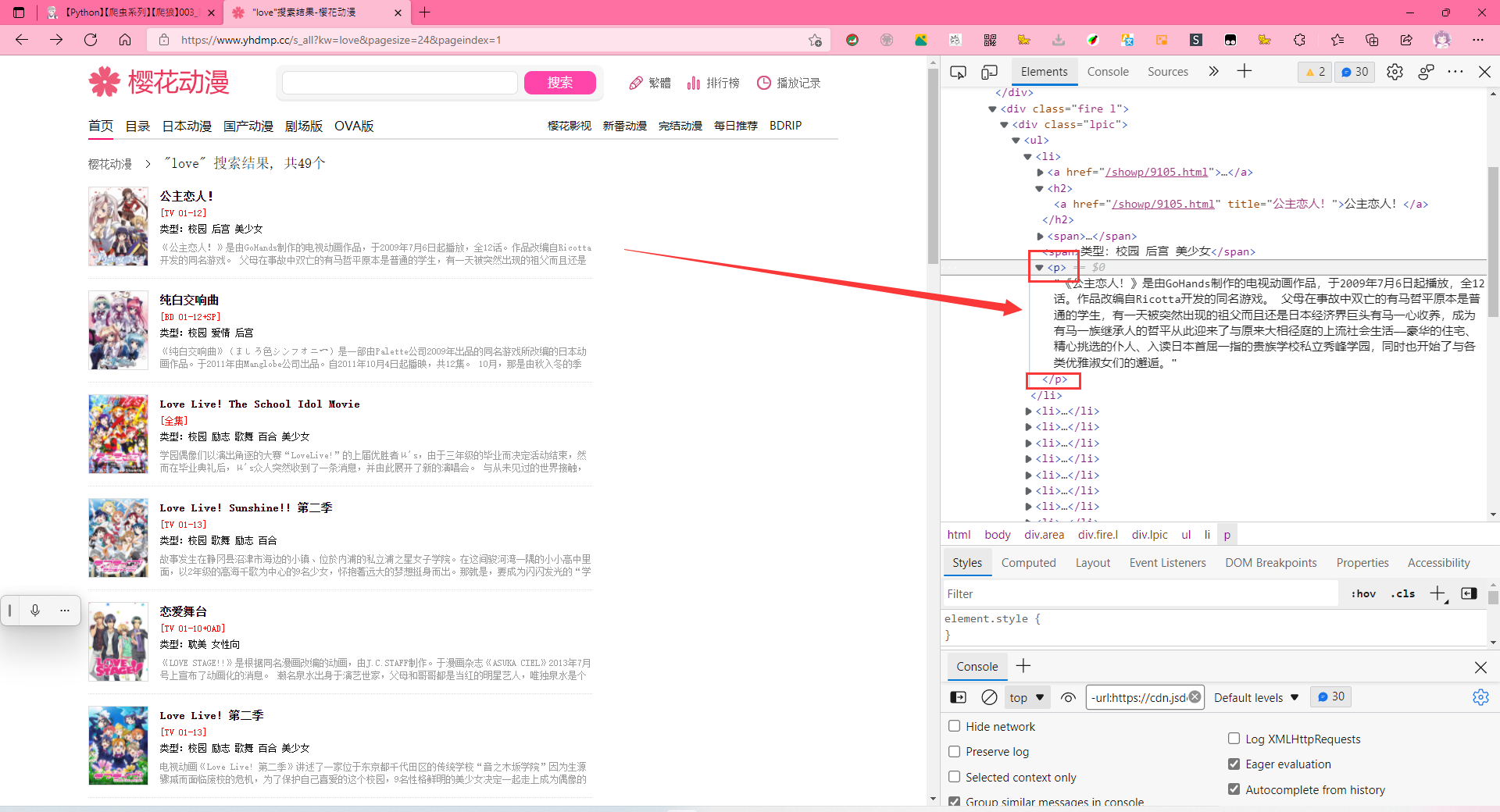

先看这些视频,是在哪个div里面的

for datapage in soup.find_all("div", class_="lpic"):

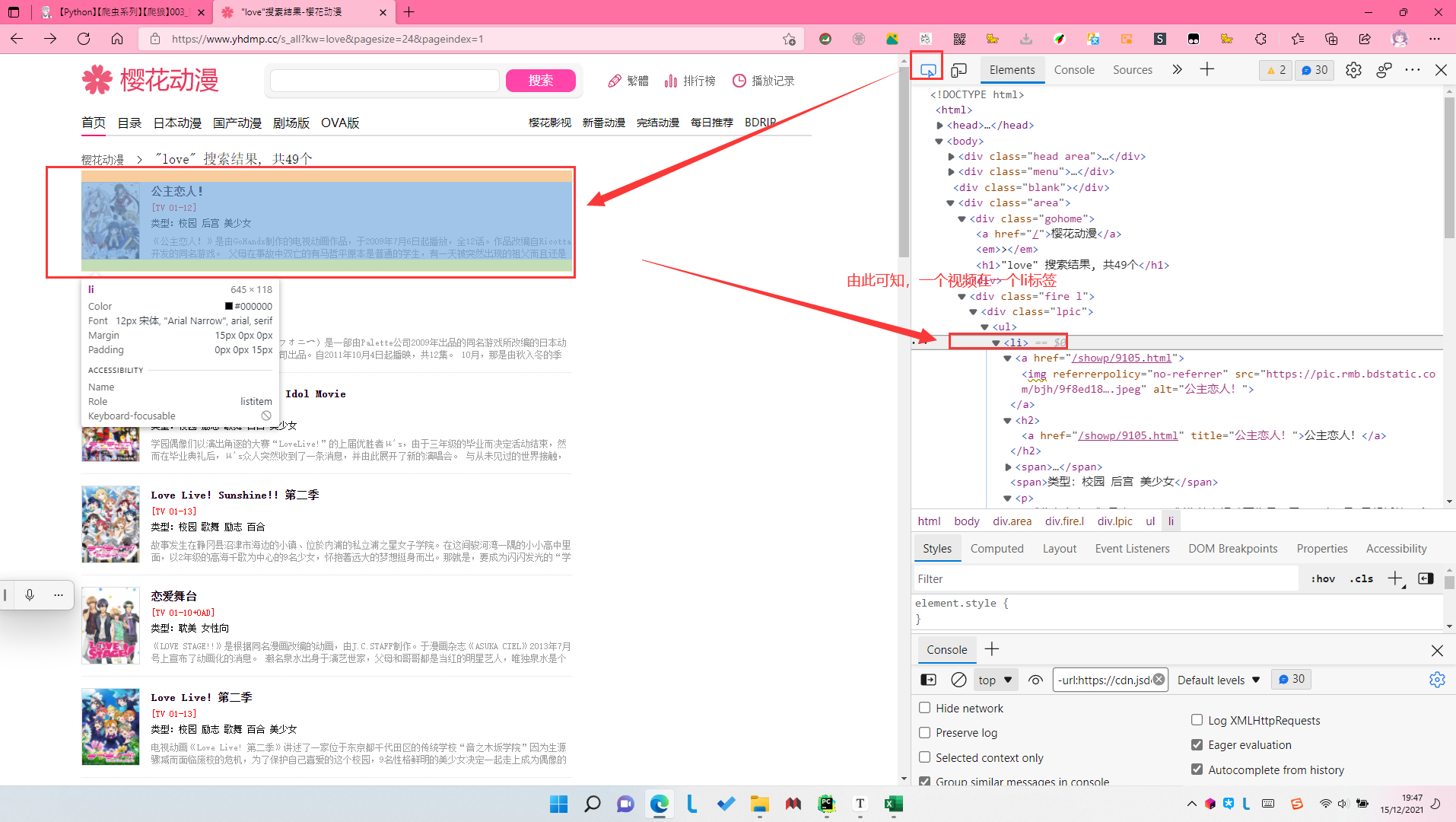

# 一个li标签,包含一个视频

for data in datapage.find_all("li"):

# 不知道soup代表着什么,没关系,也别急着写,继续往后看

我们要获取的是

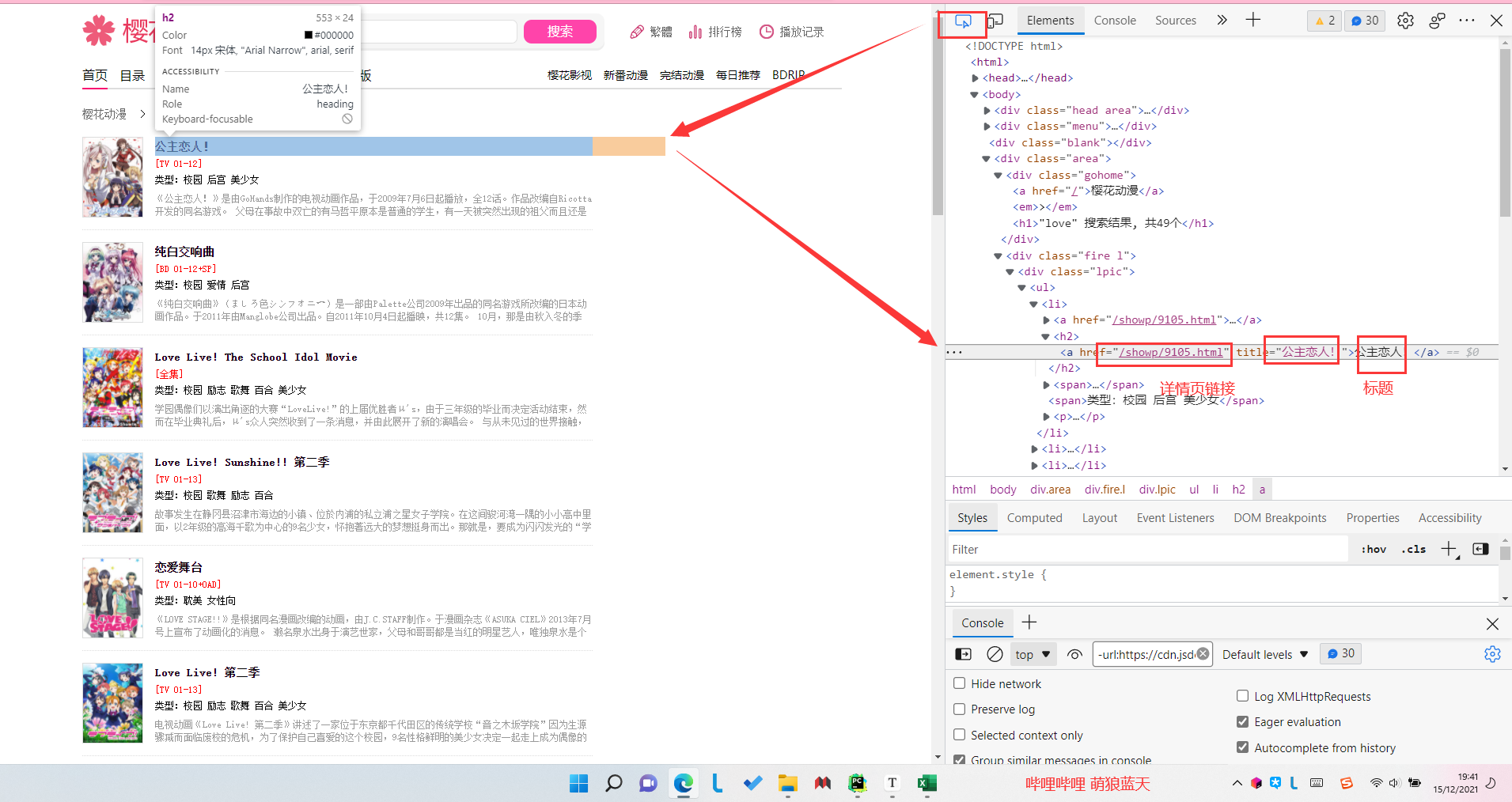

1.视频的标题

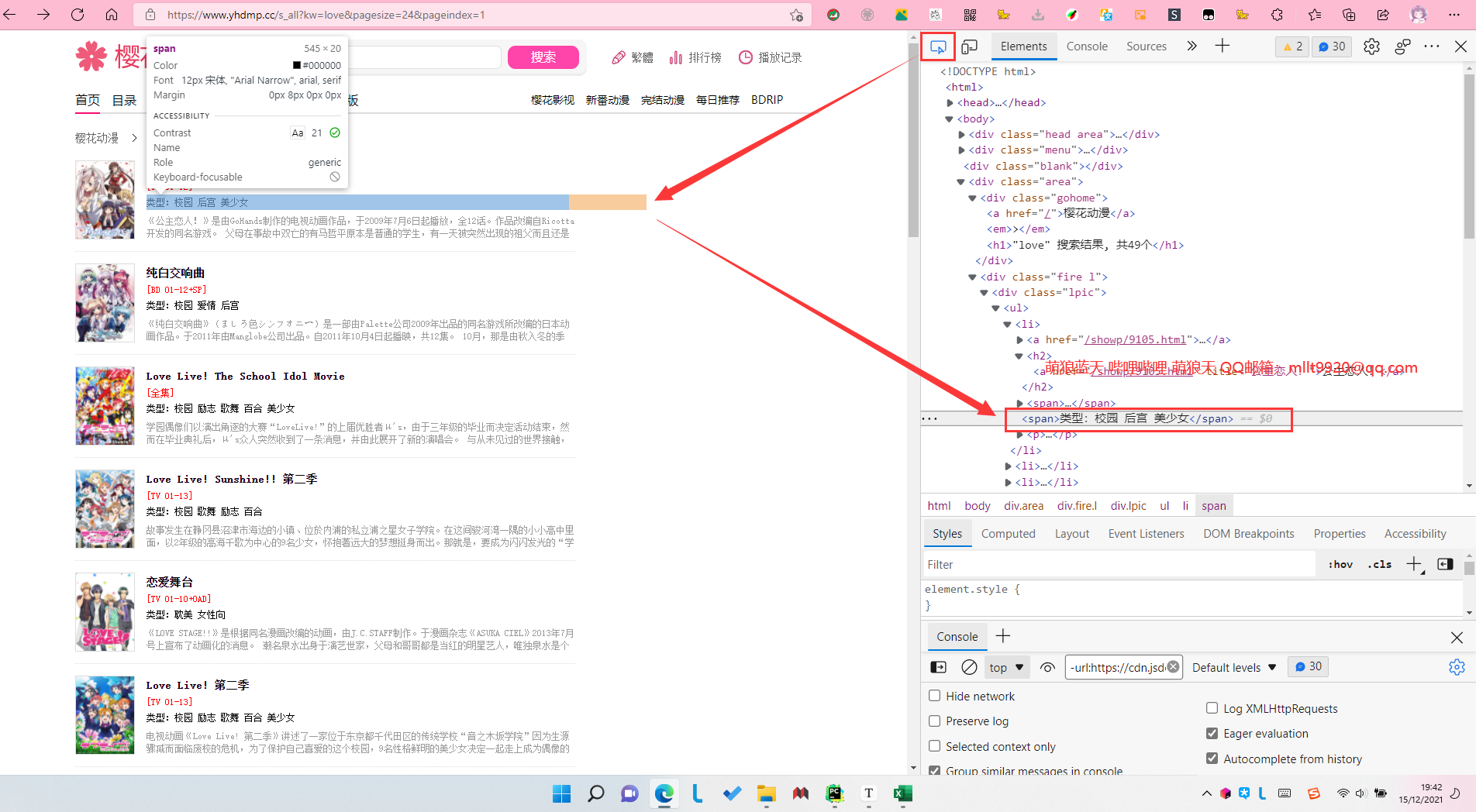

2.视频的类型

3.视频的介绍

4.视频的详情页链接

5.视频的封面图链接

正则规则模板

# 正则规则开始

gz_fan_title = re.compile(r'''<a href=".*?" title=".*?">(.*?)</a>''',re.S)

gz_fan_url = re.compile(r'''<a href="(.*?)"''',re.S)

gz_fan_url_img = re.compile(r'''referrerpolicy="no-referrer" src="(.*?)"''',re.S)

gz_fan_type = re.compile(r'''<span>类型:(.*?)</span>''',re.S)

gz_fan_message = re.compile(r'''<p>(.*?)</p>''', re.S)

# 正则规则结束

应用正则规则模板

data = str(data)

fan_title = re.findall(gz_fan_title, data)

fan_url = re.findall(gz_fan_url, data)

fan_img = re.findall(gz_fan_url_img, data)

fan_type = re.findall(gz_fan_type, data)

fan_message = re.findall(gz_fan_message, data)

那么上面的data是什么,怎么获得呢?

# 假设搜索love

pageNumber = xrilag_SearchAll("love")

# xrilag_SearchAll是自定义函数,想了解其具体代码的请查看博客https://www.cnblogs.com/mllt/p/python_pc_pl_edu_003.html

# pageNumber是搜索结果的总页数

# 使用for循环,一页一页进行处理

for page in range(pageNumber):

# 根据页面跳转的地址改变规则写出页面含变量链接,然后进行源码获取,后面便可以对这一页展开分析与爬取数据了(https://www.cnblogs.com/mllt/p/python_pc_pl_edu_003.html)

html_Document = xrilang_UrlToDocument("https://www.yhdmp.cc/s_all?kw=love&pagesize=24&pageindex=" + str(page))

# xrilang_UrlToDocument是自定义函数,作用是获取网页源码。想了解其具体内容,请查看博客https://www.cnblogs.com/mllt/p/python_pc_pl_edu_002.html

# 创建一个Beautiful Soup对象

soup = BeautifulSoup(html_Document, "html.parser") # parser是解释器

# 使用了.kpic样式的div,包含且只包含了此页的所有视频列表

for datapage in soup.find_all("div", class_="lpic"):

# 一个li标签,包含一个视频

for data in datapage.find_all("li"):

# 应用正则规则模板

data = str(data)

fan_title = re.findall(gz_fan_title, data)

fan_url = re.findall(gz_fan_url, data)

fan_img = re.findall(gz_fan_url_img, data)

fan_type = re.findall(gz_fan_type, data)

fan_message = re.findall(gz_fan_message, data)

【Python】【爬虫】【爬狼】004_正则规则模板及其应用的更多相关文章

- python爬虫—爬取英文名以及正则表达式的介绍

python爬虫—爬取英文名以及正则表达式的介绍 爬取英文名: 一. 爬虫模块详细设计 (1)整体思路 对于本次爬取英文名数据的爬虫实现,我的思路是先将A-Z所有英文名的连接爬取出来,保存在一个cs ...

- Python爬虫 - 爬取百度html代码前200行

Python爬虫 - 爬取百度html代码前200行 - 改进版, 增加了对字符串的.strip()处理 源代码如下: # 改进版, 增加了 .strip()方法的使用 # coding=utf-8 ...

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- 使用Python爬虫爬取网络美女图片

代码地址如下:http://www.demodashi.com/demo/13500.html 准备工作 安装python3.6 略 安装requests库(用于请求静态页面) pip install ...

- Python爬虫|爬取喜马拉雅音频

"GOOD Python爬虫|爬取喜马拉雅音频 喜马拉雅是知名的专业的音频分享平台,用户规模突破4.8亿,汇集了有声小说,有声读物,儿童睡前故事,相声小品等数亿条音频,成为国内发展最快.规模 ...

- python爬虫爬取内容中,-xa0,-u3000的含义

python爬虫爬取内容中,-xa0,-u3000的含义 - CSDN博客 https://blog.csdn.net/aiwuzhi12/article/details/54866310

- Python爬虫爬取一篇韩寒新浪博客

网上看到大神对Python爬虫爬到非常多实用的信息,认为非常厉害.突然对想学Python爬虫,尽管自己没学过Python.但在网上找了一些资料看了一下,看到爬取韩寒新浪博客的视频.共三集,第一节讲爬取 ...

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- 一个简单的python爬虫,爬取知乎

一个简单的python爬虫,爬取知乎 主要实现 爬取一个收藏夹 里 所有问题答案下的 图片 文字信息暂未收录,可自行实现,比图片更简单 具体代码里有详细注释,请自行阅读 项目源码: # -*- cod ...

- python爬虫-爬取百度图片

python爬虫-爬取百度图片(转) #!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:16# 文件 :spider ...

随机推荐

- webpack 的优点

1. 社区庞大,活跃,紧跟技术的前言,不断发展迭代 : 2. 专注处理模块化的项目,可以开箱即用 : 3. 通过 loader 扩展,可以把所有类型的文件解析打包 : 4. 通过plugin 扩展 , ...

- 05 Transformer 中的前馈神经网络(FFN)的实现

2:20:理论链接 博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看 配套 github 链 ...

- ASP.NET实现网站发布及跨域访问

1.软件下载及安装 visual studio 2012 or 2013 启用电脑IIS配置 2.网页编写及排版 在visual studio中创建web项目添加aspx页面(个人网页:和html差不 ...

- 自建互联网档案馆「GitHub 热点速览」

这两天北京的气温骤降,仿佛在提醒我们冬日的脚步已悄然而至,让人不禁感叹时间的飞逝,一年的时间"转瞬即逝". 如果你想留下互联网上的珍贵瞬间,避免它们消失在 404 错误中.这款开源 ...

- 线上debug&gateway自定义路由规则

如何进行线上debug. 如何在gateway自定义路由规则去进行请求分发,让请求打到集群模式下我们想要的节点. 1.配置remote debug 1.在启动参数配置参数: -Xdebug -Xrun ...

- python项目实战——人生重开模拟器

文章目录 1.菜单栏的编写 2.玩家确定颜值.体质.智力.家境 3.生成性别 4.设定角色出生点 5.各个年龄段的变化 5.1 幼年阶段 5.2 青年阶段 5.3中年阶段 5.4 晚年阶段 6.整体代 ...

- 多模型COE方法

1.概述 在当前的人工智能发展中,单一模型的表现往往难以满足复杂任务的需求.为应对这些挑战,多模型协作的方法应运而生,"专家组合"(Mixture of Experts)便是其中一 ...

- 2024御网线上Pwn方向题解

ASM Checksec检查保护 基本上保护都关闭了 64位ida逆向 程序只有一段,并且返回地址就是输入的数据,看起来就是srop了,找一下可以用的gadget 通过异或清空rax值,然后通过异或e ...

- 本文是第一篇在GitHub仓库中撰写的.md格式的blog文件

正文内容: 具体内容,只是未来测试,给出福利: 模板格式: title: 博文标题 description: 博文摘要 #多个标签请使用英文逗号分隔或使用数组语法 tags: 标签1, 标签2 #多个 ...

- games101_Homework5

使用光线追踪来渲染图像,实现两个部分:光线的生成和光线与三角的求交 你需要修改的函数是: • Renderer.cpp 中的 Render():这里你需要为每个像素生成一条对应的光 线,然后调用函数 ...