LTD: Low Temperature Distillation for Robust Adversarial Training

概

本文利用distillation来提高网络鲁棒性.

主要内容

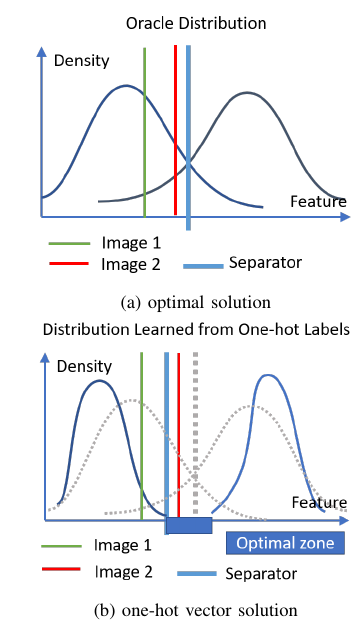

如上图所示, 作者认为, 如果我们用one-hot的标签进行训练, 结果会导致图(b)中的情形, 于是两个分布中间的空袭部分均可以作为分类边界, 从而导致存在大量的对抗样本的存在. 解决的方案要么更加密集的采样(即增加样本), 或者使用soft-label即本文的策略.

本文的目标即:

\]

其中\(p^s\)表示学生网络得到的概率向量, 而\(p^t\)是在普通数据上训练好的教师网络得到的概率向量(且注意其temperature不为1, 根据作者的消融实验, \(T=5\)对于WRN是一个不错的选择).

可以发现, 上述目标与普通的TRADES仅仅差别与第一项改用了soft-label.

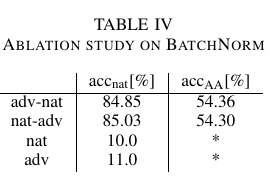

作者还额外讨论了BN的作用, 如果单独使用干净或者对抗样本进行更新, 网络几乎是不收敛的. 而先更新干净或者对抗样本对最后的结果影响不大. 这个还挺有意思的, 我也做过类似的东西, 会不会是被kill了?

问?

不晓得作者有没有试过AT的distillation, 因为感觉没有特别的创新点, 难不成AT上不起作用?

LTD: Low Temperature Distillation for Robust Adversarial Training的更多相关文章

- Feature Distillation With Guided Adversarial Contrastive Learning

目录 概 主要内容 reweight 拟合概率 实验的细节 疑问 Bai T., Chen J., Zhao J., Wen B., Jiang X., Kot A. Feature Distilla ...

- Adversarial Training

原于2018年1月在实验室组会上做的分享,今天分享给大家,希望对大家科研有所帮助. 今天给大家分享一下对抗训练(Adversarial Training,AT). 为何要选择这个主题呢? 我们从上图的 ...

- 《C-RNN-GAN: Continuous recurrent neural networks with adversarial training》论文笔记

出处:arXiv: Artificial Intelligence, 2016(一年了还没中吗?) Motivation 使用GAN+RNN来处理continuous sequential data, ...

- Understanding and Improving Fast Adversarial Training

目录 概 主要内容 Random Step的作用 线性性质 gradient alignment 代码 Andriushchenko M. and Flammarion N. Understandin ...

- Adversarial Training with Rectified Rejection

目录 概 主要内容 rejection 实际使用 代码 Pang T., Zhang H., He D., Dong Y., Su H., Chen W., Zhu J., Liu T. Advers ...

- Boosting Adversarial Training with Hypersphere Embedding

目录 概 主要内容 代码 Pang T., Yang X., Dong Y., Xu K., Su H., Zhu J. Boosting Adversarial Training with Hype ...

- Uncovering the Limits of Adversarial Training against Norm-Bounded Adversarial Examples

Uncovering the Limits of Adversarial Training against Norm-Bounded Adversarial Examples 目录 概 主要内容 实验 ...

- 论文解读(ARVGA)《Learning Graph Embedding with Adversarial Training Methods》

论文信息 论文标题:Learning Graph Embedding with Adversarial Training Methods论文作者:Shirui Pan, Ruiqi Hu, Sai-f ...

- cs231n spring 2017 lecture16 Adversarial Examples and Adversarial Training 听课笔记

(没太听明白,以后再听) 1. 如何欺骗神经网络? 这部分研究最开始是想探究神经网络到底是如何工作的.结果人们意外的发现,可以只改变原图一点点,人眼根本看不出变化,但是神经网络会给出完全不同的答案.比 ...

随机推荐

- 运算符重载+日期类Date

Hello,一只爱学习的鱼 大学学习C++运算符重载的时候,老师出了一道"运算符重载+类"的综合练习题,让我们来一起看看吧! 题目: 设计一个日期类Date,包括年.月.日等私有成 ...

- Spark(一)【spark-3.0安装和入门】

目录 一.Windows安装 1.安装 2.使用 二.Linux安装 Local模式 1.安装 2.使用 yarn模式 1.安装 2.使用 3.spark的历史服务器集成yarn 一.Windows安 ...

- 【STM32】使用SDIO进行SD卡读写,包含文件管理FatFs(七)-准备移植FatFs

[STM32]使用SDIO进行SD卡读写,包含文件管理FatFs(一)-初步认识SD卡 [STM32]使用SDIO进行SD卡读写,包含文件管理FatFs(二)-了解SD总线,命令的相关介绍 [STM3 ...

- Java发HTTP POST请求(内容为xml格式)

Java发HTTP POST请求(内容为xml格式) 一.POST请求 服务器地址:http://5.0.217.50:17001/VideoSend 服务器提供的是xml格式的http接口,接口定义 ...

- 【Java】【设计模式】单例设计模式

思想: 为了避免其他程序过多建立该类对象,先禁止其他程序建立该类对象 为了让其他程序可以访问到该类对象,只好在本类中自定义一个对象 为了方便其他程序对自定义对象的访问,可以对外提供一些访问方式 代码体 ...

- mybatis处理集合、数组参数使用in查询等语句的两种方法

对于mybatis的参数类型是集合数组的时候进行查询. 第一种:参数list使用mybatis的标签 SELECT * FROM TABLE_NAME AS a <where> <i ...

- arcgis api for js自定义引用方式

(1)常规模式 即arcgis js常见的模块引用方式,采用 require-function 模式,function的参数与require一一对应即可(dojo/domReady!比较特殊,无需 ...

- TV盒子 android 4.4安装kodi 和 安装jellyfin插件连接到 jellyfin服务器

很多IPTV盒子系统都是android 4.4的,无法安装新版kodi, 最高只能安装到改版的kodi, 版本是17.1,jellyfin插件也只能安装到0.5.8 首先下载kodi和jellyfin ...

- Mysql资料 用户权限详解

目录 一.MySQL权限详解 设置MySQL用户资源限制 用户资源限制执行操作 二.MySQL权限级别介绍 MySQL权限级别 MySQL创建权限 MySQL删除与插入权限 MySQL修改与触发器权限 ...

- 一种基于Java Swing/HTML/MySQL的汽车租赁系统

该项目是一个Java的课程作业(大二),主要运用Java.Swing.HTML.MySQL,实现基本的租车逻辑.界面可视化.信息导出.数据存储等功能.实现管理员.用户两种角色登录,并结合Java开发中 ...