Web Scraper 高级用法——使用 CouchDB 存储数据 | 简易数据分析 18

这是简易数据分析系列的第 18 篇文章。

利用 web scraper 抓取数据的时候,大家一定会遇到一个问题:数据是乱序的。在之前的教程里,我建议大家利用 Excel 等工具对数据二次加工排序,但还是存在部分数据无法排序的情况。

其实解决数据乱序的方法也有,那就是换一个数据库。

web scraper 作为一个浏览器插件,数据默认保存在浏览器的 localStorage 数据库里。其实 web scraper 还支持外设数据库——CouchDB。只要切换成这个数据库,就可以在抓取过程中保证数据正序了。

1.CouchDB 下载安装

CouchDB 可以从官网下载,官网链接为:https://couchdb.apache.org/。

因为服务器在外网,国内访问可能比较慢,我存了一份云盘文件,可以公众号后台回复「CouchDB」获取下载连接,Mac 和 Win 安装包都有,版本为 3.0.0。

具体的安装过程我就忽略了,大家平常怎么安装软件就怎么安装 CouchDB。

2.配置 CouchDB

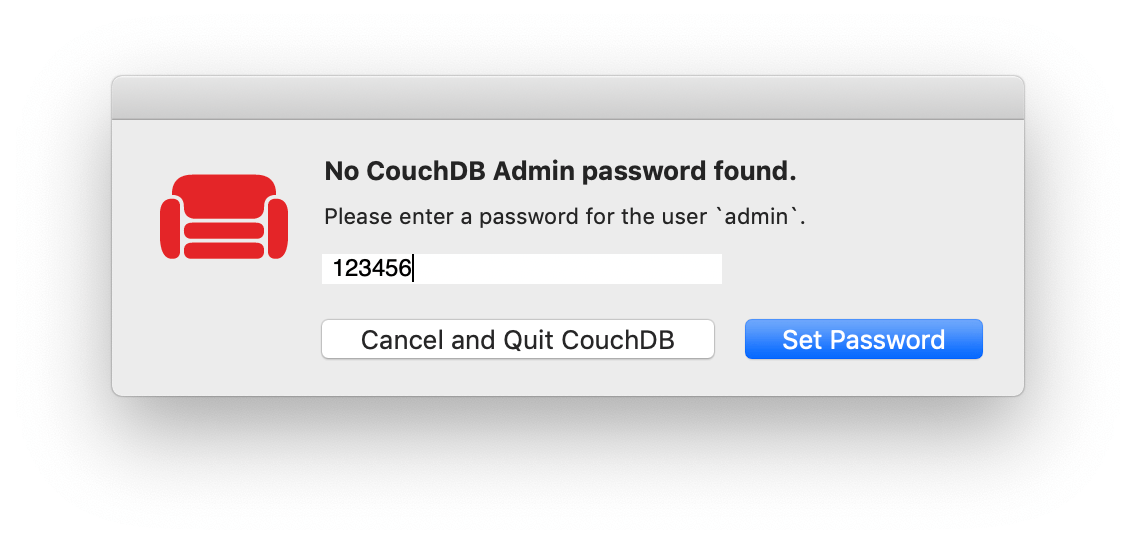

1.创建账号

第一次打开 CouchDB,可能会要求你创建一个 CouchDB 账号(或设置账号密码),这里我为了演示方便就取个简单的密码。大家一定要记住账号密码,因为之后访问 CouchDB 都要填写。

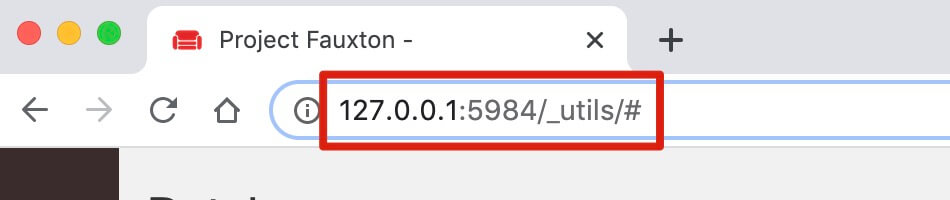

2.访问 CouchDB

一般第一次打开 CouchDB,会自动打开一个网页,网址为:http://127.0.0.1:5984/_utils/#,如果没有自动打开,可以浏览器手动输入这个网址。

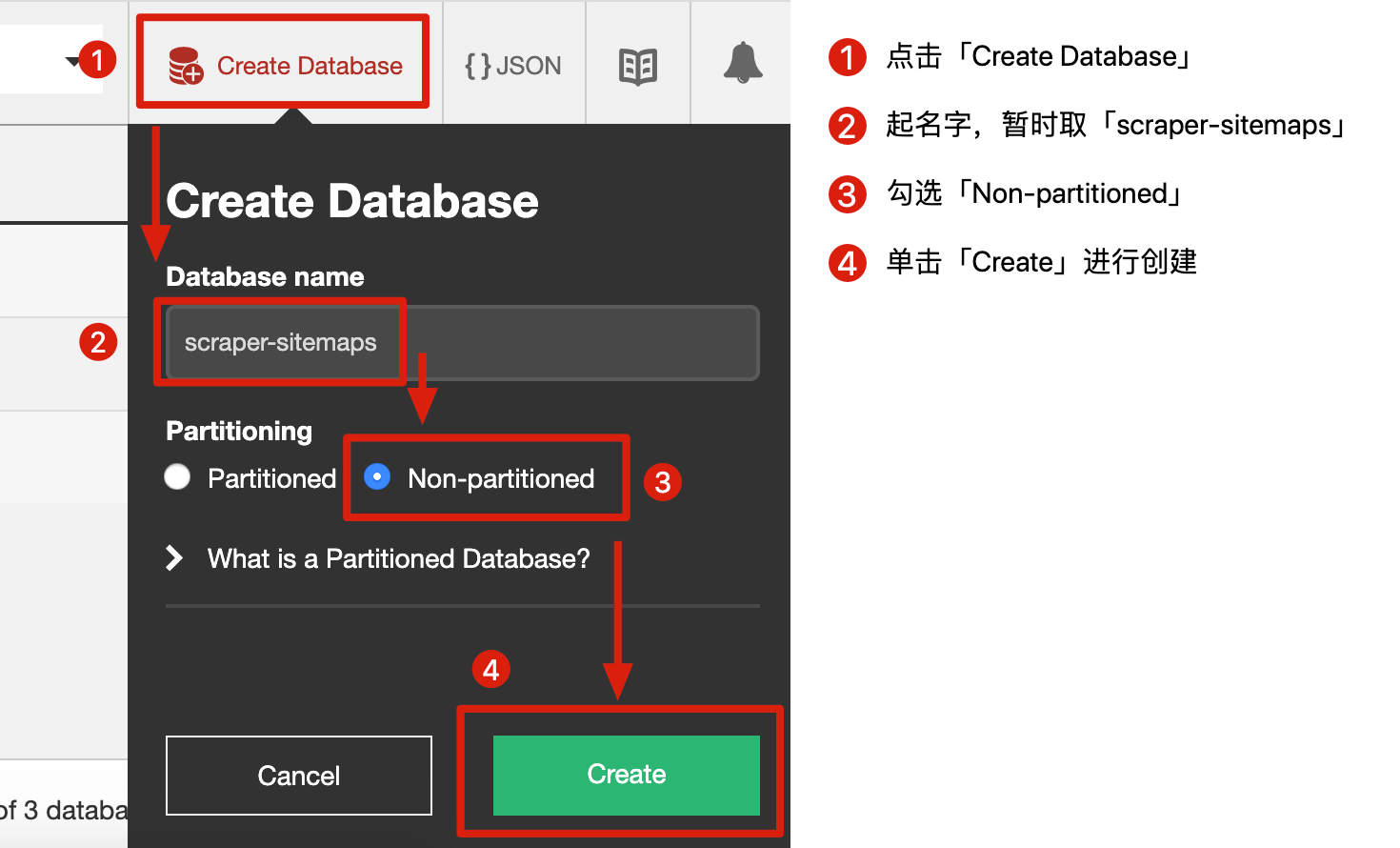

3.创建 Database

我们可以把 Database 理解为一个文件,我们要创建一个文件专门保存 sitemap,创建流程可以看下图:

- 点击「Create Database」

- 为这个文件起个名字,叫「scraper-sitemaps」

- 勾选「Non-partitioned」

- 单击「Create」创建

3.Web Scraper 切换到 CouchDB

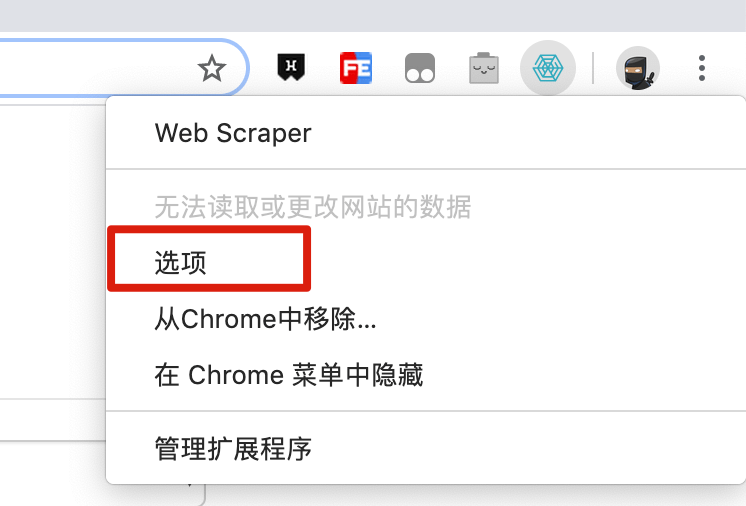

1.首先从浏览器右上角的插件列表中找到 Web Scraper 的图标,然后右键点击,在弹出的菜单里再点击「选项」。

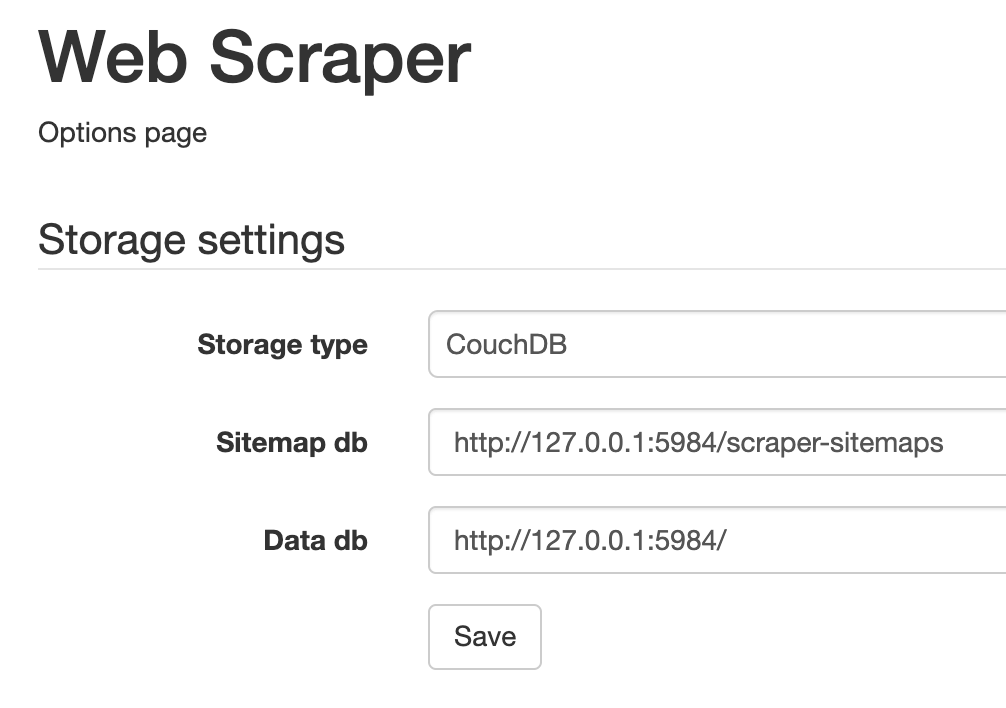

2.在新打开的管理页面里,要做这几步:

- Storage type 切换为 CouchDB

- Sitemap db 填入 http://127.0.0.1:5984/scraper-sitemaps

- Data db 填入 http://127.0.0.1:5984/

3.最后点击「Save」按钮保存配置,重启浏览器让配置生效。

4.抓取数据

抓取数据前,我们需要把电脑的各种网络代理关掉,要不然可能会连接不到 CouchDB。

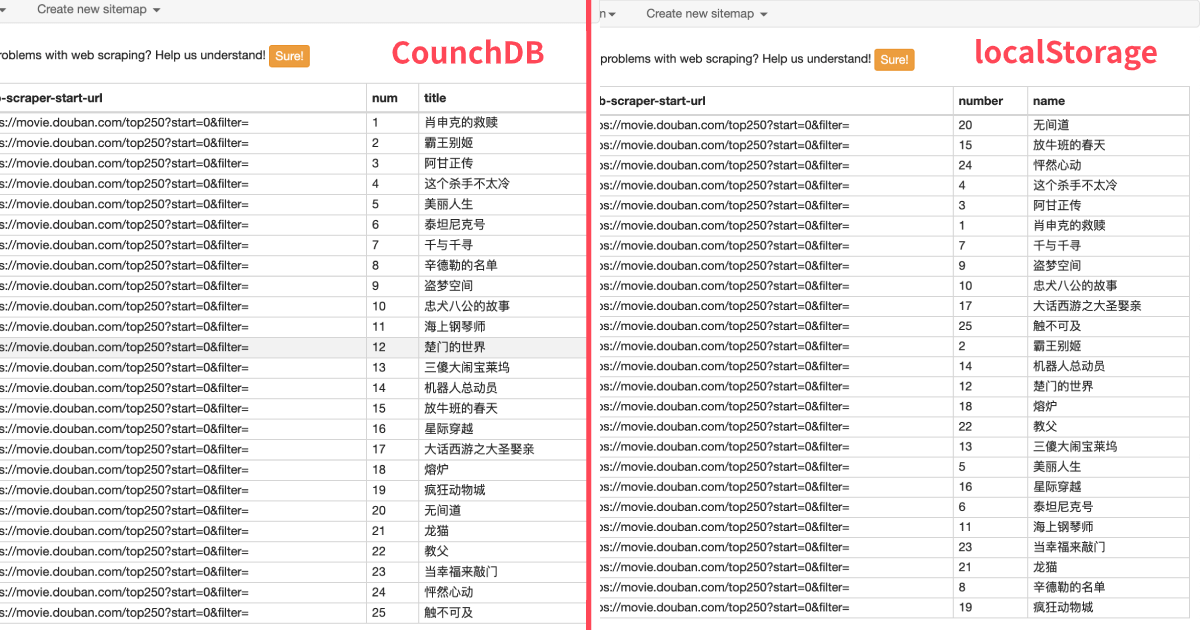

网页还是拿豆瓣 TOP250 做个简单的演示。web scraper 的操作和以前都是一样的,预览数据时我们就会发现,和 localStorage 比起来,数据都是正序的:

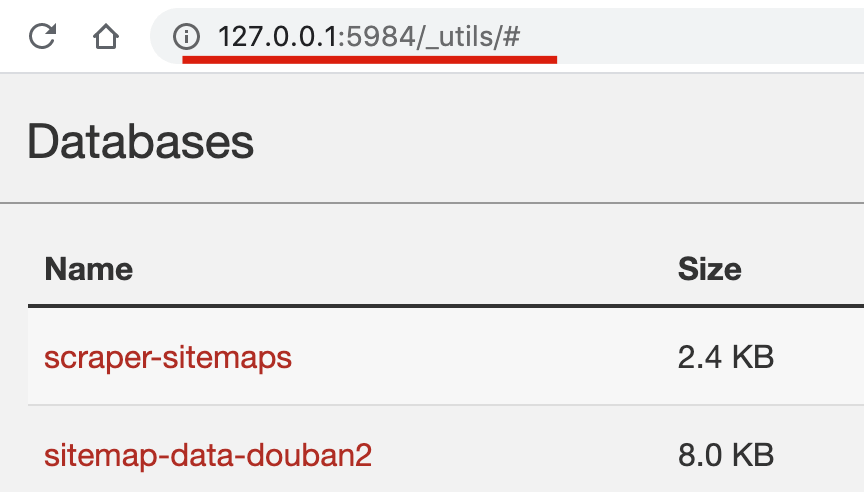

我们也可以在 CouchDB 的操作页面预览数据。http://127.0.0.1:5984/_utils/# 这个页面是主界面,我们可以看到保存 sitemap 的 database 和豆瓣数据的 database:

点击「sitemap-data-douban2」进入数据详情页,可以预览数据:

5.导出数据

导出数据也是老样子,在 web scraper 插件面板里点击「Export data as CSV」就可以导出。其实也可以从 CouchDB 里导出数据,但这样还得写一些脚本,我这里就不多介绍了,感兴趣的人可以自行搜索。

6.个人感悟

其实一开始我并不想介绍 CouchDB,因为从我的角度看,web scraper 是一个很轻量的插件,可以解决一些轻量的抓取需求。加入 CouchDB 后,这个安装下来要几百兆的软件,只是解决了 web scraper 数据乱序的问题,在我看来还是有些大炮打蚊子,也脱离了轻量抓取的初衷。但是有不少读者私信我相关内容,为了教程的完整性,我还是写下了这篇文章。

7.联系我

因为文章发在各大平台上,账号较多不能及时回复评论和私信,有问题可关注公众号 ——「卤代烃实验室」,(或 wx 搜索 sky-chx)关注上车防失联。

Web Scraper 高级用法——使用 CouchDB 存储数据 | 简易数据分析 18的更多相关文章

- Web Scraper 高级用法——抓取属性信息 | 简易数据分析 16

这是简易数据分析系列的第 16 篇文章. 这期课程我们讲一个用的较少的 Web Scraper 功能--抓取属性信息. 网页在展示信息的时候,除了我们看到的内容,其实还有很多隐藏的信息.我们拿豆瓣电影 ...

- Web Scraper 翻页——控制链接批量抓取数据(Web Scraper 高级用法)| 简易数据分析 05

这是简易数据分析系列的第 5 篇文章. 上篇文章我们爬取了豆瓣电影 TOP250 前 25 个电影的数据,今天我们就要在原来的 Web Scraper 配置上做一些小改动,让爬虫把 250 条电影数据 ...

- 简易数据分析 15 | Web Scraper 高级用法——CSS 选择器的使用

这是简易数据分析系列的第 15 篇文章. 年末事情比较忙,很久不更新了,后台一直有读者催更,我看了一些读者给我的私信,发现一些通用的问题,所以单独写篇文章,介绍一些 Web Scraper 的进阶用法 ...

- Web Scraper 高级用法——利用正则表达式筛选文本信息 | 简易数据分析 17

这是简易数据分析系列的第 17 篇文章. 学习了这么多课,我想大家已经发现了,web scraper 主要是用来爬取文本信息的. 在爬取的过程中,我们经常会遇到一个问题:网页上的数据比较脏,我们只需要 ...

- 使用 Chrome 浏览器插件 Web Scraper 10分钟轻松实现网页数据的爬取

web scraper 下载:Web-Scraper_v0.2.0.10 使用 Chrome 浏览器插件 Web Scraper 可以轻松实现网页数据的爬取,不写代码,鼠标操作,点哪爬哪,还不用考虑爬 ...

- Web Scraper 翻页——利用 Link 选择器翻页 | 简易数据分析 14

这是简易数据分析系列的第 14 篇文章. 今天我们还来聊聊 Web Scraper 翻页的技巧. 这次的更新是受一位读者启发的,他当时想用 Web scraper 爬取一个分页器分页的网页,却发现我之 ...

- Web Scraper——轻量数据爬取利器

日常学习工作中,我们多多少少都会遇到一些数据爬取的需求,比如说写论文时要收集相关课题下的论文列表,运营活动时收集用户评价,竞品分析时收集友商数据. 当我们着手准备收集数据时,面对低效的复制黏贴工作,一 ...

- 简易数据分析 04 | Web Scraper 初尝--抓取豆瓣高分电影

这是简易数据分析系列的第 4 篇文章. 今天我们开始数据抓取的第一课,完成我们的第一个爬虫.因为是刚刚开始,操作我会讲的非常详细,可能会有些啰嗦,希望各位不要嫌弃啊:) 有人之前可能学过一些爬虫知识, ...

- 简易数据分析 12 | Web Scraper 翻页——抓取分页器翻页的网页

这是简易数据分析系列的第 12 篇文章. 前面几篇文章我们介绍了 Web Scraper 应对各种翻页的解决方法,比如说修改网页链接加载数据.点击"更多按钮"加载数据和下拉自动加载 ...

随机推荐

- go源码分析(一) 通过调试看go程序初始化过程

参考资料:Go 1.5 源码剖析 (书签版).pdf 编写go语言test.go package main import ( "fmt" ) func main(){ fmt.Pr ...

- SSM框架学习笔记

管理部门: --Spring + SpringMVC+MyBatis 1.index.jsp--->SpringMVC(Servlet) 接受客户端的请求,读取页面的值,回传到页面 2.Myba ...

- Java中static和final的解析

static关键字和final关键字是Java中一个难点&重点.本文通过static的用途.常见问题.final的用途.final常见问题,以及static和final的对比来解释这两个关键字 ...

- kerberos系列之kerberos安装

最近搞了一下kerberos,准备写一个系列,介绍kerberos的安装,和常用组件kerberos配置,今天进入第一篇:kerberOS安装 具体kerberos是什么东西,大家可以百度查一下,这里 ...

- AspNetCore3.1_Secutiry源码解析_6_Authentication_OpenIdConnect

title: "AspNetCore3.1_Secutiry源码解析_6_Authentication_OpenIdConnect" date: 2020-03-25T21:33: ...

- Redhat 线下赛 WEB WP

赛制 给每个参赛队伍所有题目的gamebox,参赛队伍在开赛时就能获取到所有题目的源码,可以选择先防御后攻击或先攻击后防御,只要拿到gamebox上的flag,机器人就会自动帮你攻击场上所有未防御选手 ...

- node 模块载入原理【1】

简单介绍 我们会从简单的模块载入原理来开始,尝试阅读下 Node.js 源代码.首先我们知道 Node.js 的源代码主要是由 C++ 和 JavaScript 编写的,JS 部分主要在 lib 目录 ...

- [BFS,大水题] Codeforces 198B Jumping on Walls

题目:http://codeforces.com/problemset/problem/198/B Jumping on Walls time limit per test 2 seconds mem ...

- ELK 环境搭建总结

开始动手前的说明 我搭建这一套环境的时候是基于docker搭建的,用到了docker-compose,所以开始前要先安装好docker . docker-compose,并简单的了解docker . ...

- OpenCV-Python 光流 | 四十八

目标 在本章中, 我们将了解光流的概念及其使用Lucas-Kanade方法的估计. 我们将使用cv.calcOpticalFlowPyrLK()之类的函数来跟踪视频中的特征点. 我们将使用cv.cal ...